维度专题

当网工,华为认证哪种适合我?四个维度来解惑

随着网络技术的不断进步,对网工的专业技能要求也越来越高。 在这种背景下,获得权威认证成为了提升个人技能、证明专业能力的重要途径。 华为,作为全球领先的ICT解决方案提供商,其认证项目在业界享有极高的声誉。 华为认证不仅涵盖了网络技术的各个方面,还根据不同的技能水平和职业发展阶段,提供了不同级别的认证,包括HCIA、HCIP、HCIE。 这些认证不仅有助于网络工程师提升自己的技术水平,也是企业在招聘

【生成模型系列(中级)】词向量维度选择的奥秘——从理论到实验的揭秘【通俗理解,代码模拟】

【通俗理解】词向量维度选择的奥秘——从理论到实验的揭秘 关键词提炼 #词向量 #维度选择 #最小熵原理 #Johnson-Lindenstrauss引理 #注意力机制 #图网络 第一节:词向量维度选择的类比与核心概念【尽可能通俗】 1.1 词向量维度选择的类比 词向量维度选择就像为一场复杂的烤肉方子挑选合适的食材和分量。 每个词就像是烤肉中的不同食材,而维度就像是每种食材所需的分量。

NLP-生成模型-2017-Transformer(一):Encoder-Decoder模型【非序列化;并行计算】【O(n²·d),n为序列长度,d为维度】【用正余弦函数进行“绝对位置函数式编码”】

《原始论文:Attention Is All You Need》 一、Transformer 概述 在2017年《Attention Is All You Need》论文里第一次提出Transformer之前,常用的序列模型都是基于卷积神经网络或者循环神经网络,表现最好的模型也是基于encoder- decoder框架的基础加上attention机制。 2018年10月,Google发出一篇

浅谈维度建模、数据分析模型,何为数据仓库,与数据库的区别

往期推荐 大数据HBase图文简介-CSDN博客 数仓分层ODS、DWD、DWM、DWS、DIM、DM、ADS-CSDN博客 数仓常见名词解析和名词之间的关系-CSDN博客 数仓架构:离线数仓、实时数仓Lambda和Kappa、湖仓一体数据湖-CSDN博客 0. 前言 1991年,数据仓库之父 比尔·恩门 著书《Building the DataWarehouse》,要求构建数据仓

kafka监控维度分析

一、监控目标 1.当系统可能或处于亚健康状态时及时提醒,预防故障发生 2.报警提示 a.短信方式 b.邮件 二、监控内容 2.1 机器监控 Kafka服务器指标 CPU Load Disk IO Memory 磁盘log.dirs目录下数据文件大小,要有定时清除策略 2.2 JV

【小白深度学习入门】【2】池化层详解:工作原理、维度计算、池化类型

《博主简介》 小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。 👍感谢小伙伴们点赞、关注! 《------往期经典推荐------》 一、AI应用软件开发实战专栏【链接】 项目名称项目名称1.【人脸识别与管理系统开发】2.【车牌识别与自动收费管理系统开发】3.【手势识别系统开发】4.【人脸面部活体检测系统开发】5.【图片风格快速迁移软件开发】6

mysql创建时间维度的sql脚本

mysql创建时间维度sql脚本 其中d0是开始时间,d1是结束时间 T是万能的表,只需满足T表的记录数量大于所插入的时间行数即可. # time span SET @d0 = "2014-01-01"; SET @d1 = "2016-12-31"; SET @date = date_sub(@d0, interval 1 day); # set up the time di

Pytorch中高维度张量理解

Pytorch中高维度张量理解 创建一个tensor获取第一个维度的第0个元素:获取第二个维度的第0个元素:获取第三个维度的第0个元素:获取第四个维度的第0个元素:其他情况 创建一个tensor tensor = torch.rand(3,5,3,2) 结果如下: ```pythontensor([[[[0.3844, 0.9532],[0.0787, 0.4187]

人工智能与神经科学:理解大脑的新维度

近年来,人工智能(AI)的发展对神经科学的研究产生了深远的影响。在神经网络、机器学习和大模型的驱动下,研究者们发现AI不仅仅是一个计算工具,它还能够揭示人类大脑的某些机制。这种新型的跨学科合作,称为“神经系统理解”(Neural Systems Understanding),正逐渐成为探索大脑奥秘的重要方法。 人工智能与神经科学的交叉点 在过去的几十年里,神经科学主要依靠动物实验和生物成像技术

【Python】numpy增加数组维度

增加维度 (1)比如我们希望将两个二维数组在一个新的维度上拼接成一个三维数组,我们可以先利用 newaxis 构建出这个维度,然后再使用 concatenate,vstack, hstack 等方法。 a = np.array([[1,2],[3,4]]) b = np.array([[5,6],[7,8]]) a_ = a[..., np.newaxis] b_ = b[..., np

面试常问! transformer中dk的大小,以及为什么设成这样,维度,原文分析。

目录: 原文 :翻译:流程:原因: 原文(多头注意力部分) : 李沐b站论文精读 论文网盘下载:链接 提取码: vm3d 翻译: 在这项工作中,我们采用了 h=8 个并行注意力层,或称为头。对于每一层,我们使用 dk = dv = dmodel / h = 64。由于每个头的维度减少了,总的计算成本与具有完整维度的单头注意力相似。 即:dk = 512 / 8 = 64

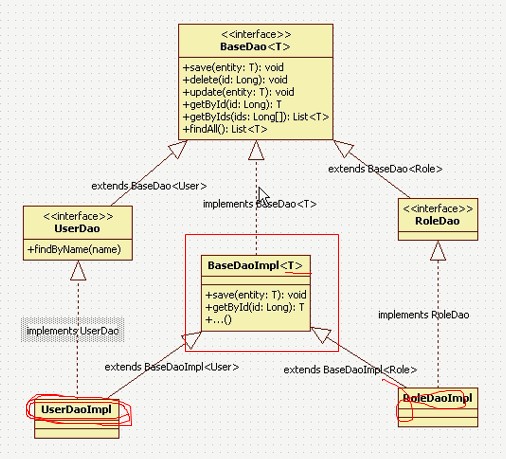

【OA】Dao层“接口”、“实现”两个维度一个良好的设计学习

在学习OA系统的时候,鉴于已经搭建起来的SSH框架,首先要做的就是从底层开始做起,结合所做的项目更多的是在前人基础上修改,这次学习如何设计Dao也是让我大开眼界,总结成博客,便于以后再回头学习。 一、包设计 项目名称:ItcastOA 资源文件夹:src、config、test 由于“src”用于存放主代码,对DAO的接口、实

【算法学习笔记】29:动态规划中可丢弃状态的维度压缩

1 动机 当状态 i i i只依赖于前置状态 i − 1 i - 1 i−1,并且在计算出状态 i i i之后就可以丢弃状态 i − 1 i - 1 i−1时的解时, i − 1 i - 1 i−1就成为一个可丢弃的状态,因此就可以将 i i i这个维度直接压缩(省略)掉,用一个变量不停的更新自己就可以了,可以直接节省一个维度的空间占用。 2 例题 2.1 LC1955. 统计特殊子序列的数

SQL进阶技巧:如何将编码集还原成维度集?

目录 0 场景描述 1 数据准备 2 问题分析 3 小结 0 场景描述 假设有如下code编码集,code表如下: code101101010011 其中每一位代表排名的名词,当编码中有1时表示该位置有排名,从左到右进行顺序排名,例如1011 分别代表1,3,4排名。假设0N 代表第N名,现有一张name编码表,name表如下: codename01第一名02第二名03

数据仓库 --- 范式建模与维度建模

一、维度建模源于 Kimball 提出的总线式的 自下而上(DM-DW-ODS)的数据仓库架构。 根据应用推宽表形式。 特点: 1.模型结构简单,星型模型为主; 2.开发周期短,能够快速迭代; 3.维护成本较高; 4.根据应用频繁更新; 二、范式建模源于Inmon提出的集线器的自上而下(ODS-EDW-DM)的数据仓库架构。 根据底表抽象通用逻辑。

维度数据模型建模过程

选择业务流程 确认那些业务处理流程是数据仓库应该覆盖的,是维度方法的基础。因此,建模的第一个步骤是描述需要建模的业务流程。例如,需要了解和分析一个零售店的销售情况,那么与该零售店销售相关的业务流程都是需要关注的。为了描述业务流程,可以简单利用文本记录,或者使用“业务流程建模标注”(BPMN)方法,也可以使用统一建模语言(UML)或其他类似方法。 声明粒度 确定了业务流程后,下一步是声明模型的

SQL进阶技巧:多维分析之如何还原任意维度组合下的维度列簇名称?【利用grouping_id逆向分析】

目 录 0 需求描述 1 数据准备 2 问题分析 3 小结 0 需求描述 现有用户访问日志表 visit_log ,每一行数据表示一条用户访问日志。 需求: (1)按照如下维度组合 (province), (province, city), (province, city, device_type) 计算用户访问量,要求一条SQL语句统计所所有组合维度的结果。

如何确定PCA降维的维度

主要是对西瓜书里面的一个思路的实现,并不涉及PCA原理和公式推导,用一句话总结PCA,在 R d R^{d} Rd中的m个点经过矩阵变换(压缩)映射到 R d ′ R^{d'} Rd′空间中,并且保证 d ′ < d d'<d d′<d,其中 d ′ d' d′是新维度。 用矩阵表示: Z d ′ ∗ m = W d ′ ∗ d T ∗ X d ∗ m Z_{d'*m}=W^{T}_{d'*d}

数据中台模型设计系列(一):维度建模初探

1、与几个概念的关系 操作型业务系统 对于这个概念大家都不陌生。企业业务赖以运转的交易系统就属于操作型业务系统。因此它是为了保障业务正常运转,能够更快的处理事务。 但是因为它是针对某一特定的意图(例如满足交易业务),它不需要承诺与其他业务系统共享公共数据。因此就出现了适合于企业中交叉应用的ERP、主数据系统。当然对于有建设业务中台的企业来说,基于微服务架构的各个服务中心,能更好的提供可复用统一

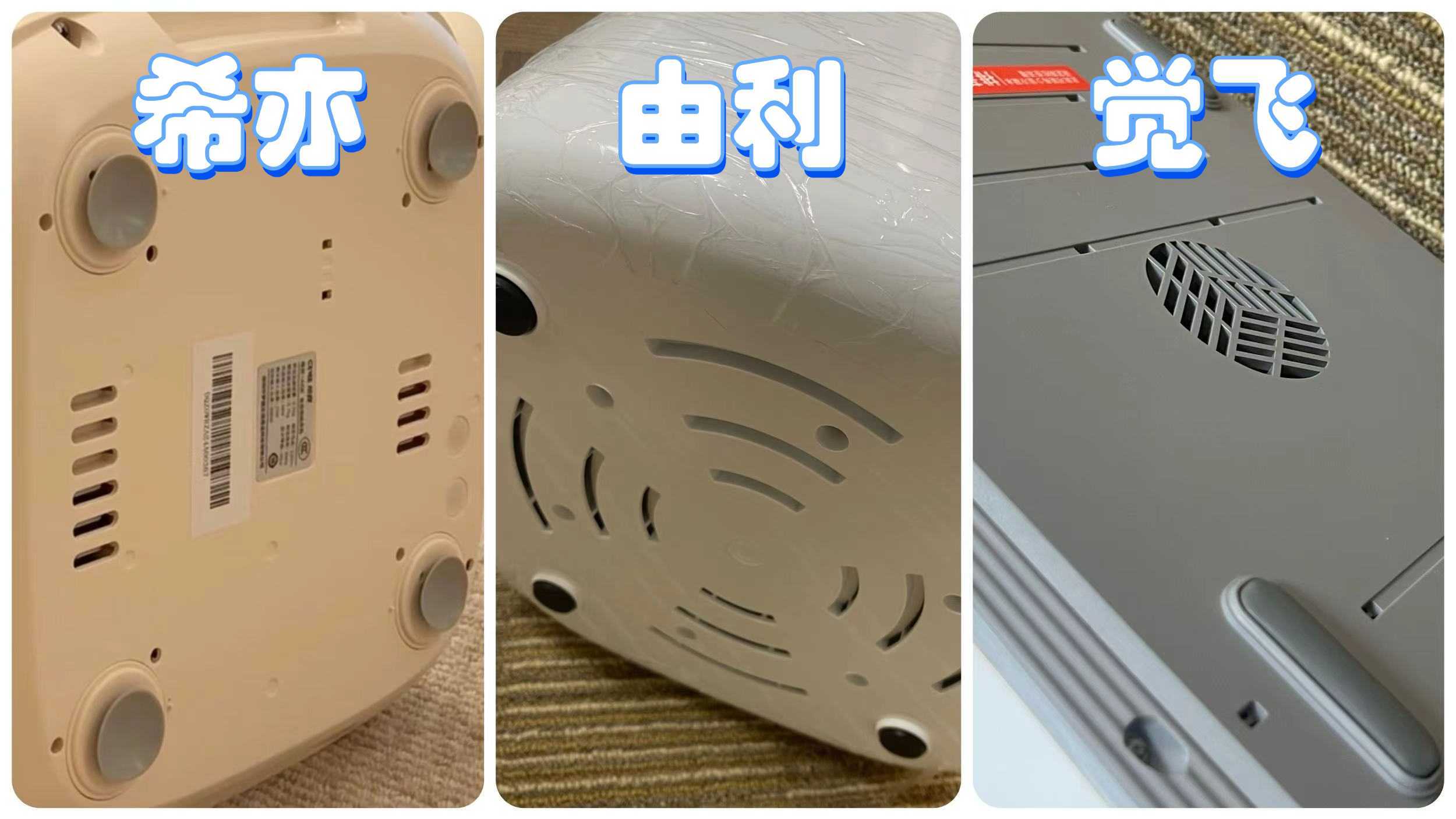

觉飞内衣洗衣机怎么样?各维度专业剖析觉飞、希亦、由利三大机型

由于我们的内衣、内裤和袜子等等贴身小件衣物的清洁频率比一般的衣物要高。而且,如果我们人工手洗的话,不仅会大大浪费了我们的时间,而且还不能进行对这些贴身的以为进行深层消毒和除菌。这种情况下,就得需要一台专门用于清洗内衣内裤以及袜子的小型洗衣机了。 而且,现在这种内衣洗衣机的牌子也越来越多,像觉飞、希亦、由利这些目前比较热门的牌子,很多朋友都想知道这些牌子哪个更好,今天我就给大家简单介绍下这三个品牌

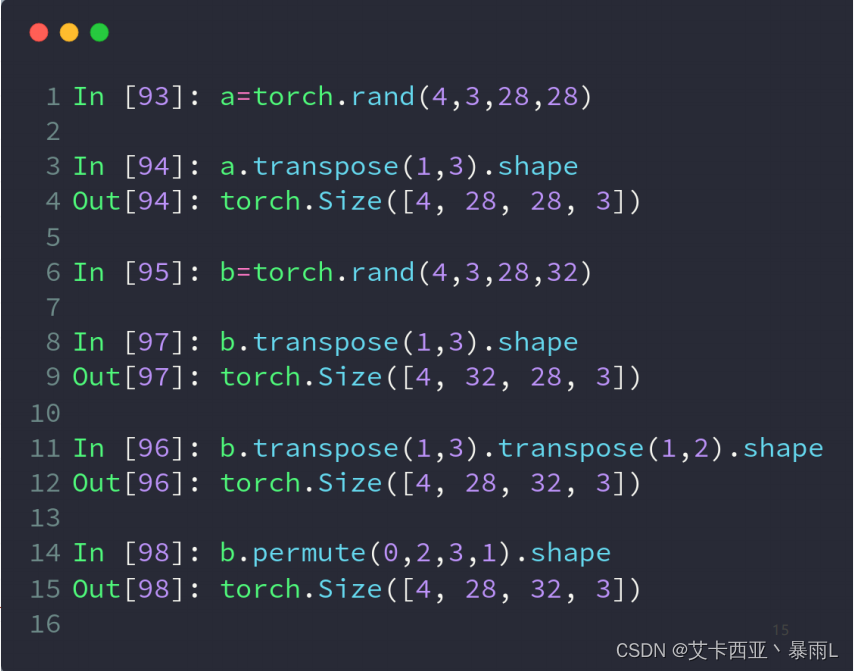

【pytorch06】 维度变换

常用API view/reshapesqueeze/unsqueezetranspose/t/permuteexpand/repeat view和reshape view操作的基本前提是保证numel()一致 a.view(4,28*28)的物理意义是把行宽以及通道合并在一起,对于4张图片,我们直接把所有数据都合在一起,用一个784维的向量来表示,这样所有的二维信息上下左右位置信息就忽略

SSIS--- 数据仓库中实现 Slowly Changing Dimension 缓慢渐变维度的三种方式

看文章之前先了解----缓慢渐变维度 (Slowly Changing Dimension) 常见的三种类型及原型设计:http://blog.csdn.net/u012071918/article/details/77533025 2013-10-16 00:09 by BIWORK, 6661 阅读, 14 评论, 收藏, 编辑 开篇介绍 关于 Slowly Changing Dim

SSIS+数据仓库系列--- 缓慢渐变维度 (Slowly Changing Dimension) 常见的三种类型及原型设计

在从 OLTP 业务数据库向 DW 数据仓库抽取数据的过程中,特别是第一次导入之后的每一次增量抽取往往会遇到这样的问题:业务数据库中的一些数据发生了更改,到底要不要将这些变化也反映到数据仓库中?在数据仓库中,哪些数据应该随之变化,哪些可以不用变化?考虑到这些变化,在数据仓库中的维度表又应该如何设计以满足这些需要。 很显然在业务数据库中数据的变化是非常自然和正常的,比如顾客的联系方式,手机号码