手推专题

手推 GBDT与xgboost

先说结论: GBDT与xgboost的主要区别是GBDT利用的一阶导数的思想去拟合每棵树,xgboost利用二阶导数思想去拟合每棵树。 另外xgboost还加入了其他许多技巧,比如xgboost加入和正则项是模型泛化能力更强;同时xgboost还支持并行计算(每棵树还是串行,并行是特征维度的并行);xgboost在训练完一棵树后都会为其叶子节点的分数乘以一个缩减权重(shrinkage)。来给后

独家 | 手推贝叶斯分析:基于真实示例的贝叶斯分析分步演练

作者:ChristianGraf 翻译:Kay 校对:陈丹 本文约2800字,建议阅读8分钟。 在本文中,您将通过一个真实示例来学习如何使用贝叶斯分析。 介绍 与纯频率论方法相比,贝叶斯分析提供了从数据中获得更多见解的可能性。本文将通过一个真实的示例向您介绍如何使用贝叶斯分析。本文将演示选择错误的先验时可能出问题的地方,并且展示如何总结我们的结果。为了让您理解这篇文章,我假设您已经熟悉贝叶斯

白板手推公式性质 AR模型 时间序列分析

白板手推公式性质 AR模型 时间序列分析 视频讲解:https://www.bilibili.com/video/BV1D1421S76v/?spm_id_from=.dynamic.content.click&vd_source=6e452cd7908a2d9b382932f345476fd1 B站对应视频讲解(白板手推公式性质 AR模型 时间序列分析)

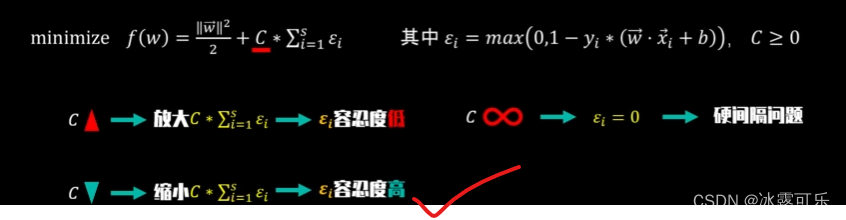

手推支持向量机04-软间隔SVM-模型定义

目录 1.写在前面 2.软间隔SVM(soft-margin SVM) 1.写在前面 前面我们重点介绍了硬间隔SVM,其中涉及到了拉格朗日乘子法,对偶,强对偶关系,原问题和对偶问题,并且利用KKT条件找到最佳超平面。这篇文章将重点介绍软间隔SVM(soft-margin SVM)。 2.软间隔SVM(soft-margin SVM) 我们使用硬间隔S

手推支持向量机03-硬间隔SVM-模型求解(对偶问题之KKT条件)

目录 1.写在前面 2.KTT条件 3.求最终的w*,b*和最终的决策函数 1.写在前面 上面我们讲到了怎么对硬间隔SVM进行求解,我们我们先把带约束问题,转化为无约束问题,通过强对偶关系将minmax转为maxmin,对w,b求min,最终我们求出来最小值,然后关于λ求最大值。 我们最后圈出来的地方,可以变成min,只需要在后面加上符号。因为习

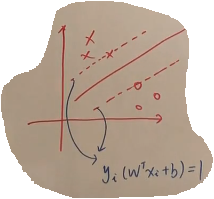

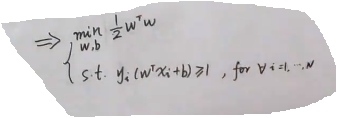

手推支持向量机01-硬间隔SVM-模型定义(最大间隔分类器)

目录 1.写在前面 2.硬间隔SVM(hard-margin SVM) 1.写在前面 支持向量机SVM是机器学习中非常流行的分类算法,最近朋友推荐了机器学习-白板推导系列(六)-支持向量机SVM(Support Vector Machine)视频,感觉这个大佬讲的非常棒,之前写的关于svm的东西太浅显了,于是重新整理,方便以后复习。我们主要是从理论推导SVM是怎么一步一

机器学习(9)---线性回归中的公式推导(手推)、闭式解和数值解

文章目录 一、闭式解(解析解)二、数值解三、一元线性回归中w和b的推导四、多元线性回归中w的推导五、角标问题 一、闭式解(解析解) 1. 在机器学习中,闭式解也被称为解析解(analytical solution),是指可以通过严格的数学公式或方程直接求解出模型参数的解析解。 2. 闭式解通常用于线性回归等一些简单的模型中,其中模型参数的求解可以通过最小二乘法等数学方法直

从香农熵到手推KL散度:一文带你纵览机器学习中的信息论

点击上方“中兴开发者社区”,关注我们 每天读一篇一线开发者原创好文 机器之心编译 参与:Nurhachu Null、蒋思源 信息论与信息熵是 AI 或机器学习中非常重要的概念,我们经常需要使用它的关键思想来描述概率分布或者量化概率分布之间的相似性。在本文中,我们从最基本的自信息和信息熵到交叉熵讨论了信息论的基础,再由最大似然估计推导出 KL 散度而加强我们对量

手推机器学习系列笔记——手推SVM(1)硬间隔、软间隔、约束优化问题、对偶性证明、KKT条件

笔记是听了b站大神的白板推导机器学习系列课,再结合李航老师的《统计学习方法》、周志华老师的西瓜书以及其他优秀博主的博客而成(浑然天成!!!): https://space.bilibili.com/97068901?from=search&seid=9183191776664110144(大神的白板推导机器学习系列课传送门) 对于大神的课,我只能说太强了,讲的特别特别好!下面让我们开始吧!

手推广告论文(一)实时广告投竞标优化与预算控制Real time bid optimization with smooth budget delivery in online advertising

Real time bid optimization with smooth budget delivery in online advertising原论文 实时广告投竞标优化与预算控制 摘要 在当今的在线广告市场,每天都有数以十亿计的广告展示位通过实时竞价(RTB)交易所进行公开拍卖。在这种情况下,广告商需要在毫秒级时间内为每个收到的RTB广告请求提交投标。受预算限制,广告商的目标是购买

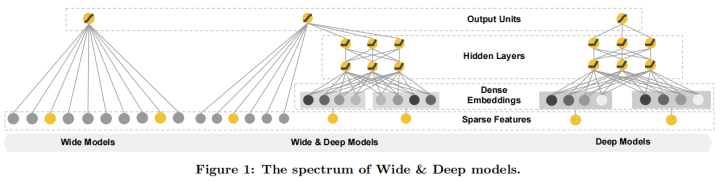

手推广告论文(二)Wide Deep 推荐系统算法Wide Deep Learning for Recommender Systems

Wide & Deep Learning for Recommender Systems 论文地址https://arxiv.org/pdf/1606.07792.pdf 摘要 广义线性模型结合非线性特征转换,在处理具有大规模稀疏输入的回归和分类问题中已被广泛应用。通过一系列交叉积特征转换来记忆特征交互既有效又具有解释性,然而要实现更好的泛化性能,需要投入更多的特征工程工作。相较于此,深度神

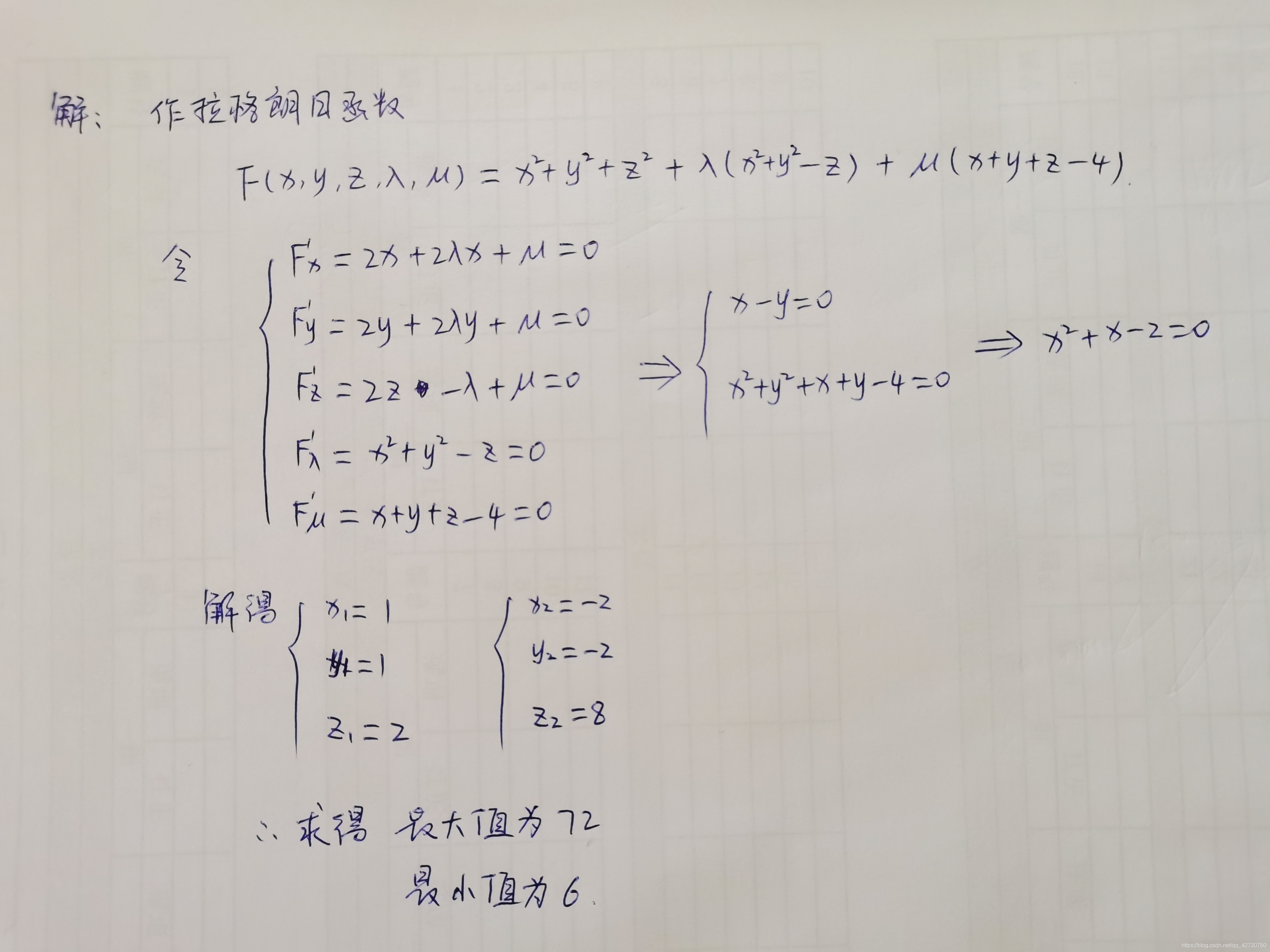

机器学习之支持向量机(手推公式版)

文章目录 前言1. 间隔与支持向量2. 函数方程描述3. 参数求解3.1 拉格朗日乘数3.2 拉格朗日对偶函数 前言 支持向量机 ( S u p p o r t (Support (Support V e c t o r Vector Vector M a c h i n e , S V M ) Machine,SVM) Machine,SVM)源于统计学习理论,是一

复盘:手推SVM支持向量机二分类超平面,求解目标函数原问题,kkt条件,对偶问题求q,核函数、hinge loss损失函数,硬间隔,软间隔,最后得到w和b

复盘:手推SVM支持向量机二分类超平面,求解目标函数原问题,kkt条件,对偶问题求q,核函数、hinge loss损失函数,硬间隔,软间隔,最后得到w和b 提示:系列被面试官问的问题,我自己当时不会,所以下来自己复盘一下,认真学习和总结,以应对未来更多的可能性 关于互联网大厂的笔试面试,都是需要细心准备的 (1)自己的科研经历,科研内容,学习的相关领域知识,要熟悉熟透了 (2)自己的实习经历

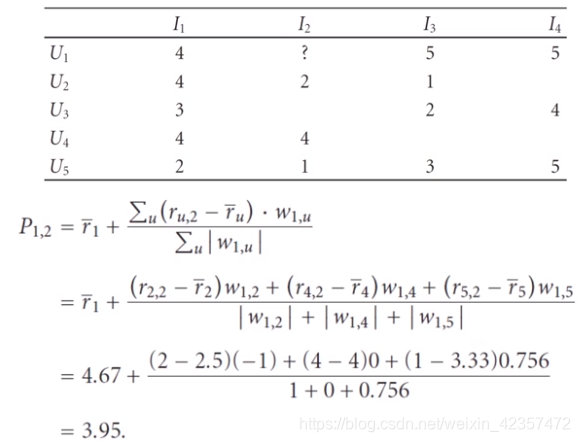

协同过滤之余弦距离相似度计算手推过程

参考:https://www.bilibili.com/video/av38554878?p=4 https://blog.csdn.net/huozi07/article/details/45600963 多维向量余弦距离相似度公式 参考:https://blog.csdn.net/smile_shujie/article/details/89516305 与sklearn 对比