小批量专题

仅使用python标准库(不使用numpy)写一个小批量梯度下降的线性回归算法

看到一个有意思的题目:仅使用python的标准库,完成一个小批量梯度下降的线性回归算法 平常使用numpy这样的计算库习惯了,只允许使用标准库还有点不习惯,下面就使用这个过程来写一个。 import randomfrom typing import List# 生成测试数据def generate_data(num_samples: int, weights: List[float], b

Mxnet (27): 小批量随机梯度下降(Minibatch-SGD)

目前为止,梯度学习的方法中有两个极端: 一次使用所有的数据计算梯度和更新参数;一次计算一次梯度。 1 向量化和缓存 决定使用小批量的主要原因是计算效率。当考虑并行化到多个GPU和多个服务器时很好解释。我们需要向每一个GPU至少发送一个图像,假设每个服务器8个GPU一共16个服务器,那么我们的最小批次已经达到了128。 在单个GPU甚至CPU来看,情况更加微妙。设备的内存类型千奇百怪,用于计算

【深度学习笔记】7_3 小批量随机梯度下降

注:本文为《动手学深度学习》开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图 7.3 小批量随机梯度下降 在每一次迭代中,梯度下降使用整个训练数据集来计算梯度,因此它有时也被称为批量梯度下降(batch gradient descent)。而随机梯度下降在每次迭代中只随机采样一个样本来计算梯度。正如我们在前几章中所看到的,我们还可以在每轮迭代中随机均匀采样多个样本来组成一个

批量梯度下降、随机梯度下降、小批量梯度下降

一、批量梯度下降(Batch Gradient Descent,BGD) 在批量梯度下降中,每次迭代都使用整个训练集的数据进行梯度计算和参数更新。也就是说,每次迭代都对所有的样本求取梯度,然后更新参数。由于要处理整个训练集,批量梯度下降需要较大的内存来存储全部数据,并且计算速度相对较慢。但它的优点是可以保证收敛到全局最优解,尤其在凸优化问题上表现良好。 import numpy as np

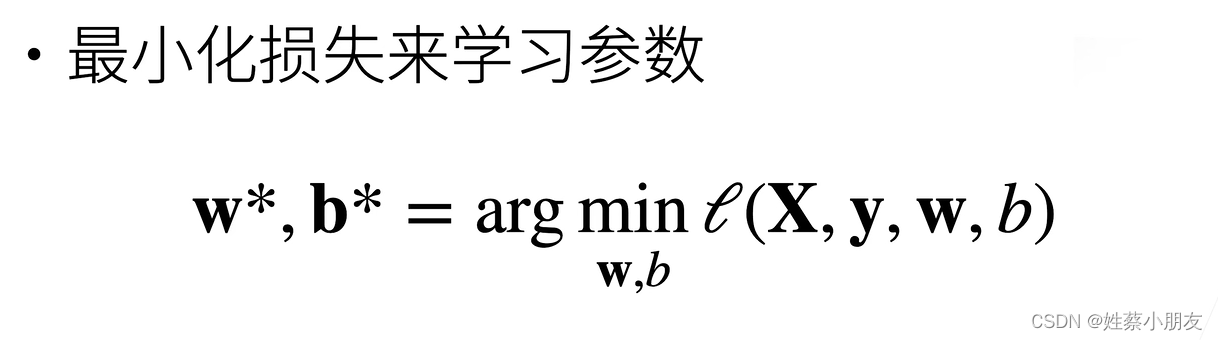

线性回归+小批量梯度下降算法

目录 1.线性模型计算预测值:2.使用均方损失作为损失函数:3.基础优化算法:梯度下降4.训练数据:5.线性回归实现:6.线性回归总结: 1.线性模型计算预测值: 线性模型可以看做单层神经网络。 使用线性模型可以对每个样本数据x计算其预测值y x为一个样本数据一维向量w为权重一维向量,值表示x对应位置所占的权重,未知b为偏差值,未知y为预测值,即加权平均值 2.使用均方损失作

gerber文件怎么导贴片坐标_SMT代工代料要给SMT小批量贴片加工厂哪些资料

SMT代工代料要给SMT小批量贴片加工厂哪些资料,在SMT加工中特别是代工代料,如果出现出现客户提供给电子加工厂的加工资料不足的情况的话会造成加工时间的浪费,从而导致交期受到影响。 在SMT代工代料加工前,需要提供什么资料给SMT小批量贴片加工厂。 一、 Gerber资料文件Gerber文件从PCB文件中导出的一个文件,一般Gerber文件内容有Pad层、阻焊层、丝印层、钢网层,贴片加工厂

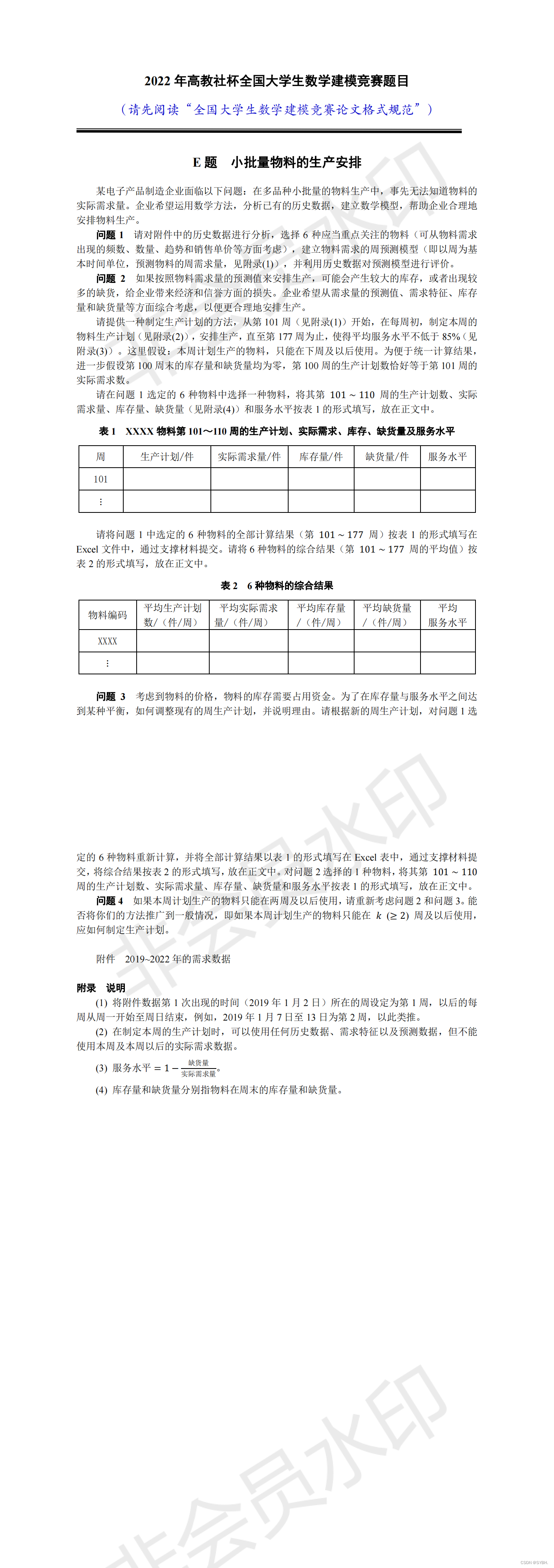

2022年数学建模E题 小批量物料的生产安排(解析及Matlab代码)

订阅专栏2023年9月数学建模比赛期间可获得比赛解析和源码 目录 问题 1 代码及解析: 问题 2 解析及代码: 问题 3

利用小批量训练的方法在子图中进行消息传递

如果用户只想更新图中的部分节点,可以先通过想要囊括的节点编号创建一个子图, 然后在子图上调用 update_all() 方法。例如: nid = [0, 2, 3, 6, 7, 9]sg = g.subgraph(nid)sg.update_all(message_func, reduce_func, apply_node_func) 同时也可以在大图中使用随机(批次)训练。第6章:在大

Tensorflow_tf1简单实现小批量梯度下降

TensorFlow 程序通常分为两部分: 第一部分构建计算图谱(这称为构造阶段), 第二部分运行它(这是执行阶段)。 建设阶段通常构建一个表示ML模型的计算图谱,然后对其进行训练计算。执行 阶段通常运行循环,重复地求出训练步骤,逐渐改进模型参数 0、加载包和数据 ## 加载包import numpy as np from sklearn.datasets import fet

人工智能基础_机器学习014_BGD批量梯度下降公式更新_进一步推导_SGD随机梯度下降和MBGD小批量梯度下降公式进一步推导---人工智能工作笔记0054

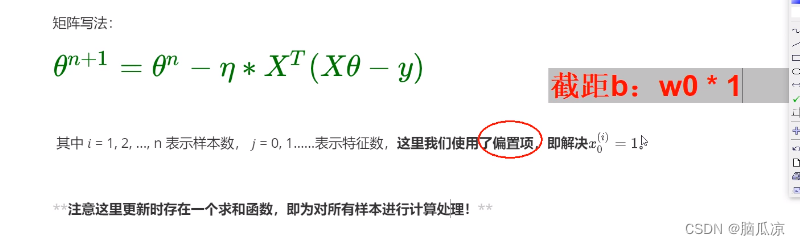

然后我们先来看BGD批量梯度下降,可以看到这里,其实这个公式来源于 梯度下降的公式对吧,其实就是对原始梯度下降公式求偏导以后的梯度下降公式,然后 使用所有样本进行梯度下降得来的,可以看到* 1/n 其实就是求了一个平均数对吧.所有样本的平均数. 然后我们看,我们这里* 1/n那么前面还有一个eta ,对吧,那么这个1/n是个常量对吧,我们下面 就和eta进行了合并,可以看到,这里的

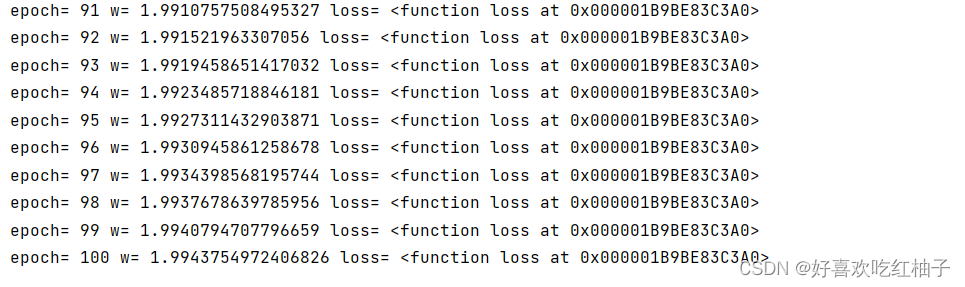

pytorch深度学习实践(二):梯度下降算法详解和代码实现(梯度下降、随机梯度下降、小批量梯度下降的对比)

目录 一、梯度下降1.1 公式与原理1.1.1 cost(w)1.1.2 梯度1.1.3 w的更新 1.2 训练过程可视化1.3 代码实现 二、随机梯度下降(stochastic gradient descent,SDG)2.1 公式与原理2.1.1 w的更新 2.2 代码实现2.3 梯度下降和随机梯度下降的优缺点对比2.3.1 梯度下降算法(Batch Gradient Descent)2

机器学习(四):批量梯度下降法(BGD)、随机梯度下降法(SGD)和小批量梯度下降法(MBGD)

本文基于吴恩达老师的机器学习课程。看了吴恩达老师的机器学习课程,收获很多,想把课上学做的笔记结合自己的理解以及找到的一些资料综合起来做一个总结。大家感兴趣也可以自己去看一看吴恩达老师的课,这套课程,被公认为最好的机器学习的入门教程,下面是课程视频链接: 斯坦福大学公开课 :机器学习课程 上一篇博客机器学习(三):线性回归:梯度下降算法讲了用最小二乘法求得损失函数,再用梯度下降算法最小化损失函数