台大专题

从零对Transformer的理解(台大李宏毅)

Self-attention layer自注意力 对比与传统cnn和rnn,都是需要t-1时刻的状态然后得到t时刻的状态。我不知道这样理解对不对,反正从代码上看我是这么认为的。而transformer的子注意力机制是在同一时刻产生。意思就是输入一个时间序列,在计算完权重后就直接得到状态。 计算注意力机制的参数q,k,v 那么相信大家肯定看不懂上面的,接下来我来说说a(1,n)怎么计算(如图)

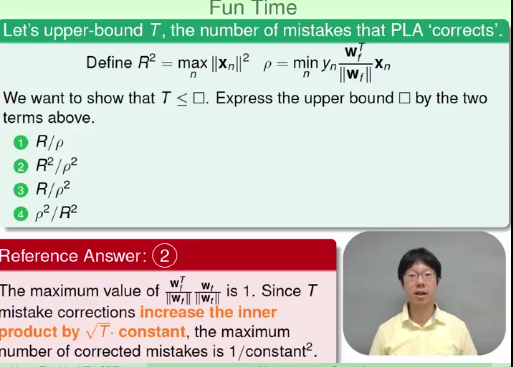

PLA Percentron Learning Algorithm #台大 Machine learning #

Percentron Learning Algorithm 于垃圾邮件的鉴别 这里肯定会预先给定一个关于垃圾邮件词汇的集合(keyword set),然后根据四组不通过的输入样本里面垃圾词汇出现的频率来鉴别是否是垃圾邮件.系统输出+1判定为垃圾邮件,否则不是.这里答案是第二组. 拿二维数据来做例子.我们要选取一条线来划分红

Coursera台大机器学习课程笔记3 – 机器学习的可能性

提纲: 机器学习为什么可能? 引入计算橙球概率问题通过用Hoeffding's inequality解决上面的问题,并得出PAC的概念,证明采样数据学习到的h的错误率可以和全局一致是PAC的将得到的理论应用到机器学习,证明实际机器是可以学习 机器学习的大多数情况下是让机器通过现有的训练集(D)的学习以获得预测未知数据的能力,即选择一个最佳的h做为学习结果,那么这种预测是可

基础补习—概率—台大叶柄成(第二周)

基础补习—概率—台大叶柄成(第二周) 最近在急补概率论与数理统计,无意中发现了这门台大的网课,语言幽默,简单易懂,风评巨赞,在百度云上可以找到这门课的资源。这门课共有9周的课时,每周课时差不多有4节课,每节课12分钟左右,目前差不多一天看一周。2017年10月14日看了第二周的课,将视频相关知识总结在博文中。 集合论 集集复集集、不相交、互斥、De Morgan’s Law 机率名

台大李宏毅课程笔记2——Gradient Descent(梯度下降)

李宏毅课程笔记2 AdagradStochastic Gradient DescentFeature Scaling(特征缩放)梯度下降的理论解释 本次笔记主要包含三节课:Gradient Descent 1 2 3(梯度下降)李老师将梯度下降分为三节来讲,本次笔记对其进行统一的总结和记录。 先放上视频链接: Gradient Descent 1 https://www.bilib

黄仁勋2023台大毕业典礼演讲:你们正处于AI的起跑线上,每个行业都将被革命、重生,为新思想做好准备!...

黄仁勋台大毕典演说全文 》无论是追逐食物、或不被人当食物,你都要不停跑下去 黄仁勋受邀参加台大毕业典礼。他出生于台南,4 岁时随家人离开台湾,前往美国。(摄影者:商业周刊杨文财) 摘要 1.英伟达(Nvidia)创办人黄仁勋受邀参加台湾大学于 5 月 27 日举办的毕业典礼,担任致词嘉宾。他开头先以台语跟大家打招呼,表示台语不够好,因此用英文演说。 2.黄仁勋在演说中分享 3 个 Nvidia

MATLAB教程_04变数(变量)与档案存取_台大郭彦甫课程笔记

MATLAB教程_04变数(变量)与档案存取_台大郭彦甫课程笔记 一、变数/变量-string1、类型2、double 转 integer3、Character(Char)字元 二、变数/变量-structure1、宣告举例——学生作业成绩:2、函数3、嵌套结构 三、变数/变量-Cell Array 单元阵列1、宣告2、访问(读取) Cell Array 单元阵列3、函数4、怎样把矩阵转换成

台大李宏毅机器学习—学习笔记07

熵: 熵(entropy)指的是体系的混乱的程度,在不同的学科中也有引申出的更为具体的定义,是各领域十分重要的参量。信息熵(香农熵): 是一种信息的度量方式,表示信息的混乱程度,也就是说:信息越有序,信息熵越低。信息增益: 在划分数据集前后信息发生的变化称为信息增益。 为了计算熵,我们需要求关于H(X)在以p(x)分布下的信息量的数学期望: 条件熵:条件熵H(Y|X)表示在已知随机变量X的

美女老师台大陈蕴侬深度学习课程最新资料下载

点击上方,选择星标或置顶,每天给你送干货! 阅读大概需要3分钟 跟随小博主,每天进步一丢丢 转载自:AINLP 今天给大家推荐一门最近刚完结的深度学习课程,来自国立台湾大学计算机科学与信息工程助理教授陈蕴侬主讲的《应用深度学习-2020》。已经提前帮大家试听过了,是中文授课噢,赶紧一起来追剧吧!请注意,标题内容来自一位同学在该课程油管视频下的评论。 课程主页: https://www.cs