yuv专题

使用FFmpeg的AVFilter转换YUV到RGB

AVFilter 是 FFmpeg 库 libavfilter 的核心组件,提供了一套强大的音视频处理框架,用于对音视频流进行复杂的过滤、转换和效果处理。通过 AVFilter,开发者可以构建自定义的滤镜图(filter graph),实现各种音视频处理任务,如颜色空间转换、缩放、裁剪、特效添加等。 以下是对 AVFilter 的详细介绍,包括其架构、关键概念、使用方法以及示例代码。 1. A

Linux-视频监控系统(10)-对USB摄像头的YUV图片压缩成视频

需要把图片压缩成摄像头,需要一个工具,就是大名鼎鼎的ffmpeg。ffmpeg的功能实在在太强大了,源代码也比较复杂,同时需要掌握很多音视频压缩的相关知识,我也是初次接触ffmpeg,了解的东西还不是很多,如果需要进一步了解的同学可以参考[总结]FFMPEG视音频编解码零基础学习方法 我在这里呢,总结一下我在开发过程中碰到的问题,以及贴出经过自己理解后的代码。 问题总结 首先是这

LCD显示问题-lcd中像素深度bpp和像素格式(比如RGB,YUV)的关系

lcd中像素深度bpp和像素格式(比如RGB,YUV)的关系 像素深度(bits per pixel,简称bpp) 一个像素的颜色在计算机中由多少个字节数据来描述。计算机中用二进制位来表示一个像素的数据,用来表示一个像素的数据位越多,则这个像素的颜色值更加丰富、分的更细,颜色深度就更深。 一般来说像素深度有这么几种:1位、8位、16位、24位、32位。 像素格式(pixel format

音视频-图像篇(YUV和RGB)

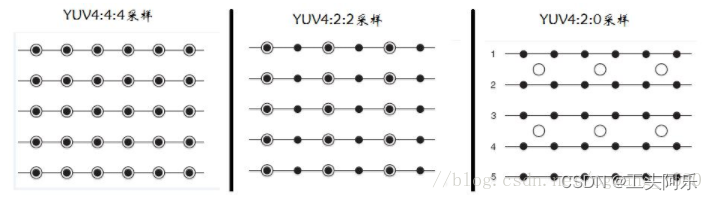

文章目录 一、图像基础概念二、YUV与RGB1.YUV分类方式2.YUV“空间-间”的数据划分1)UV按照“空间-间”的划分方式,分为YUV444、YUV422、YUV4202)YUV“空间-内”的数据划分 3.RGB 三、比较JPG、PNG、GIF、BMP图片格式 一、图像基础概念 像素: 像素是一个图片的基本单位,pix是英语单词picture的简写,加上英语单词“元素e

20240827让飞凌的OK3588-C核心板在Linux R4下通过rockit工具的VI功能获取SONY索尼8530机芯的YUV图

20240827让飞凌的OK3588-C核心板在Linux R4下通过rockit工具的VI功能获取SONY索尼8530机芯的YUV图 2024/8/27 19:40 缘起,我司使用飞凌的OK3588-C的核心板,系统是Linux R4版本。 机芯选用SONY索尼的HDMI OUT接口的8530,输出格式有BGR3/NV16。 我司选用NV16格式了。 由于代理商不给力,让我们直接找Rock

Bayer域、RGB域和YUV域及其图像处理算法简介

Bayer域、RGB域和YUV域是图像处理中的三种不同的颜色空间或数据表示方式,它们各有特点,适用于不同的处理阶段和目的。 Bayer域 定义:Bayer域是指图像传感器捕捉到的原始数据,每个像素只包含红(R)、绿(G)、蓝(B)三种颜色中的一种信息,由拜耳滤色器阵列决定。最常见的模式是RGGB(两个绿色像素夹在红色和蓝色像素之间)。 RGB域 定义:RGB域指的是每个像素包含完整的红、绿

ISP为何先处理RAW、再处理RGB、再处理YUV

文章目录 1. 先处理RAW数据原因:处理步骤: 2. 处理RGB数据原因:处理步骤: 3. 处理YUV数据原因:处理步骤: 总结 先处理RAW数据,再处理RGB数据,最后处理YUV数据是图像信号处理器(ISP)中的标准流程。这种处理顺序的原因涉及图像质量的优化、色彩准确性的确保以及适应不同应用需求的必要性。以下是详细的解释: 1. 先处理RAW数据 原因: 最大化数据保

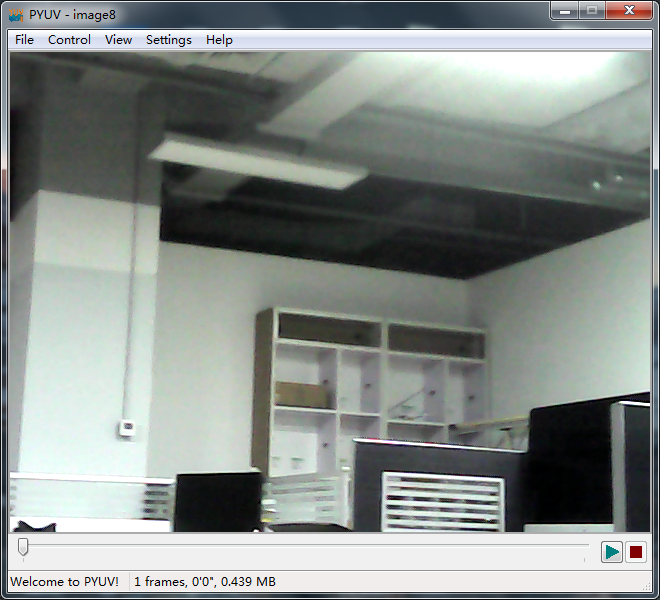

工具(1)查看YUV 图

#灵感# 没啥灵感,就是脑子越来越健忘,就啥都记一笔。 工具名字:YUVPlayer 操作流程: 1、打开YUVPlayer, 把YUV文件拖进来。 2、如果拖进来失败,需要先设置属性, 尤其是YUV类型。 3、成功打开图片后,如果显示不对,可以在【工具】里再次设置。 ps:图像调试过程中,总会出现奇奇怪怪的问题。需要抓 raw、yuv来判断问题出现在sensor上

色彩格式之RGB与YUV

一. RGB色彩模型 1.1 色彩模型原理 已有的研究结论表明, 自然界的任意颜色由三种基本颜色混合而成。三基色为: 红(Red),绿(Green), 蓝(Blue)组成, 这是RGB 色彩模型的原理。所以,描述一个颜色可以用R、G、B颜色分量表示. 1.2 色彩空间 色彩空间又称色域,就是某种技术系统所能定义的色彩范围

【音视频 | YUV格式】深入理解 YUV 数据格式,一文弄懂

😁博客主页😁:🚀https://blog.csdn.net/wkd_007🚀 🤑博客内容🤑:🍭嵌入式开发、Linux、C语言、C++、数据结构、音视频🍭 🤣本文内容🤣:🍭介绍YUV数据格式🍭 😎金句分享😎:🍭你不能选择最好的,但最好的会来选择你——泰戈尔🍭 ⏰发布时间⏰: 2024-08-20 09:47:15 本文未经允许,不得转发!!! 目录 �

YUV测试视频下载地址

测试视频编解码器所需的yuv测试序列网址。 http://media.xiph.org/video/derf/ http://trace.eas.asu.edu/ ftp://ftp.ldv.ei.tum.de/videolab/public/SVT_Test_Set/

毕设系列之Libx264实时视频流(YUV 420P转H264视频编码篇)

#PS:要转载请注明出处,本人版权所有 #PS:这个只是 《 我自己 》理解,如果和你的 #原则相冲突,请谅解,勿喷 开发环境:Ubuntu 16.04 LTS 本文的技术实现部分参考雷博士的这篇文章。http://blog.csdn.net/leixiaohua1020/article/details/42078645 1、现在网上关于H264的文章有很多,但是我个人认为最好的就是

RAW Sensor vs YUV Sensor:详细对比

目录 一、RAW传感器1.1 定义1.2 工作原理1.3 优点1.4 缺点1.5 应用场景 二、YUV传感器2.1 定义2.2 工作原理2.3 优点2.4 缺点2.5 应用场景 三、总结 在现代智能手机和数码相机中,图像传感器(Image Sensor)是至关重要的组件,它决定了设备的图像捕捉能力。常见的图像传感器类型有两种:RAW传感器(Raw Sensor)和YUV传感器(

YUV格式与RGB格式详解

图像处理 文章目录 图像处理前言YUV 格式YUV 采样 前言 像素格式描述了像素数据存储所用的格式,定义了像素在内存中的编码方式。RGB 和 YUV 为两种经常使用的像素格式。/ 1024 / 1024 = 2.63 MB 存储空间。 RGB 和 RGBA 格式 RGB 图像具有三个通道 R、G、B,分别对应红、绿、蓝三个分量,由三个分量的值决定颜色,一般也叫做 RG

模块[camera]_RGB/HSV/YUV颜色空间模型总结

转自:http://blog.sina.com.cn/s/blog_679741950100ivz0.html 颜色通常用三个相对独立的属性来描述,三个独立变量综合作用,自然就构成一个空间坐标,这就是颜色空间。而颜色可以由不同的角度,用三个一组的不同属性加以描述,就产生了不同的颜色空间。但被描述的颜色对象本身是客观的,不同颜色空间只是从不同的角度去衡量同一个对象。

模块[camera]_摄像头的YUV

搞驱动,时间长了便成万事通,要做摄像头相关,那就顺便瞧瞧: YUV,是一种颜色编码方法。 YUV是编译true-color颜色空间(color space)的种类,Y'UV, YUV, YCbCr,YPbPr等专有名词都可以称为YUV,彼此有重叠。 “Y”表示明亮度(Luminance、Luma), “U”是色度(Chrominance) “V”则是浓度(Chroma)

V4L2视频采集与H264编码2—v4l2采集YUV数据

在上一篇中因为是在PC机上使用的USB摄像头只能支持GPEG image格式,但是H264编码需要使用YUV数据,所以我找了个ARM开发板来做测试。本以为代码从PC机移植到开发板是很简单的一个事,谁知因为平台或是V4L2底层驱动的不同,最终也是花了九牛二虎之力才把问题给解了。话不多说,直接上代码: [objc] view plain copy /*===========

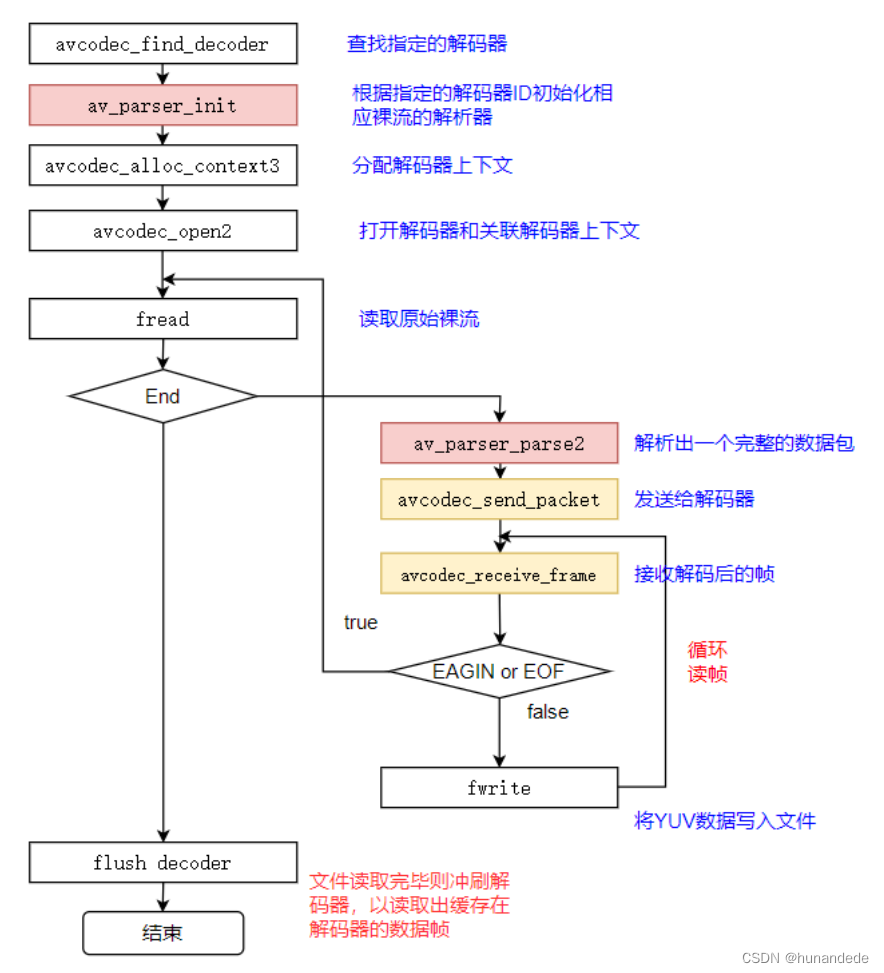

音视频开发19 FFmpeg 视频解码- 将 h264 转化成 yuv

视频解码过程 视频解码过程如下图所示: ⼀般解出来的是420p FFmpeg流程 这里的流程是和音频的解码过程一样的,不同的只有在存储YUV数据的时候的形式 存储YUV 数据 如果知道YUV 数据的格式 前提:这里我们打开的h264文件,默认是YUV420P 格式的, 我们可以通过 AVFrame->frame 获得,获得的值如果

Qml 中实现对原始视频图像格式( YUV / RGB )支持

【写在前面】 之前一直在学着视频相关的知识,然后工作也正好是监控相关的。 并且界面部分用 Qml 开发的 ( 相当舒服,是我擅长且喜欢的 )。 一开始,我觉得相当容易,只是显示解码好的图像而已,没什么难度。 记得前面写过一篇在 Qml 中使用 QImage:Qml中实现多视图,多图像源(QImage / QPixmap)_梦起

Android上使用OpenGLES2.0显示YUV数据

亲测可用:http://blog.csdn.net/ueryueryuery/article/details/17608185 楼主收到这样的任务,在Android上用OpenGLES来显示YUV图像,之所以这样做,是因为: 1.Android本身也不能直接显示YUV图像,YUV转成RGB还是必要的; 2.YUV手动转RGB会占用大量的CPU资源,如果以这样的形式播放视频,手机会很

经典算法,yuv与rgb互转,查表法,让你的软件飞起来

代码的运算速度取决于以下几个方面 1、 算法本身的复杂度,比如MPEG比JPEG复杂,JPEG比BMP图片的编码复杂。 2、 CPU自身的速度和设计架构 3、 CPU的总线带宽 4、 您自己代码的写法 将RGB格式的彩色图像先转换成YUV图像。 图像转换的公式如下: Y = 0.299 * R + 0.587 * G + 0.114 * B; 图像尺寸640*480*24bit

不同格式的YUV 和 RGB互转

YUV色彩空间: Y是亮度值,也就是说8位的灰度值即可组成一幅黑白图像,黑白电视机就是这样的. UV是色彩值,是给Y上色用的.U是Cb也就是RGB中的蓝色分量,V是Cr也就是RGB中的红色分量. YUV444 指的是每四个像素采样中每个亮度Y分量都有一个色彩UV分量上色. YUV422 指的是每四个像素采样中两个亮度Y分

【YUV格式数据】【ffplay】播放或者查看YUV格式图片或文件数据

背景 最近在调试hisi解码功能,需要把h264格式解码成yuv数据,调试的时候需要最后查看下出来的yuv格式数据是否正常,需要用到一些工具软件进行查看。然后就做个总结。 解决方案 方案1:使用ffplay命令播放YUV文件 使用ffplay命令播放图片数据 电脑上装了ffmpeg,用相关命令非常方便。ffplay播放yuv格式的图片数据: ffplay -pixel_format