tun专题

tunctl添加虚拟网卡TUN/TAP与brctl添加网桥

1 Linux添加虚拟网卡三种方法 方法1: ifconfig命令创建\删除虚拟网卡 ifconfig eth0:0 192.168.1.10 netmask 255.255.255.0 up 删除虚拟网卡: ifconfig eth0:0 down 重启服务器或者网络后,虚拟网卡就失效. 注意:添加的虚拟网卡和原网卡物理地址是一样的。 方法2: 修改网卡配置文件 在ub

NAT、TUN、DR总结

Virtual Server via NAT VS/NAT 的优点是服务器可以运行任何支持TCP/IP的操作系统,它只需要一个IP地址配置在调度器上,服务器组可以用私有的IP地址。缺点是它的伸缩能力有限, 当服务器结点数目升到20时,调度器本身有可能成为系统的新瓶颈,因为在VS/NAT中请求和响应报文都需要通过负载调度器。 我们在Pentium 166 处理器的主机上测得重写报文的平均延时为

TUN(IP Tunneling)介绍

通过IP隧道实现虚拟服务器(VS/TUN) 在VS/NAT 的集群系统中,请求和响应的数据报文都需要通过负载调度器,当真实服务器的数目在10台和20台之间时,负载调度器将成为整个集群系统的新瓶颈。大多数 Internet服务都有这样的特点:请求报文较短而响应报文往往包含大量的数据。如果能将请求和响应分开处理,即在负载调度器中只负责调度请求而响应直 接返回给客户,将极大地提高整个集群系统的吞吐

高可用架构最终一致性tUN兔粮

强一致性比较难,比如用分布式锁。分布式事务,那么开销就会很大,吞吐量比较低,很难实现。 看下面两种情况: 第一种:先更新数据库,在更新缓存 有可能数据库更新成功,缓存没有更新成功,那么缓存里面就是一些脏数据; 第二种:先更新缓存,再更新数据库 缓存更新成功了,数据库更新失败,那么数据库中的数据都没有持久化下来。 主要这些数据库和缓存的操作是没有原子的,那么追求高可用,

OpenStack Neutron解析---Linux Bridge Tun Tap

http://panpei.net.cn/2013/12/04/openstack-neutron-mechanism-introduce/ OpenStack Neutron运行机制解析概要 自从开学以来,玩OpenStack也已经3个月了,这段时间主要把精力投在了OpenStack的安装部署和网络组件Neutron的研究上了。这期间零零散散在安装部署和Neutron运作原理上来回切换,有

Linux的TUN/TAP编程 2

TUN/TAP虚拟网络设备为用户空间程序提供了网络数据包的发送和接收能力。他既可以当做点对点设备(TUN),也可以当做以太网设备(TAP)。实际上,不仅Linux支持TUN/TAP虚拟网络设备,其他UNIX也是支持的,他们之间只有少许差别。 原理简介 TUN/TAP虚拟网络设备的原理比较简单,他在Linux内核中添加了一个TUN/TAP虚拟网络设备的驱动程序和一个与之相关连的字符设备/dev/

LVS/Tun 成功案例

前阵子在LVS中文站找资料,发现很多人反应LVS的TUN模式搭建不成功,很多人反应网上的资料很混杂,但是照着做都没做成功,稍微有点郁闷。这里分享一个成功的案例,希望能帮到有需要的朋友。 本文将介绍IPIP协议,LVS/TUN 搭建,以及在TUN模式下通过iptables实现端口转发等内容。 之前看了很多网上的资料都说企业中用的最多的是DR模式,因为DR相比于TUN不用额外的

120011111111QEMU中启动单虚拟机并已TAP/TUN方式联网的方法请参见:QEMU中启动单虚拟机并已TAP/TUN方式联网的方法请参见:QEMU中启动单虚拟机并已TAP/TUN方式联网的方

用Qemu模拟ARM(1) 前面已经安装并配置了编译链和qemu,现在可以用qemu来模拟arm平台了。 1. Hello, Qemu! 输入下面的代码: hello.c - hello.c #include<stdio.h>int main(){ printf("Hello, Qemu!\n"); return 0;} 编译并运行: $ ar

br-tun无法创建GRE接口

症状:VM启动ok,web界面显示有ip,但是vnc进去显示无ip,手动设置ip后也ping不通 排查,查看: ovs-ofctl show br-tun 发现bt-tun上面没有GRE隧道的接口 然后日志中: ERROR neutron.agent.linux.ovs_lib [-] Unable to execute ['ovs-ofctl', 'add-flow'

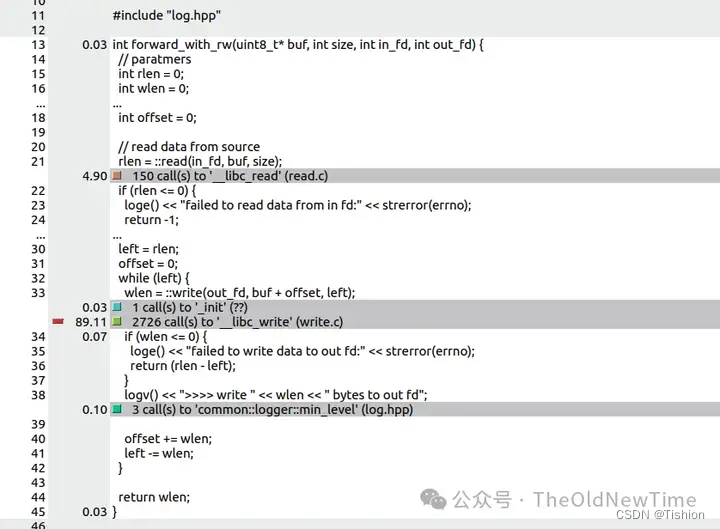

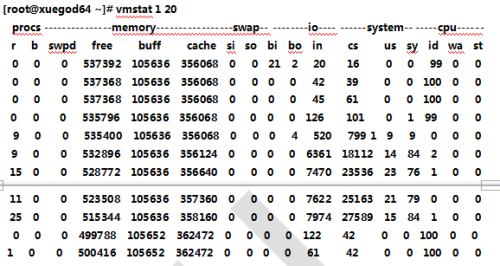

Linux TUN设备实现Tunnel性能分析

一、TUN/TAP设备原理: Linux的TUN/TAP设备是一种可以使得应用层与TCP/IP协议栈交互的驱动模块,通常用于组建虚拟局域网中的点对点隧道(Tunnel),可以工作于2层(TAP设备)和3层(TUN设备)数据交换。其工作原理图如下: 1. 数据发送流程 应用程序通过socket向192.168.1.22地址发送数据{DATA} 数据进入内核协议栈,协议栈构造IP报文,生

Linux tun/tap 驱动多队列模式(C/C++)

LINUX 内核在3.X版本才支持,正式是到 4.1 版本内核才加入到内核之中被支持,所以相对来说距今时间上来说是比较新的一种扩展技术。 多队列模式的 tun/tap 可以显著的提高,单个 tun/tap 网卡的带宽吞吐速度,但肯定没有 DPDK 那种零拷贝不内核切换的效率高。 一般来说,tun/tap 的效率与内核直接处理网卡数据速度,大约差距至少5倍左右,即 1000Mbps,tun/

LVS -- 四种工作模式的优缺点比较(NAT/TUN/DR/FULLNAT)

LVS模式 LVS:Linux Virtual Server,Linux虚拟服务器,是一个虚拟的服务器集群系统。本项目在1998年5月由章文嵩博士成立,是中国国内最早出现的自由软件项目之一。工作在TCP/IP协议的四层,其转发是依赖于四层协议的特征进行转发,由于其转发要依赖于协议的特征进行转发,因此需要在内核的TCP/IP协议栈进行过滤筛选,这就需要在内核的模块来完成,而这样的过滤转发规则又是由

负载均衡(L B)、集群、LVS、DR、TUN、NAT、fullNAT

负载均衡(Load Balance) 提供故障转移,实现高可用分摊到多个操作单元上进行执行,例如Web服务器、 FTP服务器、企业关键应用服务器和其它关键任务服务器等,共同完成工作任务解决并发压力,提高应用处理性能,增加吞吐量,加强网络处理能力,提高网络的灵活性和可用性安全防护,及负载均衡设备上做一些过滤,黑白名单等处理 集群(cluster) 集群是一组相互独立的、通过高速网络互联的计算机

Linux虚拟网卡TUN/TAP

Linux虚拟网卡TUN/TAPTUN/TAP 提供了给用户空间程序的包的接收和传输,它可以看成是简单的点对点设备或是以太网设备。它不是从物理设备接收包,而是从用户空间程序接收包。它发送包不是通过物理设备来发送包,而是将这些包写入用户空间程序来发送。为了应用这个驱动,应用程序需要打开/dev/net/tun 设备(字符设备),然后发出一个控制(ioctl)来注册一个网卡设备,一个网络设备将命名为t

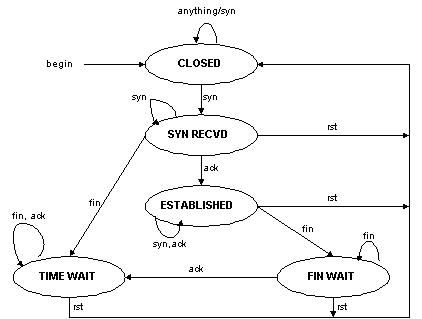

TUN/TAP设备浅析(三) -- TUN/TAP设备的应用

上一篇文章主要讲述了TUN/TAP设备的一些原理,你可能会好奇,TUN/TAP设备究竟有什么用处呢?所以这篇文章,我想用一些实际的例子来回答这个问题。 例子源自陈硕老师的博客,博文中关于TUN/TAP设备的使用非常典型,对原文感兴趣的同学可以查看这里:http://blog.csdn.net/solstice/article/details/6579232 背景:在一台 PC 机上模拟 TCP

使用LVS+TUN搭建集群实现负载均衡

TUN模式的概述与工作原理 TUN模式服务概述: IP Tunneling(IP隧道) --可以在不同地域,不同网段 Director分配请求到不同的real server。real server处理请求后直接回应给用户,这样director负载均衡器仅处理客户机与服务器的一半连接。IP Tunneling技术极大地提高了director的调度处理能力,同时也极大

使用LVS+TUN搭建集群实现负载均衡

TUN模式的概述与工作原理 TUN模式服务概述: IP Tunneling(IP隧道) --可以在不同地域,不同网段 Director分配请求到不同的real server。real server处理请求后直接回应给用户,这样director负载均衡器仅处理客户机与服务器的一半连接。IP Tunneling技术极大地提高了director的调度处理能力,同时也极大

Microsoft Wi-Fi Direct Virtual Adapter本地连接#2 hyper-v 交换机 wsl localhost tun tap模式代理 wsl代理

总的来说是开热点的。(可以同时连wifi,还开着热点。好nb哦。手机好像是不行的。电脑好像有适配器之类,而且,wifi物理网卡一般都有好几个信道的。) 底层原理不清楚。 参与文章:Everything About Microsoft Wi-Fi Direct Virtual Adapter 这个注册表在:hklm\system\currentcontrolset\services\wlansvc

TAP/TUN Vnet veth

TAP 设备与 VETH 设备 TUN/TAP 设备是一种让用户态程序向内核协议栈注入数据的设备,一个工作在三层,一个工作在二层,使用较多的是 TAP 设备。VETH 设备出现较早,它的作用是反转通讯数据的方向,需要发送的数据会被转换成需要收到的数据重新送入内核网络层进行处理,从而间接的完成数据的注入。 图 3 .TAP 设备和 VETH 设备工作过程 如图所示

Linux虚拟网络设备之tun/tap和veth设备的特点

在现在的云时代,到处都是虚拟机和容器,它们背后的网络管理都离不开虚拟网络设备,所以了解虚拟网络设备有利于我们更好的理解云时代的网络结构。从本篇开始,将介绍Linux下的虚拟网络设备。 虚拟设备和物理设备的区别 在Linux网络数据包的接收过程和数据包的发送过程这两篇文章中,介绍了数据包的收发流程,知道了Linux内核中有一个网络设备管理层,处于网络设备驱动和协议栈之间,负责衔接它们之间的数据交

openstack H版本多节点openvswitch的br-tun无法创建gre tunnel的解决方法

特点:VM可以启动,web界面显示有ip,但是vnc进去显示无ip,手动设置ip后也ping不通 通过以下命令可以查看br-tun上面没有建立GRE隧道 ovs-ofctl show br-tun 然后openvswitch-agent的日志中显示: ERROR neutron.agent.linux.ovs_lib [-] Unable to execute ['ov

LVS NAT/TUN/DR三种模式比较

LVS共有三种模式,优缺点比较如下:NAT模式优点:集群中的物理服务器可以使用任何支持TCP/IP操作系统,物理服务器可以分配Internet的保留私有地址,只有负载均衡器需要一个合法的IP地址。不足:扩展性有限。当服务器节点(普通PC服务器)数据增长到20个或更多时,负载均衡器将成为整个系统的瓶颈,因为所有的请求包和应答包都需要经过负载均衡器再生。假使TCP包的平均长度是536字节的话,平均

LVS DR TUN(IP Tunneling)介绍

通过IP隧道实现虚拟服务器(VS/TUN) 在VS/NAT 的集群系统中,请求和响应的数据报文都需要通过负载调度器,当真实服务器的数目在10台和20台之间时,负载调度器将成为整个集群系统的新瓶颈。大多数 Internet服务都有这样的特点:请求报文较短而响应报文往往包含大量的数据。如果能将请求和响应分开处理,即在负载调度器中只负责调度请求而响应直 接返回给客户,将极大地提高整个集群系统的吞吐

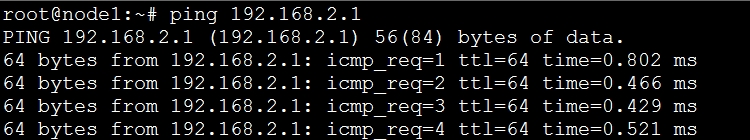

零入门kubernetes网络实战-23->基于tun虚拟网络设备来构建点对点的VPN案例(golang版本、helloworld级别)

《零入门kubernetes网络实战》视频专栏地址 https://www.ixigua.com/7193641905282875942 本篇文章视频地址(稍后上传) 本篇文章主要是练习: 通过tun设备来实现跨主机通信测试在宿主机-1上使用curl命令可以访问宿主机-2上的web服务; 请求有去,有回 测试在宿主机-1上使用ping命令 可以ping通 宿主机-2上的tun类型的虚拟网

LVS NAT/DR/TUN三种模式

本文为汇总加个人改动类型 1 什么是LVS LVS是Linux Virtual Server的简写,意即Linux虚拟服务器,是一个虚拟的服务器集群系统。该项目在1998年5月由章文嵩博士成立,是中国国内最早出现的自由软件项目之一。 LVS主要有负载均衡调度器和RealServer组成。 2 LVS工作模式 LVS工作模式分为NAT模式、TUN模式、以及DR模式。 2.1 NAT

TUN设备和TAP设备

文章目录 TUN/TAP 的发展历史TUN/TAP设备数据流outter flowinner flowoutter flow 与 inner flow 的应用场景 TAP设备TAP设备实现 VLANqemu 实例TAP设备实现VLAN时的数据流 TAP设备实现 VPN实例TAP设备实现VPN时的数据流 TUN设备TUN设备实现 VPN实例TUN设备实现VPN时的数据流 TUN