trainer专题

使用 HuggingFace 中的 Trainer 进行 BERT 模型微调,太方便了!!!

节前,我们星球组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学. 针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。 汇总合集: 《大模型面试宝典》(2024版) 发布!圈粉无数!《PyTorch 实战宝典》火了!!! 以往,我们在使用HuggingFace在训练BERT模型时,代码

YOLOV8逐步分解(3)_trainer训练之模型加载

yolov8逐步分解(1)--默认参数&超参配置文件加载 yolov8逐步分解(2)_DetectionTrainer类初始化过程 接上2篇文章,继续讲解yolov8训练过程中的模型加载过程。 使用默认参数完成训练器trainer的初始化后,执行训练函数train()开始YOLOV8的训练。 1. train()方法实现代码如下所示: def train(self):"""A

【CenterFusion】run_epoch()函数-训练一轮epoch-CenterFusion/src/lib/trainer.py

文件位置:CenterFusion/src/lib/trainer.py run_epoch作用:CenterFusion 项目训练一轮epoch过程 在 main.py 函数中,生成了训练器,然后再使用训练器训练一个 epochrun_epoch()函数的定义在src\lib\trainer.py150行左右,它的主要过程如下所示: def run_epoch(self, phase,

【Python】科研代码学习:八 FineTune PretrainedModel (用 trainer,用 script);LLM文本生成

【Python】科研代码学习:八 FineTune PretrainedModel [用 trainer,用 script] LLM文本生成 自己整理的 HF 库的核心关系图用 trainer 来微调一个预训练模型用 script 来做训练任务使用 LLM 做生成任务可能犯的错误,以及解决措施 自己整理的 HF 库的核心关系图 根据前面几期,自己整理的核心库的使用/继承关系

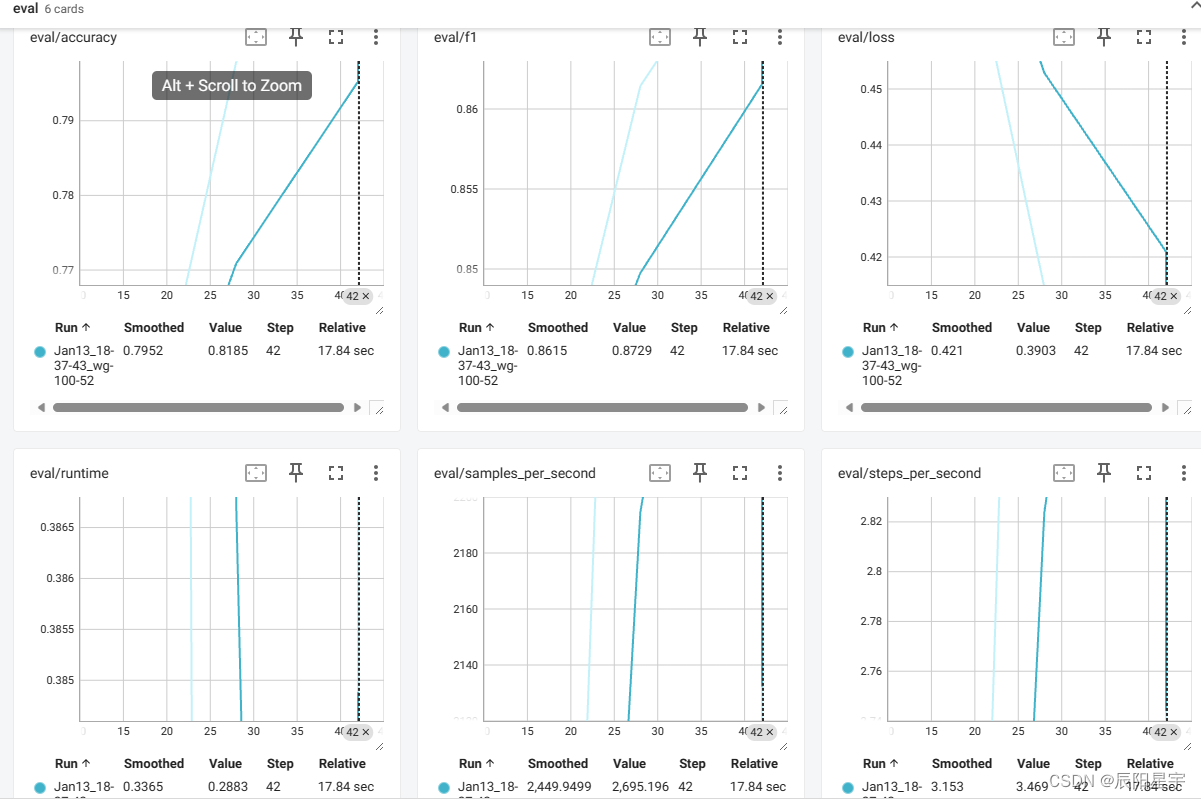

NLP(六十六)使用HuggingFace中的Trainer进行BERT模型微调

以往,我们在使用HuggingFace在训练BERT模型时,代码写得比较复杂,涉及到数据处理、token编码、模型编码、模型训练等步骤,从事NLP领域的人都有这种切身感受。事实上,HugggingFace中提供了datasets模块(数据处理)和Trainer函数,使得我们的模型训练较为方便。关于datasets模块,可参考文章NLP(六十二)HuggingFace中的Datasets使用。

ChatGLM的Trainer模块解析

Trainer类 为什么这样比较好 Trainer是一个简单但功能完备的PyTorch训练和评估循环,针对🤗 Transformers进行了优化。 参数: model: [PreTrainedModel]或torch.nn.Module类型,可选。用于训练、评估或预测的模型。如果未提供,则必须传入model_init。args: [TrainingArguments]类型,可选。用于调整

飞桨自然语言处理框架 paddlenlp的 trainer

飞桨(PaddlePaddle)的NLP库PaddleNLP中的Trainer类是一个用于训练和评估模型的简单但功能完整的循环。它被优化用于与PaddleNLP一起使用。Trainer类简化了训练过程,提供了自动的批处理、模型保存、日志记录等特性。 以下是Trainer类的主要参数和功能: 模型: model:可以是一个预训练的模型或一个自定义的paddle.nn.Layer。如果使用自定义模型

【HuggingFace Transformer库学习笔记】基础组件学习:Trainer

基础组件学习——Trainer 导入包 from transformers import AutoTokenizer, AutoModelForSequenceClassification, Trainer, TrainingArgumentsfrom datasets import load_dataset 加载数据集 dataset = load_dataset("csv",

FATE —— 二.2.5 Homo-NN定制Trainer以控制训练过程

前言 在本教程中,您将学习如何创建和定制您自己的Trainer,以控制培训过程、进行预测并汇总结果以满足您的特定需求。我们将首先向您介绍需要实现的TrainerBase类的接口。然后,我们将提供FedProx算法的工具示例(请注意,这只是一个工具示例,不应在生产中使用),以帮助您更好地理解教练定制的概念。 Trainer基本类 基础 TrainerBase Class是FATE中所有Homo N

FATE —— 二.2.6 Homo-NN使用FATE接口Trainer

前言 在本教程中,我们将演示如何使用培训师用户界面返回格式化的预测结果,评估模型的性能,保存模型,并在仪表板上显示损失曲线和性能分数。这些接口允许您的培训师与FATE框架集成,使其更易于使用。 由于官方网站的示例代码有一定的错误,所以在此进行声明,改正后的_proximal_term如下所示: def _proximal_term(self, model_a, model_b):diff_ =

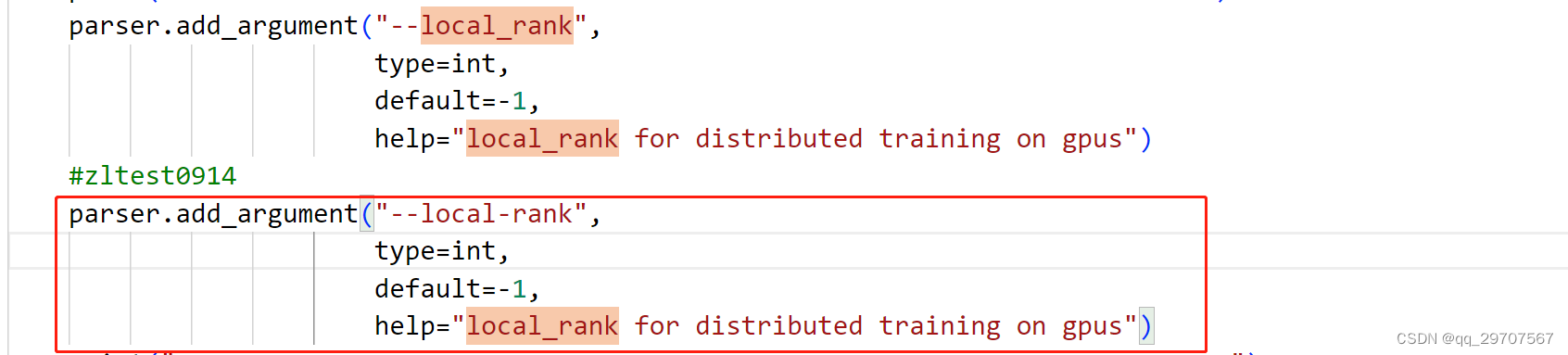

【deepspeed】 gpt模型训练报错run_clm_no_trainer.py: error: unrecognized arguments: --local-rank=0

测试场景:使用deepspeed框架训练gpt模型 问题: 报错torch.distributed.elastic.multiprocessing.errors.ChildFailedError 具体见截图: 解决办法: 含义:表明在运行 train.py 脚本时,传递了一个未被识别的参数 --local-rank=1 这里我在train.py脚本文件中果然没有找到–local