task2专题

【深度学习详解】Task2 分段线性模型-引入深度学习 Datawhale X 李宏毅苹果书 AI夏令营

前言 《苹果书》第一章的内容包括 机器学习基础 -> 线性模型 -> 分段线性模型 -> 引入深度学习 这一篇章我们继续后续内容 ~ 其中涉及到“激活函数”的作用理解: 除了 开源项目 - 跟李宏毅学深度学习(入门) 之外, 还有 @3Blue1Brown 的神经网络 和 @StatQuest 的深度学习 视频内容辅助。 🍎 🍎 系列文章导航 【深度学习详解】Task1 机器学习基础-

Datawhale X 李宏毅苹果书 AI夏令营 Task2打卡

线性模型(Linear model) 通常模型的修改来自于对问题的理解,即领域知识 基本定义:把输入特征x乘上一个权重,再加上一个偏置就可以得到预测的结果。 优点:简单易理解,可理解性好(权重w可以直观表达了各属性在预测中的重要性) 1 分段线性曲线 1.1 线性模型的局限性 Linear(线性)的Model太过简单,对于绝大多数的实际情况来说x1与y的关系不是简单的线

【2024】Datawhale AI夏令营-从零上手Mobile Agent-Task2笔记

【2024】Datawhale AI夏令营-从零上手Mobile Agent-Task2笔记 本文介绍通义实验室最新的多模态手机智能体工作——Mobile-Agent。 一、大模型智能体背景 1.1 大模型智能体的优势 随着大模型的高速发展,大模型智能体成为热门研究方向,受到工业界和学术界的广泛关注。 在大模型智能体诞生之前,智能体主要基于强化学习(RL)设计,如OpenAI Five和

Datawhale X 李宏毅苹果书 AI夏令营 进阶 Task2-自适应学习率+分类

目录 1.自适应学习率1.1 AdaGrad1.2 RMSProp1.3 Adam1.4 学习率调度1.5 优化策略的总结 2.分类2.1 分类与回归的关系2.2 带有 softmax 的分类2.3 分类损失 1.自适应学习率 传统的梯度下降方法在优化过程中常常面临学习率设置不当的问题。固定的学习率在训练初期可能过大,导致模型训练不稳定,而在后期可能过小,导致训练速度缓慢。为了

Datawhale X 李宏毅苹果书 AI夏令营 Task2笔记

Datawhale X 李宏毅苹果书 向李宏毅学深度学习(进阶) 是 Datawhale 2024 年 AI 夏令营第五期的学习活动(“深度学习 进阶”方向) 往期task1链接:深度学习进阶-Task1 我做的task1的笔记博客:传送门 Datawhale官方的task2链接:深度学习进阶-Task2 Github-

【Datawhale X 李宏毅苹果书 AI夏令营】《深度学习详解》Task2 打卡

文章目录 前言学习目标一、线性模型二、分段线性曲线总结 前言 本文是【Datawhale X 李宏毅苹果书 AI夏令营】的Task2学习笔记打卡。 学习目标 李宏毅老师对应视频课程:https://www.bilibili.com/video/BV1JA411c7VT?p=3 《深度学习详解》第一章主要介绍了深度学习中的基础数学知识。 一、线性模型 经过了前面的梯

DataWhale AI夏令营-《李宏毅深度学习教程》笔记-task2

DataWhale AI夏令营-《李宏毅深度学习教程》笔记 第四章 卷积神经网络卷积神经网络构成一个通俗的例子 第四章 卷积神经网络 这部分看书的时候感觉云里雾里的,好在之前学过一些卷积神经网络、全链接、感受野的概念,我就用自己的理解阐述一篇笔记吧,当复习了。 卷积神经网络构成 传统的卷积神经网络由三部分构成: 卷积层:想象你拿一个小窗口在图片上滑动,每次看到的只是局部区域

Datawhale X 李宏毅苹果书 AI夏令营 task2

《深度学习详解》 - 自适应学习率(Task2) 1. 自适应学习率的背景与重要性 学习率的挑战: 在训练深度学习模型时,选择合适的学习率至关重要。过大的学习率会导致训练过程中的震荡,使模型无法收敛;过小的学习率则会导致训练速度缓慢,甚至可能陷入局部最优解。为了克服这些问题,自适应学习率(Adaptive Learning Rate)算法应运而生。 图 3.18 展示了训练网络时损失的变

Datawhale X 李宏毅苹果书 AI夏令营_深度学习基础学习心得Task2

本次学习主要针对自适应学习率;介绍了Adagrad,RMSprop和Adam优化器 1、为什么需要自适应学习率: 训练一个网络,在走到临界点的时候损失不再下降,而梯度并没有变得很小。相当于下坡路在两步之间,而步子迈大了,直接把下坡路跳过了,又走到上坡路上了。在这时候就需要把学习率(步幅)调低一点让梯度继续下降。 但是常规的 学习率下降方法是不够用的,我们希望在梯度大的时候走慢点,在梯度小的时

Datawhale-爬虫-Task2(正则表达式)

学习内容 什么是正则表达式案例 什么是正则表达式 定义:一套规则,可以在字符串文本中进行搜查替换等使用步骤: 1.使用 compile() 函数将正则表达式的字符串编译成一个 pattern 对象2.通过 pattern 对象的一些方法对文本进行匹配,匹配结果是一个 match对象3.用 match 对象的方法,对结果进行操作 常用方法: match:从开始位置开始查找,一次匹

【无标题】天池机器学习task2

GridSearchCV,它存在的意义就是自动调参,只要把参数输进去,就能给出最优化的结果和参数。但是这个方法适合于小数据集,一旦数据的量级上去了,很难得出结果。这个时候就是需要动脑筋了。数据量比较大的时候可以使用一个快速调优的方法——坐标下降。它其实是一种贪心算法:拿当前对模型影响最大的参数调优,直到最优化;再拿下一个影响最大的参数调优,如此下去,直到所有的参数调整完毕。这个方法的缺点就是可能会

DW-matplotlib-Task2

一、概述 1、matplotlib的三层API matplotlib的原理是用Artist对象在画布(canvas)上绘制(Render)图形。步骤类似于: 准备一块画布或画纸准备好颜料、画笔等制图工具作画 因此,matplotlib有三个层次的API,如下表所示: API说明matplotlib.backend_bases.FigureCanvas绘图区,所有的图像都是在绘图区完成的ma

Task2 Data Whale活动:EDA

Task2 Data Whale活动:EDA 分析变量间的相互关系,变量与预测值间可能存在的关系,绘制图表。天池赛题地址 (https://tianchi.aliyun.com/competition/entrance/231784/introduction?spm=5176.12281957.1004.1.38b02448ausjSX) 赛题数据集变量描述 FieldDescription

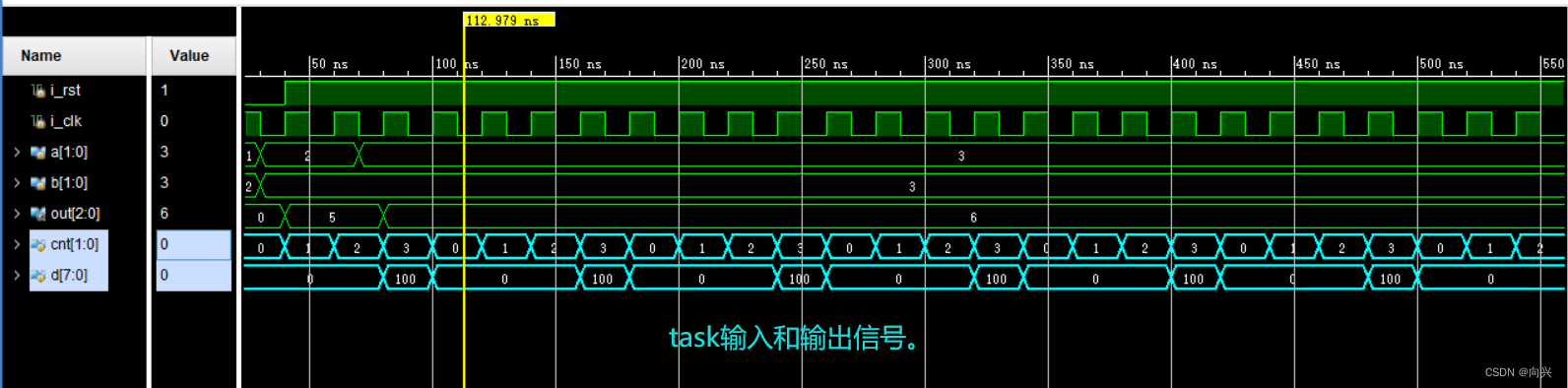

task2:Verilog编写的设计模块在模块内部直接调用task

Verilog编写的设计模块在模块内部直接调用task 1,概念2,模块设计2.1,RTL设计2.2,tb测试代码2.3,sim仿真输出 参考文献: 1,练习七-在Verilog中使用任务task 1,概念 在模块设计中,直接在内部模块使用调用task任务,然后通过task任务中的变量(包括:输入和输出)来调用task任务的工作。 2,模块设计 2.1,RTL

python基础Task2笔记(个人)

python基础Task2笔记 一,列表 1.1列表 a.由一系列按特定顺序排列的元素组成。 b.是python中使用最频繁的数据类型. c.专门用于存储一串信息。 d.索引从0开始。 1.2标志 a.列表用 [ ] 定义 b.数据之间用 , 分隔。 1.3基本操作 a.创建 b.append() 输入 motorcycles=[] motorcycles.append(‘hond

linux-0.11调试教程,task2参数所在内存页的页目录项和页表项

此文内容在do_execve()函数的change_ldt()函数之后create_table()函数运行之前的情形。change_ldt()函数会调用put_page()函数把参数内存页放置到当前任务的线性地址的末端。 第一步:在页目录表里找到任务2的参数内存页所在的页目录项,算出页表所在的地址0xffd000,因为每个进程64M对应16个字的空间任务2的在第32-47个字处。

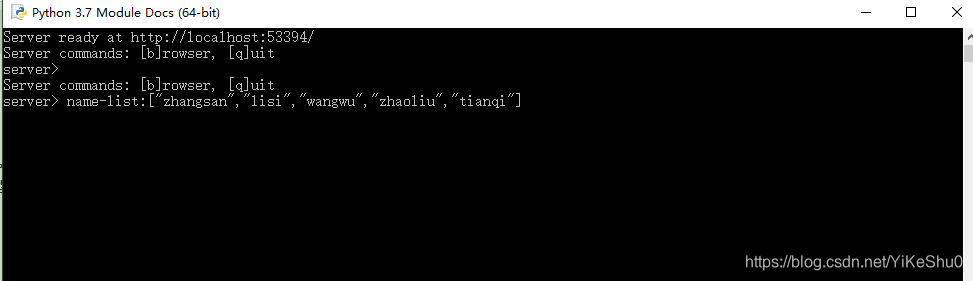

linux-0.11调试教程,task2的参数,copy_strings()函数和create_tables()函数的关系

下面是create_tables运行之前的用户栈的情况 下面是create_tables运行之后的用户栈的情况 init/main.c文件部分内容: static char * argv_rc[] = { "/bin/sh", NULL }; static char * envp_rc[] = { "HOME=/", NULL }; 0x002f3d45

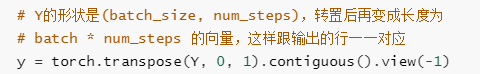

《动手学深度学习》task2_3 循环神经网络基础

目录 循环神经网络循环神经网络的构造从零开始实现循环神经网络one-hot向量初始化模型参数定义模型裁剪梯度定义预测函数困惑度定义模型训练函数训练模型并创作歌词 循环神经网络的简介实现定义模型 循环神经网络 本节介绍循环神经网络,下图展示了如何基于循环神经网络实现语言模型。我们的目的是基于当前的输入与过去的输入序列,预测序列的下一个字符。循环神经网络引入一个隐藏变量 H H

《动手学深度学习》task2_2 语言模型与数据集

目录 语言模型语言模型n元语法 语言模型数据集读取数据集建立字符索引时序数据的采样随机采样相邻采样 语言模型 一段自然语言文本可以看作是一个离散时间序列,给定一个长度为 T T T的词的序列 w 1 , w 2 , … , w T w_1, w_2, \ldots, w_T w1,w2,…,wT,语言模型的目标就是评估该序列是否合理,即计算该序列的概率: P ( w

《动手学深度学习》task2——文本预处理,语言模型,循环神经网络基础笔记

系统学习《动手学深度学习》点击这里: 《动手学深度学习》task1_1 线性回归 《动手学深度学习》task1_2 Softmax与分类模型 《动手学深度学习》task1_3 多层感知机 《动手学深度学习》task2_1 文本预处理 《动手学深度学习》task2_2 语言模型 《动手学深度学习》task2_3 循环神经网络基础 笔记目录 1 文本预处理1.1 关于建立词典1.2 关于在词

动手学深度学习PyTorch版--Task2--文本预处理;语言模型;循环神经网络基础

一.文本预处理 文本是一类序列数据,一篇文章可以看作是字符或单词的序列,本节将介绍文本数据的常见预处理步骤,预处理通常包括四个步骤: 1.读入文本 2.分词 3.建立字典,将每个词映射到一个唯一的索引(index) 4.将文本从词的序列转换为索引的序列,方便输入模型 1.读入文本 import collectionsimport redef read_time_machine():# op

Introduction to Advanced Machine Learning, 第三周,week3_task2_fine_tuning_clean(hse-aml/intro-to-dl 答案)

这是俄罗斯高等经济学院的系列课程第一门,Introduction to Advanced Machine Learning,第三周编程作业。任务是利用pre-trained InceptionV3架构,使用花朵分类训练集,经过fine tune之后,能够用于花朵的识别。 这个作业一共两个部分,难易程度:容易。 1. prepared images for the model,图片剪裁 2.

天池-新闻文本分类-task2 fasttext

FastText:快速的文本分类器 文章目录 一、word2vec1.1 word2vec为什么 不用现成的DNN模型1.2 word2vec两种模型:CBOW和Skip-gram1.2 word2vec两种优化解法:霍夫曼树和负采样1.2.2 基于Hierarchical Softmax的CBOW模型算法流程:1.2.3 负采样方法 1.3 总结: 二、fasttext2.1、简介2.2

2017 开放学术精准画像大赛 - task2 解决方案

第一次和同学组队做比赛。参加了 2017 开放学术精准画像大赛,三个人各自完成一个task。 队伍最终排名第二名,三个任务的python代码已经开源,见 https://github.com/geekinglcq/aca ps: 三个人能一起做完比赛,很开心。其次,比赛赛制虽然出现了一些小插曲,但总体来说主办方还是挺nice的。 我负责task2部分的任务,算法在初赛时表现不佳,排名17名。

第14期(六月)组队学习 Task2:LBP特征描述算子-人脸检测

LBP特征描述算子-人脸检测 Task2:LBP特征描述算子-人脸检测1 LBP特征描述算子简介2 圆形LBP算子3 LBP算子旋转不变性及等价模式4 人脸检测流程5参考代码 Task2:LBP特征描述算子-人脸检测 1 LBP特征描述算子简介 LBP(Local Binary Pattern)是一种用来描述图像局部特征的算子,具有灰度不变性和旋转不变性等优点。LBP可以用

六月组队学习 Task2:LBP特征描述算子-人脸检测

1 LBP特征描述算子简介 LBP(Local Binary Pattern)是一种用来描述图像局部特征的算子,具有灰度不变性和旋转不变性等优点。LBP可以用于人脸识别和目标检测,OpenCV中相关LBP特征进行人脸识别的接口,另外有LBP特征训练目标检测器的方法,虽然OpenCV实现了LBP特征的计算,但是没有提供一个单独的计算LBP特征的接口,即OpenCV中使用了LBP算法,却没有函数接口