sparkcontext专题

Spark Core源码精读计划3 | SparkContext辅助属性及后初始化

推荐阅读 《关于MQ面试的几件小事 | 消息队列的用途、优缺点、技术选型》 《关于MQ面试的几件小事 | 如何保证消息队列高可用和幂等》 《关于MQ面试的几件小事 | 如何保证消息不丢失》 《关于MQ面试的几件小事 | 如何保证消息按顺序执行》 《关于MQ面试的几件小事 | 消息积压在消息队列里怎么办》 《关于Redis的几件小事 | 使用目的与问题及线程模型》 《关于Red

SparkContext源码深入剖析

本节分析针对Standalone模式 版本:Spark2.11 在Spark中,SparkContext是Spark所有功能的一个入口,你无论是用java、scala,甚至是python编写都必须要有一个SparkContext,它的主要作用,包括初始化Spark应用程序所需的一些核心组件,包括 调度器(DAGSchedule、TaskScheduler),还会去到Spark M

Spark Master资源调度--SparkContext向所有master注册

Spark Master资源调度–SparkContext向所有master注册 更多资源 github: https://github.com/opensourceteams/spark-scala-mavencsdn(汇总视频在线看): https://blog.csdn.net/thinktothings/article/details/84726769 Youtube视频分享 Sp

ERROR SparkContext: Error initializing SparkContext.

在Intellij idea中测试写好的Spark程序,运行时报如下错误: Using Spark’s default log4j profile: org/apache/spark/log4j-defaults.properties 20/06/14 21:45:56 INFO SparkContext: Running Spark version 2.3.4 20/06/14 21:45:5

Spark六:Spark 底层执行原理SparkContext、DAG、TaskScheduler

Spark底层执行原理 学习Spark运行流程 学习链接:https://mp.weixin.qq.com/s/caCk3mM5iXy0FaXCLkDwYQ 一、Spark运行流程 流程: SparkContext想西苑管理器注册并向资源管理器申请运行Executor资源管理器分配Executor,然后资源管理器启动ExecutorExecutor发送心跳至资源管理器SparkConte

创建RDD的常用方式【并行化集合创建、从外部存储系统创建、RDD衍生、小文件读取】,创建SparkContext对象的方式

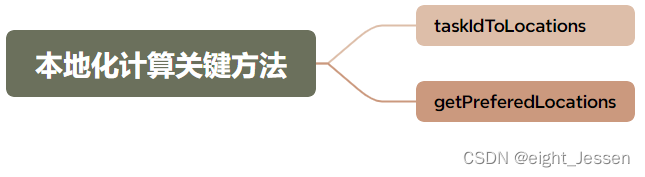

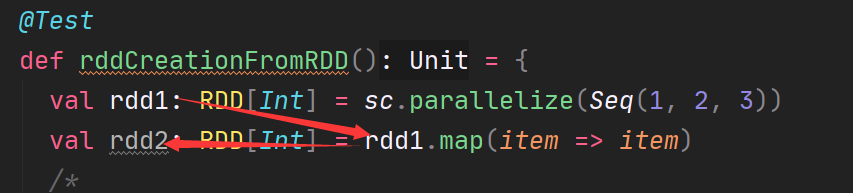

文章目录 创建 SparkContext 对象RDD 创建方式1. 创建并行化集合RDD(parallelize、makeRDD)parallelizemakeRDD 2. 从外部存储系统创建RDD(textfile)3. 从RDD衍生新的RDD(原地计算)4. 小文件读取(wholeTextFiles) RDD 分区数目(总结)获取 RDD 分区数目的俩种方式 RDD 分区的数据取决于那些

SparkContext简介

本篇文章就要根据源码分析SparkContext所做的一些事情,用过Spark的开发者都知道SparkContext是编写Spark程序用到的第一个类,足以说明SparkContext的重要性;这里先摘抄SparkContext源码注释来 简单介绍介绍SparkContext,注释的第一句话就是说SparkContext为Spark的主要入口点,简明扼要,如把Spark集群当作服务端那Spark

SparkContext 源码分析

SparkContext 源码分析 更多资源 github: https://github.com/opensourceteams/spark-scala-mavencsdn(汇总视频在线看): https://blog.csdn.net/thinktothings/article/details/84726769 Youtub 视频分享 Youtub视频(Spark原理分析图解): ht

SparkContext 与 SparkContext 之间的区别是什么

SparkContext 是 Spark 的入口点,它是所有 Spark 应用程序的主要接口,用于创建 RDD、累加器、广播变量等,并管理与 Spark 集群的连接。在一个 Spark 应用程序中只能有一个 SparkContext。 而 SparkSession 是 Spark 2.0 新增的 API,它是对 SparkContext、SQLContext 和

SparkContext 与 SparkContext 之间的区别是什么

SparkContext 是 Spark 的入口点,它是所有 Spark 应用程序的主要接口,用于创建 RDD、累加器、广播变量等,并管理与 Spark 集群的连接。在一个 Spark 应用程序中只能有一个 SparkContext。 而 SparkSession 是 Spark 2.0 新增的 API,它是对 SparkContext、SQLContext 和