smi专题

Nvidia驱动莫名其妙不好使了?nvidia-smi报错?如何解决?已解决!!

文章目录 一、报错提示二、解决方案2.1 原因1的解决办法2.2 原因2的解决方案 一、报错提示 Ubuntu20.04出现Failed to initialize NVML: Driver/library version mismatch问题NVIDIA-SMI has failed because it couldn‘t communicate with the NVI

starting container process caused exec: \nvidia-smi\: executable file not found in $PATH

1、问题描述: 我在安装好了nvidia-docker之后,按照网上的教程执行: #nvidia-docker run --rm nvidia/cuda nvidia-smi 结果报如下错误: container_linux.go:247: starting container process caused "exec: \"nvidia-smi\": executable file not

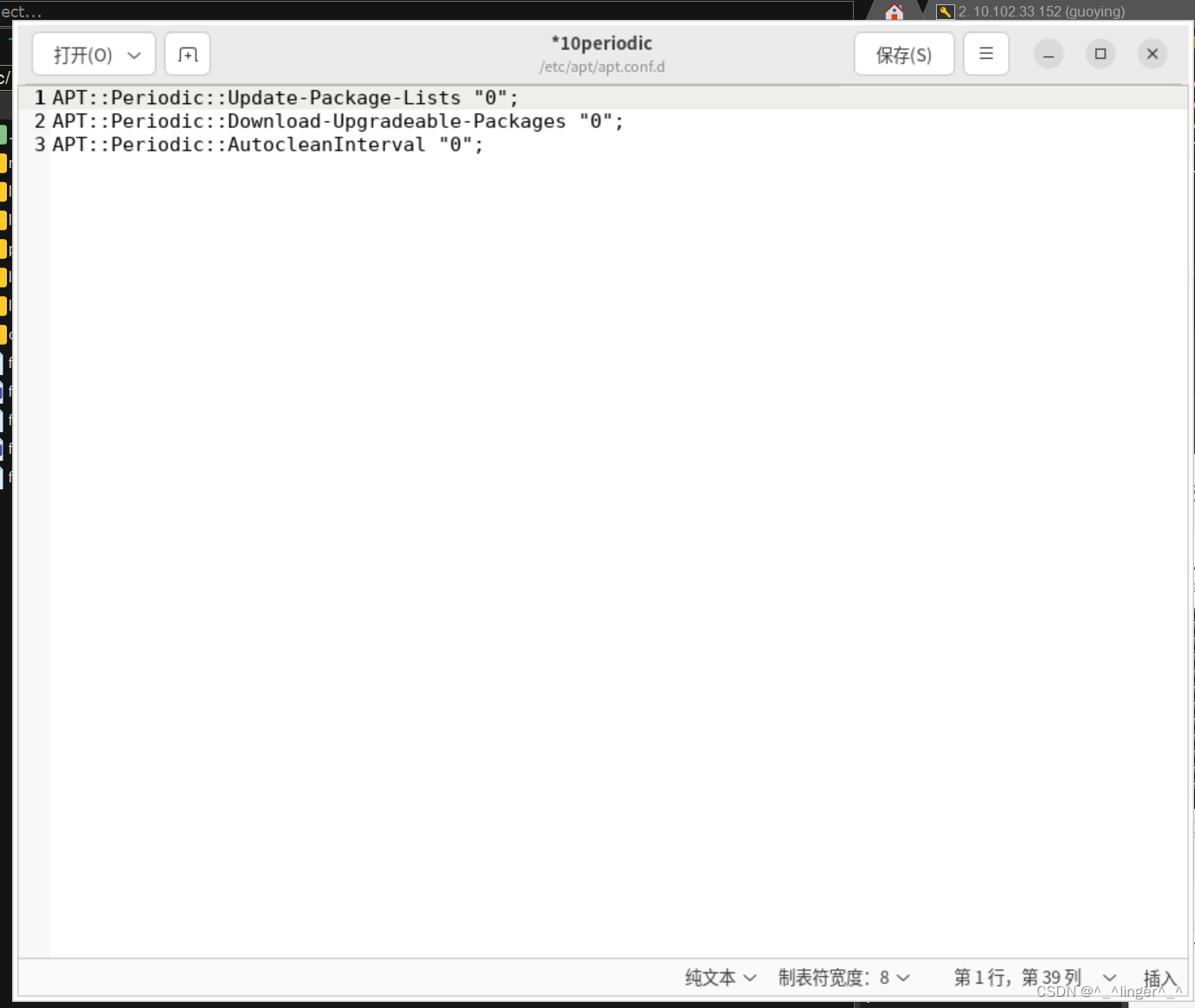

Ubuntu 22.04 某次重启后nvidia-smi 失效

Ubuntu 22.04 某次重启后nvidia-smi 失效 某次重启后失效,遂在网上寻找答案: 方案一:使用dkms进行安装相应模块 具体的可以参考链接 dkms 但是我试了一下并不好用,并且报错如下: Building module:cleaning build area...'make' -j32 NV_EXCLUDE_BUILD_MODULES='' KERNEL_UNAM

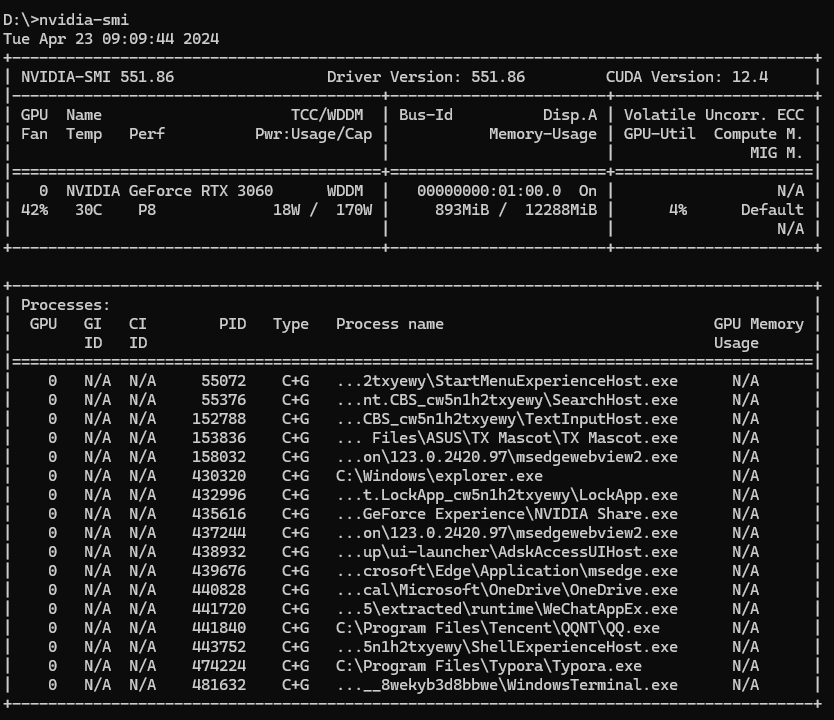

windows系统使用nvidia-smi命令办法

参考: https://blog.csdn.net/Castlehe/article/details/114978005 老版本的cuda,nvidia-sim.exe这个软件是位于:C:\Program Files\NVIDIA Corporation\NVSMI 新版本的cuda(比如cuda11.0),nvidia-sim.exe这个软件是位于:C:\Windows\System32\Dr

【已解决】ubuntu nividia-smi 出现“Make sure that the latest NVIDIA driver is installed and running.”

有个小朋友不知更新了啥导致服务器输入nvidia-smi之后显示如下信息:NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver. Make sure that the latest NVIDIA driver is installed and running. 此问题我找了半天原因,不管怎么重装

实时检测GPU使用率nvidia-smi

nvidia-smi --query-gpu=utilization.gpu --format=csv,noheader,nounits 为了判断所有 GPU 的利用率都小于阈值,可以循环检查每一个 GPU 的利用率。如果所有 GPU 的利用率都低于阈值,则增加空闲时间计数;否则,重置空闲时间计数。 下面是一个改进后的脚本,判断所有 GPU 的利用率都小于阈值: #!/bin/bash# 设

hpc中查看显存占用,等效nvidia-smi

nvidia-smi在hpc中无法使用, 但是可以通过以下方法查看应用程序占用的显存 先执行程序,之后 bjobs 输出 可以看到使用的是gpu01节点 之后 ssh gpu01

GPU系列(五)-nvidia-smi 基本使用

1 什么是 nvidia-smi? nvidia-smi 全称是 NVIDIA System Management Interface,是 NVIDIA 提供的管理和监控 GPU 的接口。 nvidia-smi 调用的是 NVML。NVML 全称是 NVIDIA Management Library,提供了一组 C API,用于 NVIDIA GPU 监控和管理的库。 1.1 可查询的状态

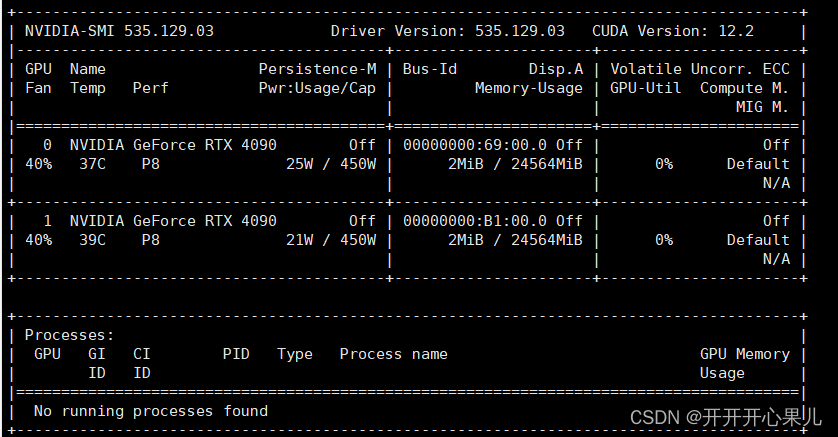

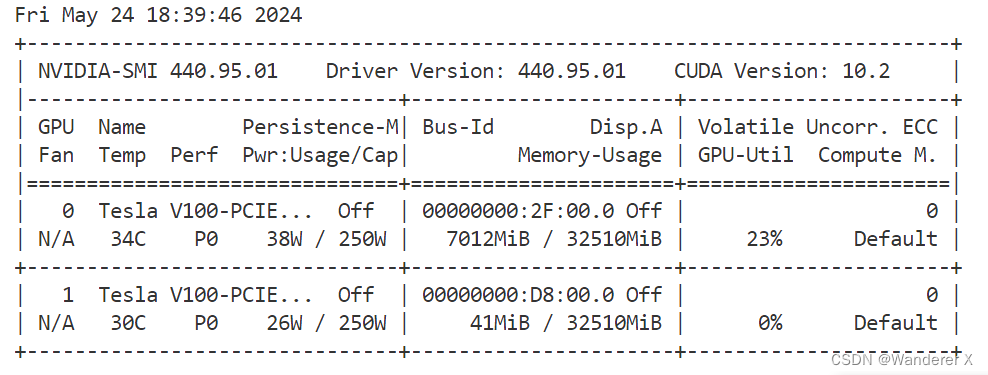

nvidia-smi 输出内容详解

一、nvidia-smi 介绍 nvidia-smi(NVIDIA System Management Interface)是一种命令行实用程序,主要用于监控和管理NVIDIA GPU(图形处理器)的状态和性能。它提供了一个简单而强大的方式来获取有关GPU的实时信息,这些信息包括GPU的使用情况、温度、内存占用等,同时也支持进行一些基本的管理操作。 在大多数情况下,nvidia-smi是与NV

[linux] top命令,nvidia-smi命令

Top命令 top命令是Linux下常用的性能分析工具,能够实时显示系统中各个进程的资源占用状况,类似于Windows的任务管理器 https://www.cnblogs.com/niuben/p/12017242.html 查看各个进程的资源占用状况 退出用 ctrl+c nvidia-smi 查看GPU使用情况的 CUDA之nvidia-smi命令详解 https://blo

nvidia-smi详解

nvidia-smi:控制你的 GPU 大多数用户都知道如何检查他们的 CPU 的状态,查看有多少系统内存可用,或者找出有多少磁盘空间可用。相比之下,从历史上看,密切关注 GPU 的运行状况和状态一直比较困难。如果您不知道去哪里寻找,甚至可能难以确定系统中 GPU 的类型和功能。值得庆幸的是,NVIDIA 最新的硬件和软件工具在这方面做出了很好的改进。 该工具是 NVIDIA 的系统管理接口

nvidia-smi查看无进程,但GPU占用率100%问题解决

问题:nvidia-smi查看无进程,但GPU占用率100%问题解决 原因:记住记住记住Ctrl+Z是把当前运行程序挂起,并不是终止运行,终止用Ctrl+C,前段时间跑代码测性能和看部分结果一直用的Ctrl+Z,导致程序都处于挂起状态,占用大量内存。 解决: pgrep -u user-name| sudo xargs kill -9 tips: 1. ps -ef | grep 'py

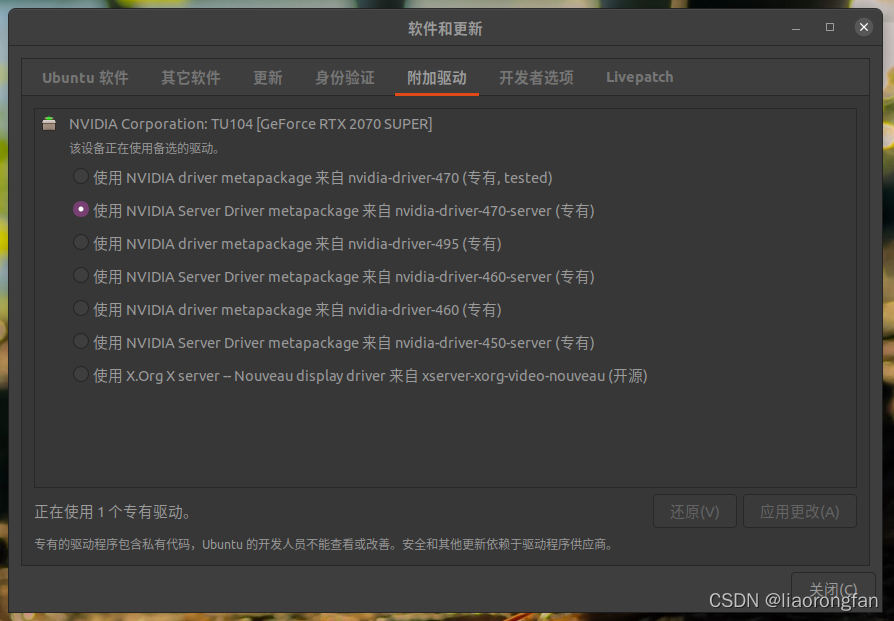

原本nvidia-smi正常,重启服务器ubuntu系统后,使用nvidia-smi报错(切换linux内核版本)

原本nvidia-smi正常,重启服务器ubuntu系统后,使用nvidia-smi报错显示: NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver. Make sure that the latest NVIDIA driver is installed and running. 造成出错原因

解决nvidia-smi无进程,但GPU显存被占用的情况

文章目录 一、问题描述二、解决方案 一、问题描述 如题,解决nvidia-smi无进程,但GPU显存被占用的情况。 二、解决方案 # 查看没有显示出来的进程fuser -v /dev/nvidia*# Kill掉sudo kill -9 pid 如果要kill的进程特别多,可以用以下的python脚本: import ospid = list(set(os.po

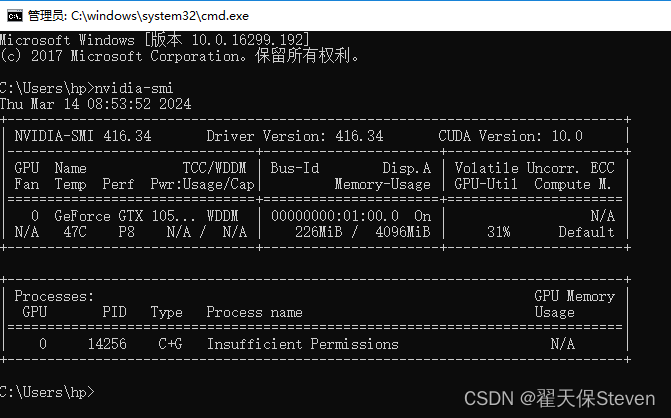

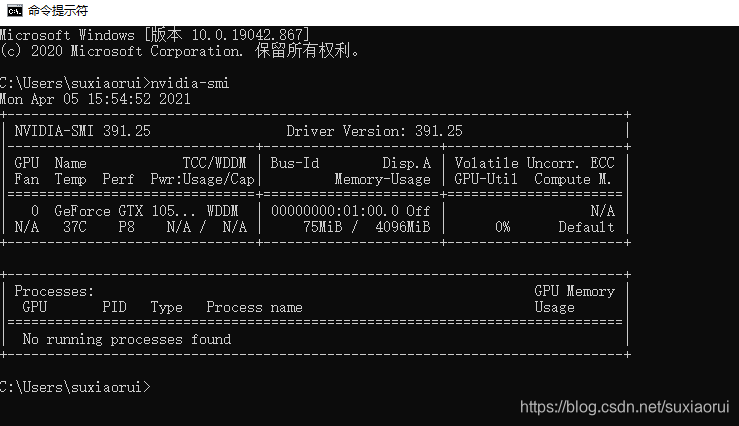

Windows10中配置并使用nvidia-smi

1. 问题 当在window10系统中使用nvidia-smi命令时: 会得到提示:nvidia-smi不是内部或外部命令,也不是可运行的程序或批处理文件。 注:其实安装NVIDIA控制面板时,软件已内置安装了nvidia-smi.exe,我们只需把相关路径添加到环境变量中即可使用相关功能。 2. 解决办法 2.1 查找路径 nvidia-smi.exe默认安装路径(也可根据自己的实际安

windos中查看gpu信息,以及NVIDIA-SMI命令详解

1 NVIDIA-SMI介绍 nvidia-smi简称NVSMI,提供监控GPU使用情况和更改GPU状态的功能,是一个跨平台工具,它支持所有标准的NVIDIA驱动程序支持的Linux发行版以及从WindowsServer 2008 R2开始的64位的系统。该工具是N卡驱动附带的,只要安装好驱动后就会有它。 Windows下程序位置:C:\Program Fi

解决方案-Windows下cmd输入nvidia-smi命令无效

作者:翟天保Steven 版权声明:著作权归作者所有,商业转载请联系作者获得授权,非商业转载请注明出处 问题描述 nvidia-smi是 NVIDIA System Management Interface 的缩写,是 NVIDIA 提供的用于管理和监控 NVIDIA GPU 设备的命令行工具。它通常用于以下几个方面: 查看 GPU 信息:nvidia-smi 可以提供关于系统中

wsl-oraclelinux -bash: nvidia-smi: command not found

-bash: nvidia-smi: command not found 1. 问题2. 解决方法 1. 问题 在 wsl Oracle Linux 中,执行 nvidia-smi 报下面错误, -bash: nvidia-smi: command not found 2. 解决方法 export PATH=/usr/lib/wsl/lib:$PATH 完结!

NVIDIA-SMI has failed because it couldn’t communicate with the NVIDIA driver

1、NVIDIA-SMI has failed because it couldn’t communicate with the NVIDIA driver 解决过程: 1.sudo apt-get install dkms 2.sudo apt-get install nvidia-driver-550 但是在进行第二步之前,不知道自己服务器nvidia-driver的版本号,可以采用命令来

‘nvidia-smi显示不是内部或外部命令也不是可运行的程序’解决办法

问题描述: ‘nvidia-smi显示不是内部或外部命令也不是可运行的程序’ 解决办法: 将C:\Program Files\NVIDIA Corporation\NVSMI 写入电脑环境变量path中即可。 然后重新输入nvidia-smi 查看

通过 NVIDIA-SMI 统计GPU使用情况

通过 NVIDIA-SMI 统计GPU使用情况 罗列本机显卡 nvidia-smi -L | --list-gpus 本示例的输出如下,也就是本机的显卡环境: [name@gpu4 code]$ nvidia-smi -LGPU 0: A40 (UUID: GPU-b0f3bdaa-e0e1-aff7-3cc7-9c067db6aea1) nvidia-smi -f | --fil

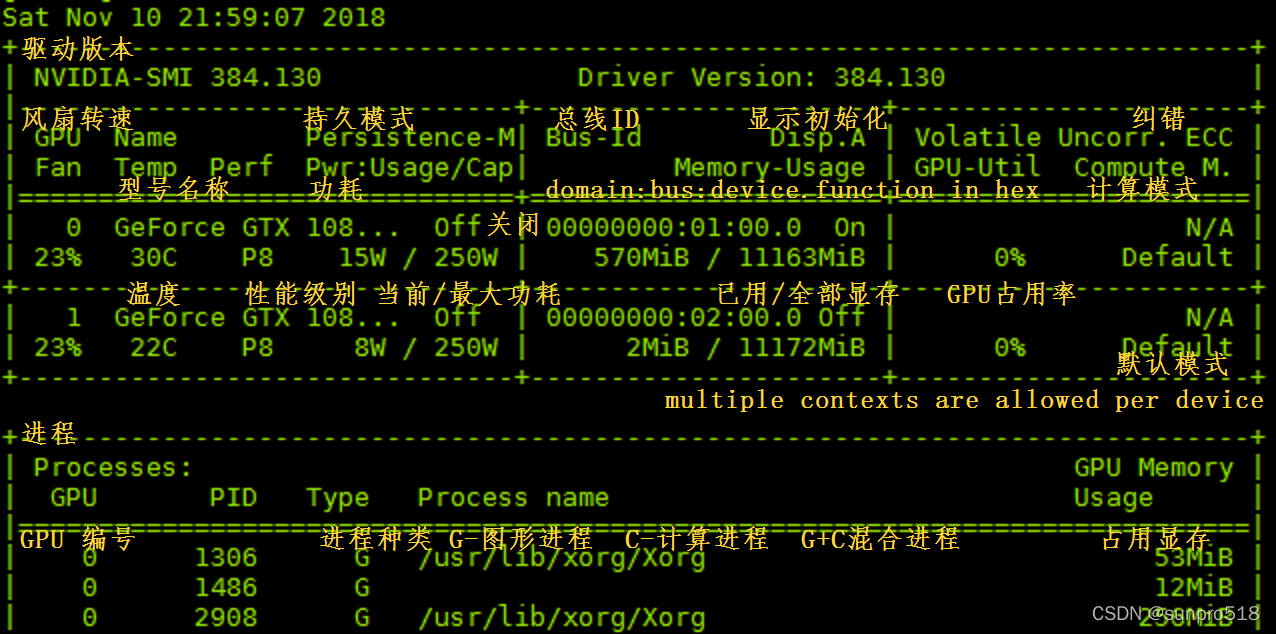

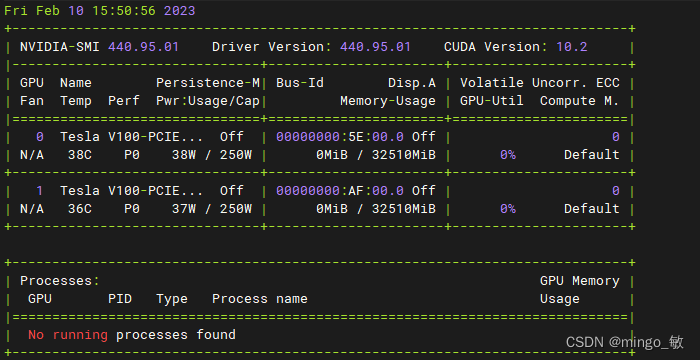

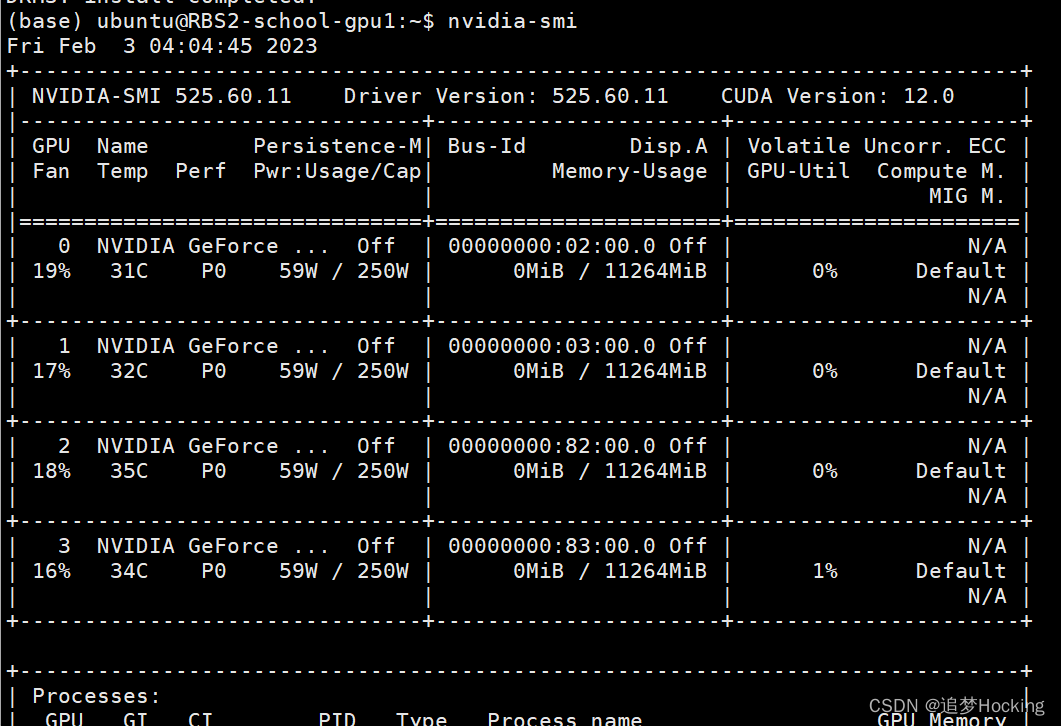

nvidia-smi输出内容释义及使用

nvidia-smi(NVIDIA System Management Interface) 是基于nvml的gpu的系统管理接口,主要用于显卡的管理和状态监控。 1.基础命令nvidia-smi 安装完成后在命令行或终端输入命令nvidia-smi,即可看到下面的信息(点击放大): 包含了显卡的信号、温度、风扇、功率、显存、使用率、计算模式等信息。 部分指标说明如下1: Fan: 风

centos: NVIDIA-SMI has failed because it couldn‘t communicate with the NVIDIA driver.

ubuntu: NVIDIA-SMI has failed because it couldn‘t communicate with the NVIDIA driver. centos: NVIDIA-SMI has failed because it couldn‘t communicate with the NVIDIA driver. 重启服务器之后就出现连接不上NVIDIA驱动的情况。

错误 NVIDIA-SMI has failed because it couldn’t communicate with the NVIDIA driver. 解决方案

服务器重启了,当我再次跑实验时,发现cuda不可用,于是输入nvidia-smi才发现了一个错误,如下: NVIDIA-SMI has failed because it couldn’t communicate with the NVIDIA driver 这是由于重启服务器,linux内核升级导致的,由于linux内核升级,之前的Nvidia驱动就不匹配连接了,但是此时Nvid

NVIDIA-SMI报错couldn‘t communicate with the NVIDIA driver

1 问题描述: 在使用GPU训练时,程序突然中断,计算机死机重启后出现GPU drvier问题 NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver. Make sure that the latest NVIDIA driver is installed and running. 2 处理

NVIDIA-SMI has failed because it couldn‘t communicate with the NVIDIA driver.Make sure that解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了NVIDIA-SMI has f

![[linux] top命令,nvidia-smi命令](/front/images/it_default.jpg)