rl专题

rl: (7) Failed to connect to get.rvm.io port 443: Operation timed out

问题:curl -L https://get.rvm.io | bash -s stable 命令失败 报错内容: rl: (7) Failed to connect to get.rvm.io port 443: Operation timed out 或 curl: (35) LibreSSL SSL_connect: SSL_ERROR_SYSCALL in connection t

LLM的范式转移:RL带来新的 Scaling Law

从几周前 Sam Altman 在 X 上发布草莓照片开始,整个行业都在期待 OpenAI 发布新模型。根据 The information 的报道,Strawberry 就是之前的 Q-star,其合成数据的方法会大幅提升 LLM 的智能推理能力,尤其体现在数学解题、解字谜、代码生成等复杂推理任务。这个方法也会用在 GPT 系列的提升上,帮助 OpenAI 新一代 Orion。 OpenA

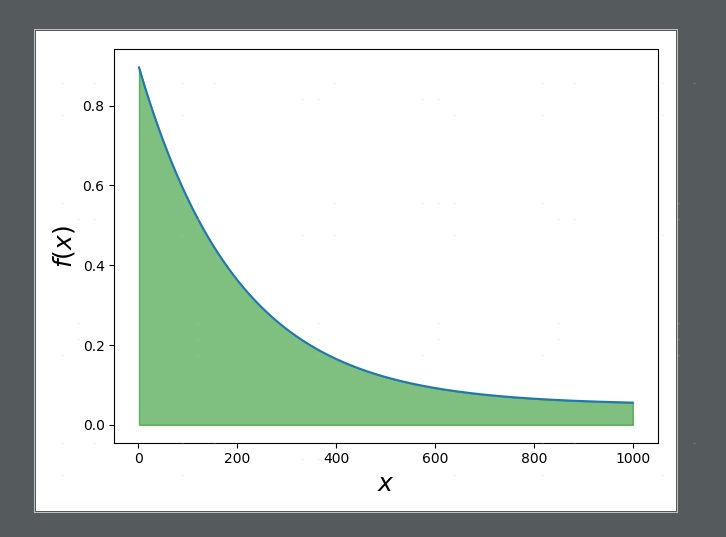

sft是mean-seeking rl是mode-seeking

原文链接 KL散度是D(P||Q),P和Q谁在前谁在后是有讲究的,P在前,就从P采样。 D K L ( P ∣ ∣ Q ) = E x − p ( x ) ( l o g ( P ( x ) / Q ( x ) ) ) D_{KL}(P||Q)=E_{x-p(x)}(log(P(x)/Q(x))) DKL(P∣∣Q)=Ex−p(x)(log(P(x)/Q(x)))想象一下,如果某个x的Q=

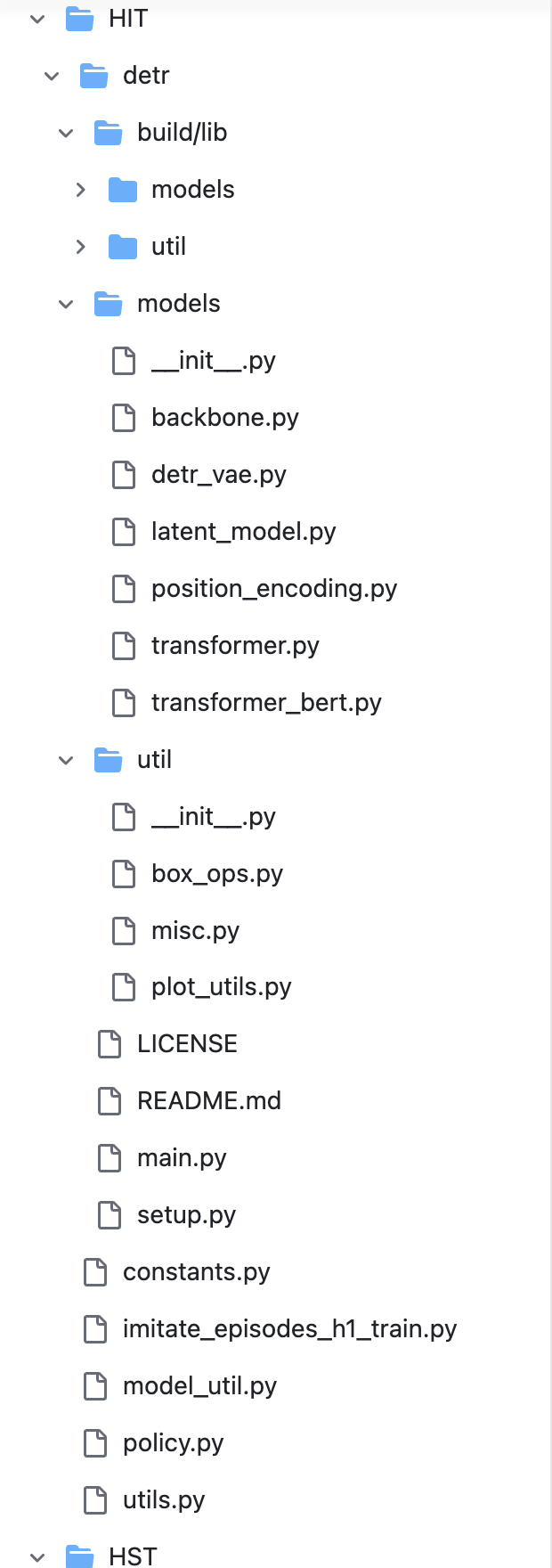

HumanPlus——斯坦福ALOHA团队开源的人形机器人:融合影子学习技术、RL、模仿学习

前言 今天只是一个平常的日子,不过看到了两篇文章 一篇是《半年冒出近百家新公司,「具身智能」也有春天》 我看完之后转发到朋友圈,并评论道:让机器人翻一万个后空翻,不如让机器人打好一个螺钉,毕竟在目前阶段 炫酷没有意义,所以我们近期全力为工厂去赋能,解决一个个工业场景 期待我司与更多工厂合作,从前期的验证、评估开始另外一篇文章便是之前斯坦福Moblie aloha团队竟然开源推出了他们的人形机器

Offline RL : Beyond Reward: Offline Preference-guided Policy Optimization

ICML 2023 paper code preference based offline RL,基于HIM,不依靠额外学习奖励函数 Intro 本研究聚焦于离线偏好引导的强化学习(Offline Preference-based Reinforcement Learning, PbRL),这是传统强化学习(RL)的一个变体,它不需要在线交互或指定奖励函数。在这个框架下,代理(agent)被提

Online RL + IL : TGRL: An Algorithm for Teacher Guided Reinforcement Learning

ICML 2023 Poster paper Intro 文章设定一个专家策略,给出两种优化目标。一个是基于专家策略正则的累计回报,一个是原始累计回报。通过比较二者动态的衡量专家策略对智能体在线学习的影响程度,进而实现在线引导过程。 Method 原始的RL目标是最大化累计奖励: π ∗ = arg max π J R ( π ) : = E [ ∑ t = 0 ∞ γ t r t

###好好好####RL-GAN For NLP: 强化学习在生成对抗网络文本生成中扮演的角色

目录 【导读】本文全面系统性梳理介绍了强化学习用于发掘GAN在NLP领域的潜力,请大家阅读。 1. 基础:文本生成模型的标准框架 2. 问题:GAN为何不能直接用于文本生成 2.1. GAN基础知识 2.2. GAN面对离散型数据时的困境(啥是离散型数据?) 3. 过渡方案:对于GAN的直接改进用于文本生成 3.1. Wasserstein-divergence,额外的礼物 3.2

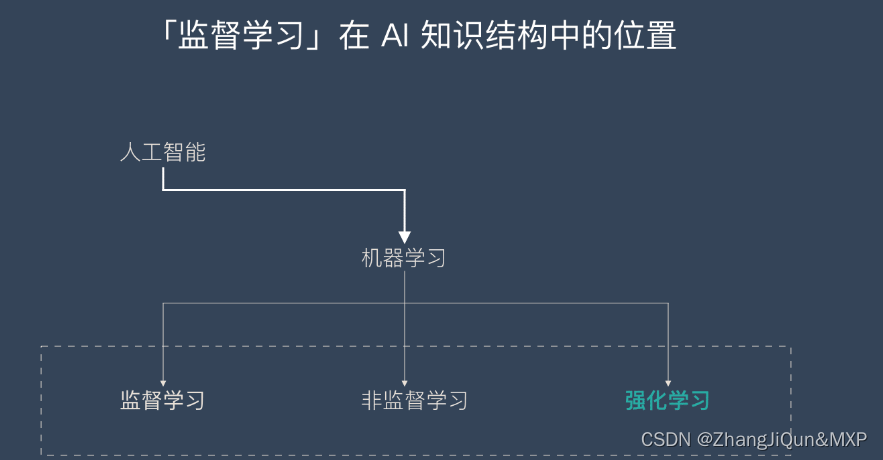

强化学习-Reinforcement learning | RL

目录 什么是强化学习? 强化学习的应用场景 强化学习的主流算法 强化学习是机器学习的一种学习方式,它跟监督学习、无监督学习是对应的。本文将详细介绍强化学习的基本概念、应用场景和主流的强化学习算法及分类。 什么是强化学习? 强化学习并不是某一种特定的算法,而是一类算法的统称。 如果用来做对比的话,他跟监督学习,无监督学习 是类似的,是一种统称的学习方式。

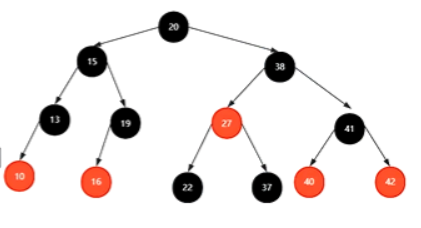

B树,红黑树,LR,RL

红黑树来源于多叉树–>234树4阶B树 红黑树:每个节点不是红色就是黑色,根节点一定是黑色,叶子节点是黑色的,一个红色节点的子节点一定是黑色的,从根节点到根节点都会经过相同数量的黑色节点,从根节点到任意节点经过的路径最长的路径不会超过最短路径的二倍 时间上O(logn),再者就是稳定 插入节点都是红色的

Stable Baselines/用户向导/RL算法

Stable Baselines官方文档中文版 Github CSDN 尝试翻译官方文档,水平有限,如有错误万望指正 下面这个表格展示了stable baselines项目中采用的所有RL算法及其重要特征:迭代策略、离散/连续行动、多线程 NameRefactored [1]RecurrentBoxDiscreteMulti ProcessingA2C✔️✔️✔️✔️✔️ACER✔️✔️

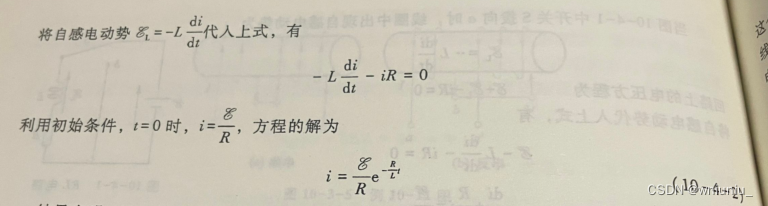

RL 暂态电路与磁能

前言 RL 电路是一个电阻 R 和 自感线圈 L 组成的 RL 电路,在连接或者接通电源U 的时候,由于自感电动势的作用,电路中的电流不会瞬间改变,而是一个连续的渐变的过程,通常这个时间很短暂,所以被称为暂态过程 正文 看看书上是怎么写的,列出式子然后微分方程,记住最后的公式 那么电流稳定后,开关转向 b 的时候,电流是怎么变化的呢

[NOTE] Advice and Perspectives on RL Research Frontiers - Rich Sutton in DLRLSS 2019

根据我的习惯,当然先放ressources:slides,video. 这是Sutton在DLRLSS 2019 summer school上的一个lecture,从他自己的角度分享了对RL领域的一些理解,他目前的研究方向及前沿等。一些思考还是很有启发的。个别要点摘录于此,细节可以自行阅读、观看。 Developing your own research thoughts There are

自定义gym环境并使用RL训练--寻找宝石

完整代码已上传到 github 最近有项目需要用到RL相关的一些东西,于是就开始尝试自己搭建一个自定义的gym环境,并使用入门的DQN网络对这个环境进行训练,这个是我入门的第一个项目,可能有一些地方理解的不够的或者有问题的,希望见谅并能指正。 其中环境的自定义部分参考了csdn extremebingo的文章,模型建立与训练过程参考了: pytorch official tutori

【RL】(task5)PPO算法和代码实现

note 文章目录 note一、RLHF对齐1. 训练奖励模型和RL2. RLHF3. 常见的公开偏好数据集 二、PPO近端策略优化1. PPO介绍2. PPO效果 二、PPO代码实践PPOmemoryPPO modelPPO update 时间安排Reference 一、RLHF对齐 1. 训练奖励模型和RL 用奖励模型训练sft模型,生成模型使用奖励或惩罚来更新策略,以便

【RL】Value Function Approximation(值函数逼近)

Lecture 8: Value Function Approximation Algorithm for state value estimation Objective function 令 v π ( s ) v_{\pi}(s) vπ(s)和 v ^ ( s , w ) \hat{v}(s, w) v^(s,w)是真实state value和近似函数。 算法的目标是找到一个最优的

【RL】Temporal-Difference Learning(时序差分方法)

Lecture 7: Temporal-Difference Learning TD learning of state values TD learning通常指的是一大类 RL 算法 TD学习也指用于估计state value的特定算法。 TD learning of state values – Algorithm description 算法中需要的data/experience

【RL】Monte Carlo Learning(蒙特卡洛学习)

Lecture 5: Monte Carlo Learning The simplest MC-based RL algorithm: MC Basic 理解MC basic算法的关键是理解如何将policy iteration算法迁移到model-free的条件下。 Policy iteration算法在每次迭代过程中有两步: { Policy evaluation: v π k =

【Desire HD】2.3.3 S-ON RL,不降级,变S-Off ,刷recovery

首先,本帖子的教程是适用于Desire HD 2.3.3 S-ON RL,即S-on的教程,如果你是S-off,那么你很容易用别的软件(一键root)来root你的手机!如果你是2.3.3的S-ON RL,又舍不得自己的存档,短信一类的东西,也不太会降级,觉得输入代码麻烦,不安全,怕刷坏机子,那么请看本教程!(2.5版本的也适用!) 1.首先下载软件:下载点我,下载会很慢,耐心等待,完全下载!

【RL】Bellman Equation (贝尔曼等式)

Lecture2: Bellman Equation State value 考虑grid-world的单步过程: S t → A t R t + 1 , S t + 1 S_t \xrightarrow[]{A_t} R_{t + 1}, S_{t + 1} StAt Rt+1,St+1 t t t, t + 1 t + 1 t+1:时间戳 S t S_t St:时间

【RL】Basic Concepts in Reinforcement Learning

Lecture1: Basic Concepts in Reinforcement Learning MDP(Markov Decision Process) Key Elements of MDP Set State: The set of states S \mathcal{S} S(状态 S \mathcal{S} S的集合) Action: the set of actions

你的linux机器上 grep xxx -rl ./ 会递归吗?

最近遇到一个奇葩的问题, 在别的linux上OK, 但是, 在我的linux上就出了问题(具体问题, 我们会在后面的文章说到), 最终定位到, 是如下linux命令再两台机器上有不同的表现: grep xxx -rl ./ 在别人的linux机器上, r没有递归, 但在我的机器上, r就递归了。 Oh, my god. 这种问题

【RL】(task4)DDPG算法、TD3算法

note 文章目录 note一、DDPG算法二、TD3算法时间安排Reference 一、DDPG算法 DDPG(Deep Deterministic Policy Gradient)算法 DDPG算法是一种结合了深度学习和确定性策略梯度的算法。它主要解决的是在连续动作空间中,智能体(agent)如何通过不断尝试来学习到一个最优策略,使得在与环境交互的过程中获得最大的回报。

NAS with RL(Using TensorFlow)

目录 代码一: train.py net_manager.py cnn.py reinforce.py 代码二: train.py controller.py model.py manager.py nascell.py 代码一: 代码地址:nascell-automl-master 修改后代码(需要新建几个python文件): train.py imp

复现NAS with RL时pytorch的相关问题

optimizer.zero_grad()是什么? optimizer.zero_grad()是PyTorch中的一个操作,它用于清零所有被优化变量(通常是模型的参数)的梯度。 在PyTorch中,当你计算某个张量的梯度时(比如通过调用.backward()函数),这个梯度会被累积到.grad属性中,而不是被替换掉。这意味着,每次计算梯度,新的梯度值会被加上旧的梯度值。 如果在反向传播前不将

【RL】(task3)A2C、A3C算法、JoyRL

note 文章目录 note一、A2C算法二、A3C算法时间安排Reference 一、A2C算法 在强化学习中,有一个智能体(agent)在某种环境中采取行动,根据其行动的效果获得奖励。目标是学习一种策略,即在给定的环境状态下选择最佳行动,以最大化长期累积的奖励。 A2C(Advantage Actor-Critic) Actor-Critic 框架:A2C 基于

Sparse Reward的思考——Hierarchical RL

背景 现在就出现了另外一个场景,就是我们的目标是多个步骤的。可能在中间的某个步骤,很难获得最好的收益。举个例子,小孩子在学习和玩耍的过程看成一个强化的过程。比如,下一步如果选择玩耍,下一步可以得到1分,但是最终是-100分。对于学习步骤,下一步可能是-1分,但是最终是100分。但是我们的机器在选择适合,可能会选择玩耍,因为最终的reward是多步的,比较难以学习。在这种情况下,就需要用到spar

![[NOTE] Advice and Perspectives on RL Research Frontiers - Rich Sutton in DLRLSS 2019](https://img-blog.csdnimg.cn/20200721134449547.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3Rhbmd3aW5n,size_16,color_FFFFFF,t_70)