rknn专题

2. 下载rknn-toolkit2项目

官网链接: https://github.com/airockchip/rknn-toolkit2 安装好git:[[1. Git的安装]] 下载项目: git clone https://github.com/airockchip/rknn-toolkit2.git 或者直接去github下载压缩文件,解压即可。

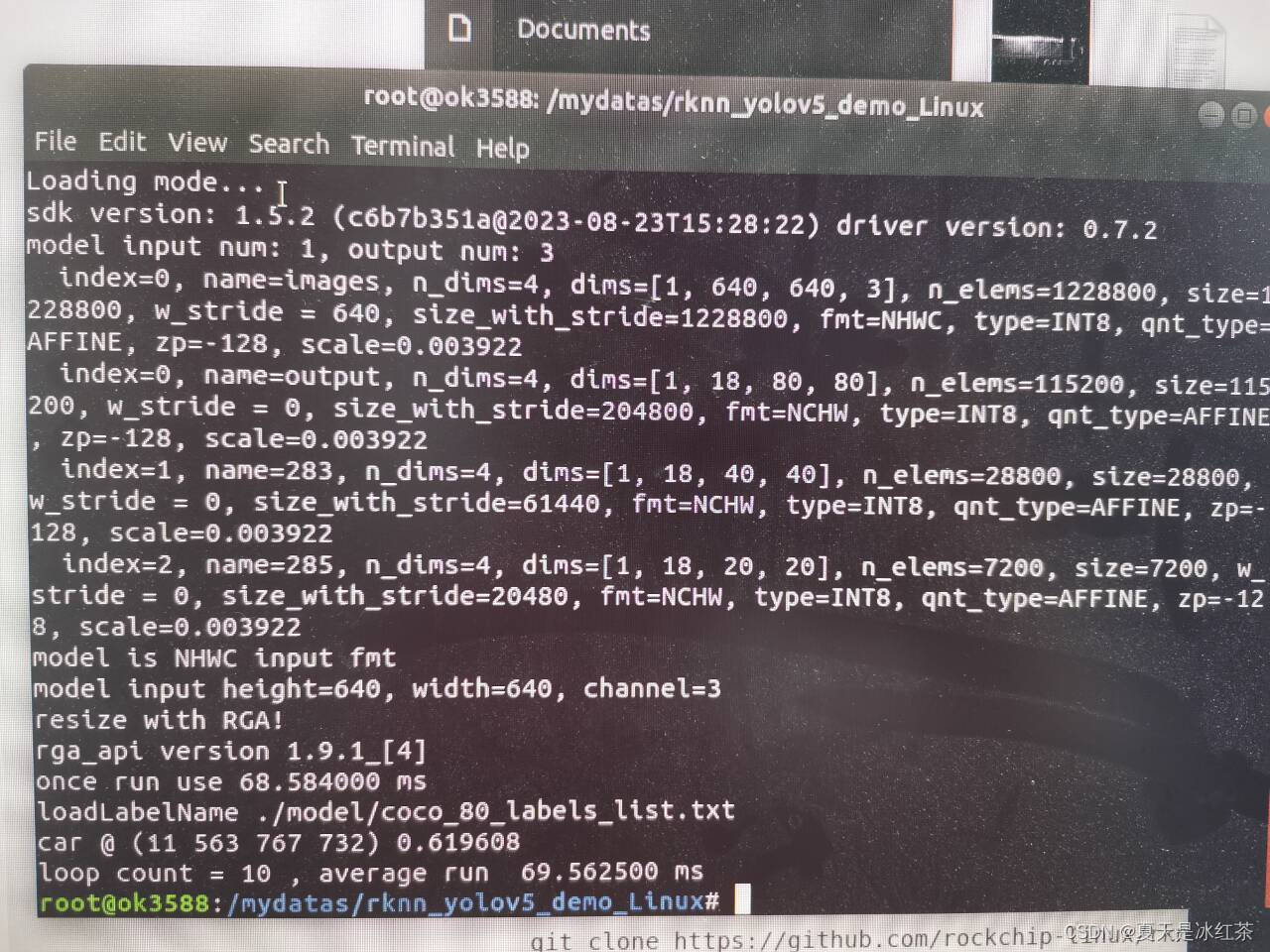

RKNPU2从入门到实践 --- 【10】RKNPU2零拷贝API实现RKNN模型在RK3588开发板上的部署

目录 一、为什么叫零拷贝API? 二、零拷贝API执行流程(代码解读) 2.1 前奏工作 2.2 main.cc文件的编写(代码的编写) 2.2.1 第一步:rknn_init接口创建rknn_context对象、加载RKNN模型 2.2.2 第二步:调用rknn query接口查询获取到模型输入输出属性、推理时间、SDK版本等信息 2.2.3 第三步:调用rknn_cre

rv1126--Create RKNN model fail, error=-13,rknn_init error ret=-13

在rv1126板子上加载rknn模型时报错, ./run_rv1109_rv1126.shpost process config: box_conf_threshold = 0.50, nms_threshold = 0.60Loading mode...Create RKNN model fail, error=-13rknn_init error ret=-13 这时候当然是去

ubuntu安装rknn-toolkit1.7.0

目录 1.下载toolkit 2.安装 3.测试 1.下载toolkit 首先下载package:Releases · rockchip-linux/rknn-toolkit · GitHub 2.安装 下载完之后解压得到 修改requirements-gpu.txt,把torchvision注释掉。 tensorflow-gpu==1.14.0torch==1.

在RV1126上实现人脸识别----facenet转成rknn模型

目录 1.模型下载 Pre-trained models 2.将facenet转成rknn模型并推理 3 查看网络模型 1.模型下载 首先需要下载facenet的模型,github下载网址为:https://github.com/davidsandberg/facenet Pre-trained models Model nameLFW accuracyTraining

yolov5转成rknn模型

目录 1 转换方法 2 yolov5版本问题 3 yolov5的输出格式问题 4 转成rknn模型时的格式问题 1 转换方法 将yolov5的pth模型转成rknn模型,具体方法分两步 利用yolov5工程中自带的export.py将pt模型转成onnx模型利用如下脚本生成rknn模型 将onnx模型转化为RV1126平台的rknn模型_cumtchw-CSDN博客 这篇笔

将onnx模型转化为RV1126平台的rknn模型

在将onnx装成rknn模型之前,首先需要准备一些校准图片,比如你的模型时用来见得行人的,那么你可以准备100张行人图片放到文件夹中,然后用下面脚本将图片的路径生成到dataset.txt文件中 import osimages = "./test"with open("dataset.txt",'w') as f:for image_name in os.listdir(images):f.w

RKNPU2从入门到实践 ---- 【8】借助 RKNN Toolkit lite2 在RK3588开发板上部署RKNN模型

前言 作者使用的平台为Ubuntu20.04虚拟系统,开发板为瑞芯微RK3588,开发板上的系统为Ubuntu22.04系统。 一、任务 完成RKNN模型的部署,RKNN模型的部署是将RKNN模型放到开发板上,应用程序可以加载RKNN模型,从而在嵌入式设备上完成推理计算的任务。 瑞芯微提供了两种嵌入式部署方式,一种是使用RKNPU2 SDK的C接口进行部

RKNPU2从入门到实践 --- 【4】RKNN 模型构建【使用pycharm一步一步搭建RKNN模型】

目录 前言 1.1 RKNN 初始化及对象释放 1.1.1 概念介绍 1.1.2 实际演示 1.2 RKNN 模型配置 1.2.1 概念介绍 1.2.2 实际演示 1.3 模型加载 1.3.1 概念介绍 1.3.1.1 Caffe模型加载接口 1.3.1.2 TensorFlow模型加载接口 1.3.1.3 TensorFlowLite 模型加载接口 1.3.1.

onnx模型转换到rknn脚本

from rknn.api import RKNN ONNX_MODEL = './onnx_models/yolov5s_rm_transpose.onnx' # platform="rk1808" platform = "rv1109" RKNN_MODEL = 'yolov5s_relu_{}_out_opt.rknn'.format(platform) if __name__ ==

在Windows环境下的rknn-toolkit环境搭建

在Windows环境下的rknn-toolkit环境搭建 最近需要使用RK3566来跑YOLOv5。想要实现目标就需要使用rknn-toolkit工具将模型转化成可以运行在rk3588的NPU上的模型。只是转换模型的话,没有必要使用GPU,所以我这里安装的是CPU版的,所需的组件按照requirements-cpu.txt中的要求安装。 一、准备工作 安装好conda,我是用的是anacon

避坑指南!RK3588香橙派yolov5生成RKNN模型!

地址1,转换模型 地址2,转换模型 地址3,解决ppa 下载k2 本文目录 一、将.pt模型转为onnx模型文件。(Windows)二、将.onnx模型转为.rknn模型文件。(Linux)三、将.rknn模型部署到开发板RK3588中。(ARM) 一、将.pt模型转为onnx模型文件。(Windows) 前提:下载源码。源码下载地址~ 将models/yol

rknn adb shell error: closed

博主的答案: 【Android测试】adb shell回车后出现 error closed的解决办法-CSDN博客 第1种:重启电脑,之后把手机查到电脑上,启动idea 第2种:手机-设置-应用程序-开发-usb调试打开再关闭一次 第3种:重启手机,usb调试打开再关闭一次。 第4种:在cmd下Try "adb kill-server" and then "adb start-s

rknn 麒麟系统调试环境搭建

目录 设置ip 设置静态ip adb usb调试驱动下载 可以用ssh进行远程链接 设置ip 一.解决方法 设置自动获取IP 第一步:编辑文件 sudo vim /etc/network/interfaces 第二步:重启network sudo /etc/init.d/networking restart 设置静态ip auto eth0 iface eth0

RK3588 - RKNN(Rockchip 神经处理单元)的逆向工程

本文翻译自https://jas-hacks.blogspot.com/2024/02/rk3588-reverse-engineering-rknn.html RK3588 NPU 的内部操作和功能主要隐藏在名为RKNPU2的闭源 SDK 中。由于对大型语言模型 (LLM) 的兴趣以及对transform模型最佳矩阵乘法的追求,想了解 RKNPU SDK 新引入的矩阵乘法 API (rknn_m

[python][whl]rknn_toolkit_lite2的whl版本下载地址汇总

rknn_toolkit_lite2-2.0.0b0-cp311-cp311-linux_aarch64.whl下载地址:https://download.csdn.net/download/FL1623863129/89061081 rknn_toolkit_lite2-2.0.0b0-cp39-cp39-linux_aarch64.whl下载地址:https://download.csdn.n

yolov5训练并生成rknn模型部署在RK3588开发板上,实现NPU加速推理

简介 RK3588是瑞芯微(Rockchip)公司推出的一款高性能、低功耗的集成电路芯片。它采用了先进的28纳米工艺技术,并配备了八核心的ARM Cortex-A76和Cortex-A55处理器,以及ARM Mali-G76 GPU。该芯片支持多种接口和功能,适用于广泛的应用领域。 本篇为yolov5部署在RK3588的教程。 一、yolov5训练数据 请选择v5.0版本:Releases

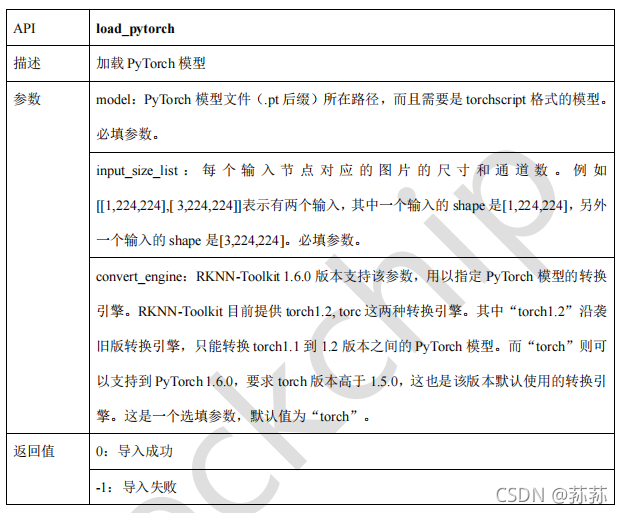

RK3399Pro RKNN-Toolkit 的使用

RKNN-Toolkit 前言模型运行在与 PC 相连的 Rockchip NPU 平台上运行非 RKNN 模型时工具的使用流程运行RKNN 模型时工具的使用流程 模型运行在 RK3399Pro Linux 开发板上PyTorch 模型加载接口 前言 目前 RKNN-Toolkit 可以运行在 PC(Linux/Windows/MacOS x64)上,也可以运行在 RK3399P

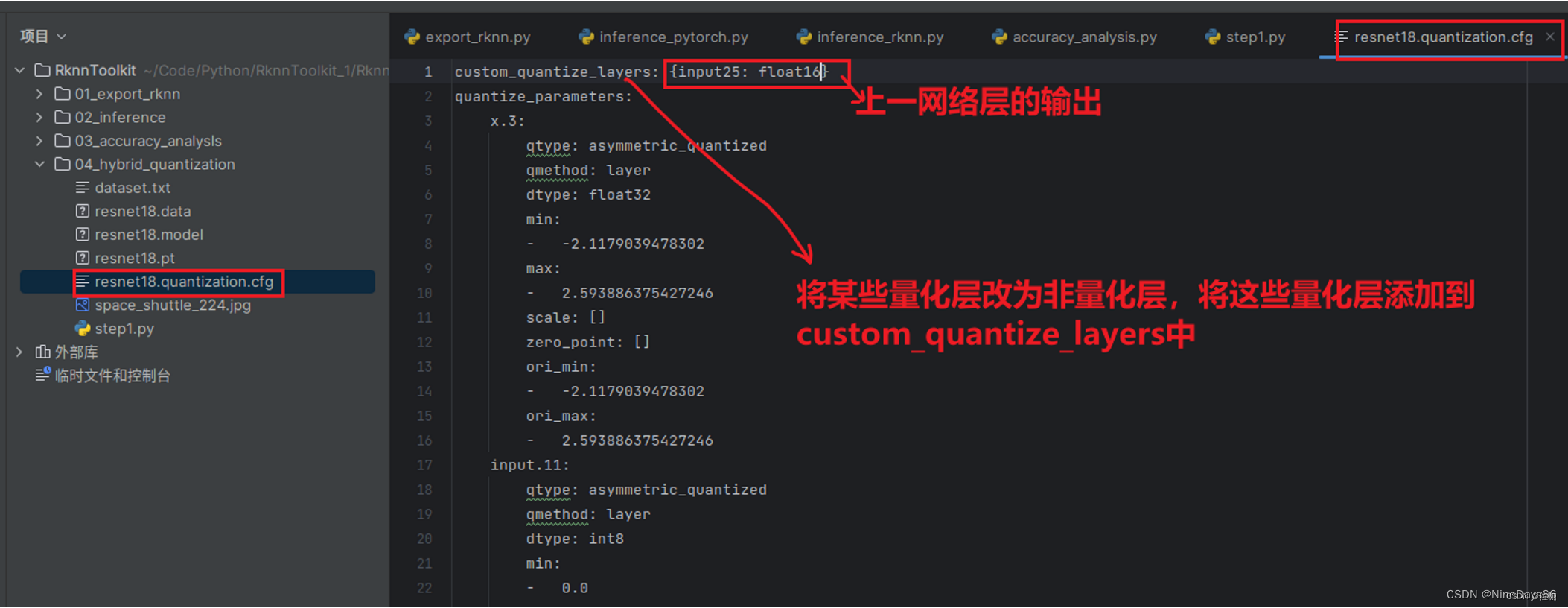

模型部署——RKNN模型量化精度分析及混合量化提高精度

模型部署——RKNN模型量化精度分析及混合量化提高精度(附代码)-CSDN博客 3.1 量化精度分析流程 计算不同情况下,同一层网络输入值的余弦距离,来近似的查看每一层精度损失的情况。具体量化精度分析的流程如下: 3.2 量化精度分析accuracy_analysis接口 量化精度分析调用accuracy_analysis接口,推理并产生快照,

模型部署——rknn-toolkit-lite2部署RKNN模型到开发板上(python版)

在RKNN模型部署前,需要注意以下几点: (1)硬件平台兼容性: 确保你的开发板与 RKNN Toolkit Lite2 兼容。目前,RKNN Toolkit Lite2 支持 Rockchip RK3566、RK3588、RK3399 等平台。 确认开发板的 NPU 型号和版本与 RKNN 模型的 NPU 算子兼容。 (2)模型转换: 使用 RKNN Toolkit 或 RKNNConver

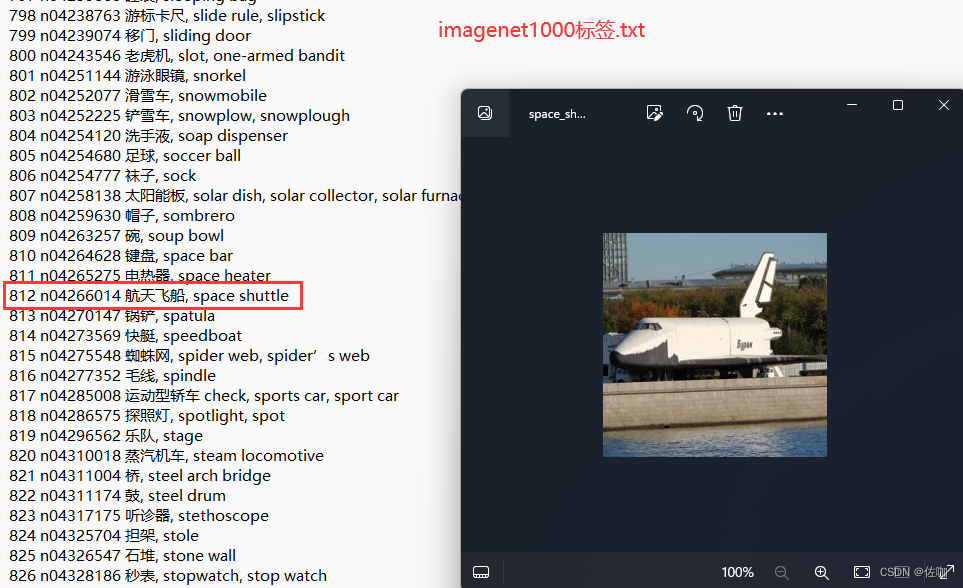

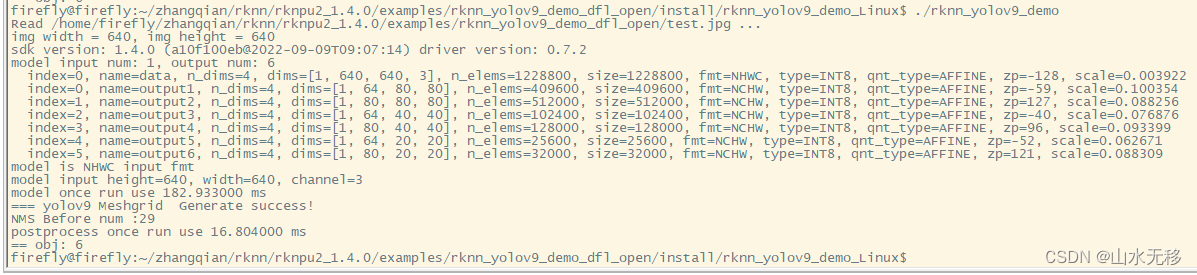

yolov9 瑞芯微芯片rknn部署、地平线芯片Horizon部署、TensorRT部署

特别说明:参考官方开源的yolov9代码、瑞芯微官方文档、地平线的官方文档,如有侵权告知删,谢谢。 模型和完整仿真测试代码,放在github上参考链接 模型和代码。 之前写过yolov8检测、分割、关键点模型的部署的多篇博文,yolov8还没玩溜,这不yolov9又来了。yolov9刚出来两三天,有朋友就问:yolov9都出来好几天了,怎么没有见到你写一篇部署博客呢。其实yolov

【已解决】pt文件转onnx后再转rknn时得到推理图片出现大量锚框变花屏

前言 环境介绍: 1.编译环境 Ubuntu 18.04.5 LTS 2.RKNN版本 py3.8-rknn2-1.4.0 3.单板 迅为itop-3568开发板 一、现象 采用yolov5训练并将pt转换为onnx,再将onnx采用py3.8-rknn2-1.4.0推理转换为rknn,rknn模型能正常转换,并且推理显示正常。但将rknn文件放到开发板,使用rknn_too

12. onnx转为rknn测试时有很多重叠框的修改(python)

我们下载rknn-toolkit2-master后并进行前面的处理后,进入到rknn-toolkit2-master\examples\onnx\yolov5文件夹,里面有个test.py文件,打开该文件,其代码如下: # -*- coding: utf-8 -*-# coding:utf-8import osimport urllibimport tracebackimport tim

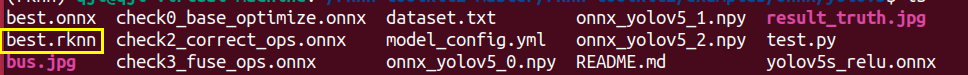

pytorch模型转换为rknn模型,使用npu推理

一、转换为onnx模型 在yolov5代码中运行export.py,转换为onnx模型,参数根据自己需要修改。 二、创建转换目录 然后在rknn文件夹下,找到onnx2rknn.py、dataset.txt和coco2017数据集,将它们复制到新的文件夹中,作为rknn模型转换目录。将需要转换的onnx模型也放在该目录中。 我的目录结构如图所示,其中第一个文件夹是已经转换成功的生成目录

模型部署之——ONNX模型转RKNN

提示:这里可以添加学习目标 提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 一、加载Docker镜像二、转换脚本 一、加载Docker镜像 加载rknn官方提供的基于x86架构下模型转换的镜像文件,生成容器,以及执行镜像。 sudo docker load -i rknn-toolkit2:1.3.0-cp36sudo docker

RK3588平台开发系列讲解(AI 篇)RKNN rknn_query函数详细说明

文章目录 一、查询 SDK 版本二、查询输入输出 tensor 个数三、查询输入 tensor 属性(用于通用 API 接口)四、查询输出 tensor 属性(用于通用 API 接口)五、查询模型推理的逐层耗时六、查询模型推理的总耗时七、查询模型的内存占用情况八、查询模型里用户自定义字符串九、查询原始输入 tensor 属性(用于零拷贝 API 接口)十、查询原始输出 tensor 属性(