rbm专题

DBN---RBM简介

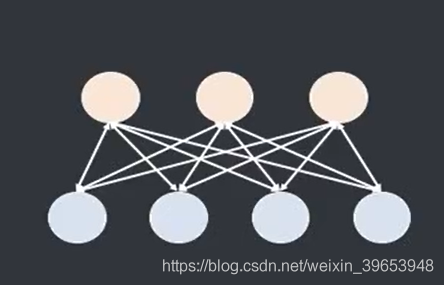

上图即是RBM(受限玻尔兹曼机)的网络结构图,与玻尔兹曼机的区别就在于没有层内连接,其中 v v为可见层,hh为隐藏层,可见层用于输入数据和获取结果,隐藏层则表示状态的变化,另外 v=(v1,v2,...,vnv) \mathbf v=(v_1,v_2,...,v_{n_{v}})表示可见层神经元的状态, h=(h1,h2,...,hnh) \mathbf h=(h_1,h_2,...

受限制玻尔兹曼机RBM原理简介

引言 受限玻尔兹曼机RBM在深度学习领域一直有重要的应用,之前一直没有接触过RBM,觉得太复杂,公式太多,这几天在Google上找到些好的turtorial,可以在这里做一个总结。 玻尔兹曼机BM BM背景 Boltzmann machines(BM)是Markov Random Fields with pairwise interaction potentials. 这里的potenti

受限玻尔兹曼机(RBM, Restricted Boltzmann machines)和深度信念网络(DBN, Deep Belief Networks)

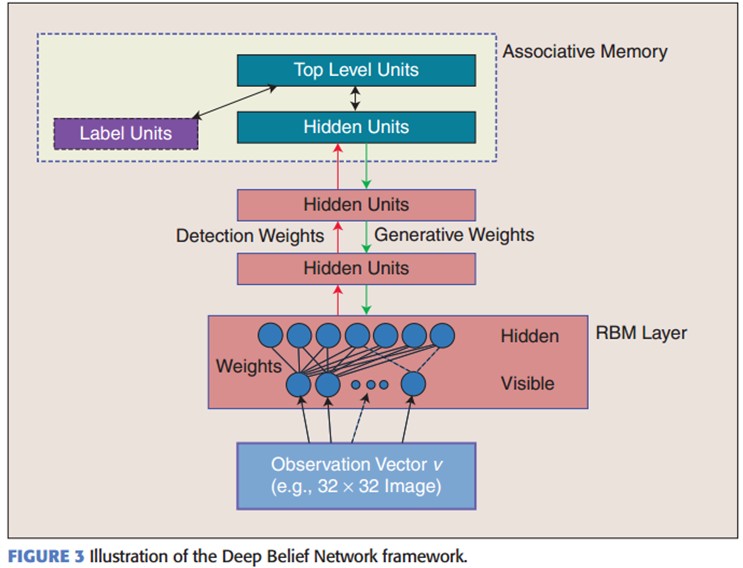

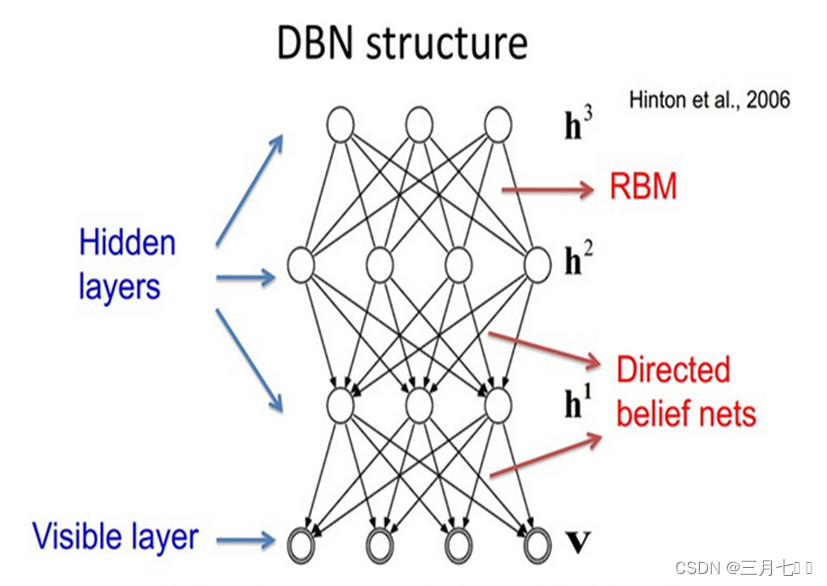

受限玻尔兹曼机对于当今的非监督学习有一定的启发意义。 深度信念网络(DBN, Deep Belief Networks)于2006年由Geoffery Hinton提出。

AutoEncoder、RBM、DBM、DBN初探

转自牛人博客:http://blog.csdn.net/zouxy09/article/details/8775524 AutoEncoder自动编码器 Deep Learning最简单的一种方法是利用人工神经网络的特点,人工神经网络(ANN)本身就是具有层次结构的系统,如果给定一个神经网络,我们假设其输出与输入是相同的,然后训练调整其参数,得到每一层中的权重。自然地,我

神经网络算法详解:反馈神经网络(Hopfield网络、双向联想记忆网络BAM、玻尔兹曼机BM、RBM)

本文介绍了反馈神经网络,包括Hopfield网络,离散Hopfield网络(DHNN),连续Hopfield网络(CHNN),双向联想记忆网络(BAM),玻尔兹曼机(BM),受限玻尔兹曼机(RBM)。其中对于BAM、BM、RBM只是对其进行了简单的介绍,并没有详细地推导算法。本文的目的旨在了解这些算法,先知道这些网络的改进和应用场景,当有业务需求的时候,再详细研究。 系列文章: 【神经网络

一文理解受限玻尔兹曼机(RBM)

一文理解受限玻尔兹曼机(RBM) 限制性玻尔兹曼机(RBM)原理RBM简单模型RBM能量函数和概率分布求极大似然 对比散度算法 RBM用途分布式RBM可能遇到的问题 限制性玻尔兹曼机(RBM)原理 限制性玻尔兹曼机在玻尔兹曼机基础上进一步加一些约束,取消了v,h变量内部的联系,即不存在可见单元与可见单元的链接,也不存在隐含单元与隐含单元的链接,如下图所示: RBM简单模型

受限波尔兹曼机(RBM)简介以及Python实现

本篇博客简单介绍了概率图模型,玻尔兹曼机(Boltzmann Machine, BM)的原理,以及受限玻尔兹曼机(Restricted Boltzmann Machine, RBM)的推断、参数学习算法,并用Python实现RBM。 预备知识 概率图模型 概率图模型(Probabilistic Graphical Model, PGM)以概率论及图论为基础,采用图论中的图结构表示概率模型。P

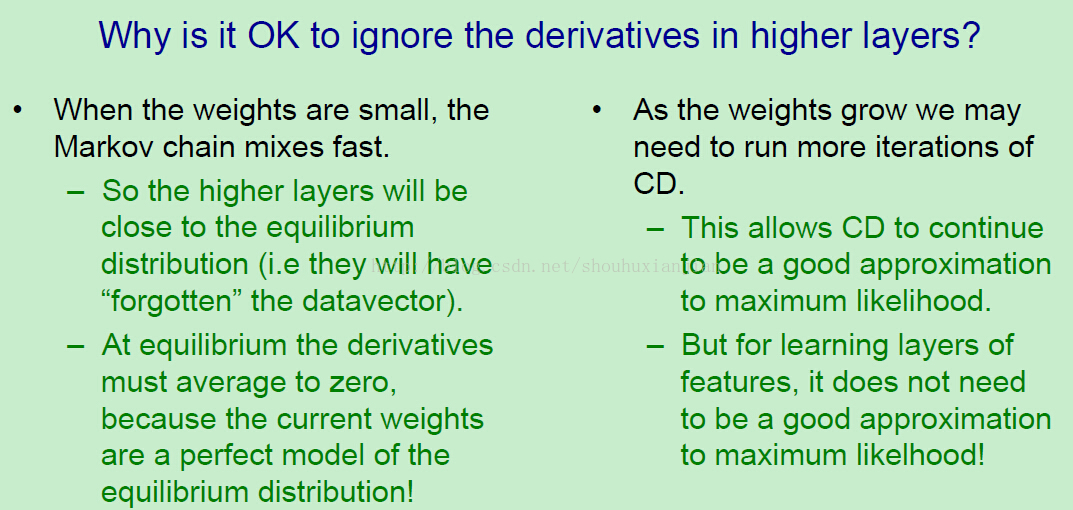

lecture14-RBM的堆叠、修改以及DBN的决策学习和微调

这是Hinton的第14课,主要介绍了RBM和DBN的东西,这一课的课外读物有三篇论文《Self-taught learning- transfer learning from unlabeled data》和《A Fast Learning Algorithm for Deep Belief Nets》以及《To recognize shapes, first learn to generate

深度学习理论知识入门【EM算法、VAE算法、GAN算法】和【RBM算法、MCMC算法、HMC算法】

目录 深度学习理论知识入门首先,让我们了解第一个流程:现在,让我们看看第二个流程: EM算法GMM(高斯混合模型) 深度学习理论知识入门 首先,让我们了解第一个流程: EM(Expectation-Maximization):EM算法是一种迭代优化算法,用于在存在潜在变量的统计模型中进行参数估计。它通过交替的E步骤(Expectation,期望)和M步骤(Maximiz

lecture14-RBM的堆叠、修改以及DBN的决策学习和微调

这是Hinton的第14课,主要介绍了RBM和DBN的东西,这一课的课外读物有三篇论文《Self-taught learning- transfer learning from unlabeled data》和《A Fast Learning Algorithm for Deep Belief Nets》以及《To recognize shapes, first learn to generate

机器学习---RBM、KL散度、DBN

1. RBM 1.1 BM BM是由Hinton和Sejnowski提出的一种随机递归神经网络,可以看做是一种随机生成的 Hopfield网络,是能够通过学习数据的固有内在表示解决困难学习问题的最早的人工神经网络之 一,因样本分布遵循玻尔兹曼分布而命名为BM。BM由二值神经元构成,每个神经元只取1或0这两 种状态,状态1代表该神经元处于接通状态,状态0代表该神经元处于断开状态