rbd专题

Ceph RBD使用

CephRBD使用 一、RBD架构说明二、RBD相关操作1、创建存储池2、创建img镜像2.1 创建镜像2.1.2 查看镜像详细信息2.1.3 镜像其他特性2.1.4 镜像特性的启用和禁用 3、配置客户端使用RBD3.1 客户端配置yum源3.2 客户端使用admin用户挂载并使用RBD3.2.1 同步admin账号认证文件3.2.2 客户端映射 3.3 客户端使用普通用户挂载并使用RBD

k8s rbd image replicapool/xxx is still being used

问题现象 启动 pod 卡在 containercreate 状态,使用kubectl describe pod [pod name]命令查看详细报错 Events:Type Reason Age From Message---- ------

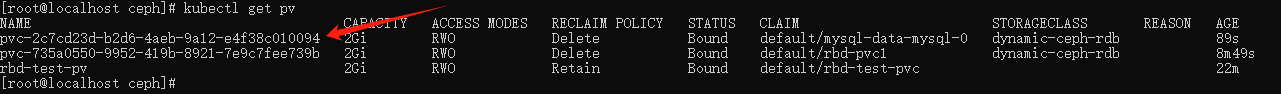

第29讲:Ceph集群使用RBD块存储设备与K8S的PV集成

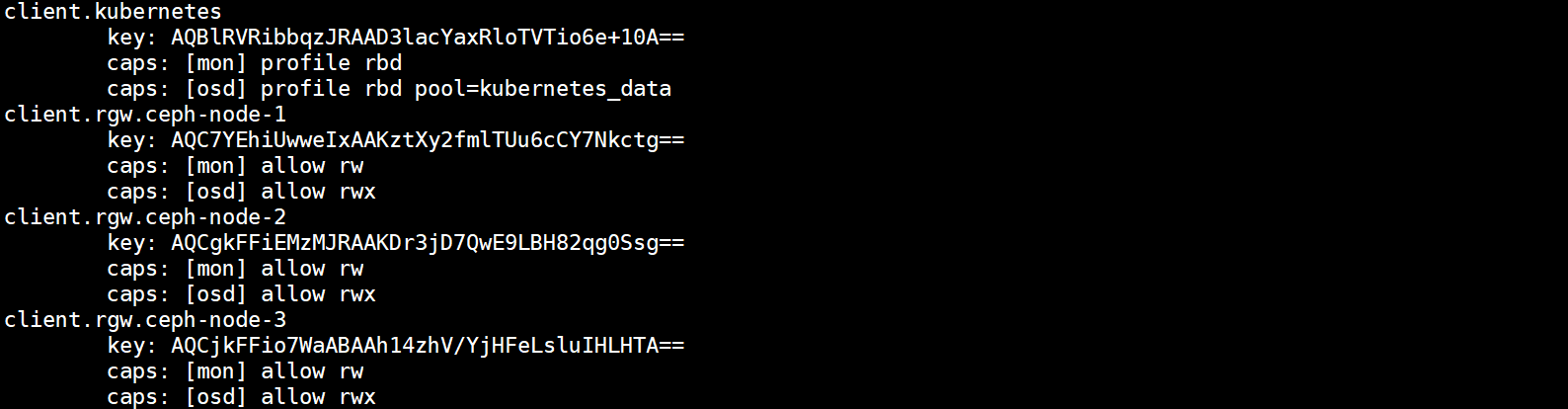

文章目录 1.Ceph集群使用RBD块存储与K8S集成简介2.Ceph集群RBD块存储与K8S PV存储卷集成2.1.创建K8S集群PV使用的块存储2.2.创建K8S集群访问RBD块存储设备的认证用户2.3.将认证用户的Key存储在K8S Secret资源中2.4.在K8S集群的所有节点中安装Ceph命令2.5.创建PV及PVC资源使用RBD作为底层存储2.6.创建Pod资源挂载PV存储卷并

proxmox 添加存储 NFS RBD

1. 添加NFS 数据中心 》 存储 》 NFS 》 ID :自定义服务器 :NFS服务器IPExport :选择共享目录内容 :自定义节点 : 自定义启用 : 勾选最大备份数 : 自定义 2. 添加RBD 数据中心 》 存储 》 rbdID : ceph 不可以自定义资源池 : rbdmonitor : 添加多个monitor 以空格隔开用户名 : 默认节点 :

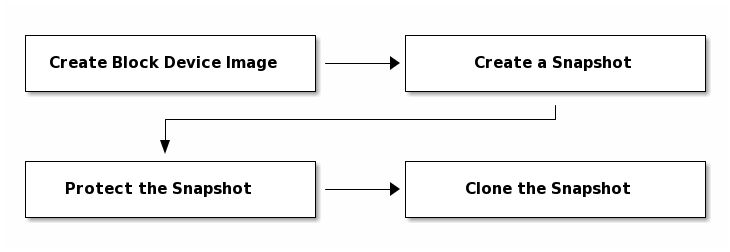

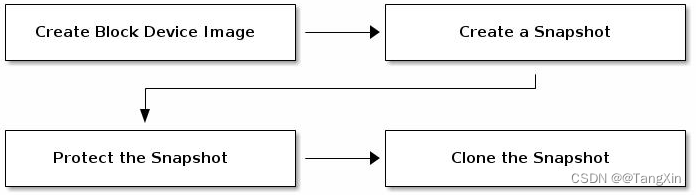

Ceph集群RBD块存储:快照与Copy-on-Write克隆的基本操作

文章目录 1.RBD块存储镜像克隆概念2.copy-on-write克隆的基本使用2.1.在块存储中创建一个快照2.2.将快照配置成保护模式2.3.基于快照克隆出镜像2.4.使用克隆的镜像2.5.查看一个快照下有哪些克隆的镜像 1.RBD块存储镜像克隆概念 镜像克隆官方文档:https://docs.ceph.com/en/pacific/rbd/rbd-snapshot/#

K8s 使用 Ceph RBD 作为后端存储(静态供给、动态供给)

一、K8s 使用 Ceph RBD Ceph RBD(Rados Block Device)是 Ceph 存储集群中的一个重要组件,它提供了块级别的存储访问。RBD 允许用户创建虚拟块设备,并将其映射到客户端系统中,就像本地磁盘一样使用。 首先所有 k8s 节点都需要安装 ceph-common 工具: yum -y install epel-release ceph-common 二、

Ceph学习 -11.块存储RBD接口

文章目录 RBD接口1.基础知识1.1 基础知识1.2 简单实践1.3 小结 2.镜像管理2.1 基础知识2.2 简单实践2.3 小结 3.镜像实践3.1 基础知识3.2 简单实践3.3 小结 4.容量管理4.1 基础知识4.2 简单实践4.3 小结 5.快照管理5.1 基础知识5.2 简单实践5.3 小结 6.快照分层6.1 基础知识6.2 简单实践6.3 小结 7.RBD实践7.1 基础

Houdini_RBD_刚体约束

仍然是看视频的笔记,摸着大佬们过河。有点杂有点乱,如有错误,多多指教。原视频链接:rbd_CONSTRAINT01_哔哩哔哩_bilibili 文章/笔记个人推荐: 1、知乎@刘鹏云_RBD 2、感谢R姐的无偿pdf笔记分享——哔哩哔哩@Rosarita_Art pdf笔记下载链接。 前面四部分主要是参数之类文字解释,可以先过一遍再回头细看,结合工程文件阅读更佳,工程文件下载链接点这,使用

Ceph实践总结之:Centos 下RBD块设备客户端的配置

在进行本章的操作之前,要先完成基本集群的搭建,请参考http://blog.csdn.net/eric_sunah/article/details/40862215 Ceph的块设备又称为 RBD 或是RADOS. 块设备 实验的过程中,可以用虚拟机来作为ceph-client的节点,但是为了保证集群的稳定,不要在集群的节点上做下面的操作 安装Ceph 通过 OS

rexray在CentOS上不能创建ceph rbd的docker volume问题定位

背景 我们通过docker的rexray插件来创建ceph rbd设备的docker volume,但总提示创建失败。 # docker volume create --driver=rexray --opt=size=5 --name=cephrbd-bookError response from daemon: create test_cephrbd_volume: VolumeD

Ceph概述、准备ceph部署环境、cephadm概述、安装Ceph集群、ceph块存储、存储池、rbd镜像管理、ceph客户端配置

ceph概述 ceph可以实现的存储方式: 块存储:提供像普通硬盘一样的存储,为使用者提供“硬盘”文件系统存储:类似于NFS的共享方式,为使用者提供共享文件夹对象存储:像百度云盘一样,需要使用单独的客户端 Ceph存储集群至少需要一个Ceph监视器、Ceph管理器和Ceph OSD(对象存储守护程序)。运行Ceph文件系统客户端时,需要Ceph元数据服务器。 监视器:Ceph Monitor(

ceph RBD的导出导入和数据恢复

背景 K8S的pod使用pvc挂载ceph RBD块(不映射到目录) ceph RBD数据恢复思路: 方法一:快照做文件备份,导入导出 1、为RBD image创建快照:rbd snap create 2、将快照导出成文件备份 (1)全量导出:rbd export (2)增量导出:rbd export-diff 3、将备份文件导入为新的RBD image (1)全量导入:rbd import

redis rbd与aof区别

Redis的持久化机制包括RBD和AOF两种,对于这两种持久化方式各有优势,本文将对此进行介绍。 https://blog.csdn.net/baidu_32872293/article/details/78174330 RDB机制的策略 RDB持久化是指在指定的时间间隔内将内存中的数据和操作通过快照的方式保存到redis bin目录下的一个默认名为 dump.rdb的文件,可

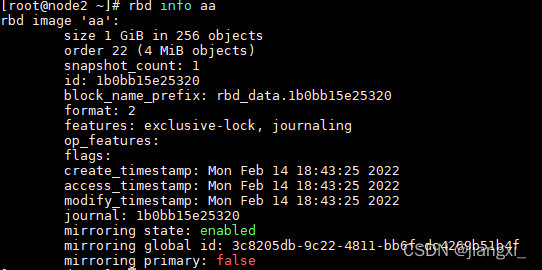

Ceph介绍之RBD实现原理

创建了一个知识星球,大家可以加入,方便学习存储相关的知识。 RBD是Ceph提供的块设备,本文将简要介绍一下其实现原理。 Ceph官方文档告诉我们Ceph本质上也是对象存储。而且了解到,Ceph的块存储其实在客户端也会被分为若干个对象进行处理。也即,对于Ceph集群,存储数据的格式就行对象。如下图所示,从镜像(块存储的呈现形式)的信息可以看出,块存储的组成及属性。 图 1 RB

qemu 使用 ceph rbd 存储块

在cinder 集群之外安装 qemu # 好像需要开启 yum install epel-release -yyum install qemu -y 在 客户 机上 放置 授权文件 qemu-img {command} [options] rbd:glance-pool/maipo:id=glance:conf=/etc/ceph/ceph.conf由于 qemu 命令 需要 /

使用tgt搭建一个基于rbd的SCSI target

Linux target framework(tgt/stgt)是为创建、维护SCSI target 驱动(包括iSCSI、FC、SRP等)提供支持。换句话说,它能将块设备、文件转换为SCSI LU并提供iSCSI、iSER等SAN中常用的传输方式来访问这些LU。它的关键目标是简洁地集成到scsi-mid层,并且大部分实现都在用户层。以 Linux 2.6.38 为分界线,此前Linux 中默认的

ceph(6)--QEMU-KVM 和 Ceph RBD 的 缓存机制总结

本系列文章会总结 QEMU/KVM 和 Ceph 之间的整合: (1)QEMU-KVM 和 Ceph RBD 的 缓存机制总结 (2)QEMU 的 RBD 块驱动(block driver) (3)存储卷挂接和设备名称 QEMU-KVM 的缓存机制的概念很多,Linux/KVM I/O 软件栈的层次也很多,网上介绍其缓存机制的文章很多。边学习边总结。本文结合 Ceph 在 QEMU/K

Docker和Kubernetes中使用Ceph RBD卷的原理分析

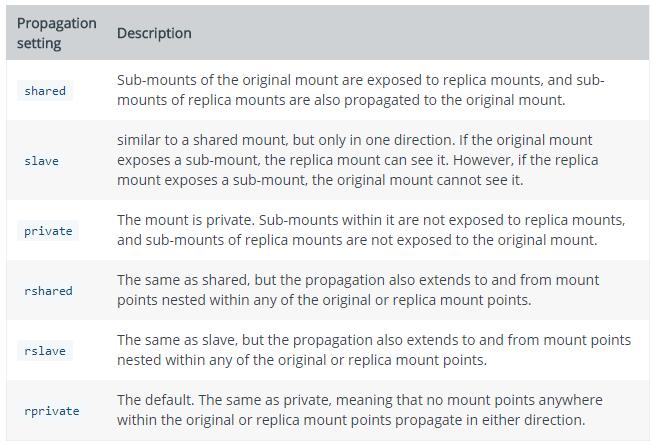

在 Docker 或者 Kubernetes 中使用 Ceph RBD 块设备,相比于在宿主机中,是否会对性能造成额外损失?带着这些疑问对相关技术进行原理分析。 Linux中的Mount绑定传播 参考文档: Shared Subtrees ; Mount namespaces and shared subtrees ; Mount namespaces,

使用luks2对ceph rbd进行加密

微信公众号:运维开发故事,作者:wanger 书接上回,上篇文章我们介绍了luks对libvirt本地磁盘的加密以及ceph rbd作为libvirt后端存储的使用,本篇介绍luks对ceph rbd的加密 背景 多个行业(例如金融行业)越来越需要在主机上使用租户/用户提供的加密密钥以卷粒度加密数据。这是由国家法规和对安全性的日益重视所推动的。迄今为止,Ceph RBD 不提供任

QCOW2和RBD快照克隆原理对比

文章目录 前言简介快照实现原理QCOW2快照原理图快照过程快照之后的写入元数据状态图还原快照QCOW2查找当前镜像的数据和快照数据有什么区别? RBD快照原理图快照过程快照之后的写入快照镜像重建还原快照克隆前为什么要做快照保护? 快照机制对比相同点不同点 克隆实现原理QCOW2RBD克隆实现对比相同点不同点 前言 RBD和QCOW2作为存储虚拟化中两个重要的磁盘格式,在概念

ceph java_java操作ceph之rbd基本操作

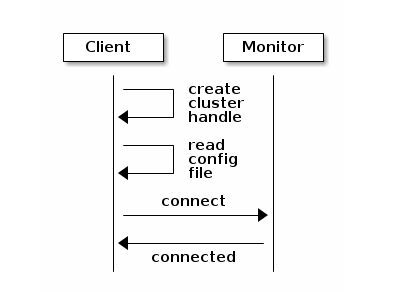

一、安装librados和librbd Ceph存储集群提供了基本的存储服务,允许Ceph在一个统一的系统中唯一地传送对象,块和文件存储。 但是,不限于使用RESTful,块或POSIX接口。 基于RADOS,Librados API使您能够创建自己的Ceph存储群集接口。Librados API使您能够与Ceph存储集群中的两种守护程序进行交互: 1)Ceph监视器,其维护集群映射的主副本。

【Ceph集群应用】Ceph块存储之RBD接口详解

Ceph块存储之RBD接口详解 1.创建Ceph块存储系统RBD接口1.1 删除镜像1.2 还原镜像1.3 在线扩容1.4 回滚镜像到指定位置1.5 删除快照1.6 快照分层1.7 快照展平1.8 镜像的导出导入 接上文基于ceph-deploy部署Ceph集群详解 1.创建Ceph块存储系统RBD接口 (1)创建一个名为rbd-demo的专门用于RBD的存储池 cep

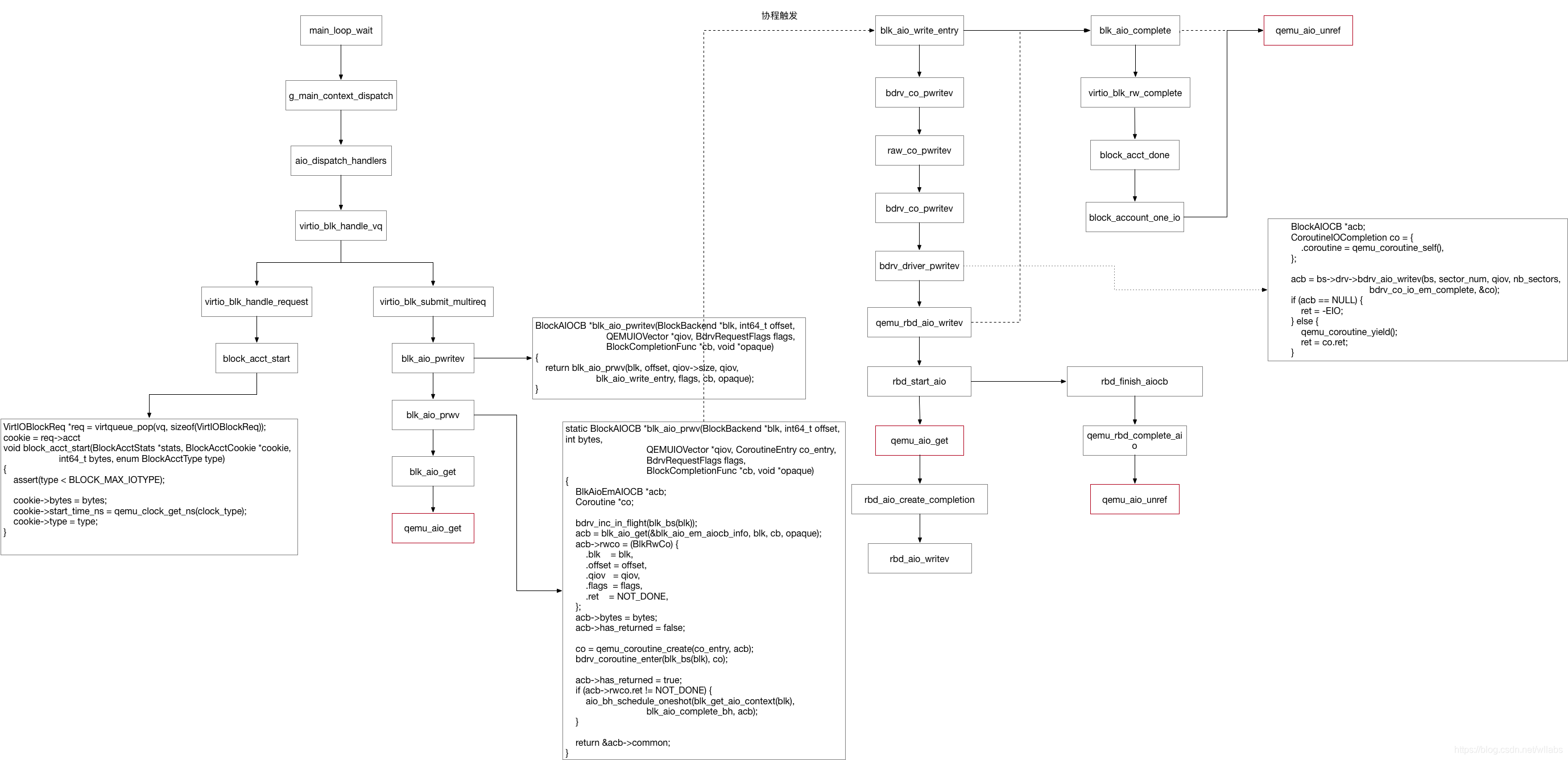

qcow2 和 rbd qemu侧流程

qcow2的读写更多的是借助qemu本身的协程机制实现并发,在读写文件的时候,会启动一个worker线程去执行读写,如果使用io thread 会在io thread里aio_poll,如果没有使用iothread,也在主线程里poll。worker进程使用的是pwrite/pread读写文件,qemu-img的同步io的worker进程使用的是pwritev/preadv,读写完成后,worke

ceph学习(3)——rbd-mirror双机热备

一.概述 本文主要关注于rbd-mirror的使用以及使用过程中的遇到的问题 二.环境准备 ceph版本:14.2.16 服务器:3台centos7服务器(ceph1,ceph2,ceph3) 硬盘:每台服务器1块10GB以上硬盘做osd,分别搭建一个单副本集群测试环境。 三.单向备份: 将集群ceph1作为主集群,ceph2,ceph3作为从集群(备份集群),将主集群rbd存储池的所有