rate专题

go rate 原生标准限速库的使用

《gorate原生标准限速库的使用》本文主要介绍了Go标准库golang.org/x/time/rate实现限流,采用令牌桶算法控制请求速率,提供Allow/Reserve/Wait方法,具有一定... 目录介绍安装API介绍rate.NewLimiter:创建限流器limiter.Allow():请求是否

解决树莓派IOError: [Errno Invalid sample rate] -9997 采样率16K错误

树莓派在基于pyaudio录音的时候会提示如上错误,这主要是使用的树莓派声卡不支持当前的采用率,没关系,其实在alsa架构下我们可以通过声卡的插件实现转换。在树莓派下家目录创建一个声卡隐藏配置文件 .asoundrc。特别说明,不要在你的pyaudio里面设置打开声卡的编号因为下面的配置已经配置了。 1.安装 sudo apt-get install pulseaudio 2.在家目录创

AntDesignVue Rate 评分 实现五星好评功能

案例:基本用法 <script setup>import {ref} from "vue";const value = ref()</script><template><div class="p-8 bg-red-300 text-center"><a-rate v-model:value="value"/><a-divider/>{{ value }}</div></template>

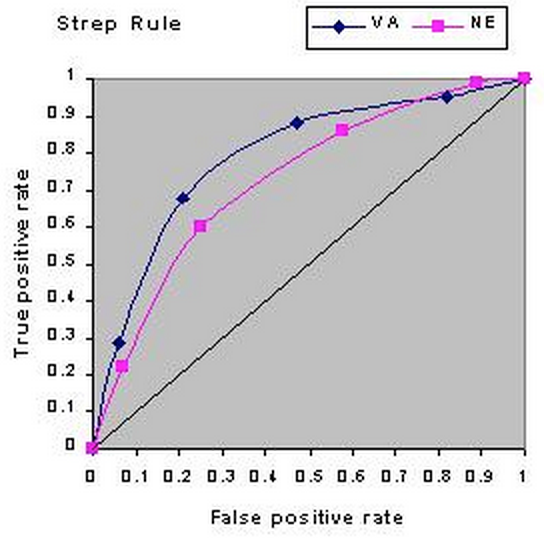

真阳率(true positive rate)、假阳率(false positive rate),AUC,ROC

很早以前就知道这些概念了,不过由于跟自己的认知习惯不一样,所以碰到了还是经常会忘。于是索性把这些概念总结一下,以后再忘了也好找(其他的文章太啰嗦了,计算方法也写的不清不楚….) 另外我也会陆续更新一些其他的机器学习相关概念和指标,即是方便自己,也方便他人吧。 注意:本文将混用正负样本和阳性(+)阴性(-)这两套说法 真阳率、假阳率 这些概念其实是从医学那边引入到机器学习里面的,所以其思维逻辑

【PyTorch 新手基础】一分钟快速部署 learning rate decay

【方法一:ReduceLROnPlateau】当设定指标在最近几个epoch中都没有变化时,调整学习率。 optimizer = torch.optim.SGD(net.parameters(), lr=learning_rate, weight_decay=0.01)scheduler = torch.optim.lr_sheduler.ReduceLROnPlateau(optimizer

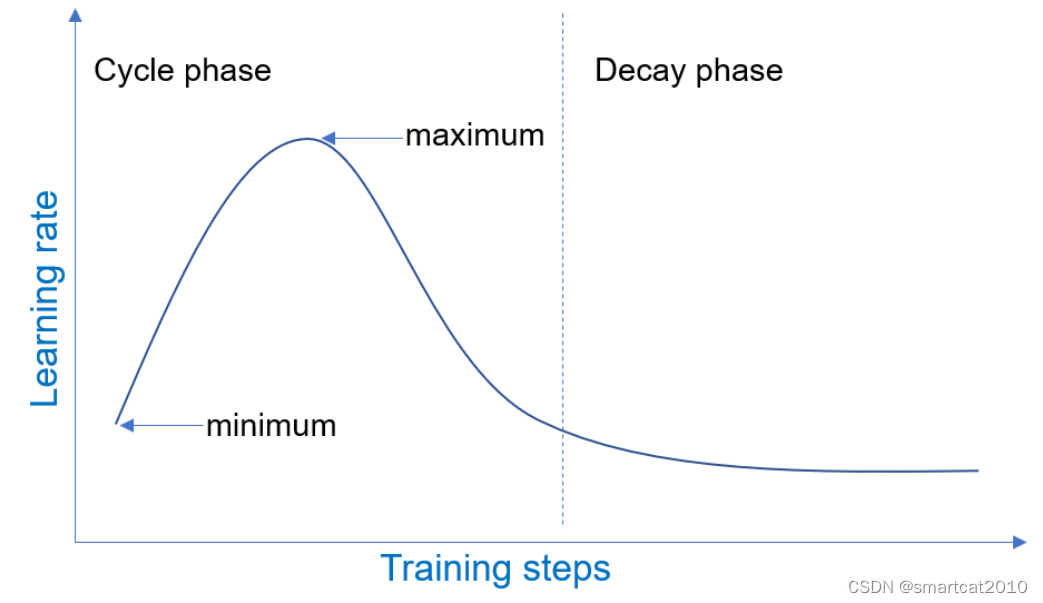

DeepSpeed Learning Rate Scheduler

Learning Rate Range Test (LRRT) 训练试跑,该lr scheduler从小到大增长lr,同时记录下validatin loss;人来观察在训练多少step之后,loss崩掉(diverge)了,进而为真正跑训练,挑选合适的lr区间; "scheduler": {"type": "LRRangeTest","params": {"lr_range_test_min_l

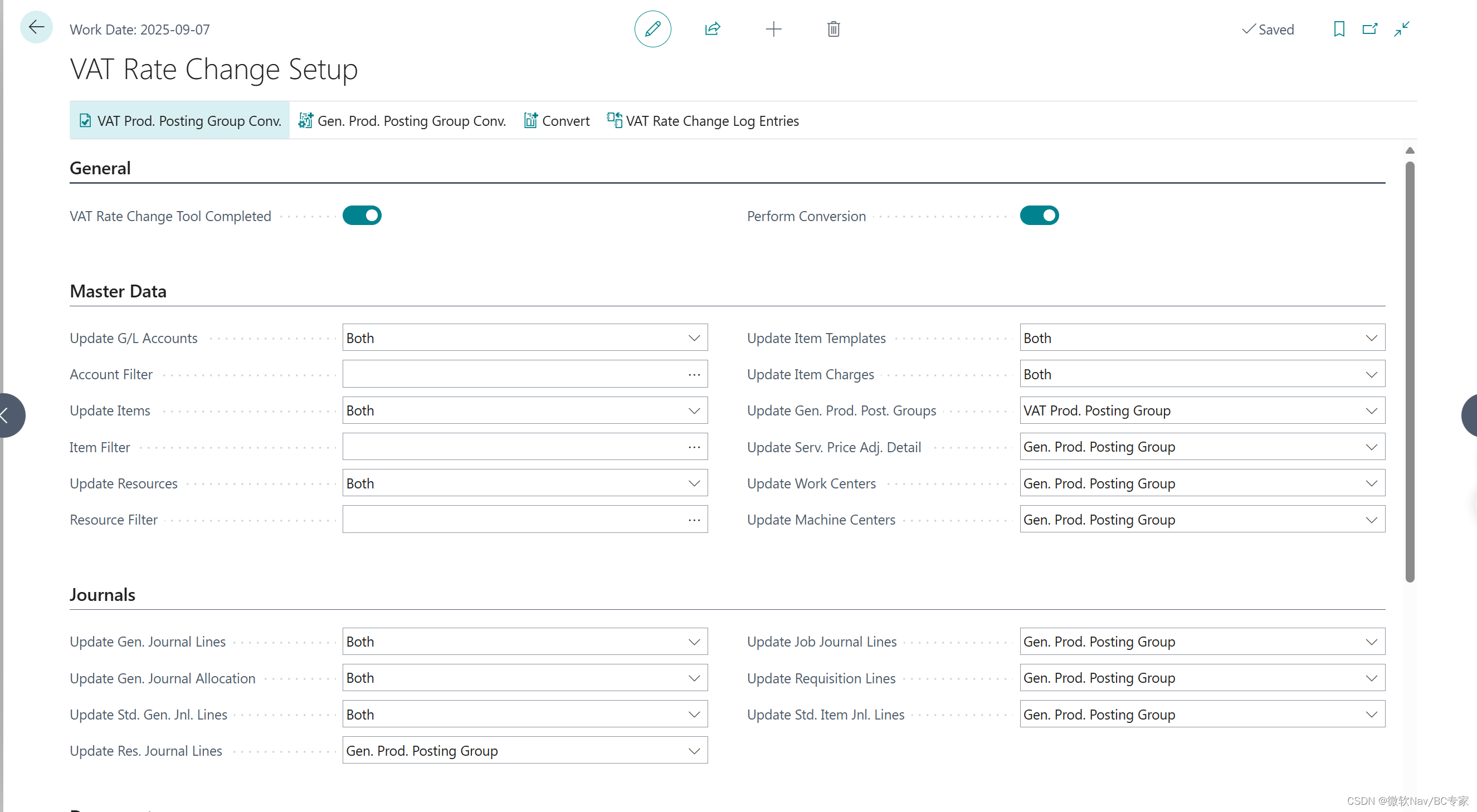

Microsoft Dynamics 365 Business Central 讲解VAT RATE CHANGE TOOL(增值税税率更改工具)

学习目标: 如果使用VAT RATE CHANGE TOOL(增值税税率更改工具) 过程演示: 1.创建新的VAT产品过账组 2.创建新的总账科目以过账采购、销售和逆向征收增值税。 3.给新的VAT产品过账设置过账设置 4.创建一个新的一般产品过账组 5.给新的产品过账组 创建过账设置 6.设置VAT Rate Change Tool

Caffe中learning rate 和 weight decay 的理解

Caffe中learning rate 和 weight decay 的理解 在caffe.proto中 对caffe网络中出现的各项参数做了详细的解释。 1.关于learning rate optional float base_lr = 5; // The base learning rate // The learning rate decay policy. The curr

How to fix the problem that the Download rate is too Slow when doing apt-get install

sudo nano /etc/apt/sources.list don’t use the address of the official one : deb http://mirrordirector.raspbian.org/raspbian/ jessie main contrib non-free rpi and change it to ALi’s: deb http://mir

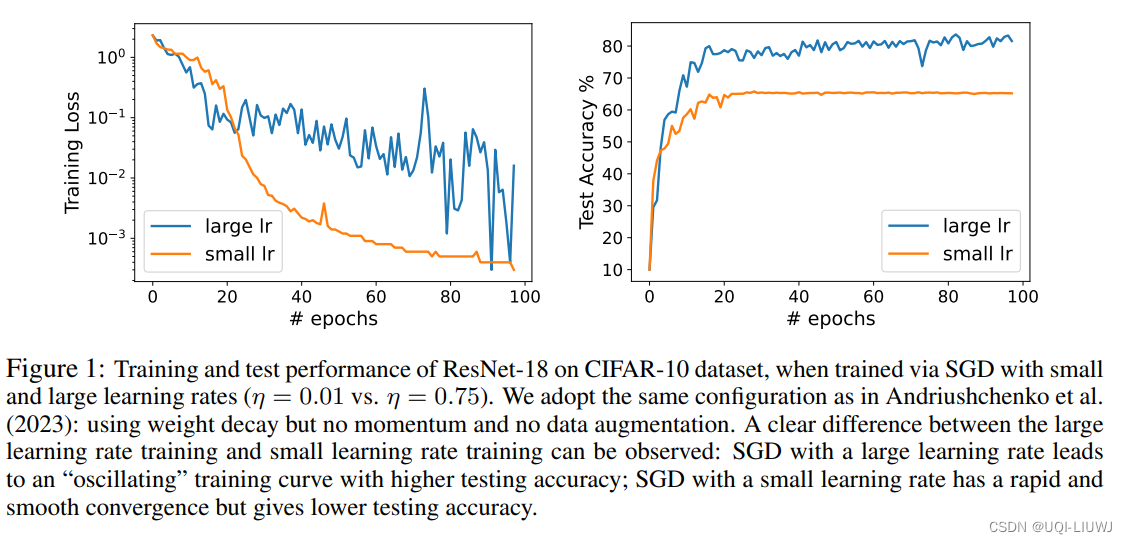

论文略读:Benign Oscillation of Stochastic Gradient Descent with Large Learning Rate

iclr 2024 reviewer评分 368 论文从理论上研究了通过随机梯度下降(SGD)且采用大学习率训练的神经网络(NN)的泛化特性论文的发现是,由于SGD的大学习率引起的NN权重的振荡,实际上有利于NN的泛化,潜在地优于通过SGD以小学习率训练的、更平滑收敛的相同NN ——>将这种现象称为“良性振荡”论文证明,通过振荡SGD且学习率较大训练的NN可以有效地学习在那些强特征存在的情况下的

hitfilm 导出视频 the sample Rate (XXX Hz) is not supported by encoder

解决办法:File->projectSettings中,修改sample rate 为 48000 Hz。

cf 807C Success Rate

You are an experienced Codeforces user. Today you found out that during your activity on Codeforces you have made y submissions, out of which x have been successful. Thus, your current success rate

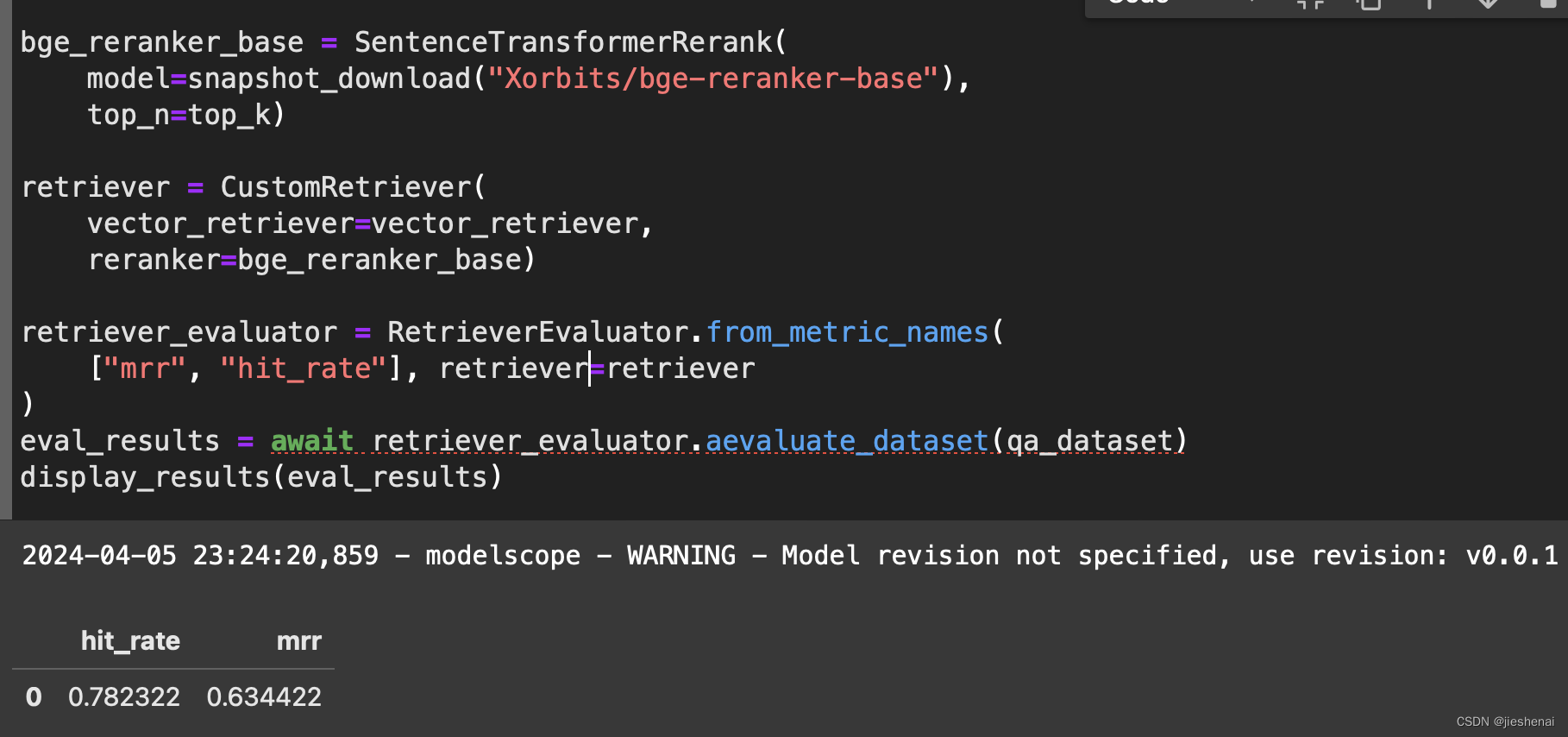

使用向量检索和rerank 在RAG数据集上实验评估hit_rate和mrr

文章目录 背景简介代码实现自定义检索器向量检索实验向量检索和rerank 实验 代码开源 背景 在前面部分 大模型生成RAG评估数据集并计算hit_rate 和 mrr 介绍了使用大模型生成RAG评估数据集与评估; 在 上文 使用到了BM25 关键词检索器。接下来,想利用向量检索器测试一下在RAG评估数据集上的 hit_rate 和 mrr; 简介 使用 向量检索 和 r

Tensorflow学习率的learning rate decay

x = tf.Variable(1.0)y = x.assign_add(1)with tf.Session() as sess:sess.run(tf.global_variables_initializer())print sess.run(x)print sess.run(y)print sess.run(x) 输出 1,2,2注意其x会变的 import tensorflow as

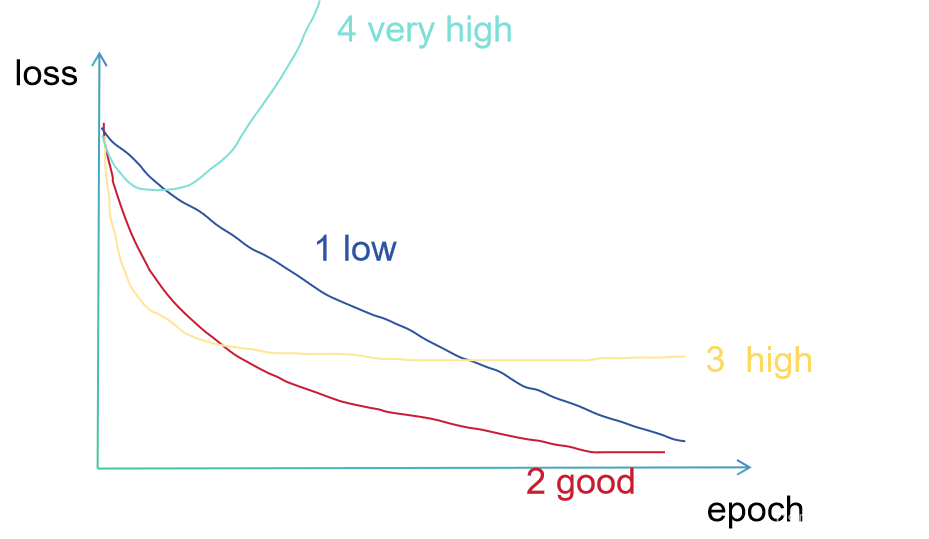

【Machine Learning】Suitable Learning Rate in Machine Learning

一、The cases of different learning rates: In the gradient descent algorithm model: is the learning rate of the demand, how to determine the learning rate, and what impact does it h

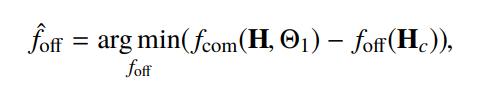

Convolutional Neural Network based Multiple-Rate Compressive Sensing for Massive MIMO CSI Feedback:

Convolutional Neural Network based Multiple-Rate Compressive Sensing for Massive MIMO CSI Feedback: Design, Simulation, and Analysis简记 文章目录 Convolutional Neural Network based Multiple-Rate Compres

推荐系统 | KDD2019 阿里 Res-embedding for Deep Learning Based Click-Through Rate Prediction Modeling

这篇文章是阿里巴巴2019年KDD上的文章,区别以往在MLP层的改进,本篇文章更多关注embedding层的优化。可以带着以下几个问题进行论文阅读,1.为何需要改进Embedding层,2.数学推导证明改进Embedding对提升模型泛化性能的作用3. 如何改进embedding 及 res-embedding的设计4. 相关参数控制和实验结果论证 目录 1. 背景 2. 理论分析

Golang 限流器 time/rate 使用介绍

本主题为系列文章,分上下两篇。本文主要介绍 time/rate 的具体使用方法,另外一篇文章 《Golang 限流器 time/rate 实现剖析》 则着重介绍其内部实现原理。 限流器是后台服务中的非常重要的组件,可以用来限制请求速率,保护服务,以免服务过载。 限流器的实现方法有很多种,例如滑动窗口法、Token Bucket、Leaky Bucket 等。 其实 golang 标

猫头虎分享已解决Bug || API限制超额(API Rate Limiting):RateLimitExceeded, APILimitReached

博主猫头虎的技术世界 🌟 欢迎来到猫头虎的博客 — 探索技术的无限可能! 专栏链接: 🔗 精选专栏: 《面试题大全》 — 面试准备的宝典!《IDEA开发秘籍》 — 提升你的IDEA技能!《100天精通鸿蒙》 — 从Web/安卓到鸿蒙大师!《100天精通Golang(基础入门篇)》 — 踏入Go语言世界的第一步!《100天精通Go语言(精品VIP版)》 — 踏入Go语言世界的第二步!

ionic rate 评价的小星星 不可点击

< ion-row justify-content-center> < rating readOnly= "true" text-center></ rating> </ ion-row>

TypeError: Unexpected keyword argument passed to optimizer: learning_rate

在载入hdf5模型时遇到这个问题,我特么太难了,人家说是版本问题,emmm,keras就是垃圾,能不能保持一致?瞎更新个啥? 版本keras=2.2.5是另一个项目要求的,可能我到时候还得重新安装。哎。 无奈,先升级吧,keras=2.3.1解决问题了 keras这玩意也不统一下。 少些偏见,多谢包容与认可。 另外有相关问题可以加入QQ群讨论,不设微信群 QQ群:86

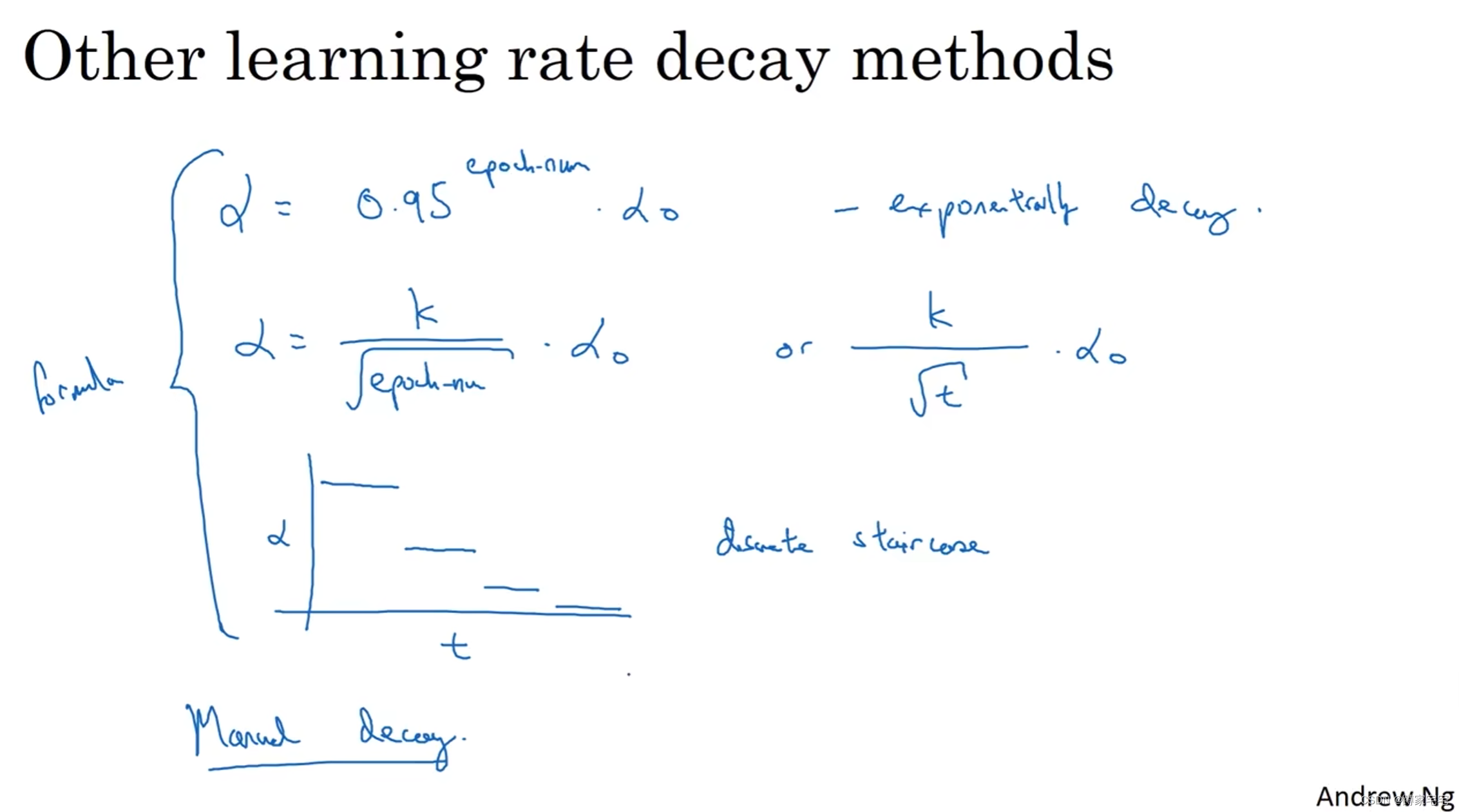

深度学习记录--学习率衰减(learning rate decay)

学习率衰减 mini-batch梯度下降最终会在最小值附近的区间摆动(噪声很大),不会精确收敛 为了更加近似最小值,采用学习率衰减的方法 随着学习率的衰减,步长会逐渐变小,因此最终摆动的区间会很小,更加近似最小值 如下图,蓝色曲线表示mini-batch梯度下降,绿色曲线表示采用学习率衰减的梯度下降 学习率衰减的实现 1 epoch = 遍历数据1次 是学习率衰减的超

Codeforces Round#412 C Success Rate

题意: 给你x,y,p,q; 其中 x,y,p,q 代表的含义为 x/y, p/q,让你求一个b,使得(x+a)/(y+b)=p/q;并且求得的b还是最小。 思路:其实这就相当于一个数学问题中求定义域的问题,因为x,y,p,q,a,b都是整数,我们可以这样转化 x+a=k*p,y+b=k*q;这样的解有很多个,为了求最小的b,那么当k最小的时候b最小,这时我们先把p,q化为互质

uView Rate 评分

该组件一般用于满意度调查,星型评分的场景。 #平台差异说明 App(vue)App(nvue)H5小程序√√√√ #基本使用 通过count参数设置总共有多少颗星星可选择通过v-model双向绑定初始化时默认选中的星星数量 <template><u-rate :count="count" v-model="value"></u-rate></template><script>expor

![解决树莓派IOError: [Errno Invalid sample rate] -9997 采样率16K错误](/front/images/it_default2.jpg)