本文主要是介绍深度学习记录--学习率衰减(learning rate decay),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

学习率衰减

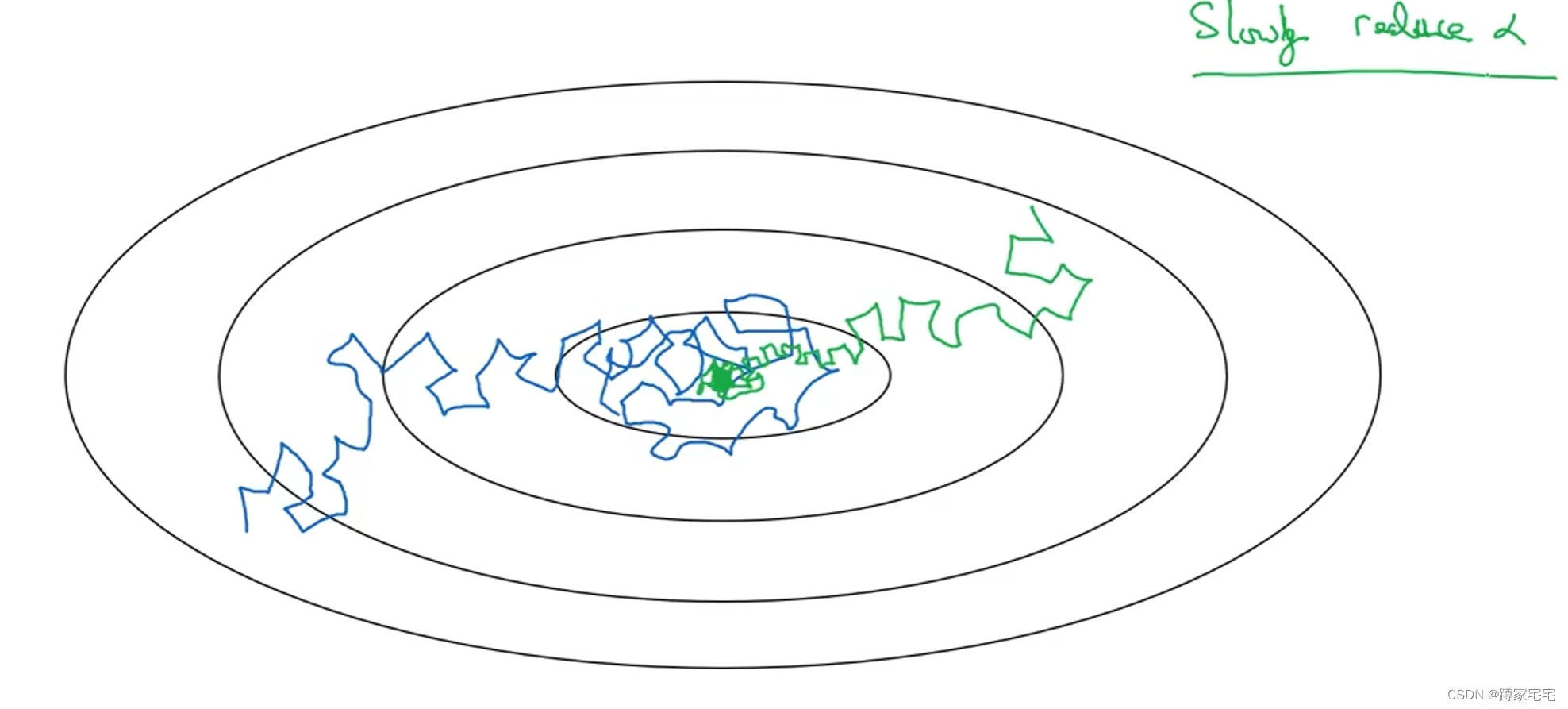

mini-batch梯度下降最终会在最小值附近的区间摆动(噪声很大),不会精确收敛

为了更加近似最小值,采用学习率衰减的方法

随着学习率的衰减,步长会逐渐变小,因此最终摆动的区间会很小,更加近似最小值

如下图,蓝色曲线表示mini-batch梯度下降,绿色曲线表示采用学习率衰减的梯度下降

学习率衰减的实现

1 epoch = 遍历数据1次

是学习率衰减的超参数,

是初始学习率,

是遍历次数

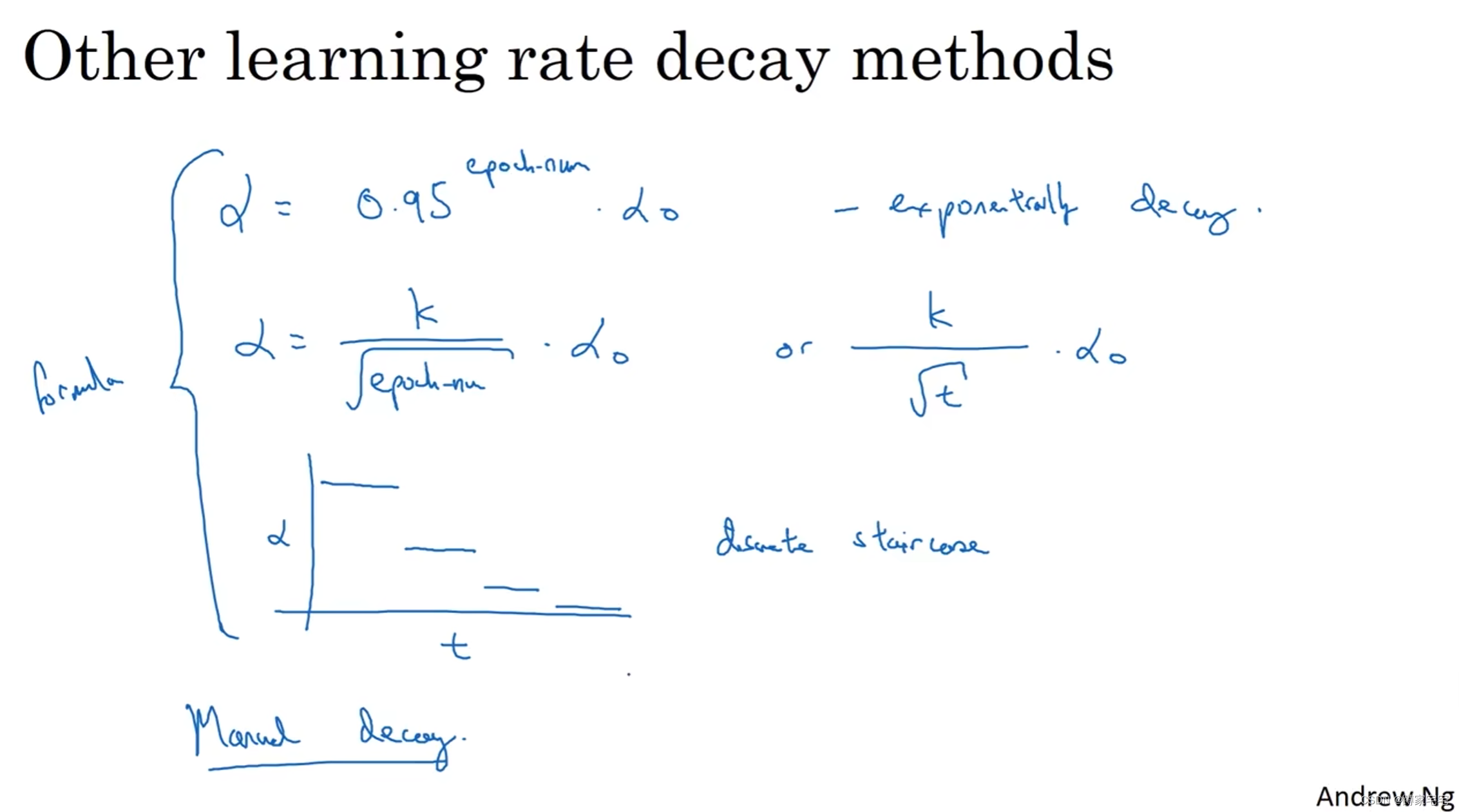

其他衰减方案

是初始学习率,

是衰减常量,一般设置

,

是遍历次数

是初始学习率,

是衰减常量,

是遍历次数

分段衰减函数

这篇关于深度学习记录--学习率衰减(learning rate decay)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!