pruning专题

MIT 6.5940 EfficientML.ai Fall 2023: Lab 1 Pruning

EfficientML.ai Lec 3 - Pruning and Sparsity (Part I) MIT 6.5940, Fall 2023, Zoom 本文是EfficientML.ai Fall 2023课程作业1练习答案,在本次练习里将会对经典的分类神经网络进行剪枝处理,减少模型大小和延迟。The goals of this assignment are as fo

关于PostgreSQL的分区表的历史及分区裁剪参数enable_partition_pruning与constraint_exclusion的区别

1. 疑惑 我们知道控制分区裁剪的参数有两个: enable_partition_pruningconstraint_exclusion 这两个参数有什么区别呢? 2. 解答 要说明这两个参数的区别需要先讲一讲PostgreSQL数据库中分区的历史,在PostgreSQL 10版本之前,PostgreSQL数据库实际上是没有单独的创建分区表的DDL语句,都是通过表继承的原理来创建分区表,

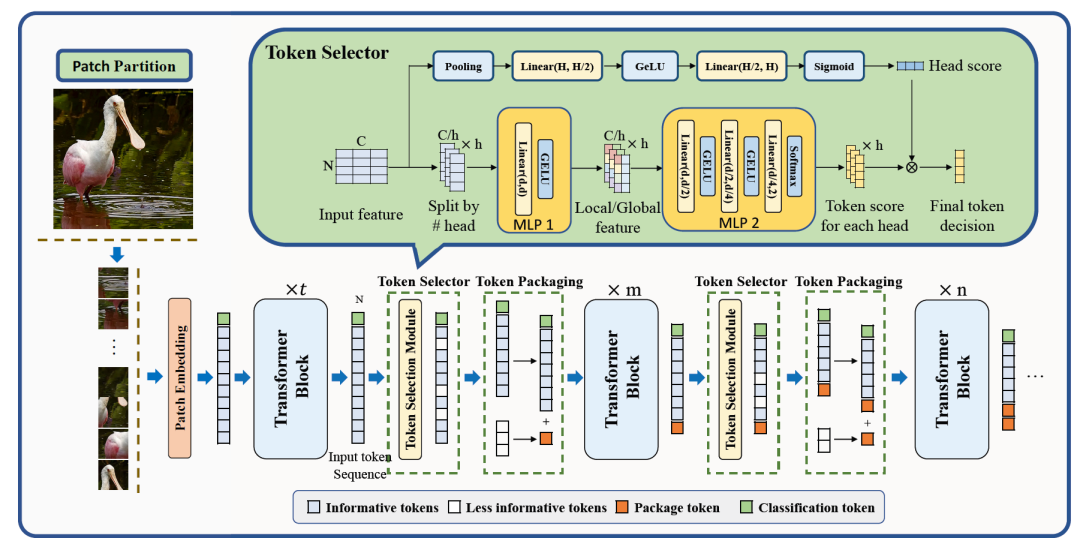

ViT:4 Pruning

实时了解业内动态,论文是最好的桥梁,专栏精选论文重点解读热点论文,围绕着行业实践和工程量产。若在某个环节出现卡点,可以回到大模型必备腔调或者LLM背后的基础模型重新阅读。而最新科技(Mamba,xLSTM,KAN)则提供了大模型领域最新技术跟踪。若对于具身智能感兴趣的请移步具身智能专栏。技术宅麻烦死磕AI架构设计。 视觉转换器(ViT)架构已经广受欢迎,并广泛用于计算机视觉应用。然而,随着 Vi

论文阅读笔记:Towards Higher Ranks via Adversarial Weight Pruning

论文阅读笔记:Towards Higher Ranks via Adversarial Weight Pruning 1 背景2 创新点3 方法4 模块4.1 问题表述4.2 分析高稀疏度下的权重剪枝4.3 通过SVD进行低秩逼近4.4 保持秩的对抗优化4.5 渐进式剪枝框架 5 效果5.1 和SOTA方法对比5.2 消融实验5.3 开销分析 6 结论 论文:https://arx

论文阅读笔记:DepGraph: Towards Any Structural Pruning

论文阅读笔记:DepGraph: Towards Any Structural Pruning 1 背景2 创新点3 方法4 模块4.1 分组4.2 依赖图4.3 网络分解4.4 依赖建模4.4 组级剪枝 5 效果 论文:https://arxiv.org/pdf/2301.12900 代码:https://github.com/VainF/Torch-Pruning 1 背景

【模型裁剪】——Rethinking the Value of Network Pruning

论文:https://arxiv.org/pdf/1810.05270.pdf code:https://github.com/Eric-mingjie/rethinking-network-pruning 转载自:https://blog.csdn.net/zhangjunhit/article/details/83506306 网络模型裁剪价值的重新思考 当前的深度学习网络模型一般都

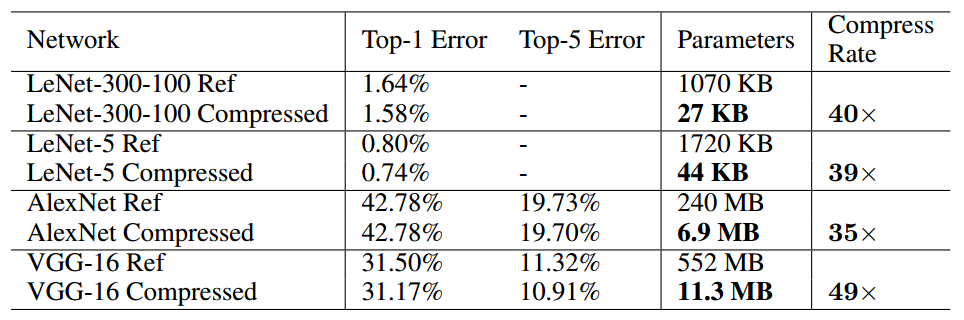

Compression Deep Neural Networks With Pruning, Trained Quantization And Huffman Coding

本次介绍的方法为“深度压缩”,文章来自2016ICLR最佳论文 《Deep Compression: Compression Deep Neural Networks With Pruning, Trained Quantization And Huffman Coding 转自:http://blog.csdn.net/shuzfan/article/details/51383809 (内含多

模型剪枝——RETHINKING THE VALUE OF NETWORK PRUNING

1.概述 神经网络的过度参数化是众所周知的,导致在推理时计算成本高,内存占用大。作为解决办法,网络剪枝被认为是提高有限计算预算应用中深度网络效率的有效技术。典型的剪枝算法包括三个阶段:训练(一个大型模型)、剪枝和微调。 普遍信念的挑战: 大模型训练的必要性:普遍认为从大型网络开始训练是重要的,因为它可以生成高性能模型。但研究发现,对于结构化剪枝方法,直接训练目标模型可以获得同

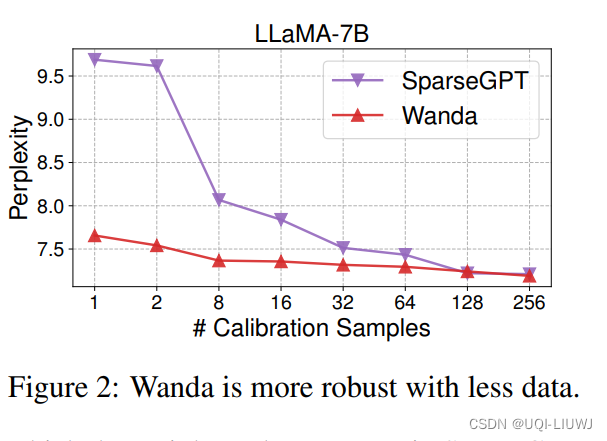

论文笔记:A Simple and Effective Pruning Approach for Large Language Models

iclr 2024 reviewer 评分 5668 1 intro 大模型网络剪枝的paper 在努力保持性能的同时,舍弃网络权重的一个子集现有方法 要么需要重新训练 这对于十亿级别的LLMs来说往往不现实要么需要解决依赖于二阶信息的权重重建问题 这同样可能带来高昂的计算成本——>引入了一种新颖、简单且有效的剪枝方法,名为Wanda (Pruning by Weights and activ

【论文笔记】ResRep: Lossless CNN Pruning via Decoupling Remembering and Forgetting

Abstract 提出了ResRep,一种无损通道修剪的新方法,它通过减少卷积层的宽度(输出通道数)来缩小CNN的尺寸。 建议将CNN重新参数化为记忆部分和遗忘部分,前者学习保持性能,后者学习修剪。通过对前者使用常规 SGD 进行训练,对后者使用带有惩罚梯度的新颖更新规则进行训练,实现了结构化稀疏性,然后等效地将记忆和遗忘部分合并到层数更窄的原始架构中。 github仓库 1 Introdu

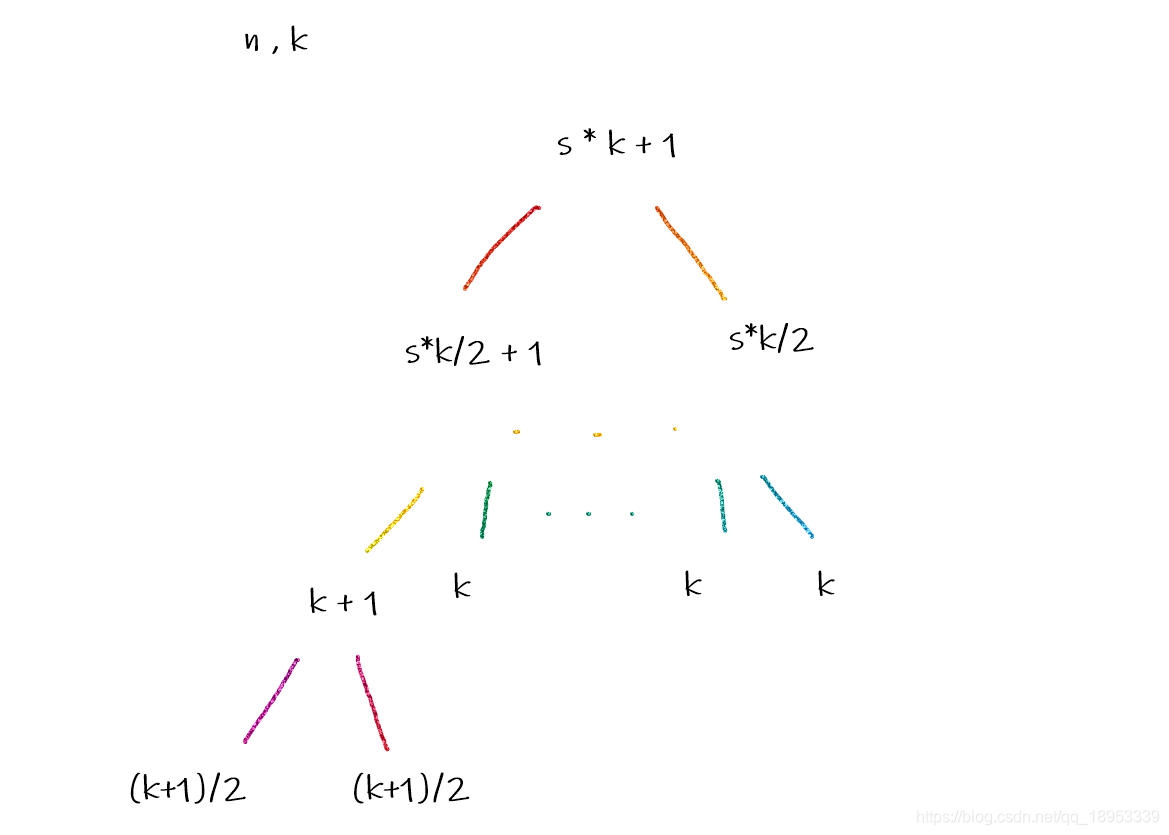

Segment Tree with Pruning

题目 题目链接: 题解: 记忆化搜索 #include <bits/stdc++.h>using namespace std;map<long long,long long>p;long long slove(long long n,long long k){if(n<=k) return 1;if(p[n]!=0) return p[n];if(n%2==0){p[n]=2*sl

【剪枝】torch-pruning的基本使用

论文:DepGraph: Towards Any Structural Pruning 工程:https://github.com/VainF/Torch-Pruning 算法和库的使用介绍:CVPR 2023 | DepGraph 通用结构化剪枝 1 TP的简介 该算法介绍了DepGraph 如何建模结构化剪枝中的层依赖,实现任意结构的剪枝。对应实现的库为 torch-pruning。

HDU - Segment Tree with Pruning

题目链接:https://acm.hdu.edu.cn/showproblem.php?pid=6983 Problem Description Chenjb is struggling with data stucture now. He is trying to solve a problem using segment tree. Chenjb is a freshman in progr

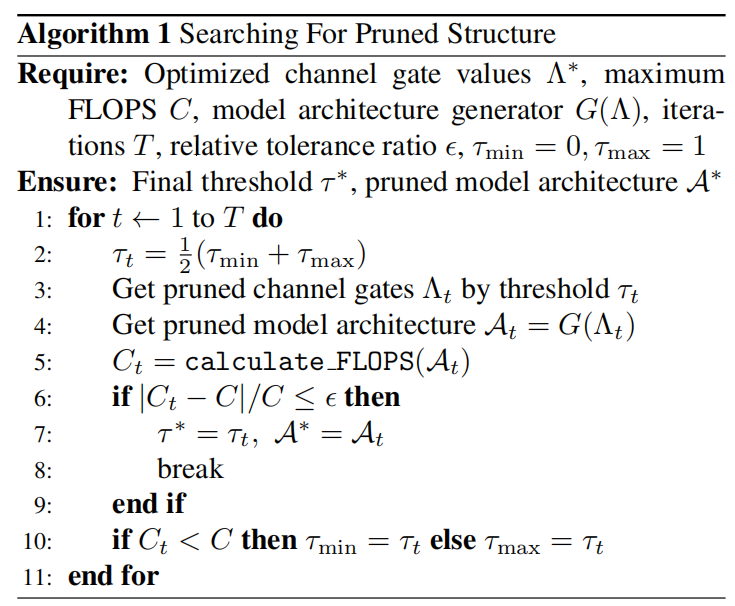

Pruning from Scratch 论文学习

Abstract 网络剪枝是降低神经网络计算成本的重要研究方向。传统的方法都是先训练一个大型、冗余的网络,然后决定哪些单元(如通道)没那么重要,可以被裁剪掉。这篇论文发现,我们不需要预训练一个过度参数化的网络,再对其进行剪枝。作者证明,从随机初始化的权重直接进行剪枝,可以获得更多样化的剪枝结构,甚至性能更优的模型。因而,作者提出了一个新的剪枝方法,允许我们从零开始剪枝 (prune from s

Pruning Pre-trained Language Models Without Fine-Tuning

本文是LLM系列文章,针对《Pruning Pre-trained Language Models Without Fine-Tuning》的翻译。 修剪未微调的预训练语言模型 摘要1 引言2 相关工作3 背景4 静态模型剪枝5 实验6 分析7 结论8 局限性 摘要 为了克服预训练语言模型(PLMs)中的过度参数化问题,剪枝作为一种简单直接的压缩方法被广泛使用,它直接去除不重要的