onnxruntime专题

PyInstaller问题解决 onnxruntime-gpu 使用GPU和CUDA加速模型推理

前言 在模型推理时,需要使用GPU加速,相关的CUDA和CUDNN安装好后,通过onnxruntime-gpu实现。 直接运行python程序是正常使用GPU的,如果使用PyInstaller将.py文件打包为.exe,发现只能使用CPU推理了。 本文分析这个问题和提供解决方案,供大家参考。 问题分析——找不到ONNX Runtime GPU 动态库 首先直接运行python程序

yolov8-obb旋转目标检测onnxruntime和tensorrt推理

onnxruntime推理 导出onnx模型: from ultralytics import YOLOmodel = YOLO("yolov8n-obb.pt") model.export(format="onnx") onnx模型结构如下: python推理代码: import cv2import mathimport numpy as npimport onnxr

Pytorch添加自定义算子之(12)-开闭原则设计tensorrt和onnxruntime推理语义分割模型

一、开闭原则 开闭原则是SOLID原则中的一个,指的是尽量使用开放扩展,关闭修改的设计原则。 在C++中如何使用开闭原则导出动态库,可以按照以下步骤进行: 定义抽象基类:定义动态库中的抽象基类,该基类应该封装可扩展的接口。 实现派生类:实现基类的派生类,这些派生类将封装对应的扩展接口。 将派生类编译为动态库:将所有派生类编译为动态库(DLL)。 使用动态库:在使用动态库的代码中,只需包

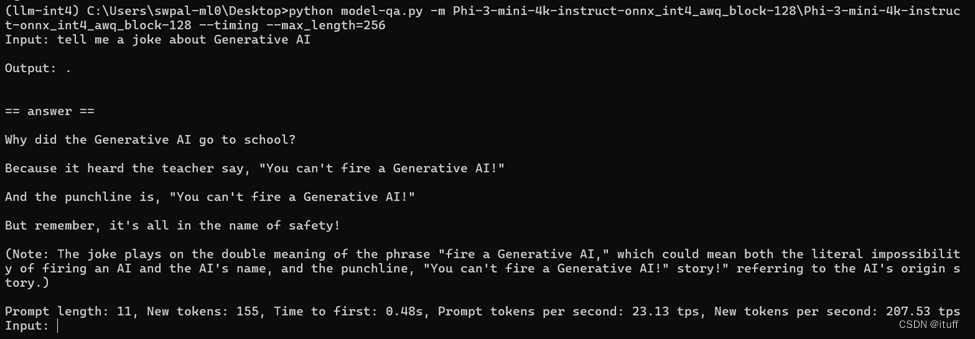

通过DirectML和ONNXRuntime运行Phi-3模型

更多精彩内容,欢迎关注我的公众号“ONE生产力”! 上篇我们讲到通过Intel Core Ultra系列处理器内置的NPU加速运行Phi-3模型,有朋友评论说他没有Intel处理器是否有什么办法加速Phi-3模型。通常,使用GPU特别是NVIDA的GPU加速AI模型是最佳的方法,但这年头英伟达的显卡不是一般贵,很多朋友苦于囊中羞涩,还在使用核显中。今天,我们介绍一种使用核显通过DirectML和

使用onnxruntime加载YOLOv8生成的onnx文件进行目标检测

在网上下载了60多幅包含西瓜和冬瓜的图像组成melon数据集,使用 LabelMe 工具进行标注,然后使用 labelme2yolov8 脚本将json文件转换成YOLOv8支持的.txt文件,并自动生成YOLOv8支持的目录结构,包括melon.yaml文件,其内容如下: path: ../datasets/melon # dataset root dirtrain: im

深度学习模型的C++部署:ONNXRUNTIME引领跨平台革命

一、引言 在AI技术的浪潮中,深度学习模型的部署已成为工程师们的核心技能。随着AI技术的不断进步,对于能够高效部署模型的人才需求日益增长。C++因其在性能和系统级控制方面的优势,正逐渐成为深度学习模型部署的行业新宠。 二、C++:性能驱动的编程语言 C++在深度学习模型部署中扮演着至关重要的角色。它不仅提供了接近硬件层面的优化能力,而且通过精细的内存管理和多线程支持,实现了快速且高效的模型推

onnxruntime 中的 Gather 算子

上一篇文章中介绍了 Division by Invariant Integers using Multiplication 的原理,很多框架均才用该算法优化除法运算。onnxruntime 是已知实现中最为简洁的,因此本文结合 onnxruntime 的 Gather 实现进行介绍。 Gather 算子是一个索引类算子,kernel 中每个线程计算偏移时使用 fast_divmod 避免除法运算。

onnxruntime.capi.onnxruntime_pybind11_state.Fail: [ONNXRuntimeError] : 1 : FAIL : Load model from mn

树莓派4B在使用onnxruntime1.6.0对model.onnx模型进行加载的时候出现以下的报错: 原因: 由于导出的ONNX模型文件不兼容ONNX Runtime当前版本所导致的,一开始我导出模型的方式如下: import tensorflow as tffrom keras import modelskeras_model = models.load_model("mnist

c#使用onnxruntime调用yolo模型导出的onnx模型分割图片

1.今天写下c#中怎么使用yolo模型系列导出的onnx分割图片 2.yolo训练好后,把模型导出为onnx模式。 3.导出模型为onnx模式后,在window中要引用,可以使用 Microsoft.ML.OnnxRuntime库 4.window系统要求win10或者更高,vs用vs2022或更高,.net使用的框架要在.net4.8或更高,才支持使用Microsoft.ML.OnnxRunti

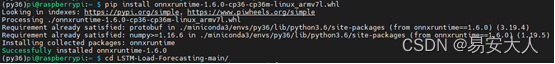

raspberrypi 树莓派 armv7l 32位的系统安装onnxruntime

项目场景: 最近尝试将模型部署在树莓派里面,使用onnxruntime推理,这里记录一下在树莓派安装使用onnxruntime的过程,我的系统是32位,onnxruntime官方没有直接的编译文件,期间走了不少弯路,最终还是成功了,希望能帮到大家少走点弯路! 安装过程 查询树莓派系统架构:uname -a 查询树莓派系统位数:getconf LONG_BIT 该系统是armv7l

YOLOv7-Openvino和ONNXRuntime推理【CPU】

纯检测系列: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv7-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 跟踪系列: YOLOv5/6/7-O

深度学习模型部署(三)Onnxruntime部署yolov5实战

模型分析 先使用yolov5下的yolo.py输出查看一下yolov5s的结构 python ./yolov5/models/yolo.py YOLOv5 🚀 v7.0-287-g574331f9 Python-3.8.18 torch-2.2.1+cu118 CUDA:0 (NVIDIA GeForce RTX 3060 Laptop GPU, 6144MiB)## 这里面的from

【Python】使用 onnxruntime-gpu 进行推理,解决运行时间久了显存被拉爆了

1. 问题 使用 onnxruntime-gpu 进行推理,解决运行时间久了显存被拉爆了 2. C++/Python 配置 运行时,配置 provder , gpu_mem_limit 参数来进行限制,比如2G显存 21474836482 * 1024 * 1024 * 1024 Python providers = [("TensorrtExecutionProvid

ONNXRuntime模型推理

直接贴code 加载,推理 import onnxruntime as ortimport torchimport timeimport cv2import numpy as npdef time_sync():if torch.cuda.is_available():torch.cuda.synchronize()return time.time()ort_session = ort.

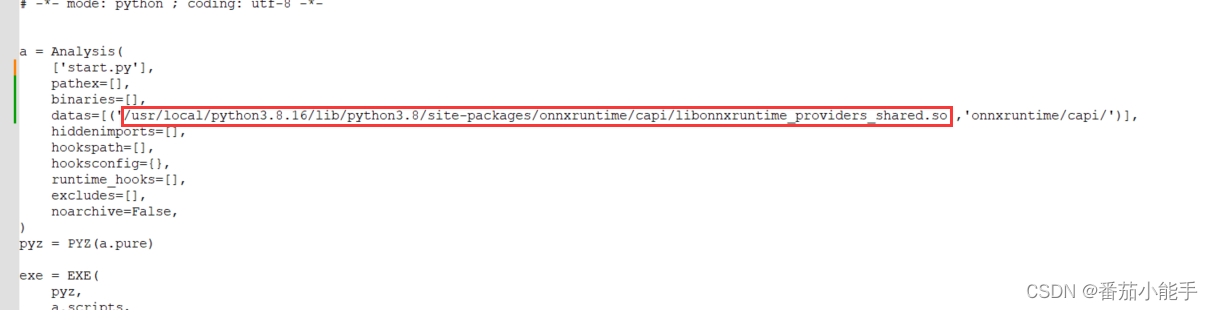

【pyinstaller打包记录】Linux系统打包可执行文件后,onnxruntime报警告(Init provider bridge failed)

简介 PyInstaller 是一个用于将 Python 程序打包成可执行文件(可执行程序)的工具。它能够将 Python 代码和其相关的依赖项(包括 Python 解释器、依赖的模块、库文件等)打包成一个独立的可执行文件,方便在不同环境中运行,而无需安装 Python 环境和相关依赖。 使用 PyInstaller,你可以将 Python 程序打包成 Wind

YOLOv5-Openvino和ONNXRuntime推理【CPU】

1 环境: CPU:i5-12500 Python:3.8.18 2 安装Openvino和ONNXRuntime 2.1 Openvino简介 Openvino是由Intel开发的专门用于优化和部署人工智能推理的半开源的工具包,主要用于对深度推理做优化。 Openvino内部集成了Opencv、TensorFlow模块,除此之外它还具有强大的Plugin开发框架,允许开发者在Openv

YOLOv9-Openvino和ONNXRuntime推理【CPU】

1 环境: CPU:i5-12500 Python:3.8.18 2 安装Openvino和ONNXRuntime 2.1 Openvino简介 Openvino是由Intel开发的专门用于优化和部署人工智能推理的半开源的工具包,主要用于对深度推理做优化。 Openvino内部集成了Opencv、TensorFlow模块,除此之外它还具有强大的Plugin开发框架,允许开发者在Openv

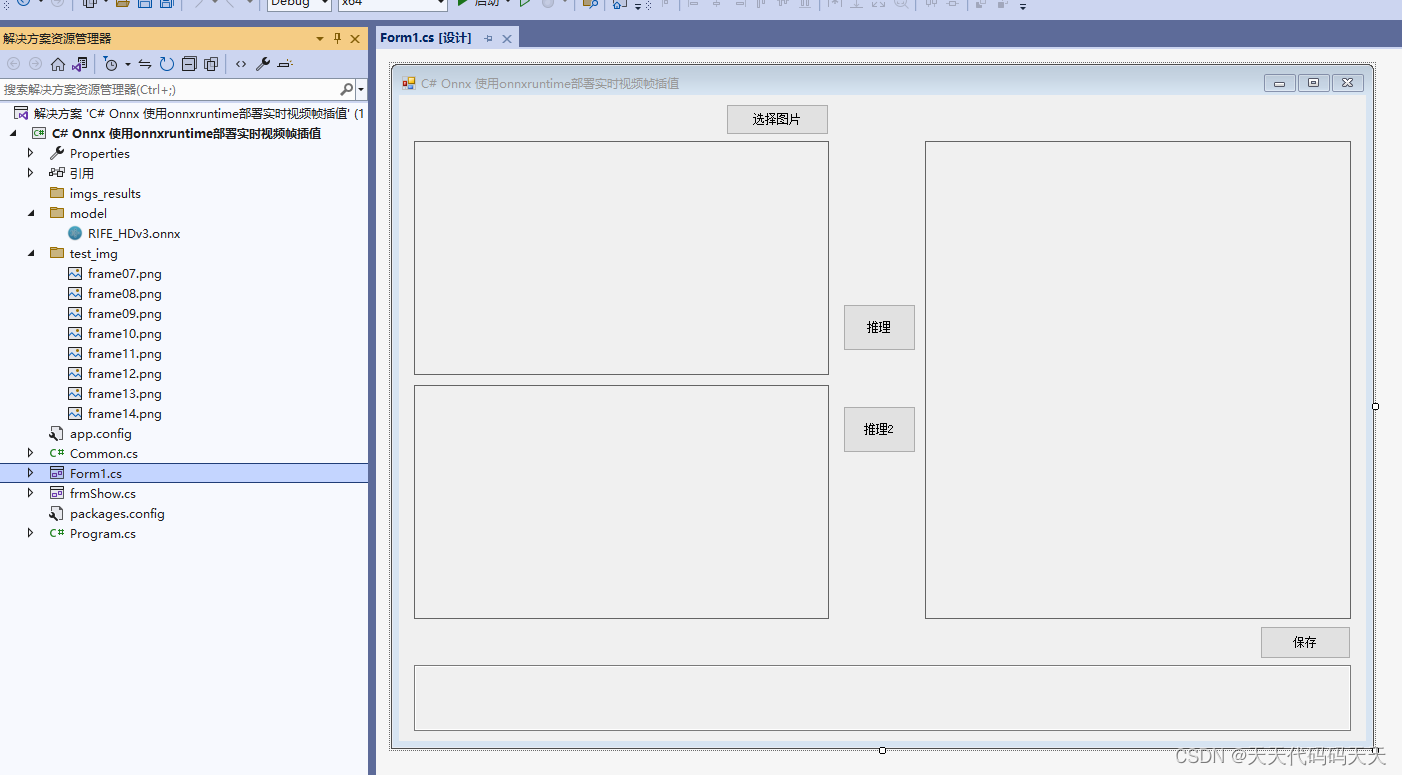

C# Onnx 使用onnxruntime部署实时视频帧插值

目录 介绍 效果 模型信息 项目 代码 下载 C# Onnx 使用onnxruntime部署实时视频帧插值 介绍 github地址:https://github.com/google-research/frame-interpolation FILM: Frame Interpolation for Large Motion, In ECCV 2022. The offi

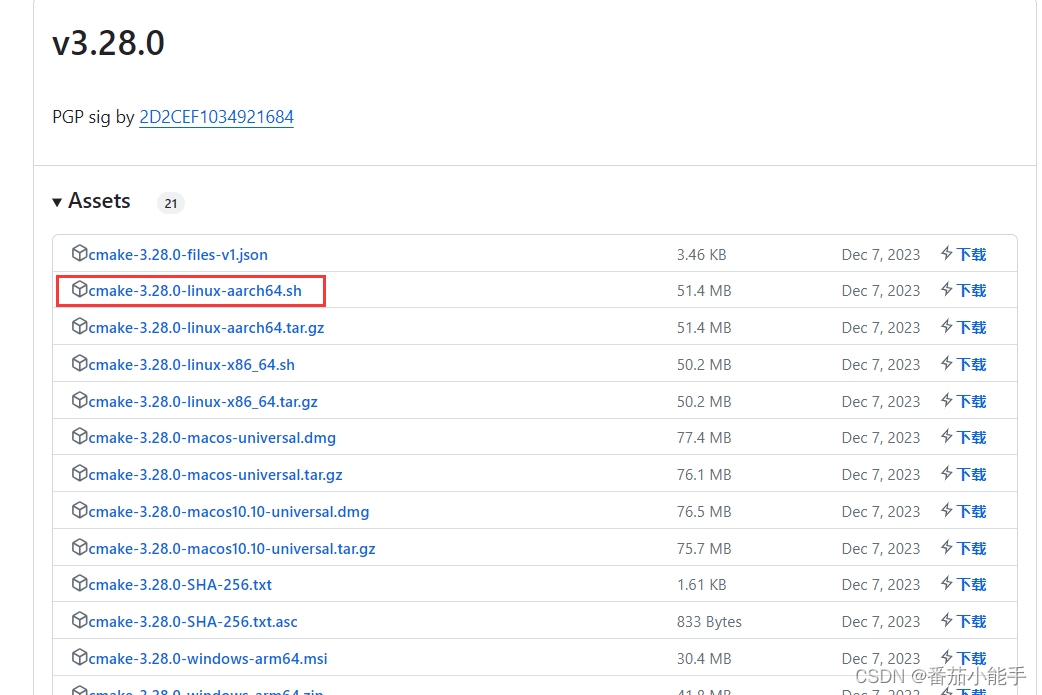

centos7 arm服务器编译安装onnxruntime-gpu

前言 ONNX Runtime是适用于Linux,Windows和Mac上ONNX格式的机器学习模型的高性能推理引擎,但在arm服务器上,onnxruntime只有CPU版的,GPU版的没有,因此需要自行去编译GPU版本的才可以。 环境准备 1、python3.8 2、cmake:2.26.0版本以上,可以直接下载aarch64版本的进行安装Releases · Kit

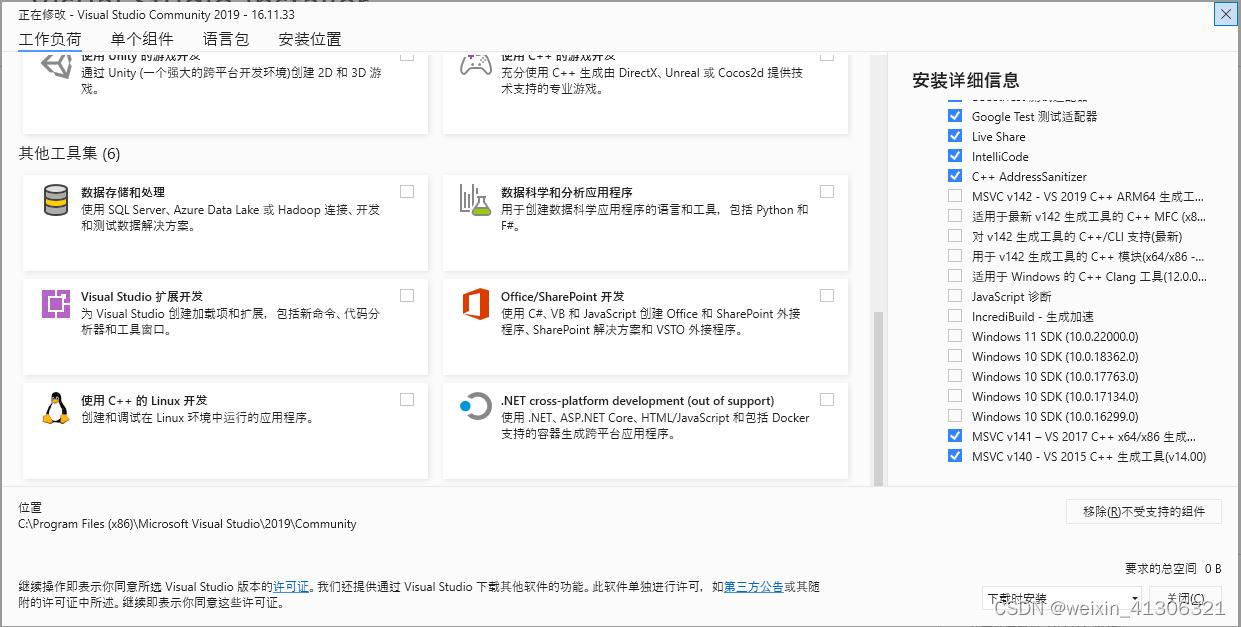

vs2019 vc140 调用 onnxruntime-1.14.1 gpu 踩坑记录

visual studio 环境: 安装了 vs2015 vs2017,vs2019 安装顺序先vs2019 社区版,没有勾选 这两项 然后直接安装vs2015,提示没有完全安装成功,直接使用vs2015 新建命令工程正常使用,opencv4 也能正常调用 然后安装vs2017 也是没勾选vc140,三个版本vs上 还是一样报错 然后卸载重装vs2015 卸载重装vs2017

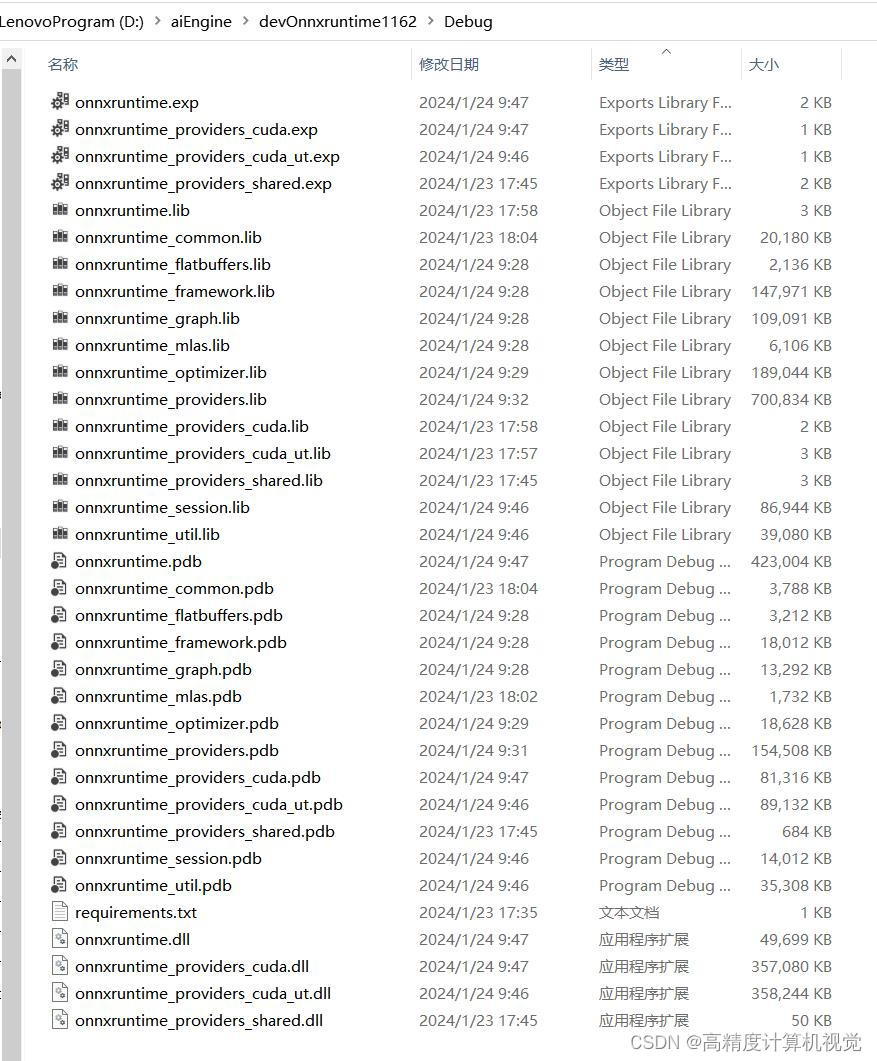

AI部署开发指南:用vs2019编译OnnxRuntime-v1.16.2

前言 要详细了解一个系统的部署,对其源码进行调试可能是最好的办法。 Pytorch的部署几经改版,最大的特点依然是不稳定,或者使用libtorch这种稳定但优化力度不够的部署方案。 而稳定且通用的方案,目前仍然是export to onnx的办法居多。onnxruntime在c++部署方面目前用得比较多,所以这里我们以微软最典型的onnxruntime部署为例,对其源码进行编译。编译后,就

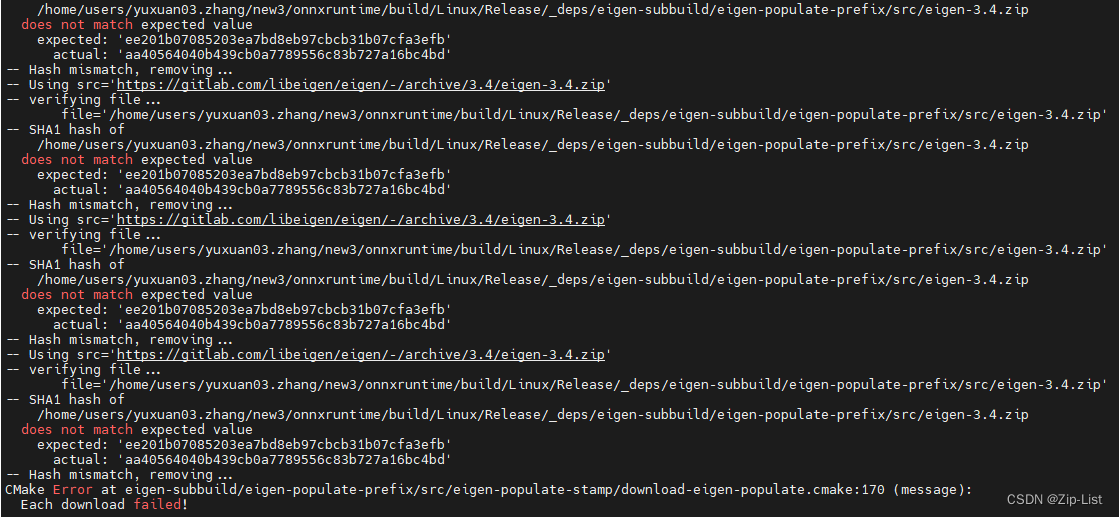

离线编译 onnxruntime-with-tensortRT

记录为centos7的4090开发机离线编译onnxruntime的过程,因为在离线的环境,所以踩了很多坑。 https://onnxruntime.ai/docs/execution-providers/TensorRT-ExecutionProvider.html 这里根据官网的推荐安装1.15 版本的onnx 因为离线环境,所以很多都是要自己手动编译安装的 onnx 源码 1.51 cm

自定义 bert 在 onnxruntime 推理错误:TypeError: run(): incompatible function arguments

自定义 bert 在 onnxruntime 推理错误:TypeError: run(): incompatible function arguments 自定义 bert 在 onnxruntime 推理错误:TypeError: run(): incompatible function arguments推理代码错误提示核心错误 解决方法核对参数修改代码 自定义 bert 在

[C#]Onnxruntime部署Chinese CLIP实现以文搜图以文找图功能

【官方框架地址】 https://github.com/OFA-Sys/Chinese-CLIP 【算法介绍】 在当今的大数据时代,文本信息处理已经成为了计算机科学领域的核心议题之一。为了高效地处理海量的文本数据,自然语言处理(NLP)技术应运而生。而在诸多NLP技术中,文本分割是一种基础且重要的任务。Chinese Clip算法正是在这样的背景下被提出,用于解决中文文本的分割问题。 Chi

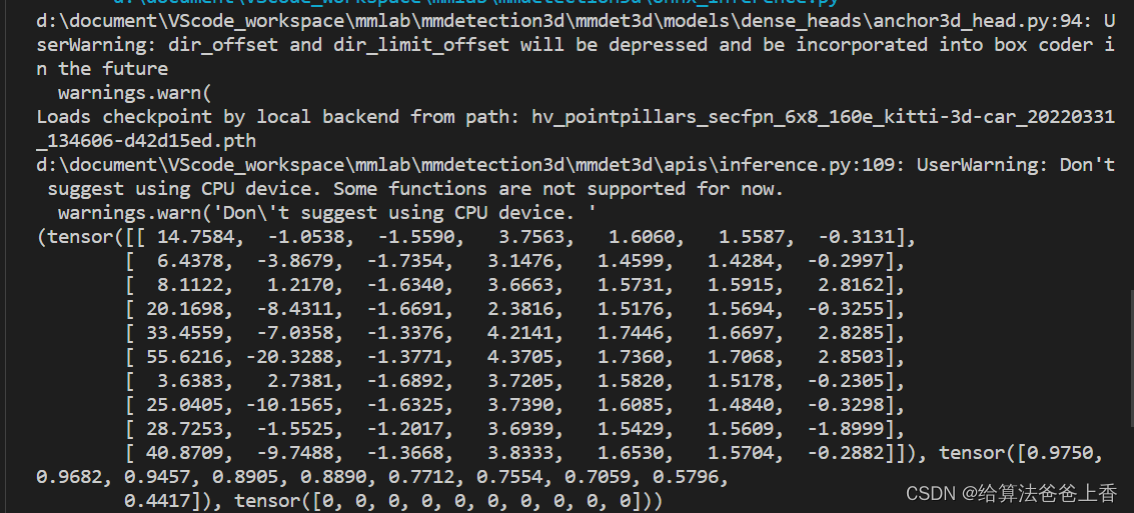

OpenMMlab导出PointPillars模型并用onnxruntime推理

导出onnx文件 通过mmdeploy的tool/deploy.py脚本容易转换得到PointPillars的end2end.onnx模型。 根据https://github.com/open-mmlab/mmdeploy/blob/main/docs/zh_cn/04-supported-codebases/mmdet3d.md显示,截止目前 mmdet3d 的 voxelize 预处理和后

[C#]使用onnxruntime部署yolov8-onnx印章检测

【官方框架地址】 https://github.com/ultralytics/ultralytics.git 【算法介绍】 YOLOv8是目标检测领域中的一种先进算法,它是YOLO(You Only Look Once)系列算法的最新发展。YOLO算法以其高效和实时的性能而著名,而YOLOv8则进一步提升了这些特点。 YOLOv8的核心思想是将目标检测任务视为回归问题,通过单次前向传播直接

![onnxruntime.capi.onnxruntime_pybind11_state.Fail: [ONNXRuntimeError] : 1 : FAIL : Load model from mn](https://img-blog.csdnimg.cn/74ae48db8fb04432b6dd6267d3b02089.png)

![[C#]Onnxruntime部署Chinese CLIP实现以文搜图以文找图功能](https://img-blog.csdnimg.cn/direct/6cfab5ee5cb544d7b536b28bad953ba0.jpeg)

![[C#]使用onnxruntime部署yolov8-onnx印章检测](https://img-blog.csdnimg.cn/direct/0ab75688442d49fd9ec07bcde2eac7fe.jpeg)