layernorm专题

train_gpt2_fp32.cu - layernorm_forward_kernel3

源码 __global__ void layernorm_forward_kernel3(float* __restrict__ out, float* __restrict__ mean, float* __restrict__ rstd,const float* __restrict__ inp, const float* __restrict__ weight,const float*

自然语言处理: 第二十四章 为什么在NLP领域中普遍用LayerNorm 而不是BatchNorm?

前言 前面讲了Transformer 架构, 其中有一个层归一化layerNorm结构,最近在看不同的大模型结构中也发现会对其优化。但是似乎在CV领域貌似批次归一化BN层用的也很多,那么这两个归一化层到底有什么区别呢?为何在NLP领域几乎都是LN层,而不用BN层呢? 一、What is Normalization? Normalization:规范化或标准化,就是把输入数据X,在

nn.LayerNorm的参数说明

Pytorch库中的torch.nn.LayerNorm模块,它是一种在自然语言处理中广泛应用的正规化技术。LayerNorm通过对输入数据进行归一化处理,可以提高模型的鲁棒性和泛化能力。具体体现如下两个方面: 1、将数据归一化至同一量级,解决数据间的可比性问题,如果量级不一样,那么网络可能解读错误。 2、归一化之后,寻求最优解的过程会变得平缓,可以更快的收敛到最优解 函数原型: torc

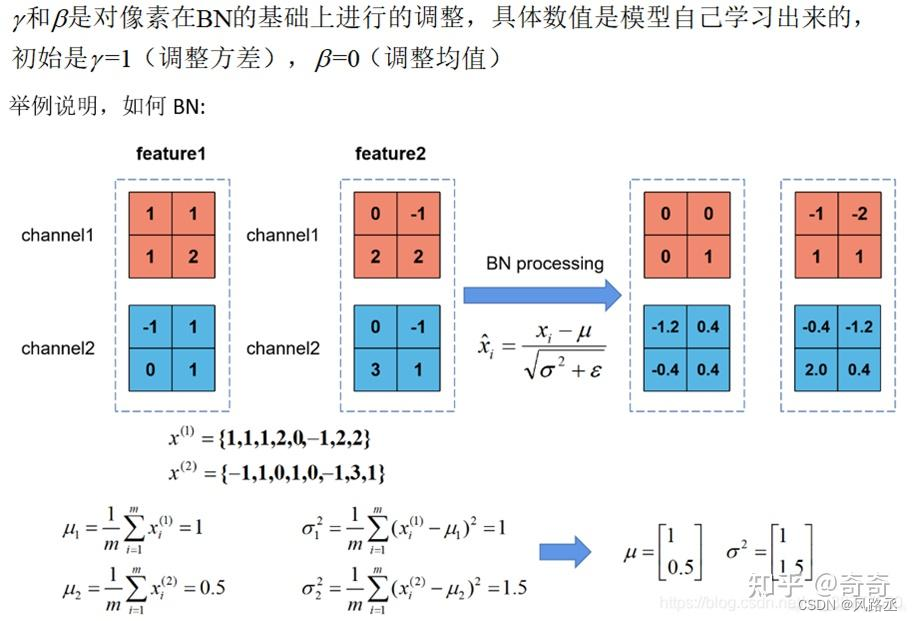

layerNorm和batchNorm

layerNorm和batchNorm 1、异同点2、图解(1)1d Norm图(2)2d Norm图 1、异同点 BatchNorm与LayerNorm的异同、 batchnorm 和layernorm的区别 相同点:都是让该层参数稳定下来,避免梯度消失或者梯度爆炸,方便后续的学习。 不同点: BN 对不同样本的同一特征做标准化(标准正态分布),抹杀了不同特征之间的大小

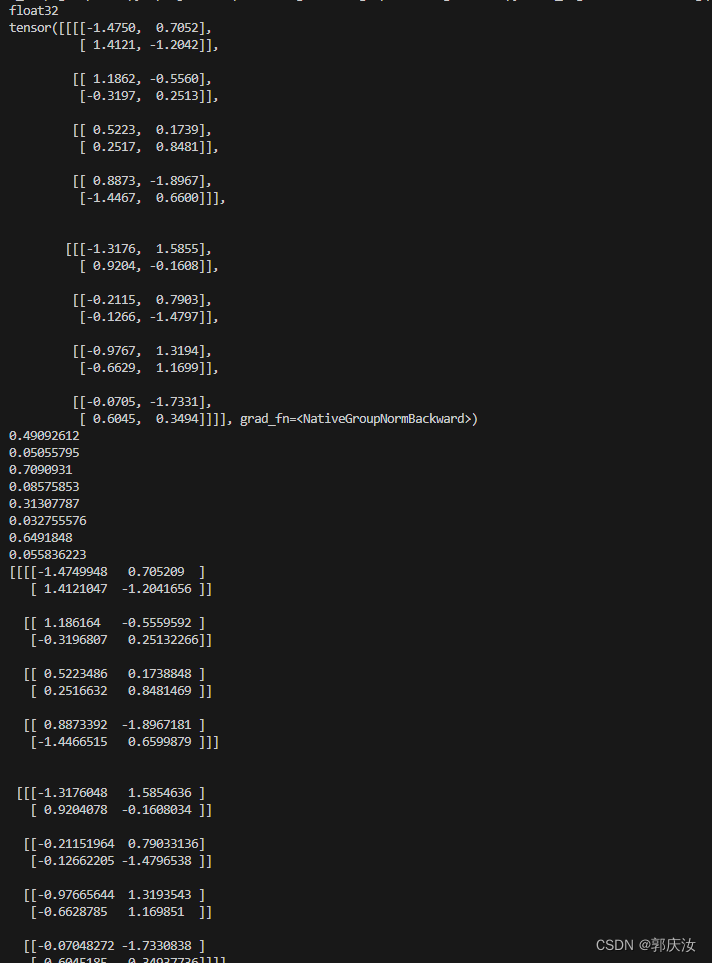

【深度学习】四种归一化方式对比:| LayerNorm,BatchNorm,InstanceNorm,GroupNorm

文章目录 1 四种归一化方式对比2 代码实践2.1 BatchNorm(批归一化)2.2 LayerNorm(层归一化)2.3 InstanceNorm(实例归一化)2.4 GroupNorm(组归一化) 归一化技术可以很好地,缓解梯度消失/爆炸问题,并有助于更快地收敛,也是一种正则化技术防止过拟合 实际中会看到好多归一化 比如BatchNorm,LayerNorm,Gro

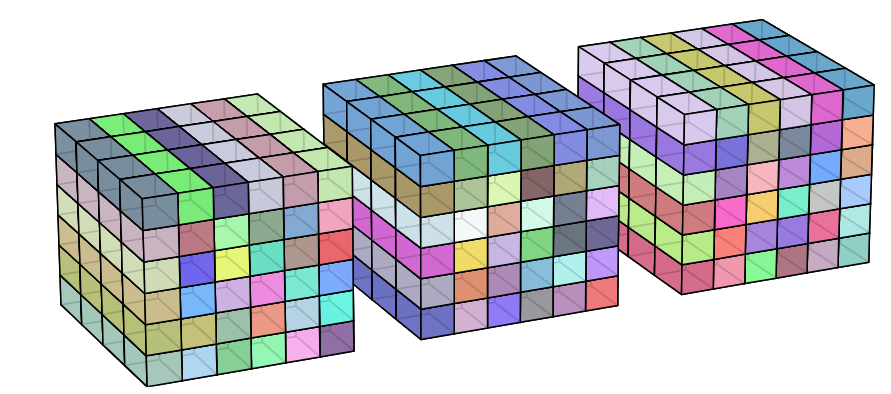

LayerNorm的图是不是画错了

这是网上一张很流行的说明几个 Normalization 区别的图 这图出自Kaiming的文章 Group Norm 但是他这个 Layer Norm 的图是不是画错了? 我大四写毕设的时候就想问🤣🤣🤣 这都几年过去了 我觉得图应该是这样画的,相同颜色的区域做标准化 仨方块代表Batch_size = 3 每个方块内,前后向代表channel维度,左右代表宽,上下代表高 也就是

hk.LayerNorm 模块介绍

hk.LayerNorm 是 Haiku 库中用于实现 Layer Normalization(层归一化)的模块。Layer Normalization 是一种神经网络归一化的技术,旨在提高神经网络的训练稳定性和泛化性。 主要参数: axis(默认为-1): 沿着哪个轴进行归一化。通常选择最后一个轴,对输入的特征进行归一化。 create_scale(默认为True): 是否创建可学习的缩

4.35 构建onnx结构模型-Layernorm

前言 构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构 本文主要是简单学习和使用两种不同onnx结构, 下面以 Layernorm 结点进行分析 方式 方法一:pytorch --> onnx 暂缓,主要研究方式二 方法二: onnx import onnxfrom onnx i

LayerNorm层归一化

LayerNorm(Layer Normalization)是一种常用的归一化技术,用于神经网络模型中的层级归一化操作。它在每个样本的每个特征维度上进行归一化,使得每个特征的均值为0,方差为1,从而有助于提高模型的训练效果和泛化能力 LN是针对自然语言处理领域提出的,例如像RNN循环神经网络 与 Batch Normalization (批归一化)既有相似之处又有不同:从公式上看,都是减去均值

pytorch中的归一化:BatchNorm、LayerNorm 和 GroupNorm

1 归一化概述 训练深度神经网络是一项具有挑战性的任务。 多年来,研究人员提出了不同的方法来加速和稳定学习过程。 归一化是一种被证明在这方面非常有效的技术。 1.1 为什么要归一化 数据的归一化操作是数据处理的一项基础性工作,在一些实际问题中,我们得到的样本数据都是多个维度的,即一个样本是用多个特征来表示的,数据样本的不同特征可能会有不同的尺度,这样的情况会影响到数据分析的结果。为了解决

torch.nn.batchnorm1d,torch.nn.batchnorm2d,torch.nn.LayerNorm解释:

批量归一化是一种加速神经网络训练和提升模型泛化能力的技术。它对每个特征维度进行标准化处理,即调整每个特征的均值和标准差,使得它们的分布更加稳定。 Batch Norm主要是为了让输入在激活函数的敏感区。所以BatchNorm层要加在激活函数前面。 1.torch.nn.batchnorm1d: (1)归一化处理公式: E(x)表示样本某一维的均值,Var(x)表示样本某一维的方差;

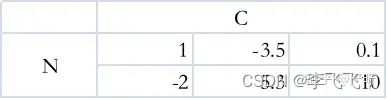

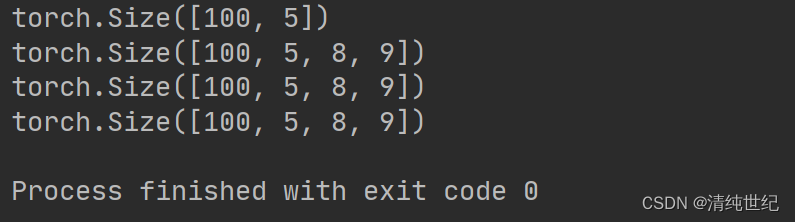

nn.LayerNorm解释

这个是层归一化。我们输入一个参数,这个参数就必须与最后一个维度对应。但是我们也可以输入多个维度,但是必须从后向前对应。 import torchimport torch.nn as nna = torch.rand((100,5))c = nn.LayerNorm([5])print(c(a).shape)a = torch.rand((100,5,8,9))c = nn.LayerNo

nn.LayerNorm解释

这个是层归一化。我们输入一个参数,这个参数就必须与最后一个维度对应。但是我们也可以输入多个维度,但是必须从后向前对应。 import torchimport torch.nn as nna = torch.rand((100,5))c = nn.LayerNorm([5])print(c(a).shape)a = torch.rand((100,5,8,9))c = nn.LayerNo

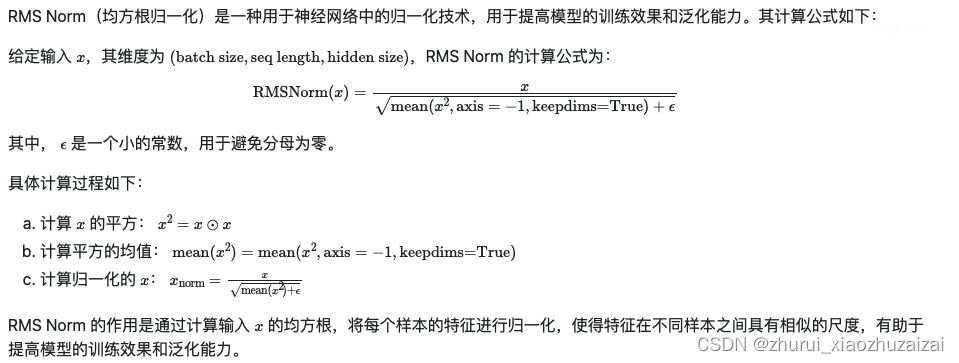

大模型LLM相关面试题整理-位置编码-tokenizer-激活函数-layernorm

10 LLMs 位置编码篇 10.1.1 什么是位置编码? 位置编码是一种用于在序列数据中为每个位置添加位置信息的技术。在自然语言处理中,位置编码通常用于处理文本序列。由于传统的神经网络无法直接捕捉输入序列中的位置信息,位置编码的引入可以帮助模型更好地理解和处理序列数据。 在Transformer模型中,位置编码通过为输入序列中的每个位置分配一个固定的向量来实现。这些向量会与输入序列中的词向

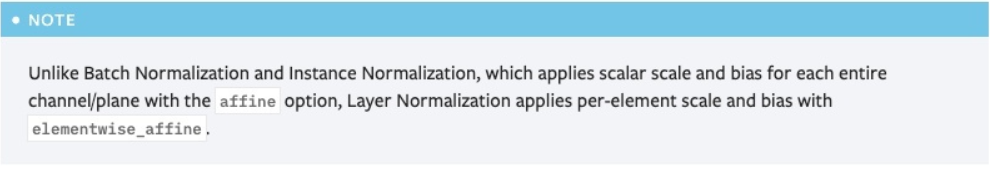

计算上理解LayerNorm,为何泄露信息,知识追踪

pytorch 中layernorm 的使用 首先给出官网的解释, torch.nn.LayerNorm(normalized_shape: Union[int, List[int], torch.Size],eps: float = 1e-05,elementwise_affine: bool = True) 其中注意:LayerNorm中不会像BatchNorm那样跟踪统计全局的均值

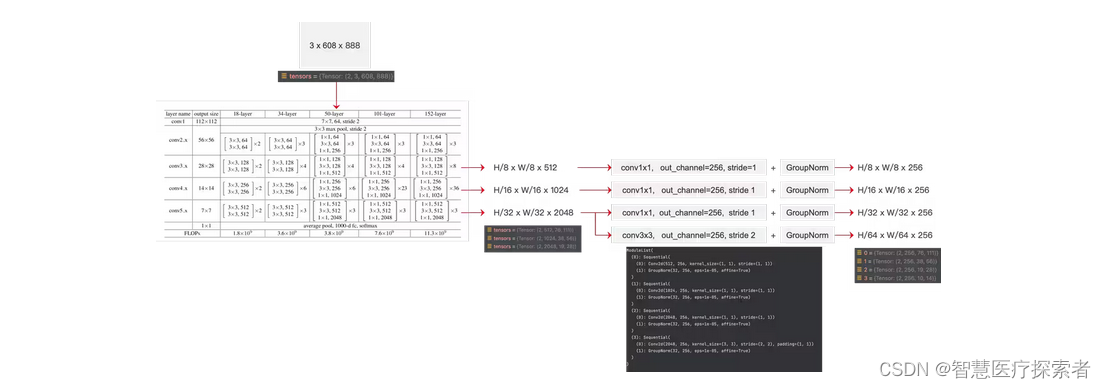

深度学习基础知识 BatchNorm、LayerNorm、GroupNorm的用法解析

深度学习基础知识 BatchNorm、LayerNorm、GroupNorm的用法解析 1、BatchNorm2、LayerNorm3、GroupNorm用法: BatchNorm、LayerNorm 和 GroupNorm 都是深度学习中常用的归一化方式。 它们通过将输入归一化到均值为 0 和方差为 1 的分布中,来防止梯度消失和爆炸,并提高模型的泛化能力 1、Batc

深度学习基础知识 BatchNorm、LayerNorm、GroupNorm的用法解析

深度学习基础知识 BatchNorm、LayerNorm、GroupNorm的用法解析 1、BatchNorm2、LayerNorm3、GroupNorm用法: BatchNorm、LayerNorm 和 GroupNorm 都是深度学习中常用的归一化方式。 它们通过将输入归一化到均值为 0 和方差为 1 的分布中,来防止梯度消失和爆炸,并提高模型的泛化能力 1、Batc