gnn专题

GNN中的Over-smoothing与Over-squashing问题

Over-squashing (过度压缩,顾名思义就是数据被“压缩”的过分小了,导致学不到什么东西。) 1、 why 会被压缩的过分小? 可能因为网络过深,那么在多层传播后,信息可能会被过度压缩(本质是特征减少了,当层数过多时会大大杂糅信息,导致特征减少,输出维度过小也会),导致细节丢失。 2、why 学不到什么东西? 会加剧梯度消失的现象,导致早期层几乎不学习,从而使得输入信息的重要细

图神经网络(GNN):同质图模型【GCN/GraphSAGE/GAT...】、异质图模型【HAN/HetGNN...】

目前的图神经网络主要针对同质图(节点类型和边类型单一)设计. 同质图中只有一种类型的节点和边(例如,只有朋友关系的社交网络),网络结构较为简单.因此,同质图神经网络通常只需要聚合单一类型的邻居来更新节点的表示即可(例如,通过在朋友关系下的邻居来更新节点表示).但真实世界中的图大部分都可以被自然地建模为异质图(多种类型的节点和边,如下图所示,IMDB数据中包含三种类型的节点Actor、Movie和

GNN-2008:Original GNN【消息传递(前向传播):聚合函数+更新函数+输出函数】【核心:不动点理论】【梯度优化:用Almeida-Pineda算法,而不是用BPTT(反向传播)算法】

GNN-2008:Original GNN【消息传递(前向传播):聚合函数+更新函数+输出函数】【核心:不动点理论】【梯度优化:用Almeida-Pineda算法,而不是用BPTT(反向传播)算法】 《原始论文:A new model for learning in graph domains-2005》 《原始论文:The Graph Neural Network Model-2008》 一

GNN-频域-2014:Spectral Networks and Locally Connected Networks on Graphs(频谱图卷积神经网络)【第一篇从频域角度分析】

《原始论文:Spectral Networks and Locally Connected Networks on Graphs》 空域卷积非常直观地借鉴了图像里的卷积操作,但缺乏一定的理论基础。 而频域卷积则不同,相比于空域卷积而言,它主要利用的是**图傅里叶变换(Graph Fourier Transform)**实现卷积。 简单来讲,它利用图的**拉普拉斯矩阵(Laplacian ma

GNN-第三方库:PyTorch Geometric Temporal【PyG的一个时间图神经网络扩展库】

PyTorch Geometric Temporal 是PyTorch Geometric(PyG)的一个时间图神经网络扩展库。它建立在开源深度学习和图形处理库之上。 GitHub源码:benedekrozemberczki/pytorch_geometric_temporal PyTorch Geometric Temporal由最先进的深度学习和参数学习方法组成,用于处理时空信号。 Py

GNN-第三方库:DGL【图神经网络框架,支持对异构图的处理,开源相关异构图神经网络的代码,在GCMC、RGCN等业内知名的模型实现上也取得了很好的效果】

一、DGL库的实现与性能 实现GNN并不容易,因为它需要在不规则数据上实现较高的GPU吞吐量。 1、DGL库简介 DGL库的逻辑层使用了顶点域的处理方式,使代码更容易理解。同时,又在底层的内存和运行效率方面做了大量的工作,使得框架可以发挥出更好的性能。 2、DGL库特点 GCMC:DGL的内存优化支持在一个GPU上对MovieLens10M数据集进行训练(原实现需要从CPU中动态加载数据

GNN-节点向量(Node Embedding)的表征学习-发展:随机游走/一阶二阶相似度(静态表征)【直接学习出各个节点的向量表示】 -->图卷积(动态表征)【学习节点间聚合函数的参数】

静态表征 基于“随机游走”、“Word2vec”的:DeepWalk、Node2vec、Metapath2vec;基于“一阶相似度”、“二阶相似度”的:LINE、SDNE; 动态表征(GCN、GraphSAGE、GAT)【训练聚合函数的参数】

GNN-静态表征-随机游走-2014:DeepWalk【步骤:①随机游走策略生成每个节点的训练序列(DFS),得到训练数据集;②套用Word2vec算法得到节点表示】【捕获二阶相似度】【浅层、同质图】

一、概述 1、 2、DeepWalk、LINE、Node2vec对比 提出的顺序DeepWalk 2014, UNE 2015, Node2Vec 2016 Node2Vec设置 p = q = 1 p=q =1

图神经网络GNN的前世今生

GNN 图神经网络(Graph Neural Network,简称GNN)已经成为处理图形结构数据的一种强大工具,广泛应用于社交网络分析、知识图谱、推荐系统等领域。在本文中,我们将深入探讨图神经网络的历史背景、关键的发展阶段以及未来可能的发展方向。 一、背景介绍 图(Graph)是一种数据结构,由节点(Node)和连接节点的边(Edge)组成。在许多现实世界的应用中,数据

探索图神经网络(GNN):使用Python实现你的GNN模型

一、引言 图神经网络(Graph Neural Network, GNN)作为近年来机器学习和深度学习领域的热门话题,正逐渐吸引越来越多的研究者和开发者的关注。GNN能够处理图结构数据,在社交网络分析、推荐系统、化学分子结构预测等领域有着广泛的应用。本文将带你一步一步使用Python实现一个基本的图神经网络模型,并帮助你理解相关的核心概念和技术细节。 二、图神经网络的基础知识 图神经网络(G

GNN algorithms(7): Flash Attention

目录 Background 参考 Flash Attention: Fast and Memory-Efficient Exact Attention with IO-Awareness Background HBM: high Boardwidth memory, 高带宽内存 SRAM: Static RAM, 静态随机存储器 Flash Attention 分而治之的思想

图神经网络(GNN)的原理及应用

什么是图神经网络 (GNN)? 图神经网络 (GNN) 是一种神经网络架构和深度学习方法,可以帮助用户分析图,使他们能够根据图的节点和边描述的数据进行预测。 图形表示数据点(也称为节点)之间的关系。这些节点表示主体(例如人、物体或地点),边缘表示节点之间的关系。图形可以由 x 轴和 y 轴、原点、象限、线条、条形和其他元素组成。 通常,机器学习 (ML) 和深度学习算法使用简单的数据类型进行

【机器学习】训练GNN图神经网络模型进行节点分类

1. 引言 1.1 图神经网络GNN概述 图神经网络(Graph Neural Network,GNN)是一种专门用于处理图结构数据的神经网络方法。它起源于2005年,当时Gori等人首次提出了GNN的概念,用于学习图中的节点特征以及它们之间的关系。随后,随着深度学习技术的快速发展,GNN得到了广泛的关注和研究。 1.1.1 GNN的核心算法思想 GNN的核心思想是通过迭代地聚合节点的邻居

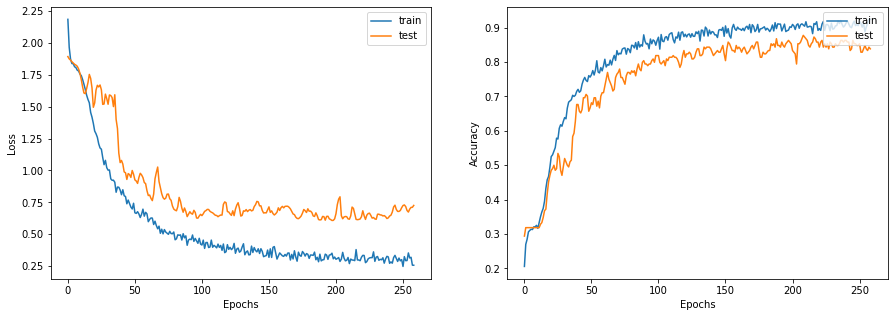

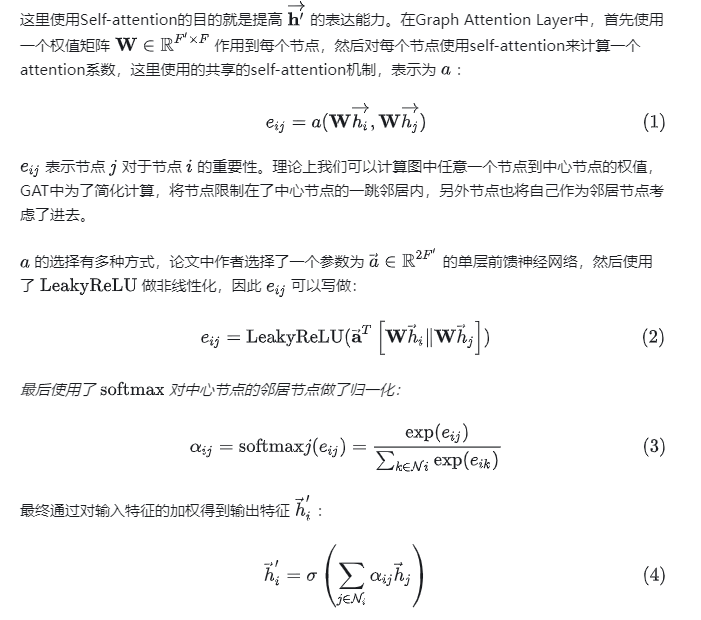

Python GNN图神经网络代码实战;GAT代码模版,简单套用,易于修改和提升,图注意力机制代码实战

1.GAT简介 GAT(Graph Attention Network)模型是一种用于图数据的深度学习模型,由Veličković等人在2018年提出。它通过自适应地在图中计算节点之间的注意力来学习节点之间的关系,并在节点表示中捕捉全局和局部信息。 GAT模型的核心思想是通过注意力机制,对图中的节点进行加权聚合。与传统的图卷积网络(GCN)模型不同,GAT不仅考虑节点本身的特征信息,还考虑了节

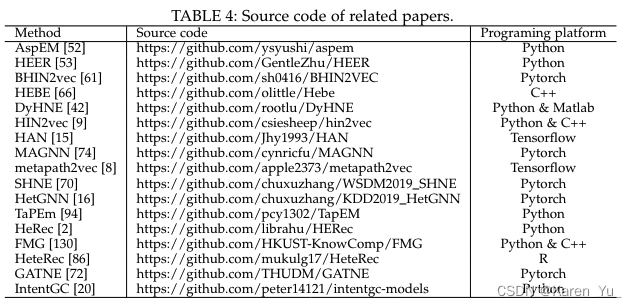

【intro】GNN中异构图(heterogeneous graph)综述

本篇博客内容是读两篇论文,两篇论文连接如下: Heterogeneous graph neural networks analysis: a survey of techniques, evaluations and applications A Survey on Heterogeneous Graph Embedding: Methods, Techniques, Applications

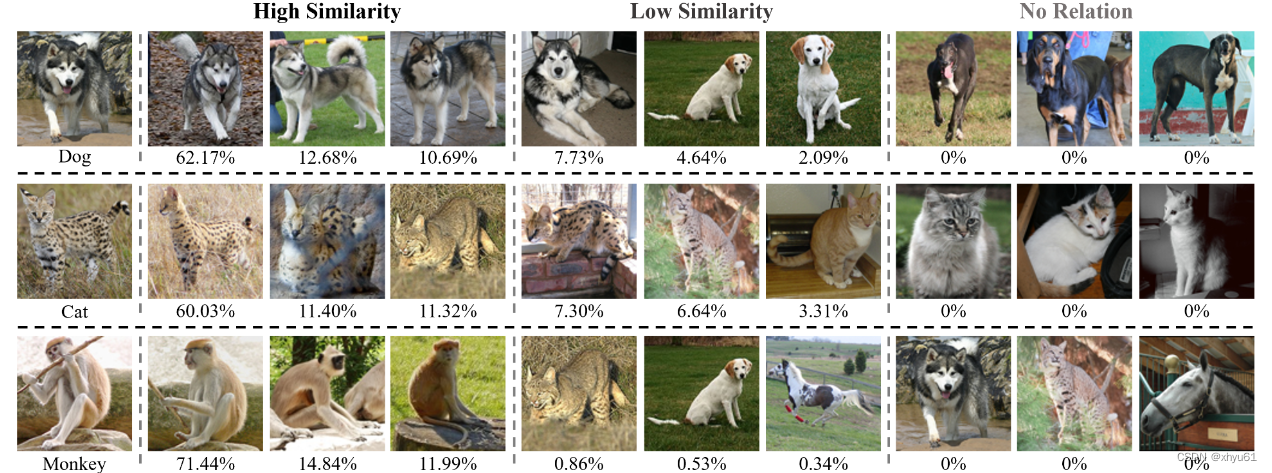

【论文笔记】CNN2GNN: How to Bridge CNN with GNN

Abstract CNN在视觉任务上表现优异,通常堆叠大量卷积核来提高训练表现; GNN成功用几个图神经层探索了图数据之间的潜在拓扑关系。 由于缺乏图结构,在非图数据上无法使用GNN,在大规模场景下推理延迟较高。 提出问题:如何桥接这两个异构网络? 本文提出了一个新颖的CNN2GNN框架,通过蒸馏将CNN和GNN统一在一起。 设计可微稀疏图学习模块(differentiable sparse

随手笔记-GNN(朴素图神经网络)

自己看代码随手写的一点备忘录,自己看的,不喜勿喷 GNN (《------ 代码) 刚开始我还在怀疑为什么没有加×weigth + bias,已经为什么权重才两个,原来是对node_feats进行的network的传播,而且自己内部直接进行了。 下面是一些自己对代码的解读,方便理解:

########全面回顾Graph深度学习,一文看尽GNN、GCN、GAE、GRNN、GRL

昨天,阿里巴巴达摩院发布2019十大技术趋势,其中就包括“超大规模图神经网络系统将赋予机器常识”: 单纯的深度学习已经成熟,而结合了深度学习的图神经网络将端到端学习与归纳推理相结合,有望解决深度学习无法处理的关系推理、可解释性等一系列问题。强大的图神经网络将会类似于由神经元等节点所形成网络的人的大脑,机器有望成为具备常识,具有理解、认知能力的AI。 此前,新智元曾经报道过清华大学孙茂松教授组对

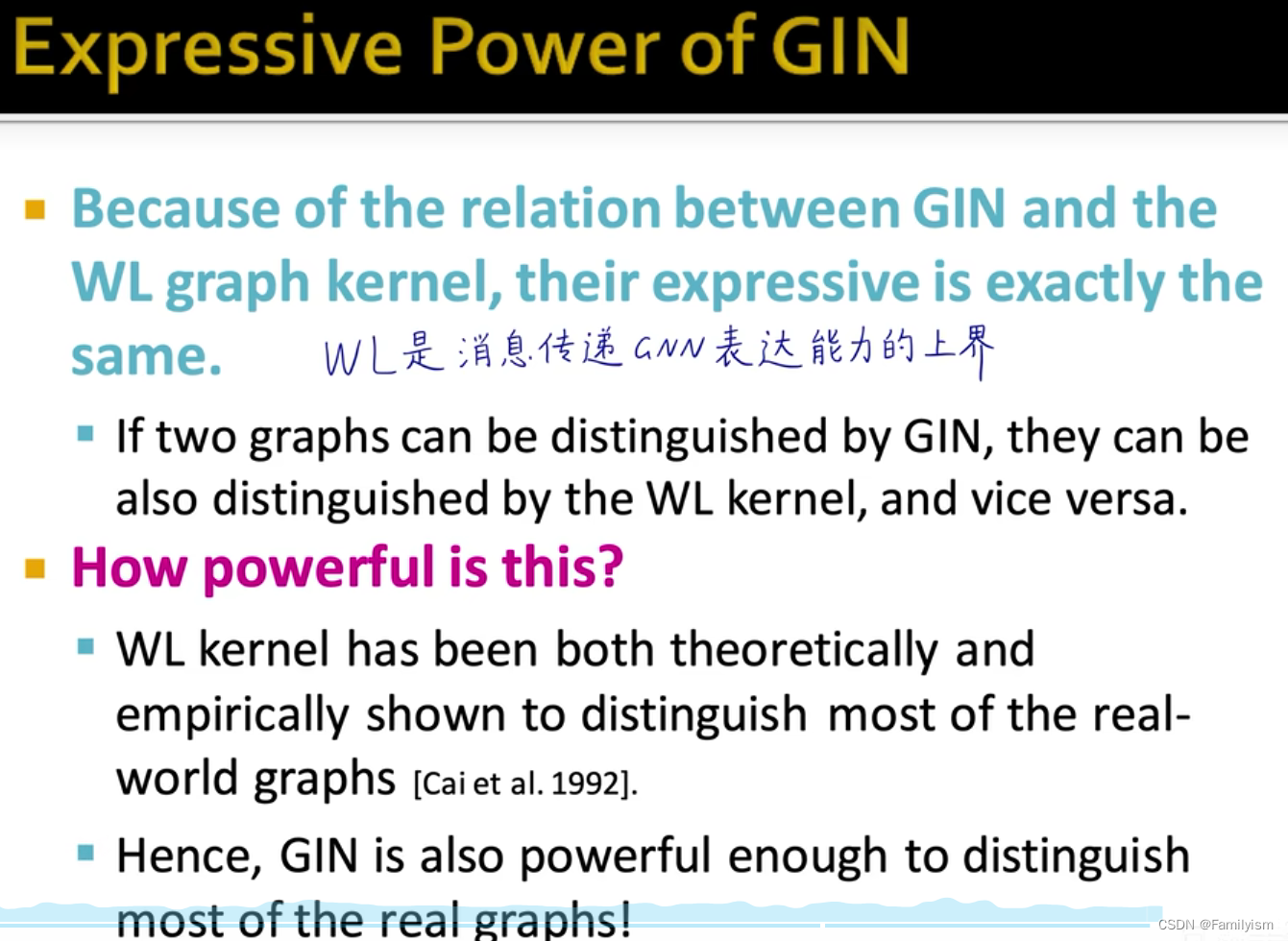

图神经网络GNN的表达能力

回顾 图卷积神经网络GCN GNN概要 神经网络的表达能力 分类or回归 神经网络的表达能力举例: 深度学习的理论基础和上限 GNN的表达能力 定义:图神经网络的表达能力就是它区分不同图的区分能力 分析常见的GNN的表达能力并设计出表达能力最强的GNN

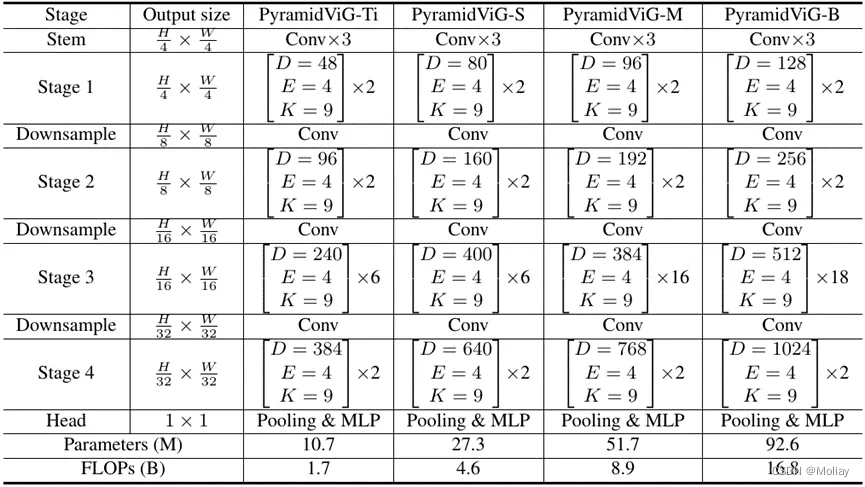

Vision GNN: An Image is Worth Graph of Nodes

感受野:在卷积神经网络中,感受野(Receptive Field)是指特征图上的某个点能看到的输入图像的区域,即特征图上的点是由输入图像中感受野大小区域的计算得到的。 感受野并非越大越好,反而可能因为过大而过于发散梯度下降(Gradient Descent GD):简单来说就是一种寻找目标函数最小化的方法,它利用梯度信息,通过不断迭代调整参数来寻找合适的目标值。超参数:在机器学习的上下文中,超参数

图神经网络GNN预训练技术进展概述

来源:图与推荐本文约2800字,建议阅读5分钟本文为大家推荐四篇有关于GNN预训练的文章。 论文推荐 /introduction/ 机器学习的成功很大程度上取决于数据。但是,高质量的标记数据通常很昂贵且难以获得,尤其是对于训练参数较多的模型。而我们却可以很容易地获取大量的无标记数据,其数量可能是标记数据的数千倍。 为了解决标注数据较少的问题,我们要尽可能利用其无标注数据,一个常规的做法是自监督

Michael Brostein 最新几何深度学习综述:超越 WL 和原始消息传递的 GNN

来源:AI科技评论本文约8500字,建议阅读15+分钟本文叫你如何突破基于 WL 测试和消息传递机制的 GNN 的性能瓶颈。 图可以方便地抽象关系和交互的复杂系统。社交网络、高能物理、化学等研究领域都涉及相互作用的对象(无论是人、粒子还是原子)。在这些场景下,图结构数据的重要性日渐凸显,相关方法取得了一系列初步成功,而一系列工业应用使得图深度学习成为机器学习方向的热门研究话题之一。 图

关于四篇GNN论文的阅读笔记PPT:包括GATNE,AM-GCN,HGSL和coGSL

关于四篇GNN论文的阅读笔记PPT:包括GATNE,AM-GCN,HGSL和coGSL 前言GATNEAM-GCNHGSLcoGSL 前言 这里的PPT主要是在跟Graph Transformer一起的: 【图-注意力笔记,篇章1】Graph Transformer:包括Graph Transformer 的了解与回顾且其与GNN、Transformer的关联【图-注意力笔记,

当GNN遇见NLP(十一):Directed Acyclic Graph Network for Conversational Emotion Recognition,ACL2021

同上一篇一样,是使用图建模对话情绪识别的论文。本文提出了用有向无环图(DAG)对对话进行编码的方法(DAG-ERC),主要借鉴了ICLR2021发表的工作DAGNN(Directed acyclic graph neural networks.)中的GNN改进策略。DAG-ERC在DAGNN的基础上进行了两个改进:(1)基于说话人身份的关系感知特征转换,以收集信息;(2)上下文信息单元,以增强历

GNN/GCN自己学习

一、图的基本组成 V:点(特征) E:边 U:图(全局特征) 二、用途 整合特征(embedding),做重构 三、邻接矩阵 以图像为例,每个像素点周围都有邻居,用邻接矩阵表示哪些点之间有关系,邻接矩阵A是对称的,也可以不对称 文本也可以做邻接矩阵: 实际是2xN, (source , target),要不然维护一个NxN太多了 四、使用场景 输入的格式不需要固定,是随