generalization专题

微调(fine-tuning)和泛化(generalization)

主要讨论两个主要方面:微调(fine-tuning)和泛化(generalization)。 文章目录 微调 Fine-tune泛化 Generalization 微调 Fine-tune 对于微调:选择合理的步骤(也就是迭代轮数或称为epochs),以获得良好的下游任务性能,但同时避免过拟合。微调是指在一个已经在大规模数据上预训练好的模型的基础上,针对特定任务领域的数据进行调

CVPR 2024 - Rethinking the Evaluation Protocol of Domain Generalization

CVPR 2024 - Rethinking the Evaluation Protocol of Domain Generalization 论文:https://arxiv.org/abs/2305.15253原始文档:https://github.com/lartpang/blog/issues/8 这篇文章主要讨论了领域泛化评估协议的重新思考,特别是如何处理可能存在的测试数据信息泄

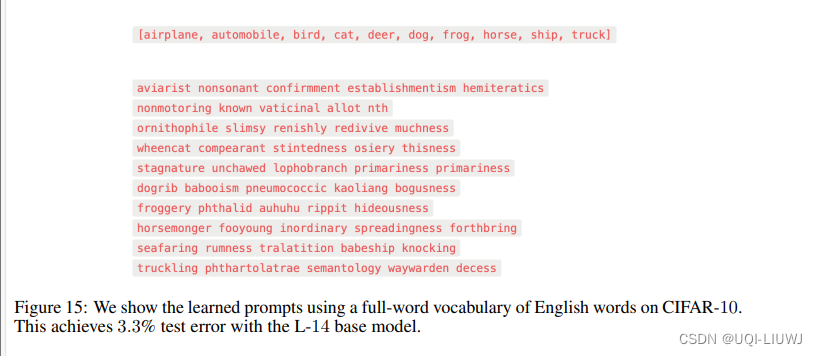

论文笔记:UNDERSTANDING PROMPT ENGINEERINGMAY NOT REQUIRE RETHINKING GENERALIZATION

ICLR 2024 reviewer评分 6888 1 intro zero-shot prompt 在视觉-语言模型中,已经取得了令人印象深刻的表现 这一成功呈现出一个看似令人惊讶的观察:这些方法相对不太受过拟合的影响 即当一个提示被手动工程化以在给定训练集上达到低错误率时(从而使得该方法实际上不再是零次学习),该方法在保留的测试数据上仍然表现良好。论文试图从理论上解释这一点 使用了经典的

论文解读:Rethinking Generalization in Few-Shot Classification

文章汇总 问题 ImageNet[38]这样流行的计算机视觉数据集总是给出单一标签来描述整张图片,而这样的标签只能正确地描述实际图像的一小部分,这不利于模型的训练;特别在测试期间,不属于训练类集合的实体,可能被认为是不相关的实体,很可能是测试类集合的一部分。 动机 参考文章近年来,小样本学习取得重大进展了吗? - 知乎 解决单label的annotation问题,比如 一张图60%

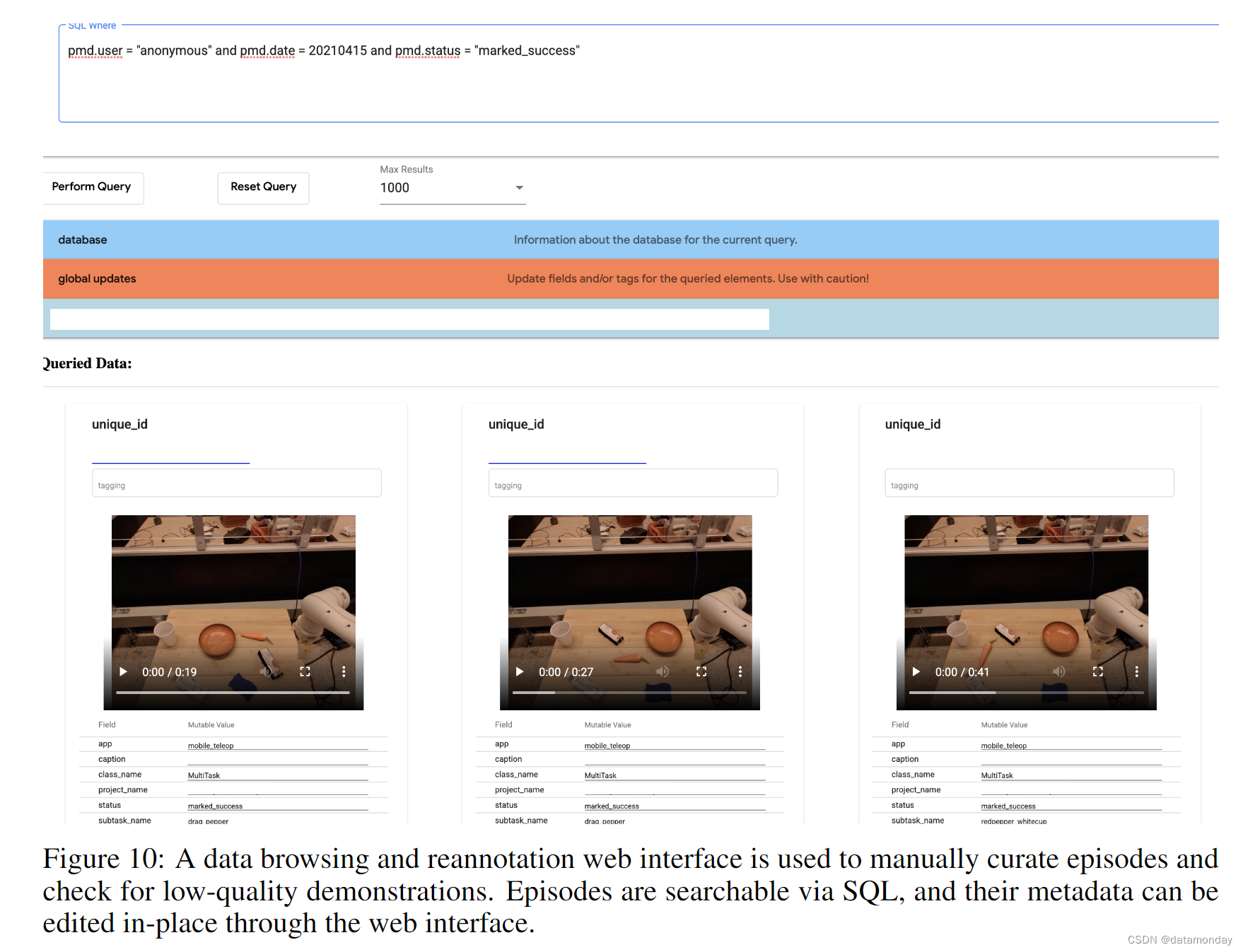

【EAI 013】BC-Z: Zero-Shot Task Generalization with Robotic Imitation Learning

论文标题:BC-Z: Zero-Shot Task Generalization with Robotic Imitation Learning 论文作者:Eric Jang, Alex Irpan, Mohi Khansari, Daniel Kappler, Frederik Ebert, Corey Lynch, Sergey Levine, Chelsea Finn 论文原文:https

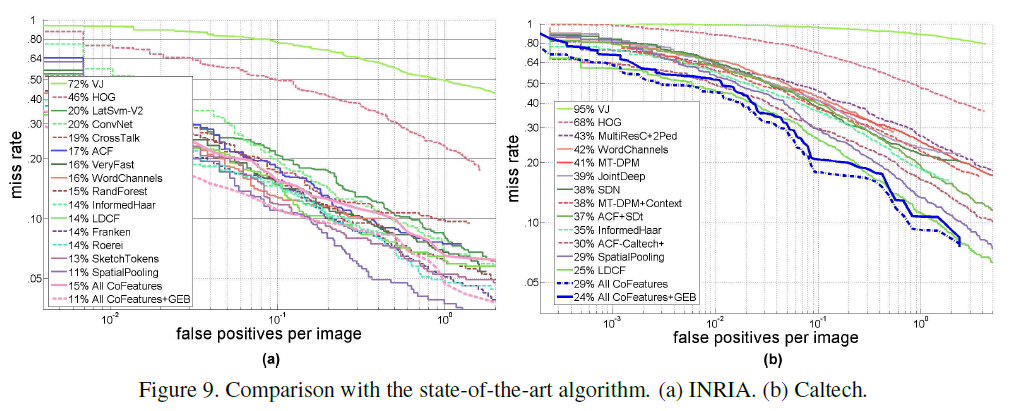

目标检测“Object Detection Using Generalization and Efficiency Balanced Co-occurrence Features”

ICCV15的文章,内容比较简单,但是boosting的方法,文章使用了Haar,HOG,LPB的共生特征,训练boosting时考虑了泛化和检测率平衡,让强特征在有高检测率的同时有好的推广性能。 特征的描述比较简单,这里使用了灰度共生矩阵的描述方法,将特征用共生的方法描述,即: 形式如下图所示: 泛化和检测平衡 好的特征对应低的分类错误率,即: 使用共生特征,离得远的图像对

weak-to-strong-generalization始终比母体更智能的人工智能,能否被它的母体所监管supervision,从而变的更强

正如supervison这个词,就像就是母亲对孩子的超级super愿景vision,比母亲更聪明更强,也就意味着要按照母亲期望的那样成长,不合理的行为要能够纠正supervison。 一代比一代强,一代比一代好。 弱模型监督能否激发出更强大模型的全部能力。 研究发现,虽然在弱监督下微调的强大模型确实能超越其弱监督者的表现,但仅靠弱监督并不能完全发挥出强大模型的潜能。 弱到强的泛化:研究表

UML用例图中包含(include)、扩展(extend)和泛化(generalization)三种关系详解

UML用例图中包含(include)、扩展(extend)和泛化(generalization)三种关系详解 共性:都是从现有的用例中抽取出公共的那部分信息,作为一个单独的用例,然后通后过不同的方法来重用这个公共的用例,以减少模型维护的工作量。 1、包含(include) 包含关系:使用包含(Inclusion)用例来封装一组跨越多个用例的相似动作(行为片断),以便多个

High-frequency Component Helps Explain the Generalization of Convolutional Neural Networks CNN泛华论文解读

通常情况下,CNN表现特征和肉眼可理解的特征存在一定的出入,在CNN泛化能力上难以理解。本文以CMU 的汪浩瀚、邢波等人《High-frequency Component Helps Explain the Generalization of Convolutional Neural Network》中进行阐述。 参考 https://zhuanlan.zhihu.com/p/24806820

ICCV2023领域泛化Domain Generalization相关论文

Domain Generalization即领域泛化,是近些年比较前沿的方向之一,顶会论文比较多。 Domain generalization deals with a challenging setting where one or several different but related domain(s) are given, and the goal is to learn a mo