gelu专题

YOLOv8改进 | 融合改进 | C2f融合Faster-GELU模块提升检测速度【完整代码 + 主要代码解析】

秋招面试专栏推荐 :深度学习算法工程师面试问题总结【百面算法工程师】——点击即可跳转 💡💡💡本专栏所有程序均经过测试,可成功执行💡💡💡 专栏目录 :《YOLOv8改进有效涨点》专栏介绍 & 专栏目录 | 目前已有100+篇内容,内含各种Head检测头、损失函数Loss、Backbone、Neck、NMS等创新点改进——点击即可跳转 本文介绍一种部分卷积(PConv)以

【深度学习】GELU激活函数是什么?

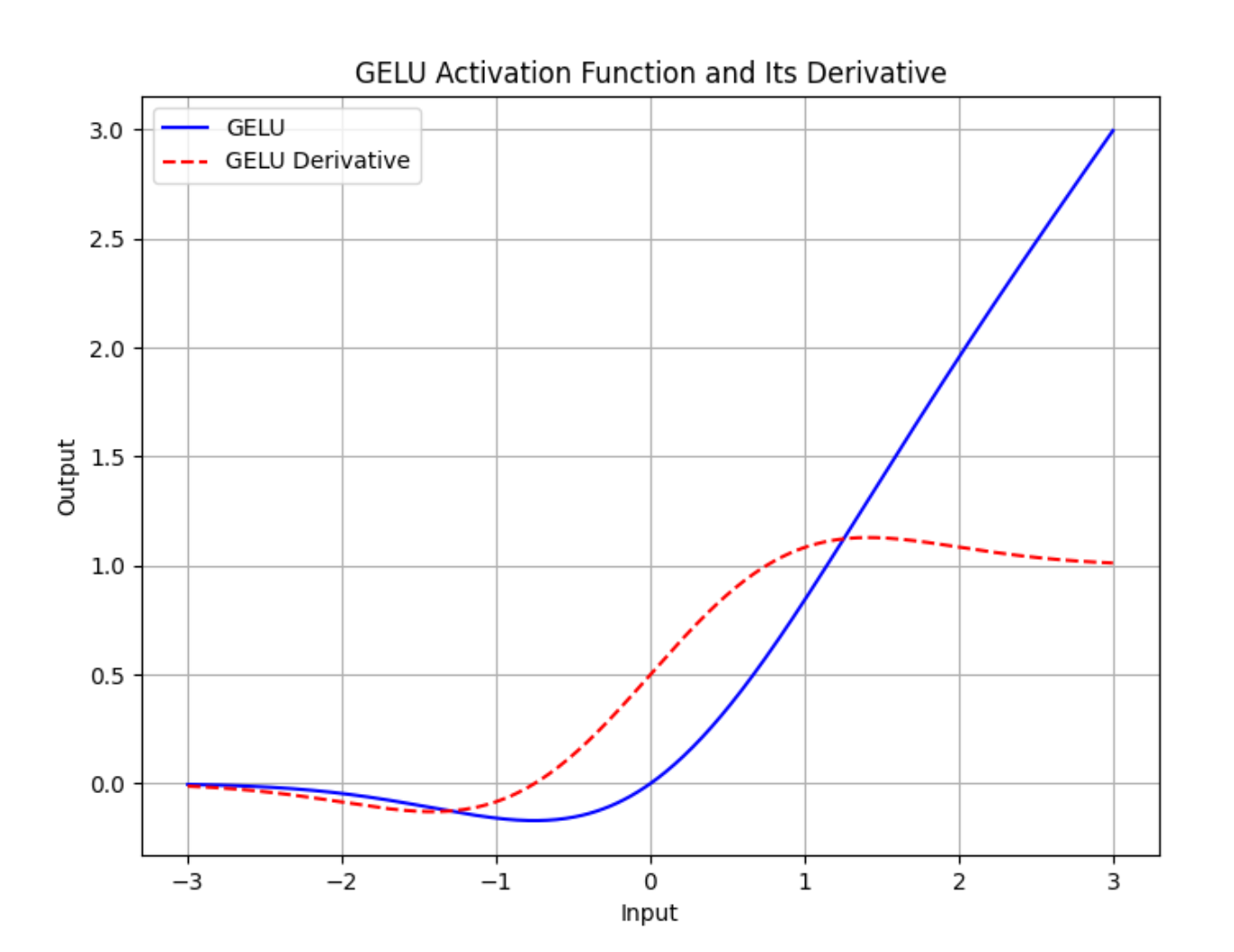

torch.nn.GELU 模块在 PyTorch 中实现了高斯误差线性单元(GELU)激活函数。GELU 被用于许多深度学习模型中,包括Transformer,因为它相比传统的 ReLU(整流线性单元)函数能够更好地近似神经元的真实激活行为。 概述 功能: 应用 GELU 激活函数。公式: GELU 激活函数可以表示为: GELU ( x ) = x ⋅ Φ ( x ) \text{GEL

[从0开始AIGC][Transformer相关]:Transformer中的激活函数:Relu、GELU、GLU、Swish

[从0开始AIGC][Transformer相关]:Transformer中的激活函数 文章目录 [从0开始AIGC][Transformer相关]:Transformer中的激活函数1. FFN 块 计算公式?2. GeLU 计算公式?3. Swish 计算公式?4. 使用 GLU 线性门控单元的 FFN 块 计算公式?5. 使用 GeLU 的 GLU 块 计算公式?6. 使用 Swis

激活函数GELU()

写的第一形象的有论文 从ReLU到GELU,一文概览神经网络的激活函数 写的第二形象的有论文 GELU 激活函数_乐享极客-CSDN博客_gelu “瘦身成功”的ALBERT,能取代BERT吗?_com GELU激活函数详解 - 知乎

GELU激活函数: 高斯误差线性单元

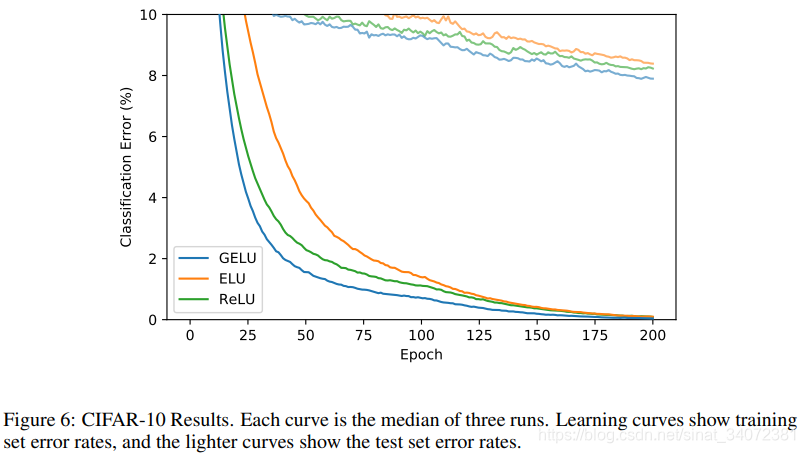

文章目录 引言GELU公式GELU实验 【Reference】 1. GAUSSIAN ERROR LINEAR UNITS (GELUS) 引言 早期网络使用二元阈值单元,sigmoid激活函数将二元阈值决策平滑,使得神经元可解释为发射率,并得以通过BP算法训练。随着网络深度增加,在训练神经网络时,sigmoid激活函数已被证实不如一些非平滑的非线性激活函数高效,如ReL

深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU、GELU等。

深度学习中常用的激活函数 1. Sigmoid函数2. Tanh函数3. ReLU函数4. LeakyReLU函数5. PReLU函数6. ELU函数:7. GELU函数: 深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU等。 1. Sigmoid函数 Sigmoid函数公式为 f ( x ) = 1 1 + e − x f(x)=

激活函数小结:ReLU、ELU、Swish、GELU等

文章目录 SigmoidTanhReLULeaky ReLUPReLUELUSoftPlus MaxoutMishSwishGELUSwiGLUGEGLU资源 激活函数是神经网络中的非线性函数,为了增强网络的表示能力和学习能力,激活函数有以下几点性质: 连续且可导(允许少数点上不可导)的非线性函数。可导的激活函数可以直接利用数值优化的方法来学习网络参数。激活函数及其导函数要尽

![[从0开始AIGC][Transformer相关]:Transformer中的激活函数:Relu、GELU、GLU、Swish](https://img-blog.csdnimg.cn/img_convert/b6acc964c165baeb1ebaad9ecdac1c8d.png)