cart专题

CART算法原理及Python实践

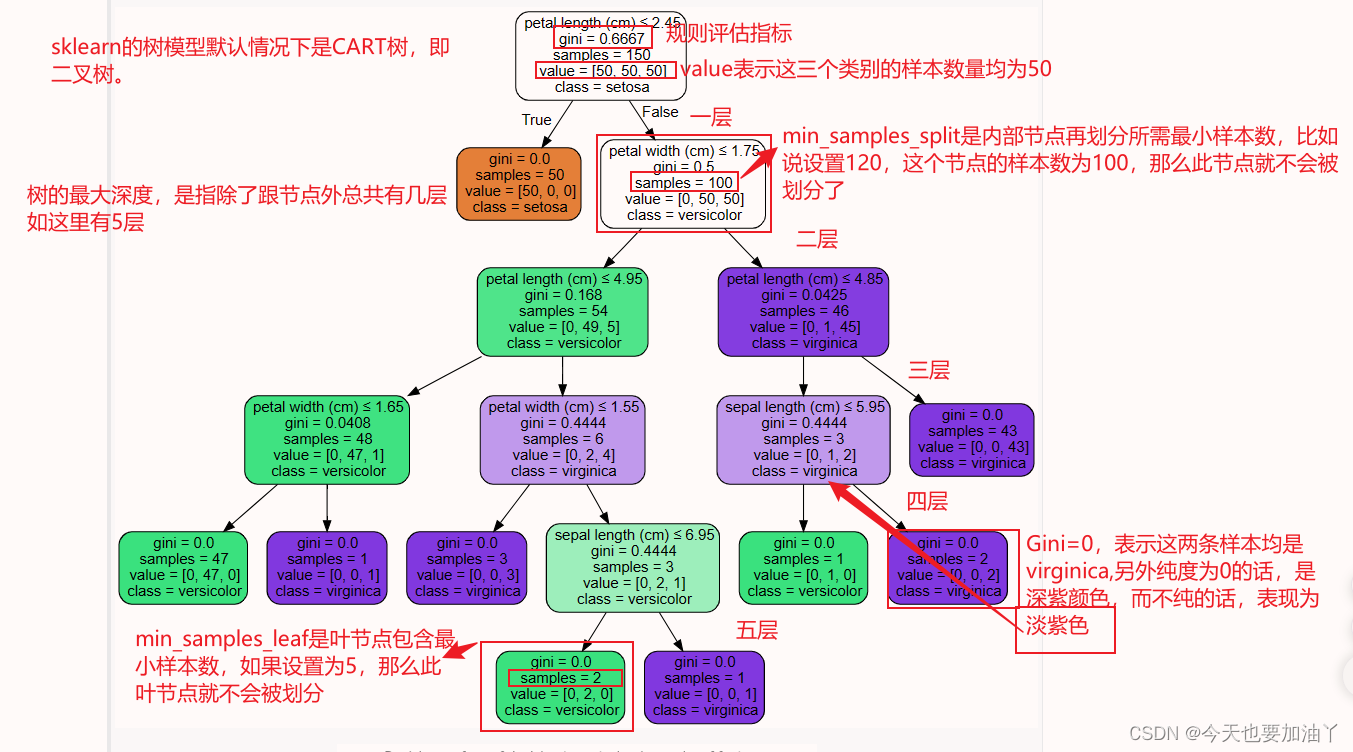

一、CART算法原理 CART(Classification And Regression Trees)算法是一种用于分类和回归任务的决策树学习技术。它采用贪心策略递归地划分数据集,以构建一棵二叉决策树。CART算法的原理可以概括为以下几个关键步骤: 1. 特征选择与数据划分 特征选择:CART算法在每次划分时,会选择最优的特征及其对应的划分点(对于连续特征)或划分值(对于离散特征)。对

《机器学习》决策树 C4.5算法、cart算法

一、什么是C4.5算法 1、概念 C4.5算法是一种决策树生成算法,它使用信息增益比(gain ratio)来选择最优分裂属性,它是ID3算法的改进版本。 C4.5算法的核心思想是选择信息增益比最大的特征作为节点进行划分,以获得最好的分类能力。它使用熵来度量数据集的不确定性,通过计算特征的信息增益来评估特征对分类的贡献程度。信息增益比越大,表示该特征对分类的影

CART决策树-基尼指数(全网最详解)

文章目录 一、基尼指数的定义二、基尼指数在CART决策树中的应用三、基尼指数与CART决策树的构建1.计算每个子集的基尼系数:2.计算基尼指数3.选择最优特征4.其余基尼指数5.构建决策树 四、总结 CART决策树基尼指数是CART(Classification And Regression Tree)算法中用于分类任务的一种评估指标,主要用于衡量数据集的不纯度或不确定性。以下是关于

模式识别十一--分类回归决策树CART的研究与实现

文章转自:http://www.kancloud.cn/digest/prandmethod/102853 摘 要:本实验的目的是学习和掌握分类回归树算法。CART提供一种通用的树生长框架,它可以实例化为各种各样不同的判定树。CART算法采用一种二分递归分割的技术,将当前的样本集分为两个子样本集,使得生成的决策树的每个非叶子节点都有两个分支。因此,CART算法生成的决策树是结构简洁的二叉树。在

CART 算法【python,机器学习,算法】

CART(Classification and Regression Tree)分类回归树。使用基尼指数计算得到树的节点。基尼指数表示系统整体的不确定性, 不确定性越大,基尼指数越大,所以在决策树中,将加权基尼系数最小的特征作为树的决策节点。 公式推导 基尼指数 g i n i ( A ) = 1 − ∑ i ∈ ( y , n ) p i 2 gini(A)=1-\sum\limits_{

CART,GBDT,XGBoost

回归树=》GBDT=》XGBoost 回归树(Reression Decision Tree) 一个例子 训练数据中臂长,年龄,体重为特征变量X,身高为标签值Y,下面开始种树 臂长(m)年龄(岁)体重(kg)身高(m)(标签值)0.55201.10.77301.30.921701.7 回归树算法流程 补充: 梯度提升树( Gradient Boosting Deci

使用matlab实现决策树cart算法(基于fitctree函数)

使用的是matlab自带的fitctree函数,也就是classregtree函数(老版本),函数用法一致。 看了网上别人的教程都乱七八糟的,也没有注释,所以自己写了一个。 数据直接用的matlab里自带的举例用数据,所以代码直接复制到maltab里即可运行。 大家有更好的想法或疑问欢迎留言交流。 %% Created by Indiffer %数据预处理 load ionosphere;

Shark源码分析(八):CART算法

Shark源码分析(八):CART算法 决策树算法是机器学习中非常常用的一种算法。在我关于机器学习的博客中有对决策树算法进行详细的介绍。在Shark中,只实现了CART这一种类型的决策树,它可以用于分类任务或是回归任务中。在这里我们只对其中有关分类任务的部分代码进行分析。 CARTClassifier类 这个类用于定义决策树,该类定义在文件<include/shark/Models/Tree

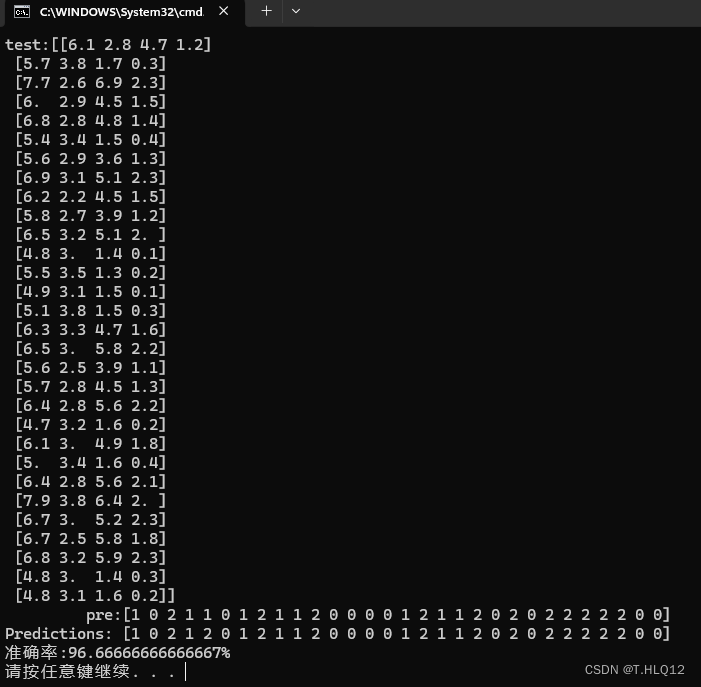

机器学习作业3____决策树(CART算法)

目录 一、简介 二、具体步骤 样例: 三、代码 四、结果 五、问题与解决 一、简介 CART(Classification and Regression Trees)是一种常用的决策树算法,可用于分类和回归任务。这个算法由Breiman等人于1984年提出,它的主要思想是通过递归地将数据集划分为两个子集,然后在每个子集上继续划分,直到满足某个停止条件为止。 CART算法在分

[机器学习] 第四章 决策树 1.ID3(信息增益) C4.5(信息增益率) Cart(基尼指数)

参考:https://www.cnblogs.com/liuq/p/9927580.html 参考:https 文章目录 一、ID3 算法信息熵🌟信息增益互信息与信息增益的关系例子优缺点 停止分裂的条件Python代码 二、 C4.5 算法🌟信息增益率 三、Cart🌟基尼指数例子🍇 数据集的选取🍇

机器学习:决策树cart算法

代码如下: from sklearn.feature_extraction import DictVectorizerfrom sklearn import preprocessingimport csvDtree = open(r'西瓜数据集3.0.csv', 'r')reader = csv.reader(Dtree)"""色泽 1-3代表 浅白 青绿 乌黑 根蒂 1-3代表 稍

决策树——(三)决策树的生成与剪枝CART

前面两篇文章分别介绍了用ID3和C4.5这两种算法来生成决策树。其中ID3算法每次用信息增益最大的特征来划分数据集,C4.5算法每次用信息增益比最大的特征来划分数据集。下面介绍另外一种采用基尼指数为标准的划分方法,CART算法。 1. CART算法 分类与回归算法(Classification and Regression Tree,CART),即可以用于分类也可以用于回归,是应用广泛的决策树

决策树算法ID3,C4.5, CART

决策树是机器学习中非常经典的一类学习算法,它通过树的结构,利用树的分支来表示对样本特征的判断规则,从树的叶子节点所包含的训练样本中得到预测值。决策树如何生成决定了所能处理的数据类型和预测性能。主要的决策树算法包括ID3,C4.5, CART等。 1,ID3 ID3是由 Ross Quinlan在1986年提出的一种构造决策树的方法。用于处理标称型数据集,其构造过程如下: 输入训练数据是一组带

决策树和CART决策树

首先简单介绍下决策树: 说到决策树肯定离不开信息熵 什么是信息熵(不要被这名字唬住,其实很简单)? 一个不太可能的时间居然发生了,要比一个非常可能的时间发生提供更多的信息。消息说:“今天早上太阳升起”。信息量是很少的,以至于没有必要发送。但另一条消息说:“今天早上日食”。信息量就很丰富。 概率越大信息量就越少,与概率成反比 1p \frac{1}{p} I(x)=logP(x)−1=−

经典决策树算法(ID3、C4.5、CART)原理以及Python实现

1 决策树简介 决策树(Decision Tree),是每个分支都通过条件判断进行划分的树,是解决分类和回归问题的一种机器学习算法,其核心是一个贪心算法,它采用自顶向下的递归方法构建决策树。 1.1 决策树模型 决策树模型是一种对实例进行分类的树,由节点(node,由圆框表示)和有向边(directed edge,由方框表示)组成,其中节点分为内部节点(internal node)和叶子

CART回归树算法过程

CART决策树算法是一种分类及回归树算法,既可以用于分类,也可以用于回归。但是在李航老师的《统计学习方法》一书中,并没有详细介绍回归树,更多的是介绍分类树,所以有必要对CART回归树进行简单介绍,有利于对CART树用于回归的操作,因为后续GBDT算法也是在CART回归树的基础上进行的,所以深入理解CART回归树非常重要。 回归树:使用平方误差最小准则 训练集为:D={(x1,y1), (x2,

GEE:CART(Classification and Regression Trees)回归教程(样本点、特征添加、训练、精度、参数优化)

作者:CSDN @ _养乐多_ 对于分类问题,这个输出通常是一个类别标签 ,而对于回归问题,输出通常是一个连续的数值。回归可以应用于多种场景,包括预测土壤PH值、土壤有机碳、土壤水分、碳密度、生物量、气温、海冰厚度、不透水面积百分比、植被覆盖度等。 本文将介绍在Google Earth Engine (GEE)平台上进行CART(Classification and Regression Tr

机器学习算法之分类和回归树(CART)

分类和回归树(Classification and Regression Trees,CART)是一种强大的机器学习算法,用于解决分类和回归问题。本篇博文将深入介绍CART算法的工作原理、应用领域以及Python示例。 算法背景 CART算法最早由Leo Breiman等人于1984年提出,它是一种决策树算法,用于将数据集划分成多个子集,每个子集内的数据具有相似的特性。CART算法可以用于分类

分类回归——CART分类与回归以及Python实现

CART分类与回归树本质上是一样的,构建过程都是逐步分割特征空间,预测过程都是从根节点开始一层一层的判断直到叶节点给出预测结果。只不过分类树给出离散值,而回归树给出连续值(通常是叶节点包含样本的均值),另外分类树基于Gini指数选取分割点,而回归树基于平方误差选取分割点。 CART分类树: 核心思想:以特征及对应特征值组成元组为切分点,逐步切分样本空间 基本概念: 基尼指数(Gini):样

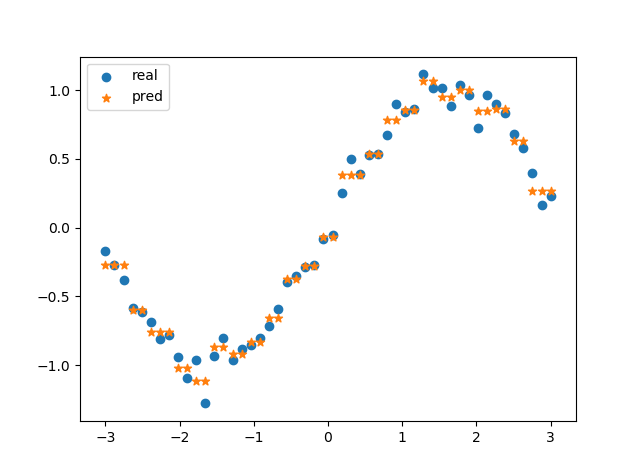

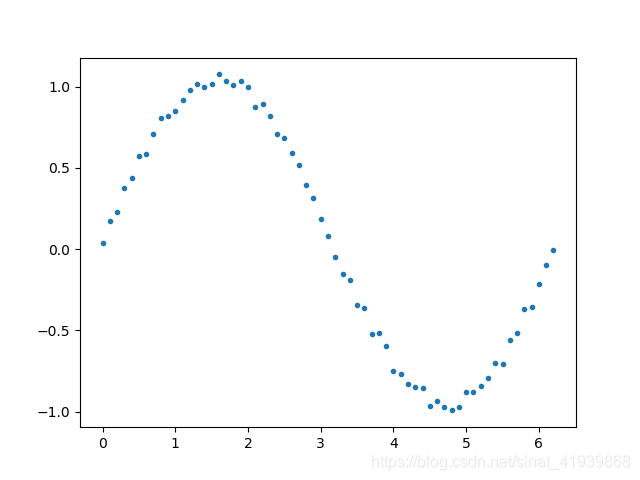

决策树(二):CART回归树与Python代码

上一篇介绍了决策树的基本概念,特征划分标准及ID3、C4.5和CART分类树的算法,本文着重对CART回归树的内容进行补充。 本文概览: 首先介绍CART回归树的算法,然后是创建CART回归树的主要步骤,最后是实现该过程的Python代码。 一、CART回归树算法 CART回归树处理的是回归问题,数据集的标签不再是离散的类别值,而是一系列的连续值的集合。 CART回归树不同于线性回归模型,不

决策树:ID3、C4.5、CART算法与Python实现

一、决策树的基本概念 决策树(Decision Tree)算法是一类常用的机器学习算法,在分类问题中,决策树算法通过样本中某一些属性的值,将样本划分到不同的类别中。 决策树跟人在做决策的思考方式很想像,先考虑重点选项,不符合则可最优先做出决策。

DataWhale-树模型与集成学习-Task02-Cart分类树代码实现-202110

助教老师实现了Cart回归树,在老师代码的基础上,实现了Cart分类树,代码如下: import numpy as npdef Gini(y):gn=1.0n=y.shape[0]for i in np.unique(y):gn=gn-(np.sum(y==i)/n)**2return gndef argmax(y):l=sorted([(np.sum(y==i),i) for i in

机器学习算法-分类回归树CART

本文转载http://www.cnblogs.com/zhangchaoyang/articles/2709922.html 分类回归树(CART,Classification And Regression Tree)也属于一种决策树,上回文我们介绍了基于ID3算法的决策树。作为上篇,这里只介绍CART是怎样用于分类的。 分类回归树是一棵二叉树,且每个非叶子节点都有两个孩子,所以对于第

GEE——使用cart机器学习方法对Landsat影像条带修复以NDVI和NDWI为例(全代码)

简介 之前发表了两篇关于影像修复的文章,并且制作了APP,大家可以去看以下的两篇博客来了解具体的研究内容和整个方法的有效性: Google Earth Engine APP——影像条带色差、色调不均匀等现象解决方案Landsat5 NDWI Image Restoration APP_ndwi不能识别泛红水体怎么办-CSDN博客 基于GEE云平台一种快速修复Landsat影像条带色差的方法_