batchnormalization专题

BatchNormalization和Layer Normalization解析

Batch Normalization 是google团队2015年提出的,能够加速网络的收敛并提升准确率 1.Batch Normalization原理 图像预处理过程中通常会对图像进行标准化处理,能够加速网络的收敛,如下图所示,对于Conv1来说输入的就是满足某一分布的特征矩阵,但对于Conv2而言输入的feature map就不一定满足某一分布规律了(注意这里所说满足某一分布规律并不是

批量规范化(batchnormalization)

µ ˆB 是小批量B的样本均值,σˆ B 是小批量B的样本标准差。应用标准化后,生成的小批量的平均 值为0和单位方差为1。由于单位方差(与其他一些魔法数)是一个主观的选择,因此我们通常包含 拉伸参数(scale)γ和偏移参数(shift)β, 请注意,γ和β是需要与其他模型参数一起学习的参数。 “魔法参数”来规范化或调整模型的行为。这些参数通常不是通过数据或者明确的推断得出,而是根据经验

Normalization,LayerNormalization和BatchNormalization

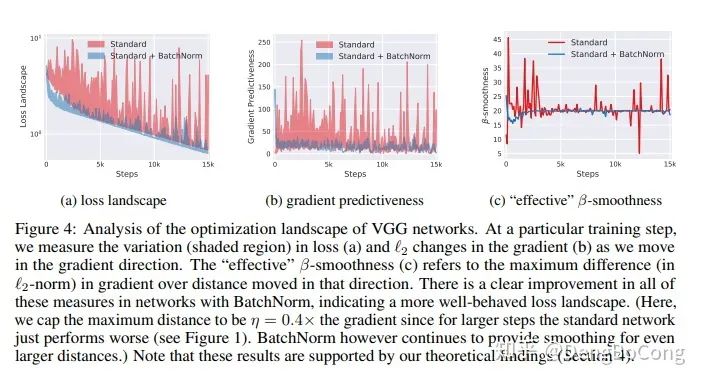

前言 假设我们的损失函数在空间中是一个曲面,这个曲面可以被我们人为的切出等高线,在采用梯度下降算法的时候,我们沿着梯度反方向迭代(梯度方向与等高线垂直),到最后我们会抵达上图曲面的最低点。 在上面的两幅图中忽略坐标值,观察损失函数曲面在空间中的形状,把它们比作山坡,我们人在山顶,很明显左图下山的路一眼就能看清,右图下山的路需要边走边观察改变下山路线,一般的情

对 BatchNormalization 中 Internal Convariate Shift 的理解

前言:写的不好,主要解释了对内部协变量漂移(Internal Convariate Shift)的理解。 之前对BatchNormalization的理解不是很透彻,在搭建神经网络的时候也没有很注意去使用,今天集中搜索整理了下Batch Normalization的相关资料,才知道BatchNormalization的重要性,并不是用了Relu激活函数,BatchNormalization就

ImportError: cannot import name ‘BatchNormalization‘ from ‘keras.layers.normalization‘

版本问题 解决方案:将from keras.layers.normalization import BatchNormalization 改成from keras.layers.normalization.batch_normalization_v1 import BatchNormalization

pytorch 与 BatchNormalization

BatchNormallization是神经网络中的一个正则化技术,可以加速网络的收敛,并且在一定程度上解决深度网络“梯度弥散”的问题。它本是数据预处理的一种方法,google的研究人员将它应用在了神经网络中。论文地址:https://arxiv.org/abs/1502.03167 理论 pytorch batch normalization: http://pytorch.org/doc

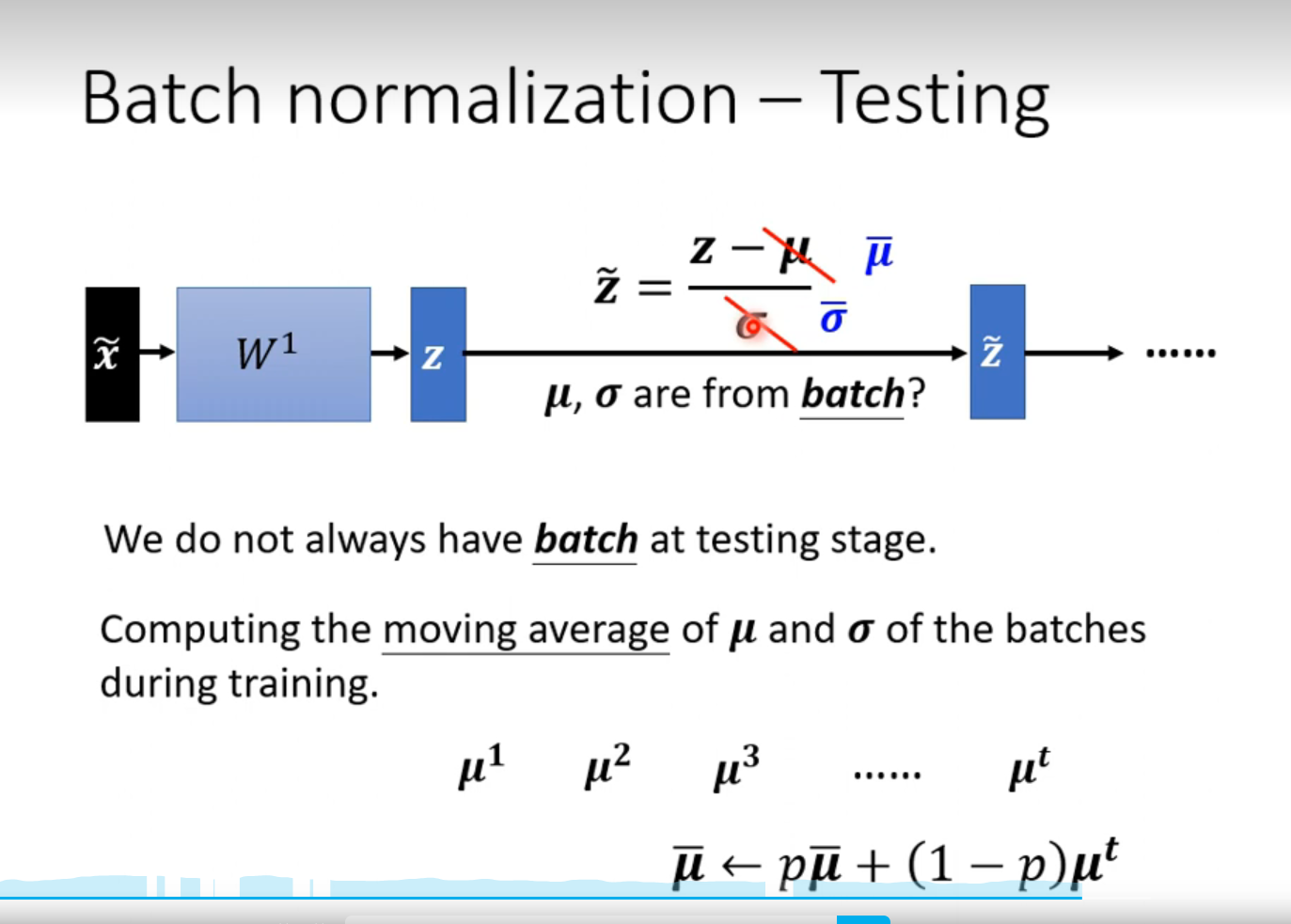

P48类神经网络训练不起来怎么办- BatchNormalization

背景 batch normalization --> 目标把山铲平-- > 可以得到更好的error surface ,让 training 更容易。 W2 很大,W2 的一点变化,能引起较大的梯度值,W1,很小,对梯度的影响比较小,两者的影响不平衡,为了保证影响力一样,将她们缩放到同样的范围 BN z的数值范围也不一样,也要进行归一化 Testing 用训练时的 mu

【tensorflow】slim模块中fine-tune中的BatchNormalization的设置

tensorflow的BatchNorm 应该是tensorflow中最大的坑之一。大家遇到最多的问题就是在fine-tune的时候,加载一个预模型然后在训练时候发现效果良好,但是在测试的时候直接扑街。 这是因为batch normalization在训练过程中需要去计算整个样本的均值和方差,而在代码实现中,BN则是采取用移动平均(moving average)来求取批均值和批方差来,所以在每一

深度学习4:BatchNormalization(批规范化)

一、起源 训练深度网络的时候经常发生训练困难的问题,因为,每一次参数迭代更新后,上一层网络的输出数据经过这一层网络计算后,数据的分布会发生变化,为下一层网络的学习带来困难。 Batch Normalizatoin 之前的解决方案就是使用较小的学习率,和小心的初始化参数,对数据做白化处理,但是显然治标不治本。 Batch Normalization是在每个mini-batch进行归一化操作

Course2-week3-hyperparameterTuning - BatchNormalization - Framework

hyperparameter tuning 1 - tuning process How to systematically organize hyperparameters tuning process? hyperparameters learning rate α α \alpha β β \beta in momentum, or set the default 0.9min