本文主要是介绍Phn2vec Embeddings,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

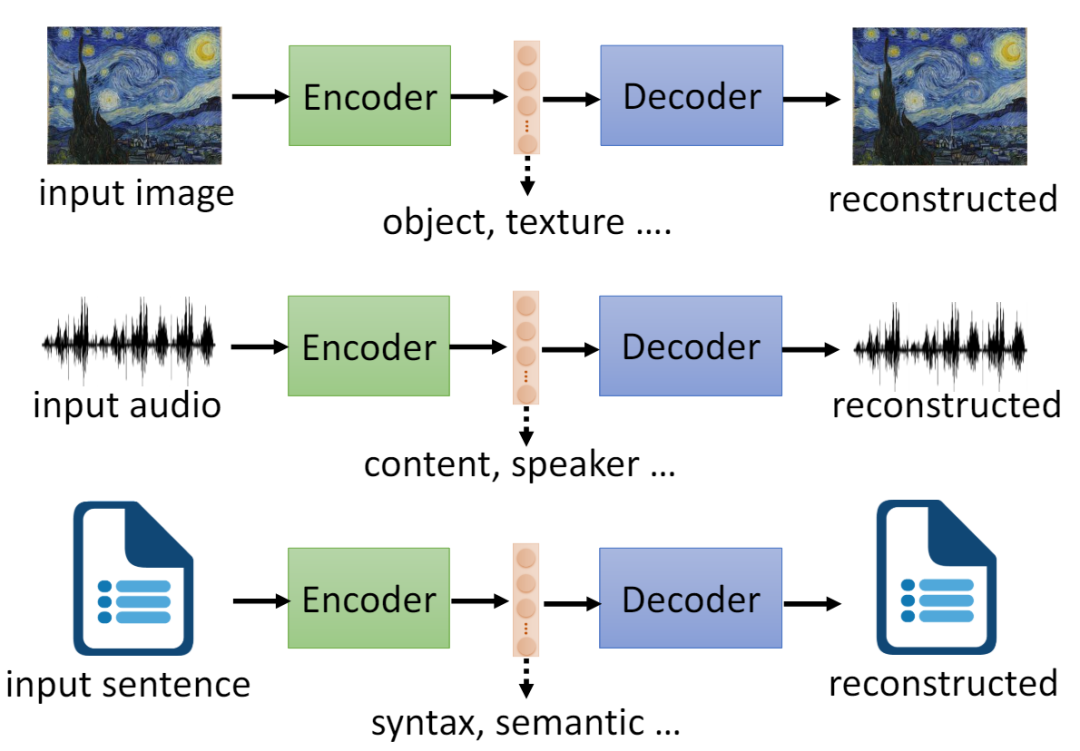

昨天在我爱机器学习上看到Ph2vec,由于自己弄过google的word2vec,出于敏感啊。觉得这个比较好,如果大家想发论文就可以去弄个啊。这种音素转成向量空间。现在翻译在以下:

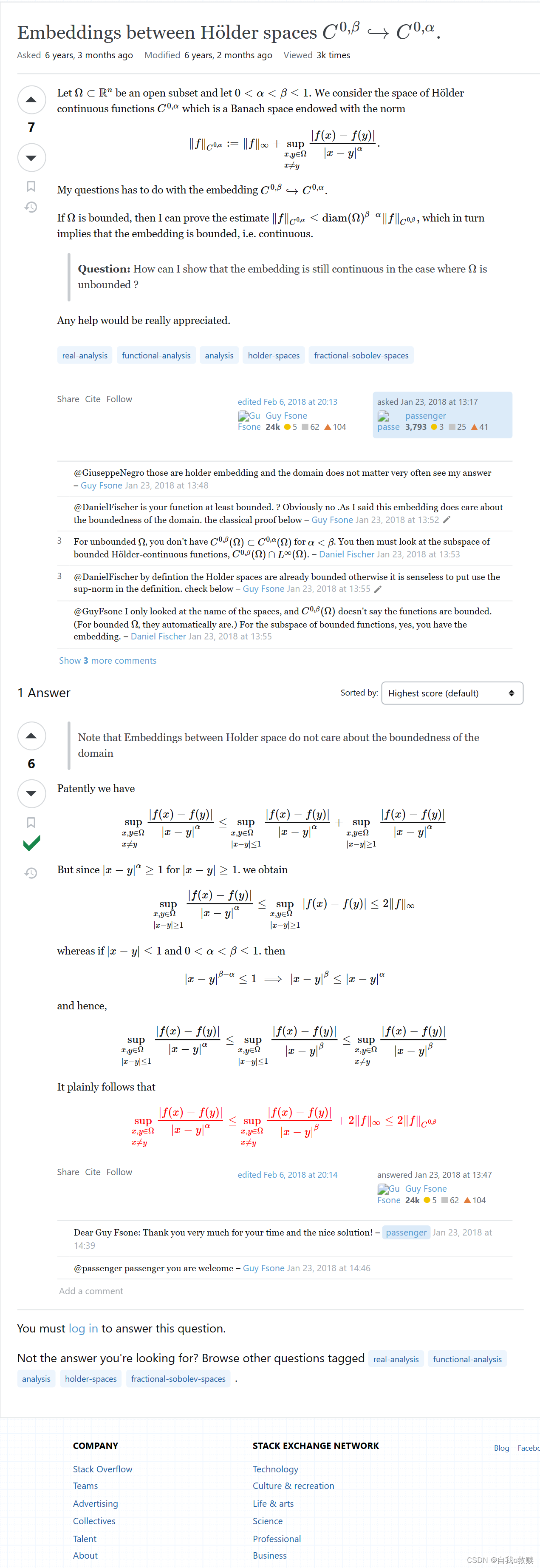

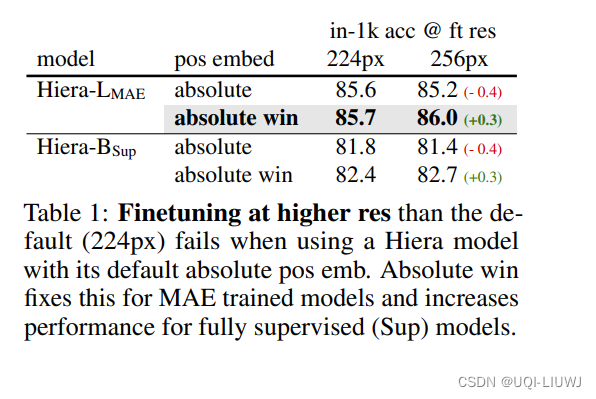

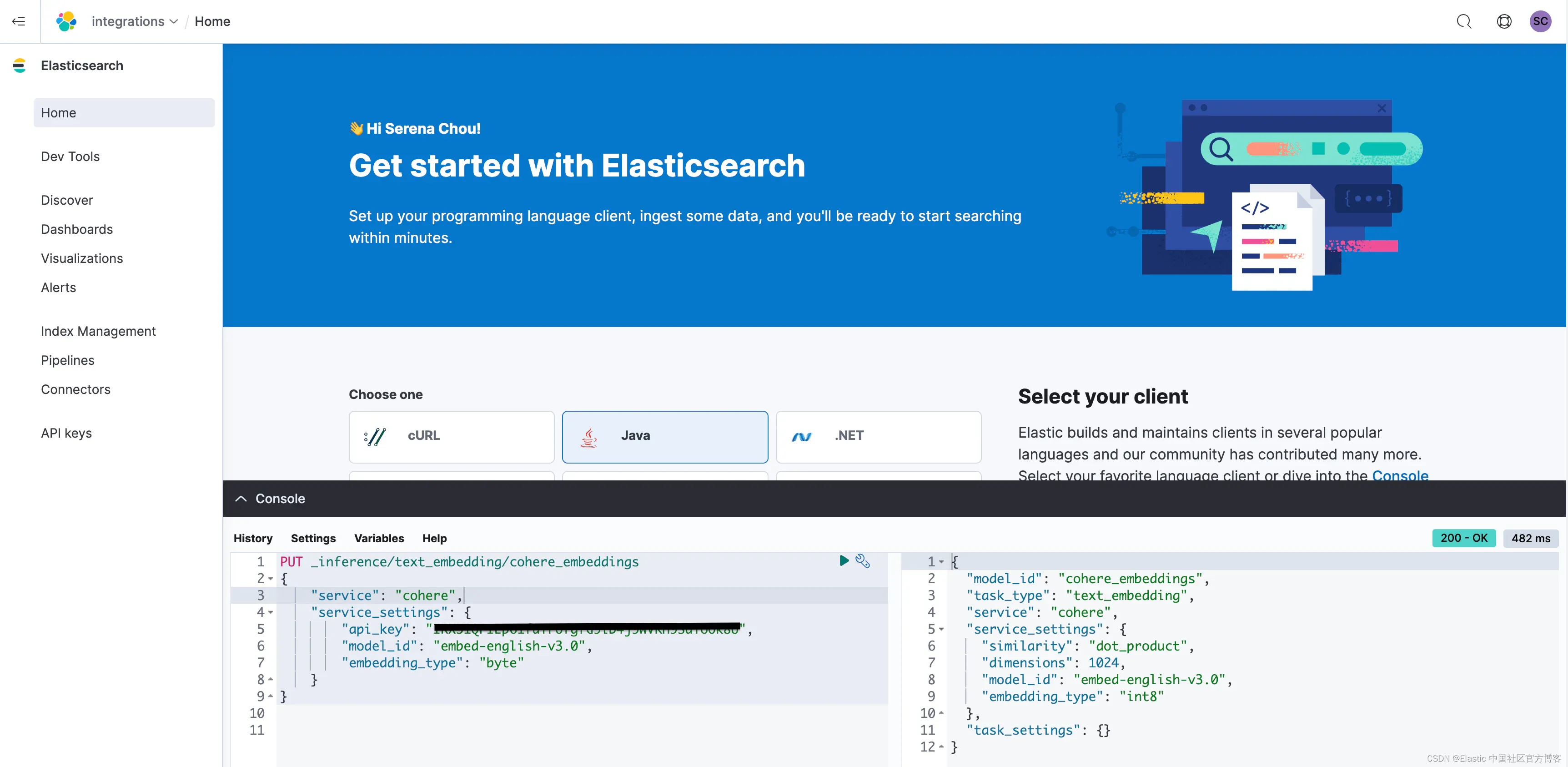

备注:因为csdn上公式和图什么的都不是很方面。呵呵……直接把word生成图片了。 呵呵……

这篇关于Phn2vec Embeddings的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!