本文主要是介绍F.softmax(cls) + 1e-4,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

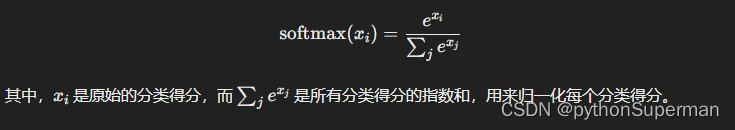

这个代码段中的 softmax 操作结合了一个微小的常数,这个常数通常被称为平滑化参数。softmax 函数将原始的分类输出转换为概率分布,其公式如下:

在实践中,当某些分类得分特别大时,softmax 函数会将对应的概率接近于 1,而其他分类的概率会接近于 0。这可能会导致模型在训练过程中对训练数据过度自信,增加了过拟合的风险。

为了减轻这种过拟合的可能性,可以在 softmax 操作中添加一个微小的常数(通常为 1e-4 或类似的小值),即在原始的分类得分中加上一个小的偏置。这样做的目的是使得模型对于分类得分的细微差异更加敏感,从而在一定程度上抑制过拟合的发生。

因此,这种平滑化操作有助于提高模型的鲁棒性,使得模型更加能够泛化到未见过的数据,并减少在训练集上过度拟合的可能性。

这篇关于F.softmax(cls) + 1e-4的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!