本文主要是介绍[深度学习论文笔记][arxiv 1805] Why do deep convolutional networks generalize so poorly to small image transf,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

[arxiv 1805] Why do deep convolutional networks generalize so poorly to small image transformations?

Aharon Azulay and YairWeiss

from Hebrew University of Jerusalem

paper link

Introduction

深度卷积网络在设计时采用了诸如max池化等模块来提高模型对输入图像中可能存在的微小平移、旋转和变形的鲁棒性。以期深度分类网络在面对人类可以轻松应对的图像变化时,也能有稳定的分类性能。

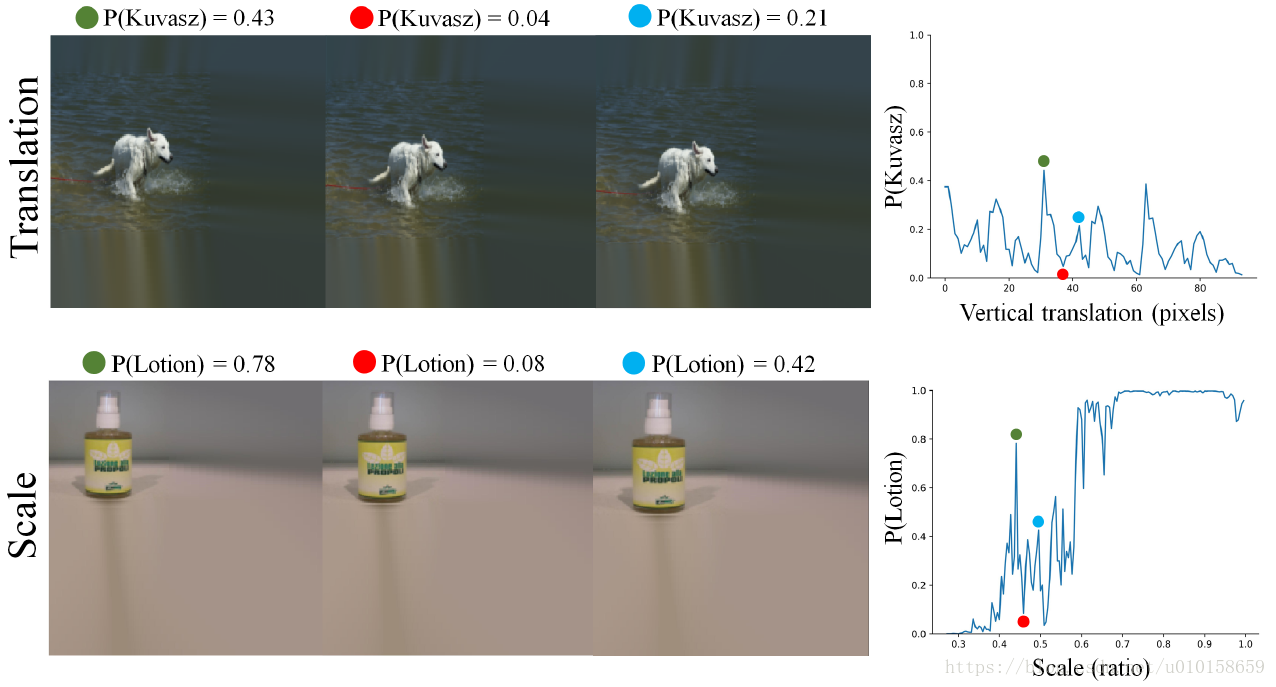

但是在作者的实验中,深度分类网络并没有表现出预期的性质。以在Imagenet数据库上预训练的InceptionResNet-V2模型为例,在一些肉眼难以感受的图像变化下,网络分类的置信概率会发生较明显的变化,如下图所示。同时对于越深的网络这种现象越显著,例如InceptionResNet-V2的现象显著于ResNet-50显著于VGG16。

这篇文章中,作者对深度卷积网络不能很好应对图像微小变化(重点在于微小平移)的原因做了两点猜测和探究:

- 网络自身结构(特别是降采样)的原因;

- 训练数据分布偏差的原因。

Ignoring the Sampling Thereom

作者认为第一点造成该现象的原因在于网络自身的结构。详细来说是在于网络中的降采样导致的。理论上讲,如果网络全是不带有步长(stride)的卷积操作,则输入像素在空间上的微扰也应该反映在输出特征上。即图像变化时,特征结果没有发生数值变化,而是仅仅随着在空间上相应的移动。但是网络中存在了具有步长的降采样操作后,如[1]中所说,输入信号必须在平移了降采样倍数整数倍的时候才能显示出特征的平移不变性。

这篇关于[深度学习论文笔记][arxiv 1805] Why do deep convolutional networks generalize so poorly to small image transf的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!