本文主要是介绍VW-LMM 统一多模态自回归建模框架,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

将自回归建模扩展到多模态场景以构建大型多模态模型(LMMs)时,存在一个很大的困难,即图像信息在 LMM 中被处理为连续的视觉嵌入,无法获得离散的监督标签用于进行分类损失计算。

该文首次成功地进行了采用统一目标的多模态自回归建模,并且进一步探讨了 LLMs 内部语义空间中视觉特征的分布以及使用文本嵌入来表示视觉信息的可能性。

论文题目:

Multi-modal Auto-regressive Modeling via Visual Words

论文地址:https://export.arxiv.org/abs/2403.07720

代码地址:https://github.com/pengts/VW-LMM

Hugging Face库:https://huggingface.co/MYTH-Lab/VW-LMM-Vicuna-7b

https://huggingface.co/MYTH-Lab/VW-LMM-Mistral-7b

https://huggingface.co/MYTH-Lab/VW-LMM-Vicuna-pif-7b

主流的 LMM 选择仅计算多模态交织序列中的语言部分的损失,将视觉信息视作上下文提示。另一类方法提出在训练阶段使用回归任务来预测下一个视觉特征的值,但其视觉和语言组件的不一致优化目标不利于统一的多模态自回归建模。

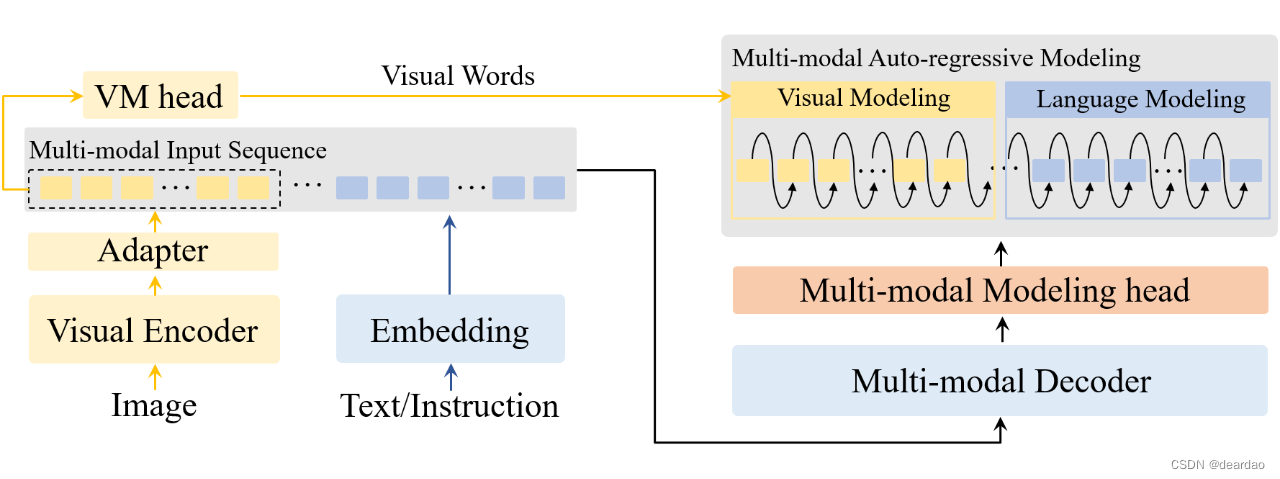

研究者提出了 VW-LMM(visual word large multi-modal model)。VW-LMM 引入了视觉词(visual words)的概念,用于构建视觉特征在LMM内部语义空间中的分布,为视觉建模(visual modeling)提供了监督信息。

一个视觉编码器(visual encoder),一个多模态解码器(multi-modal decoder),一个用于视觉-语言投影的适配器(adapter),一个用于多模态建模的多模态建模头(multi-modal modeling head,下称 MM head),以及与之对应的用于视觉建模的 VM head。

这篇关于VW-LMM 统一多模态自回归建模框架的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!