本文主要是介绍OpenCompass 大模型评测实战——作业,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

OpenCompass 大模型评测实战——作业

- 一、基础作业

- 1.1、使用 OpenCompass 评测 internlm2-chat-1_8b 模型在 C-Eval 数据集上的性能

- 1.1.1、安装基本环境

- 1.1.2、解压数据集

- 1.1.3、查看支持的数据集和模型

- 1.1.4、启动评测

- 二、进阶作业

- 2.1、将自定义数据集提交至OpenCompass官网

一、基础作业

1.1、使用 OpenCompass 评测 internlm2-chat-1_8b 模型在 C-Eval 数据集上的性能

1.1.1、安装基本环境

studio-conda -o internlm-base -t opencompass

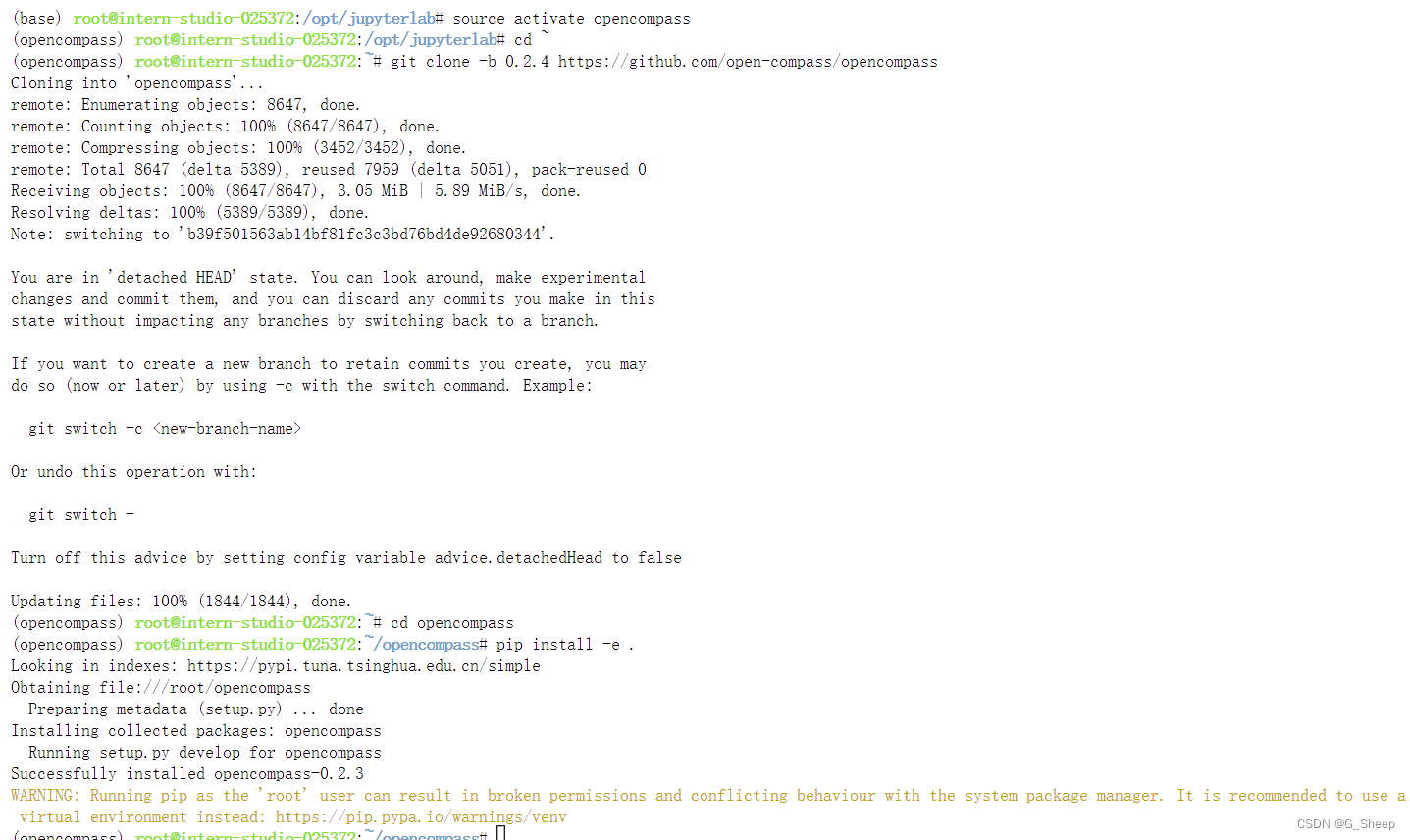

source activate opencompass

git clone -b 0.2.4 https://github.com/open-compass/opencompass

cd opencompass

pip install -e .# 如果pip install -e .安装未成功,请运行:

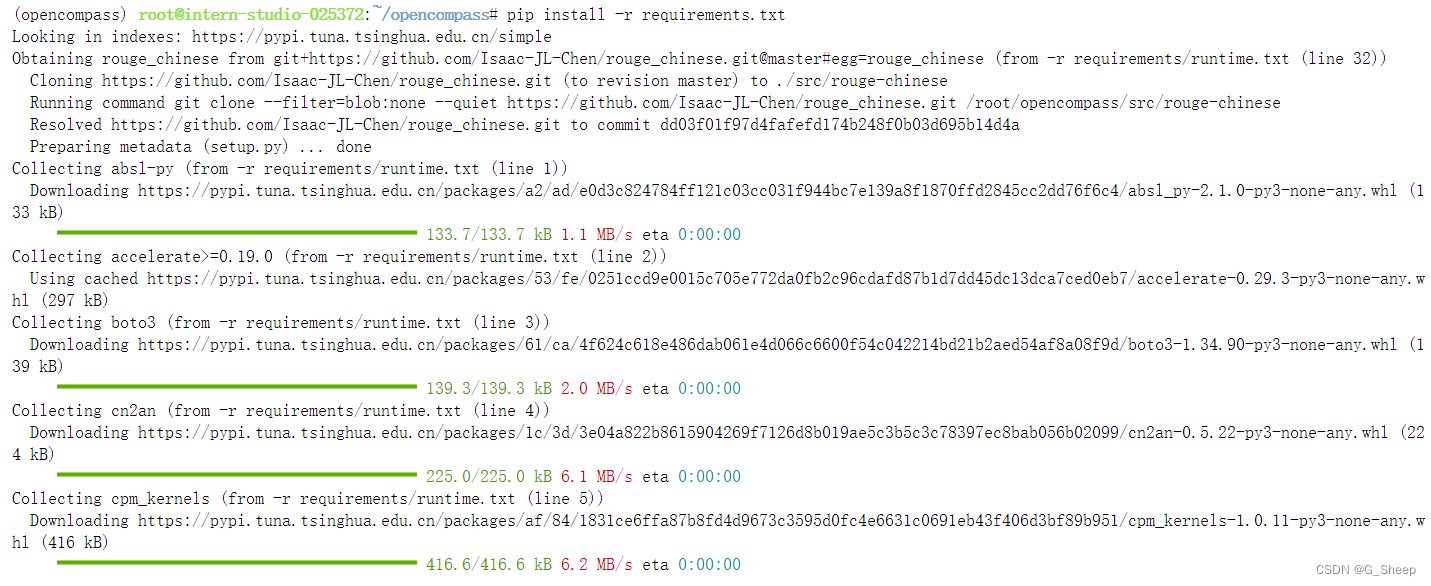

pip install -r requirements.txt

建议这边直接用 pip install -r requirements.txt 这个命令,pip install -e . 我使用的时候是运行成功了,但后面依然出现了对应包没有的问题。

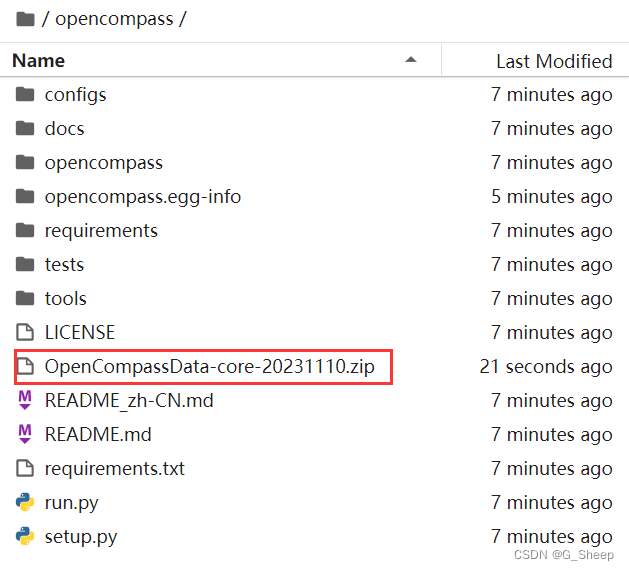

1.1.2、解压数据集

cp /share/temp/datasets/OpenCompassData-core-20231110.zip /root/opencompass/

unzip OpenCompassData-core-20231110.zip

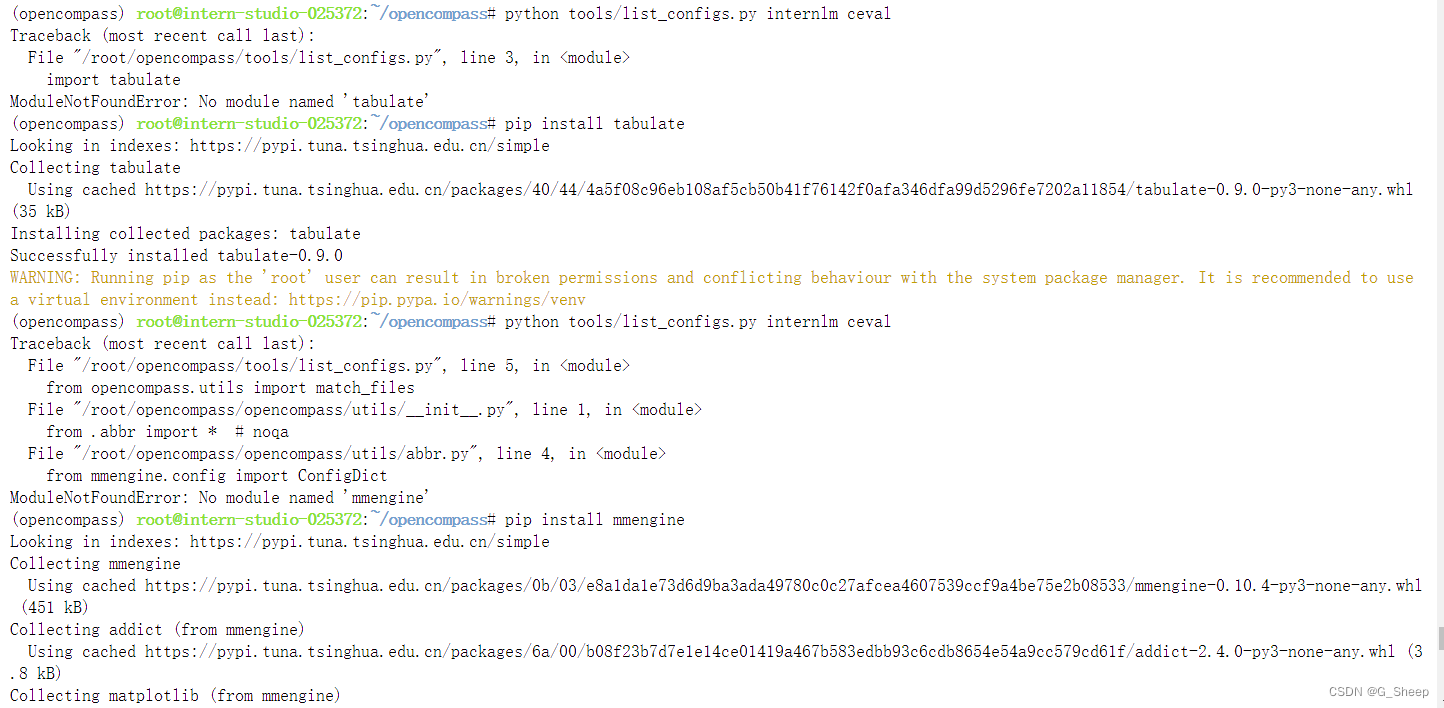

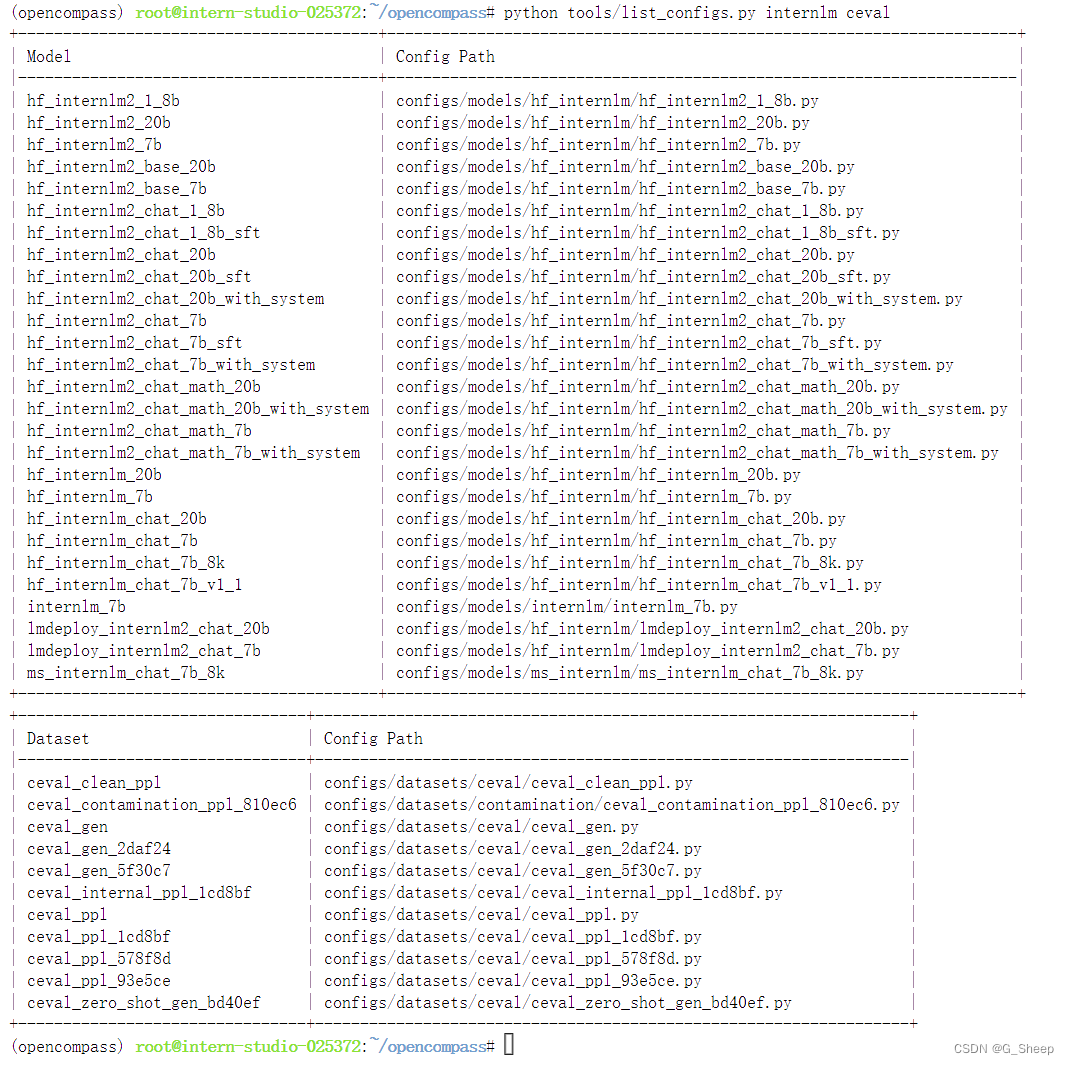

1.1.3、查看支持的数据集和模型

这边就出现了 tabulate 和 mmengine 这两个包没有的情况,那就 pip install 装上。

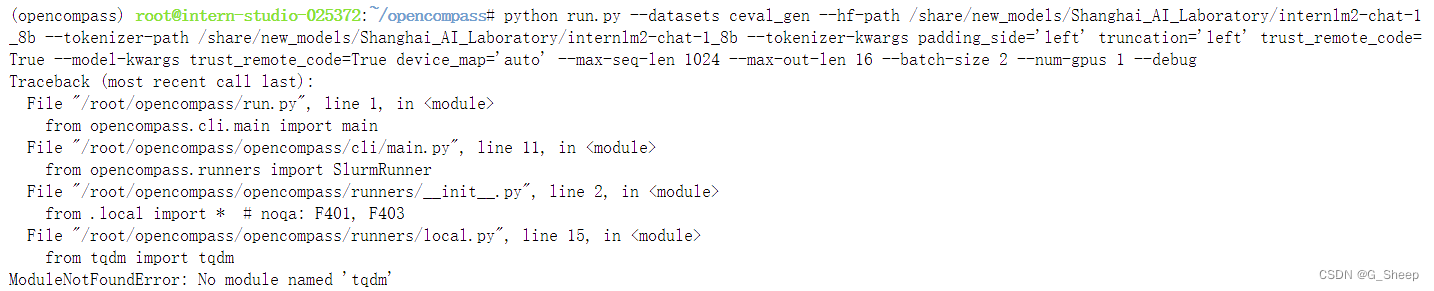

1.1.4、启动评测

python run.py

--datasets ceval_gen \

--hf-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace 模型路径

--tokenizer-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 1024 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

实在受不了了,运行了几次,每次都缺包,果断 pip install -r requirements.txt。

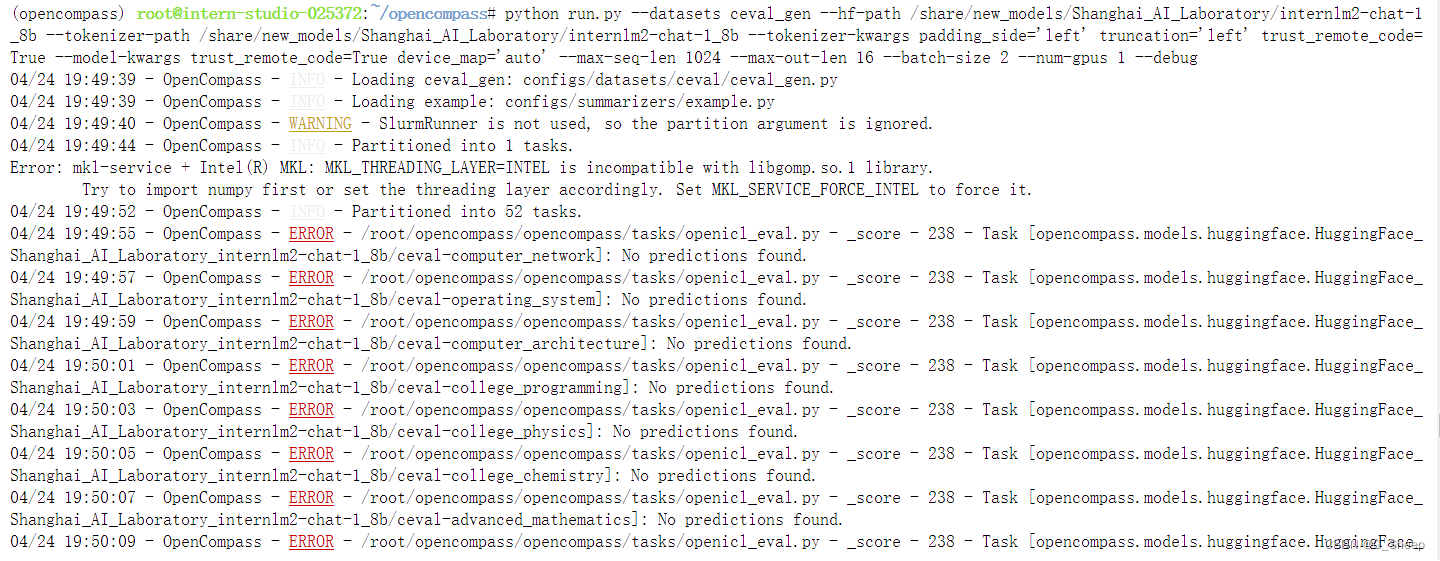

再次运行,没有出现缺包的情况,不过也是出现了和教程上说过的问题。

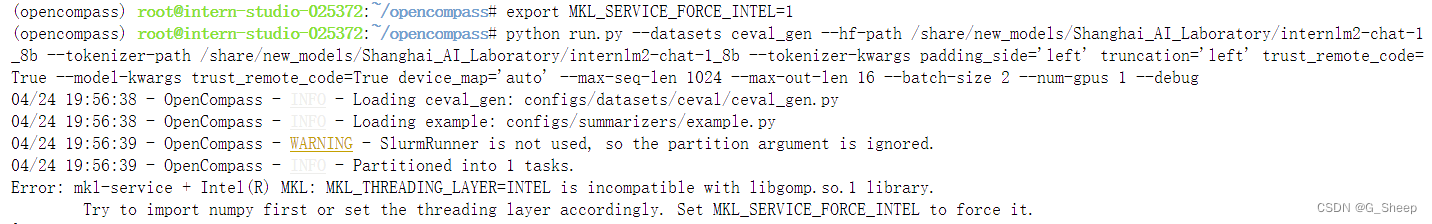

先按照教程的做法设置 export MKL_SERVICE_FORCE_INTEL=1。

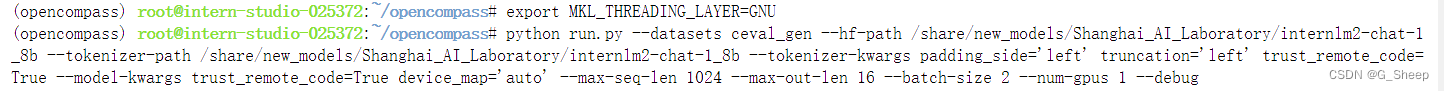

但运行发现还是报同样的错误,那就换第二种方法 export MKL_THREADING_LAYER=GNU。

这次运行以后没有再出现 MKL MKL_THREADING_LAYER=INTEL 的问题了,不过出现了新的问题。

出现这个问题是因为缺少 prtobuf 这个包,再 pip install protobuf,然后再次运行。

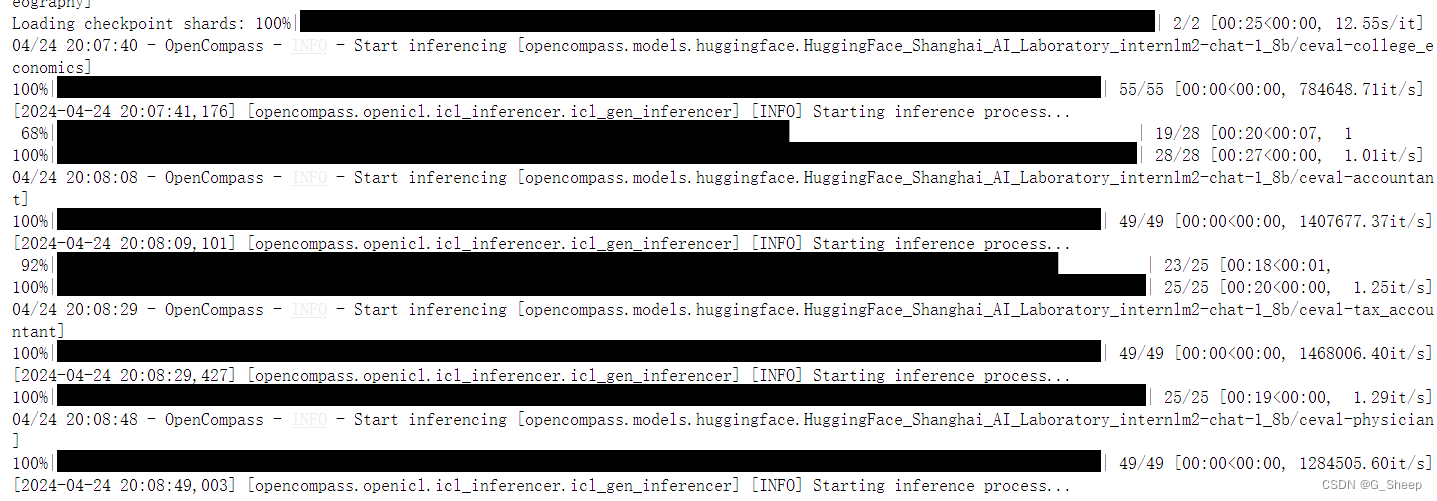

这次终于成功,安心等待结果。

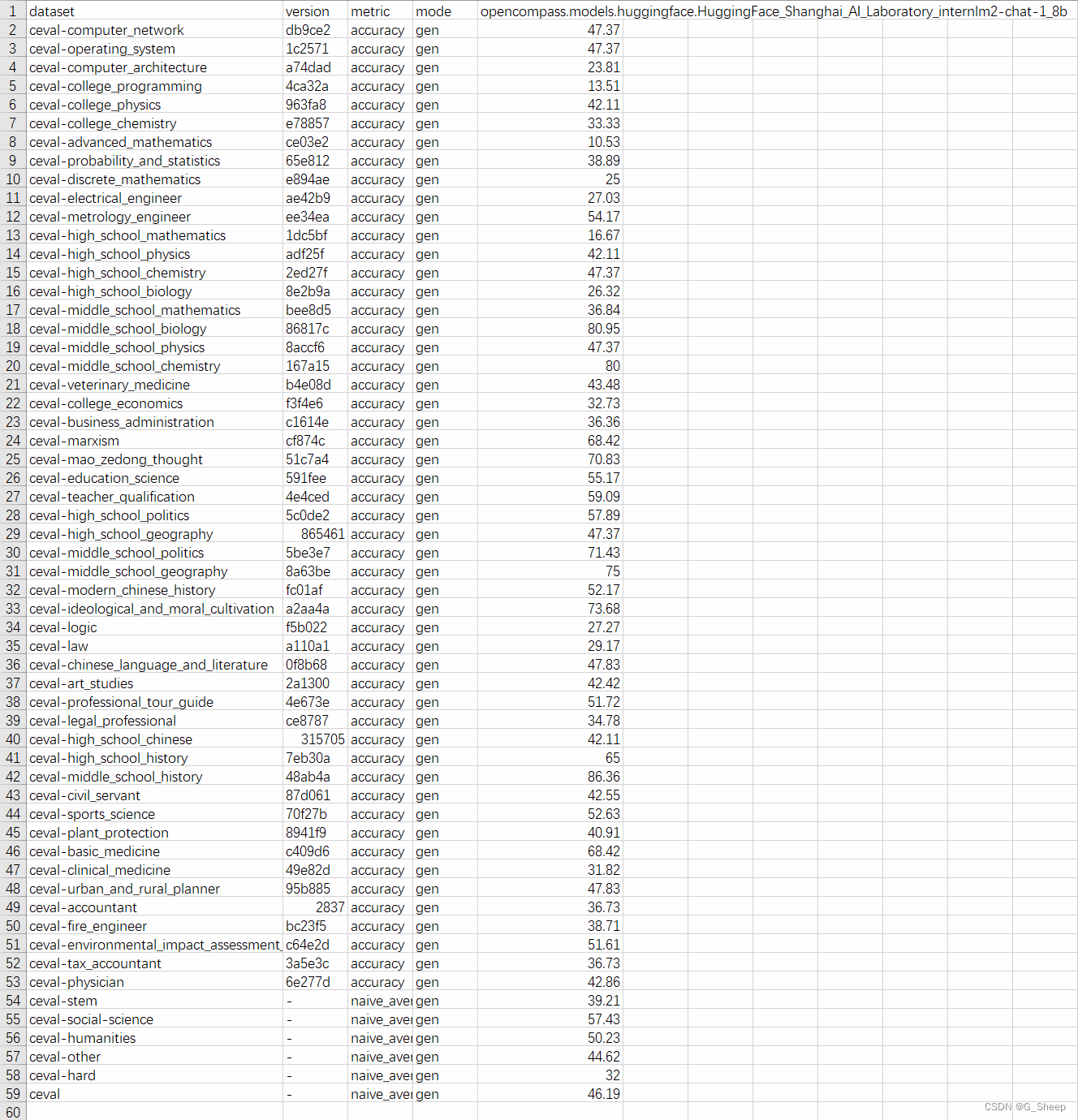

想截出来完整的图片,所以就直接将包含结果的 csv 文件下载下来。

二、进阶作业

2.1、将自定义数据集提交至OpenCompass官网

这篇关于OpenCompass 大模型评测实战——作业的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!