本文主要是介绍人工智能论文GPT-3(2):2020.5 Language Models are Few-Shot Learners;微调;少样本Few-Shot (FS),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

2 方法Approach

我们的基本预训练方法,包括模型、数据和训练,与GPT-2中描述的过程相似,只是模型规模、数据集规模和多样性,以及训练时长有所扩大,相对简单直接。

我们使用的上下文学习也与GPT-2相似,但在这项工作中,我们系统地探索了不同上下文学习设置。

因此,我们首先明确定义并对比我们将评估GPT-3的不同设置,或者原则上可以评估GPT-3的设置。

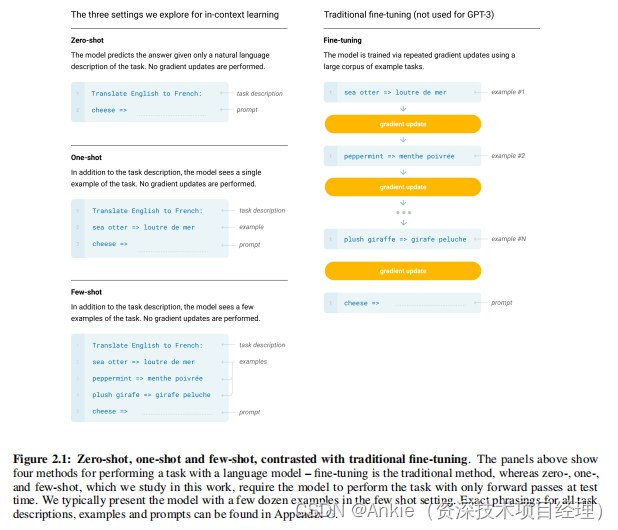

这些设置可以被看作是一个谱系,它们依赖任务特定数据的程度各不相同。具体来说,我们可以在这个谱系上至少识别出四个点(如图2.1所示):

微调Fine-Tuning (FT)

微调(FT)是近年来最常见的方法,涉及在针对所需任务的监督数据集上训练,以更新预训练模型的权重。通常使用数千到数十万个带标签的示例。

微调的主要优势是在许多基准测试上表现出色。

主要缺点是每个任务都需要一个新的大型数据集,可能导致分布外泛化性能不佳[MPL19],以及可能利用训练数据的虚假特征[GSL+18, NK19],

这可能导致与人类性能的比较不公平。在这项工作中,我们没有对GPT-3进行微调,因为我们的重点是任务无关的性能,但原则上可以对GPT-3进行微调,这是未来工作的一个有前景的方向。

少样本Few-Shot (FS)

在本工作中,我们将使用“少样本(FS)”这一术语来指代这样一种设置:在推理时,模型接收到任务的几个演示作为条件输入[RWC+19],但不允许进行权重更新。

如图2.1所示,对于典型的数据集,一个示例包括一个上下文和一个期望的完成内容(例如一个英文句子和对应的法文翻译),少样本学习的工作方式是通过提供K个上下文和完成内容的示例,然后提供一个最终的上下文示例,模型需要提供对应的完成内容。我们通常将K设置在10到100的范围内,因为这么多示例可以适应模型的上下文窗口(nctx = 2048)。

少样本学习的主要优势是大大减少了对任务特定数据的需求,并降低了从大而狭窄的微调数据集中学习过于狭窄分布的可能性。

主要缺点是,这种方法的结果到目前为止比最先进的微调模型差得多。此外,仍然需要少量的任务特定数据。正如名称所示,这里描述的用于语言模型的少样本学习与机器学习(ML)中其他上下文中使用的少样本学习[HYC01, VBL+16]有关——两者都涉及基于广泛的任务分布进行学习(在这种情况下隐含在预训练数据中),然后迅速适应新任务。

一样本One-Shot (1S)

一样本(1S)与少样本相同,只是除了自然语言的任务描述外,只允许一个演示,如图1所示。将一样本与少样本和零样本(下面将介绍)区分开来的原因是,它最符合人类接收任务指令的方式。例如,当要求人类工作者在人工服务(如Mechanical Turk)上生成数据集时,通常会给出一个任务演示。相比之下,如果不提供示例,有时很难传达任务的内容或格式。

零样本Zero-Shot (0S)

零样本(0S)与一样本相同,只是不允许提供任何演示,模型仅接收描述任务的自然语言指令。这种方法提供了最大的便利性和潜在的鲁棒性,避免了虚假关联(除非它们在大规模预训练语料库中广泛出现),但同时也是最具挑战性的设置。在某些情况下,没有先前的示例,人类可能难以理解任务的格式,因此这种设置在某些情况下“过于困难”。例如,如果有人被要求“制作一份200米短跑世界纪录表”,这个请求可能是模糊的,因为可能不清楚表格的确切格式或应包含哪些内容(即使经过仔细澄清,也很难准确理解所需的内容)。然而,至少在某些情况下,零样本与人类执行任务的方式最为接近——例如,在图2.1中的翻译示例中,人类可能仅根据文本指令就知道该怎么做。

图2.1展示了使用英语到法语翻译示例的四种方法。在本文中,我们主要关注零样本、一样本和少样本,目的是将它们作为不同的问题设置进行比较,而不是作为相互竞争的替代方案,这些设置提供了在特定基准上的性能和样本效率之间的不同权衡。我们尤其强调少样本的结果,因为其中许多结果仅略逊于最先进的微调模型。然而,最终,一样本,有时甚至零样本,似乎是与人类性能最公平的比较,也是未来工作的重要目标。

以下2.1至2.3节分别详细介绍了我们的模型、训练数据和训练过程。2.4节讨论了如何进行少样本、一样本和零样本评估的细节。

Ankie的评论:

GPT-3论文标题明确指出:“Language Models are Few-Shot Learners”,这揭示了GPT-3模型采用了少样本(few-shot)学习模式,而非传统的微调模式。GPT-3致力于实现通用人工智能的目标,因此它选择了少样本模式进行推理,而不是仅仅通过微调来应试。在少样本模式下,模型接收任务的几个演示作为条件输入,但不进行权重更新,从而保持其通用性和灵活性。

然而,少样本模式也存在一些局限性。相比于微调模式,它在应对特定任务时的应试能力可能稍逊一筹。这是因为微调模式允许模型针对特定任务进行更深入的学习和适应,而少样本模式则更注重模型的泛化能力。尽管如此,GPT-3通过采用少样本学习模式,展现出了强大的推理和生成能力,为通用人工智能的实现迈出了重要的一步。

这篇关于人工智能论文GPT-3(2):2020.5 Language Models are Few-Shot Learners;微调;少样本Few-Shot (FS)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!