本文主要是介绍为数据穿上安全的外衣——零售电商场景下的数据安全体系建设,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在电子商务交易过程中,会涉及大量的个人和财务数据的传输和处理,随着电子商务的发展,数据安全风险也成为一个备受关注的问题。

而跨境电商,属于出海业务,涉及到海外不同国家的政策法规,且数据作为电商的业务基础。若数据合规与数据安全没有妥善处理的话,可能会使企业面临法律和商业双重风险,从而影响企业的品牌形象和利益,甚至影响公司的业务运营,因此数据的合规以及数据的安全显得尤为重要。

数据安全与合规常见问题

1、数据隐私保护不足:跨境电商可能未能充分保护消费者的个人数据隐私,如未经用户同意就进行数据收集和分享,或者未能提供充分的隐私政策和选择权。

2、跨境数据传输合规性: 跨境电商在处理跨境数据流动时可能违反了某些国家或地区的数据传输规定,如未能签订合适的数据处理协议或未能确保数据的适当保护。

3、安全漏洞和数据泄露: 由于网络攻击、内部失误或技术故障等原因,跨境电商可能面临安全漏洞和数据泄露的风险,导致客户数据被盗取或泄露。

4、合规审查不全面: 跨境电商可能未能全面了解和遵守各国家或地区的数据保护法规,导致合规性审查不够严格或不完善。

5、数据处理合法性: 跨境电商在处理用户数据时可能存在合法性问题,如未能获得用户的充分同意或未能合法获取和使用特定类型的数据。

6、第三方数据处理风险: 跨境电商可能委托第三方服务提供商处理客户数据,但未能充分评估和监督这些服务提供商的数据安全和合规性,导致数据风险增加。

7、数据存储地点问题:跨境电商可能在选择数据存储地点时未能考虑到当地的数据保护法规和政策,导致违反了相关规定。

- 合规培训不足: 跨境电商可能未能为员工提供充分的数据安全和合规培训,导致员工对数据保护要求和流程的理解不够深入。

数据安全市场分析

电商技术持续创新,对现存用户深度挖掘

电商平台看重的是用户粘性和持续的消费能力,会利用大数据技术分析用户采购行为,通过数据对外共享交换,获取更有价值的信息。笔者近日在某东花费67元下单采购一个笔记本电源适配器,在与商家沟通确认型号后,第二天就收到了某宝同款价值36元的产品推送广告。显然,大数据分析精准判断了商品的采购需求,虽然忽略了物品在使用方式上的唯一性,但这其中的过程却让人引发深思。

市场发展固然重要,行业竞争激烈是不争事实

电商市场分析,2022年总零售额13.79万亿,订单总数高达1083亿笔。其中,直播作为相对较新的商业路径,使得更多电商平台将其纳入大中型商业活动,与传统电商的交锋变得愈演愈烈。促进各种营销活动频繁启动,明星、网红带头来掏空我们的钱包,虽然给我们带来了便利和优惠,也引发了质量下降、产能过剩、个人信息泄露、骚扰电话、网络诈骗等一系列的社会问题。电商的“超速”发展下,正在推动整个电商行业走向降质增效的道路。

安全问题亟需提上日程,法律法规不会“袖手旁观”

根据某分析报告在2023年数据资产泄露分析报告内容,共发生近1000起数据泄露事件,涉及1204家企业、38个行业。主要包含:物流、电商、金融、航空、招聘、教育、旅游等行业。黑产数据的交易变得更加隐蔽和便利。从泄露原因来看,本季度人为拍摄信息导致数据泄露占比42%,主要集中在物流、电商行业,涉及销售、仓储、快递等环节的面单信息泄露;合作方泄露位居第二,占比34%。可见,在2023年第一季度涉及寄递数据与电商个人信息数据约有760起泄露事件,并且彼此之间都存在一定的安全隐患。

做好数据流转行为的监测,是有效规避泄露风险的方法

数据安全的关注点是使用行为。围绕数据全生命周期开展的行为监测与防护能够有效的降低数据泄露风险。在掌握数据资产的具体使用情况后,使用有效的分类分级标识,发现数据在流转中的异常情况,根据数据级别,及时定义风险、识别风险和规避风险,做好数据在价值发挥的同时也能够进一步保障数据的使用安全。

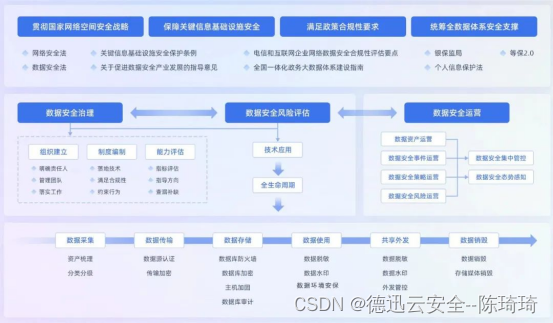

在数据安全领域,德迅云安全坚持以全数据安全为核心业务理念,拥有业界完整的覆盖数据安全全生命周期的安全标品与平台产品。通过对上述电商行业、物流行业的数据安全风险分析,德迅云安全率先提出基于关键业务数据、个人敏感信息的安全监测防护方案,用于实现对于敏感数据识别定级、面向数据流转全过程的数据安全监测防护与数据防泄漏能力。

01

从用户行为视角出发,深度关联账户信息、数据信息、接口信息,掌握数据资产的具体情况,了解敏感数据在使用过程中出现的安全隐患,及时发现数据安全风险,并能够通过实时监测技术提供完整的溯源依据,为构筑数据安全完整体系提供必要的技术手段。

02

突破结构化数据安全与非结构化数据安全的技术壁垒,从全局视角出发,建立可信的数据安全监测与审计能力,基于数据血缘关系,将结构化数据访问行为和非结构化数据访问行为的日志、结果信息等数据进行有效的关联,通过“全栈式”平台的概念,进行完整的行为分析,提炼出使用敏感数据的所有行为,提供给威胁建模、行为分析库、风险事件溯源等能力基础依据。

03

以敏感数据使用安全为导向,通过对敏感信息采取的一系列脱敏措施,遏制数据在使用过程中出现的敏感信息泄露事件。从数据静态脱敏、动态脱敏、API接口脱敏场景出发,结合访问行为、应用外发的具体情况,建立统一的脱敏平台,全面解决敏感数据在全场景使用流转过程中的脱敏难题与海量敏感数据在复杂场景的脱敏问题。

04

统一归纳风险事件、定义风险等级,智能判断发生事件的处置方式,包括但不限于:告警、阻断、审批(拒绝/通过)、放行等。依据数据级别制定可提供统一派发的细粒度的访问控制策略,使异常、高频、高危的访问行为能够得到有效的管控。从内部流转到对外发布,使用统一、高效的管控机制,结合最小化权限原则,拒绝一切违规行为。

数据安全方案架构

事前安全建设

电商企业网站众多,因此需要大规模的网站监测系统,以方便了解网站安全的整体态势。定期对电商企业的系统做深入安全探测,让电商企业知道自己网络所面临的问题。坚持挖掘有价值的威胁情报,真正做到风险预警。除此之外,提升电商企业员工的安全意识水平和安全事件处理能力,能很大程度在事前降低风险。最后,在重要时期需要加强安全运维管理服务,以保障电商业务的持续安全运营。

这边建议考虑(渗透测试,舆情监控,重保服务,信息安全意识培训)

事中安全控制

在电商平台运营过程中,为了预防大流量的DDoS和CC攻击需要采用专业的抗D服务,保障业务的可持续运行。业务安全方面,需要对安全大数据进行深度挖掘,并精剖行业中易产生欺诈行为的业务场景,杜绝羊毛党等欺诈行为。另外,部署安全防护产品对电商系统的服务器进行篡改防护、敏感信息泄露防护等也是必不可少的。最后在访问速度上可以通过智能缓存、传输协议优化、内容优化等技术提升2-10倍访问速度,并减少源站压力。

这边建议考虑方案(DDoS高防,安全加速,舆情监测)

事后紧急响应

当用户的电商系统因外部恶意入侵、攻击或由于内部误操作等原因而引起安全异常时,安全服务团队将在第一时间到达现场,协助对事件的成因及过程进行分析与追溯,并根据分析结果提供针对性的修复建议,保障安全事件发生时,第一时间定位问题、解决问题,防止问题再次发生。

这边联系建议专家服务(应急响应)

这篇关于为数据穿上安全的外衣——零售电商场景下的数据安全体系建设的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!