本文主要是介绍英伟达高性能芯片供货周期缩短到2-3个月,今年GPU不再紧缺?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

戴尔台湾地区总经理Terence Liao近日称,英伟达高性能 AI GPU的交付周期在过去几个月中已从3-4个月缩短到仅2-3个月,进入2024年以来交货等待时间一直在不短缩短,目前的2-3个月已经是英伟达高性能GPU最短的交货期。

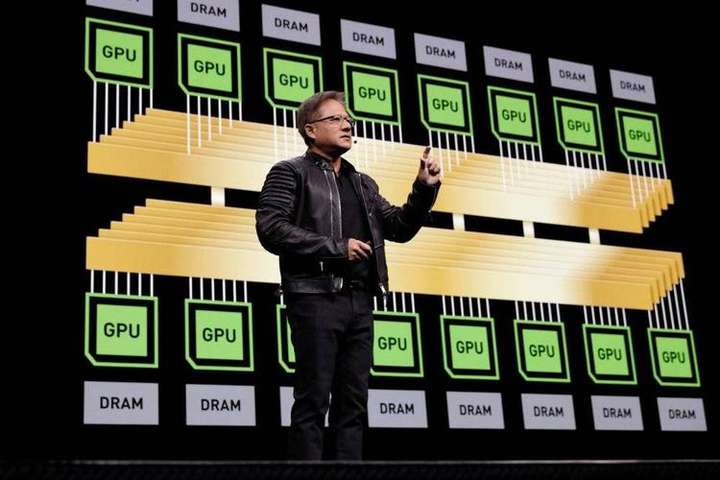

英伟达公司正在不断努力提高产能和效率,以满足全球市场对高性能GPU的迫切需求。人工智能模型Grok 3预计需要超过10万个,ChatGPT5训练大约需要5万个,扎克伯格表示Meta公司今年需要35万张英伟达高性能芯片。

全球知名大型科技企业对英伟达高性能芯片的需求量达到数十上百万张,即使英伟达芯片供应周期大幅度缩短,为全球AI企业发展提供基础保障,但对于我国企业无疑是巨大压力。随着未来AI大模型参数的不断增加,科技企业在训练和应用部署对GPU需求也随之快速增长,目前想要通过官方渠道购买高端英伟达芯片已经不可能。

在国产芯片能够逐渐替代英伟达之前,至少还有三五年的过渡阶段,拥有足够多的英伟达芯片,目前是国内大多数企业在AI领域的竞争优势。

作为英伟达NPN合作伙伴,英智公司采用了英伟达顶配芯片,在深圳建设了一套千卡规模的人工智能智算集群。通过InfiniBand 400G IB无阻塞胖树组网架构,英智这套千卡规模的智算集群的实际计算效率比上一代【H800+4IB组网】集群提升了4倍以上,为企业智能化发展提供高质量的基础设施保障。

目前这套千卡智算集群可点击【申请试用】,支持‘即租即用’模式,允许企业根据实际需求快速扩展或缩减计算资源。

这篇关于英伟达高性能芯片供货周期缩短到2-3个月,今年GPU不再紧缺?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!