本文主要是介绍4d tensor,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

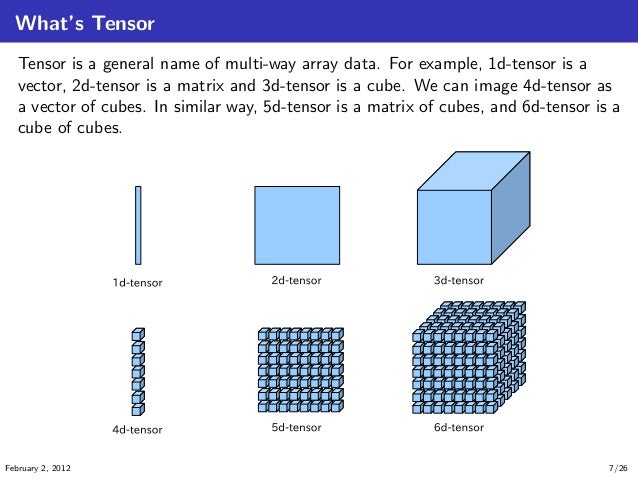

偶然在一个ppt中看到了如下关于tensor的解释,清晰明白,所以post在这里,以备后续查看

根据这个理解:

theano中的input(4d tensor):【mini-batch size, number of input feature maps, image height, image width】

例如:【100, 10, 12,12】

weight matrix (4d tensor): 【 number of feature maps at layer m,number of feature maps at layer m-1, filter height, filter width】

例如:【10,20, 5,5】

这篇关于4d tensor的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!