tensor专题

PyTorch使用教程之Tensor包详解

《PyTorch使用教程之Tensor包详解》这篇文章介绍了PyTorch中的张量(Tensor)数据结构,包括张量的数据类型、初始化、常用操作、属性等,张量是PyTorch框架中的核心数据结构,支持... 目录1、张量Tensor2、数据类型3、初始化(构造张量)4、常用操作5、常用属性5.1 存储(st

Mindspore 初学教程 - 3. Tensor 张量

张量(Tensor)是一个可用来表示在一些矢量、标量和其他张量之间的线性关系的多线性函数,这些线性关系的基本例子有内积、外积、线性映射以及笛卡儿积。其坐标在 n n n 维空间内,有 n r n^{r} nr 个分量的一种量,其中每个分量都是坐标的函数,而在坐标变换时,这些分量也依照某些规则作线性变换。 r r r 称为该张量的秩或阶(与矩阵的秩和阶均无关系)。 张量是一种特殊的数据结构,

七. 部署YOLOv8检测器-load-save-tensor

目录 前言0. 简述1. 案例运行2. 补充说明3. 代码分析3.1 main.cpp3.2 create_data.py 结语下载链接参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习笔记,仅供自己参考 本次课程我们来学习课程第六章—部署分类器,一起来学习利用 cnpy 库加载和保存 tensor 课程大纲可以看下面的思维导图

Pytorch:Tensor基本运算【add/sub/mul/div:加减乘除】【mm/matmul:矩阵相乘】【Pow/Sqrt/rsqrt:次方】【近似:floor...】【裁剪:clamp】

一、基本运算:加减乘除 1、乘法 1.1 a * b:element-wise 对应元素相乘 a * b:要求两个矩阵维度完全一致,即两个矩阵对应元素相乘,输出的维度也和原矩阵维度相同 1.2 torch.mul(a, b):element-wise 对应元素相乘 torch.mul(a, b):是矩阵a和b对应位相乘,a和b的维度必须相等,比如a的维度是(1, 2),b的维度是(1,

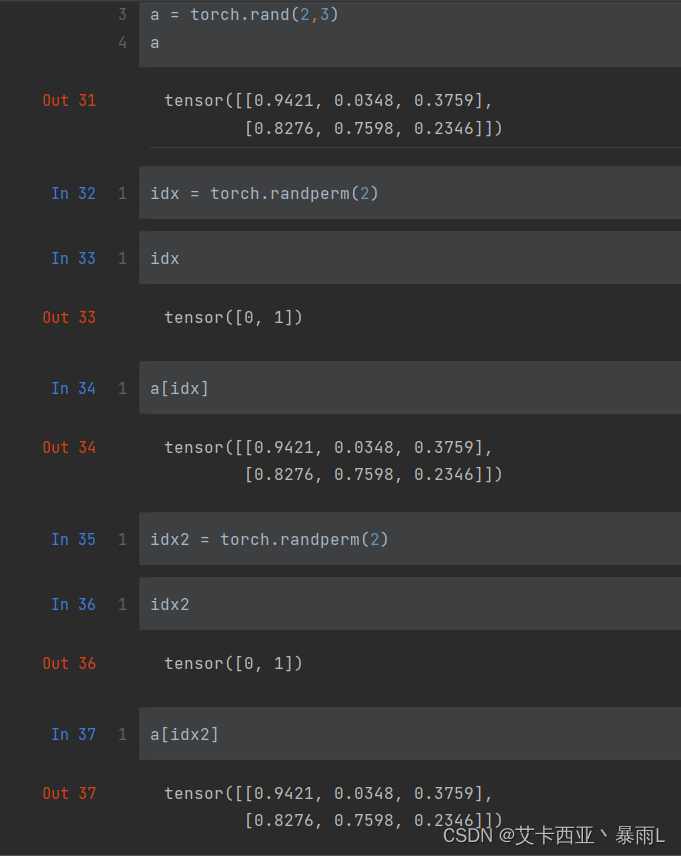

Pytorch:Tensor的高阶操作【where(按条件取元素)、gather(查表取元素)、scatter_(查表取元素)】【可并行计算,提高速度】

一、where:逐个元素按条件选取【并行计算,速度快】 torch.where(condition,x,y) #condition必须是tensor类型 condition的维度和x,y一致,用1和0分别表示该位置的取值 import torchcond = torch.tensor([[0.6, 0.7],[0.3, 0.6]])a = torch.tensor([[1., 1.],[

Pytorch:Tensor数组运算中的Broadcasting【广播机制】

简单来说,Broadcasting 可以这样理解:如果你有一个 m × n m×n m×n 的矩阵,让它加减乘除一个 1 × n 1×n 1×n 的矩阵,它会被复制 m m m 次,成为一个 m × n m×n m×n 的矩阵,然后再逐元素地进行加减乘除操作。 数组在进行矢量化运算时,要求数组的形状是相等的。当形状不相等的数组执行算术运算的时候,就会出现广播机制,该机制会对数组进行扩

tensorflow:超简单易懂 tensor list的使用 张量数组的使用 扩增 建立 append

构造张量数组: 最简单的方式: tensor_list=[tensor1,tensor2] 常用的方式(这个方式可以用于for循环) tensor_list=[]tensor_list.append(tensor1)tensor_list.append(tensor2) 张量数组的使用 批量处理张量数组里面的张量,之后将其存储到一个新的张量数组中 new_tensor_list

EXO:模型最终验证的地方;infer_tensor;step;MLXDynamicShardInferenceEngine

目录 EXO:模型最终验证的地方 EXO:infer_tensor EXO:step MXNet的 mx.array 类型是什么 NDArray优化了什么 1. 异步计算和内存优化 2. 高效的数学和线性代数运算 3. 稀疏数据支持 4. 自动化求导 举例说明 EXO:模型最终验证的地方 EXO:infer_tensor 这段代码定义了一个名为 in

Eigen::Tensor使用,定义高维矩阵

在实际项目中,需要存储大于等于三维的矩阵,而平常中我们使用Eigen::MatrixXd二维数据,这里我们使用Eigen::Tensor来定义 1.Using the Tensor module #include <unsupported/Eigen/CXX11/Tensor> 2.定义矩阵 2.一般矩阵 官方文档 // 定义一个2x3x4大小的矩阵Eigen::Tensor<f

tensor core实现矩阵乘法的详细解读

之前关于tensor core的介绍可以参考链接添加链接描述 基础的tensor core实现C=AB的代码可以参考下面这段内容: 上面代码的几个注意事项: 首先是加载mma.h头文件,这个是包含wmma模板类的头文件。 其次是设置的WMMA_M=16,WMMA_N=16,WMMA_K=8,这三个参数的表示的意思是,对于一个线程块内的一个warp来说,这个线程簇warp一次能处理的是[16,8]

【Pytorch】tensor 转置 t()

tensor的t()属性实现转置 >>> import torch>>> x = torch.Tensor([[1, 2, 3, 4, 5], [6, 7, 8, 9, 10]])>>> x1 2 3 4 56 7 8 9 10[torch.FloatTensor of size 2x5] >>> x.t()1 62 73 84 95 10

3、TENSOR VIEWS

PyTorch 允许张量是现有张量的视图。视图张量与其基础张量共享相同的基础数据。 支持 View 避免了显式数据复制,从而使我们能够进行快速且内存高效的整形、切片和元素操作。 例如,要获取现有张量 t 的视图,可以调用 t.view(...)。 >>> t = torch.rand(4, 4)>>> b = t.view(2, 8)>>> t.storage().data_ptr() =

2、TENSOR ATTRIBUTES

每个 torch.Tensor 都有一个 torch.dtype、torch.device 和 torch.layout。 torch.dtype CLASStorch.dtype torch.dtype 是表示 torch.Tensor 的数据类型的对象。 PyTorch 有十二种不同的数据类型: Data type dtype Legacy Constructors 32-bi

1、TORCH.TENSOR

torch.Tensor 是一个多维矩阵,包含单一数据类型的元素。 Data types Torch 定义了 10 种具有 CPU 和 GPU 变体的张量类型,如下所示: Data type dtype CPU tensor GPU tensor 32-bit floating point torch.float32 or torch.float torch.FloatTens

Tensorflow打印tensor值的方法

Tensorflow由于经过了封装,所以它的值在控制台上是打印不出来的,只能打印出维度,例如这样: import tensorflow as tfA = tf.constant(666)print(A) 输出结果: <tf.Tensor ‘Const:0’ shhape=() dtype=int32> 这是因为tensorflow的基本执行原理是数据流,以上语句只是占用了一个节

pytorch中 tensor.repeat()函数用法

文章目录 torch.tensor.repeat(*size)函数作用 举例 官方解释链接 torch.tensor.repeat(*size) 函数作用 用于进行张量数据复制和维度扩展的函数。参数是沿着维度重复的次数。 注意⚠️: repeat()函数跟expand()函数不同,repeat()函数重复的时候是根据tensor内的数据。同时,对于函数中的参数个数一定不能

【pytorch04】创建Tensor

numpy中的数据创建tensor 数据已经在numpy中了,将numpy中的数据转到tensor中来,因为我们将使用tensor在GPU上进行加速运算 从NUMPY导入的FLOAT其实是DOUBLE类型 list中的数据创建tensor FloatTensor()和大写的Tensor()接收的是shape(即数据的维度),当让也可以接收现有的数据, 接收数据时必须用list表示,接收s

Tensorflow: Cannot interpret feed_dict key as Tensor 解决报错 flask keras

文章目录 1 报错信息2 原因3 解决办法 1 报错信息 使用fask和keras时候,在本地没任何问题。 但是上传到服务器上之后,总是报做个错误: TypeError: Cannot interpret feed_dict key as Tensor: Tensor Tensor("Placeholder:0", shape=(3, 3, 3, 64), dtype=floa

每天五分钟深度学习框架pytorch:多维tensor向量在某一维度的拼接和分割

本文重点 在深度学习中,我们常常需要完成多个向量拼接,同时也要完成向量的分割,在pytorch中已经有封装好的库,我们可以直接调用完成这部分任务。 Cat拼接 c=torch.cat([a,b],dim=0)表示将a和b按0维度进行拼接,需要注意再非dim维度,两个矩阵的维度必须是一致的,不然会拼接失败。 Stack拼接 Stack并不会进行维度的拼接,而是会增加新的维度 我们

PyTorch 统计属性-Tensor基本操作

最小 min, 最大 max, 均值 mean,累加 sum,累乘 prod … >>> a = torch.arange(0,8).view(2,4).float()>>> atensor([[0., 1., 2., 3.],[4., 5., 6., 7.]])>>> a.min() ## 最小值:tensor(0.)>>> a.max() ## 最大值:tensor(7.)>>

由于把图像转化为tensor,然后又从tensor转化为numpy,从而导致进行人脸检测画框时,出现无法检测到人脸的特殊情况

历时一小时的愁云惨淡万里凝。 这个问题终于被我找到啦啦啦啦 我的图像是经过以下处理得到tensor格式,根据上面我提出的无法检测到人脸的问题: img_pil = Image.open(random.choice(self.out_domain_hairstyle_img_path_list)) self.image_transform = transforms.Compose([trans

PyTorch 数学运算-Tensor基本操作

用如下 a b 进行运算演示 >>> a tensor([[0.7967, 0.5056, 0.7963],[0.8603, 0.7029, 0.7590]])>>> btensor([[0.6923, 0.0411, 0.8713],[0.0483, 0.2948, 0.3286]]) 一般加减乘除运算: add/mimus/multiply/d

DeepSpeed Huggingface模型的自动Tensor并行

推理阶段。在后台,1. DeepSpeed会把运行高性能kernel(kernel injection),加快推理速度,这些对用户是透明的; 2. DeepSpeed会根据mp_size来将模型放置在多个GPU卡上,自动模型并行; import osimport torchimport transformersimport deepspeedlocal_rank = int(os.get

算法金 | 这次终于能把张量(Tensor)搞清楚了!

大侠幸会,在下全网同名[算法金] 0 基础转 AI 上岸,多个算法赛 Top [日更万日,让更多人享受智能乐趣] 1. 张量(Tensor)基础概念 1.1 张量的定义与重要性 张量是深度学习中用于表示数据的核心结构,它可以视为多维数组的泛化形式。在机器学习模型中,张量用于存储和变换数据,是实现复杂算法的基石。本文基于 Pytorch 1.2 张量与向量、矩阵的关系

使用Python实现GLM解码器的示例(带有Tensor Shape标注)

下面是一个示例,演示了如何使用Python和PyTorch实现一个基于GLM(Glancing Language Model)原理的解码器,包括对每个Tensor的shape进行标注。 代码示例 import torchimport torch.nn as nnimport torch.nn.functional as Fclass GlancingDecoder(nn.Module):d

Pytorch常用函数用法归纳:Tensor张量之间的计算

1.torch.add() (1)函数原型: torch.add(input, other, alpha, out) (2)参数说明: 参数名称参数类型参数说明inputtorch.Tensor表示参与运算的第一个输入Tensor张量othertorch.Tensor或者Number表示参与运算的第二个输入Tensor张量或标量alphaNumber, optional一个可选的缩放因子,