本文主要是介绍Python爬虫从入门到精通:(2)requests基础01_实现一个简易网页采集器_Python涛哥,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

requests 安装和导入

- requests 安装

pip install requests

- requests 导入

import requests

爬虫编码流程

- 指定url

- 发起请求

- 获取响应数据

- 持久化存储

最简单的例子(爬取搜狗页面):

# 1.指定url

url = 'https://www.sogou.com'

# 2.发起请求get方法的返回值为响应对象

response = requests.get(url=url)

# 3. 获取响应数据

# .text:返回的是字符串形式的响应数据

page_text = response.text

# 4. 持久化存储

with open('./sogou.html', 'w', encoding='utf-8') as f:f.write(page_text)

使用浏览器打开 “sogou.html” 文件,可以看到成功爬取:

实现一个简易网页采集器

基于搜狗针对不同的关键字将其对应的页面数据进行爬取

参数动态化:

- 如果请求的url携带参数,且我们想要将携带的参数进行动态化操作 那么我们必须:

- 将携带的动态参数以键值对应形式封装到一个字典中

- 将字典作用到get方法的

params参数中即可 - 需要将原始携带参数中的url中将携带的参数删除

例如:我们搜索 jay,并通过代码来实现:

url=https://www.sogou.com/web?query=jay

具体代码实现如下:

keyWord = input('enter a key word:')

# 实现参数动态化:

params = {'query': keyWord

}

url = 'https://www.sogou.com/web'

# params参数(字典):保存请求时url携带的参数

response = requests.get(url=url, params=params)# 修改响应数据的编码格式

# encoding返回的是响应数据原始的编码格式,如果给其赋值则表示修改了响应数据的编码格式

response.encoding = 'uft-8'page_text = response.text

fileName = keyWord + '.html'

with open(fileName, 'w', encoding='utf-8') as f:f.write(page_text)

print(fileName, '爬取完毕!!!')

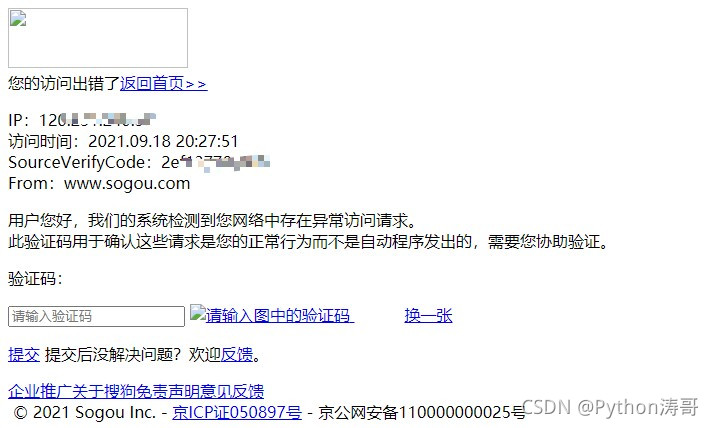

我们来看下结果:

(1)模拟搜狗搜索 jay

(2)代码结果展示

第二种反爬机制

如上图,我们看到代码运行结果并没有爬取到我们想要的内容。难道是我们代码流程错了吗?

不完全是。

-

异常的访问请求

不是浏览器发起的请求都是异常请求

网站的后台是如何知道请求是不是通过浏览器发起的?

是通过判定请求的请求头中的user-agent判定的。什么是User-Agent:

请求载体的身份标识

什么是请求载体:

浏览器:浏览器的身份标识是统一固定,身份标识可以从抓包工具中获取

爬虫程序:身份标识是各自不同 -

第二种反爬机制

UA检测:网站后台会检测请求对应的User-Agent,以判定的安全请求是否为异常请求

-

反反爬策略

-

UA伪装

被作用到了大部分网站中,日后我们写的爬虫程序都默认带上UA检测

-

伪装流程

从抓包工具中捕获到某一个基于浏览器请求的User-Agent的值,将其伪装作用到一个字典中,将该字典作用到请求方法(get,post)的headers参数中即可

具体代码实现如下:

# User-Agent headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/93.0.4577.82 Safari/537.36' }keyWord = input('enter a key word:') params = {'query': keyWord } response = requests.get(url=url, params=params, headers=headers) response.encoding = 'uft-8' page_text = response.text fileName = keyWord + '.html' with open(fileName, 'w', encoding='utf-8') as f:f.write(page_text) print(fileName, '爬取完毕!!!')现在就成功完整爬取到了页面!

-

关注 Python涛哥,学习更多Python知识!

这篇关于Python爬虫从入门到精通:(2)requests基础01_实现一个简易网页采集器_Python涛哥的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!