requests专题

使用Python的requests库来发送HTTP请求的操作指南

《使用Python的requests库来发送HTTP请求的操作指南》使用Python的requests库发送HTTP请求是非常简单和直观的,requests库提供了丰富的API,可以发送各种类型的HT... 目录前言1. 安装 requests 库2. 发送 GET 请求3. 发送 POST 请求4. 发送

使用Python的requests库调用API接口的详细步骤

《使用Python的requests库调用API接口的详细步骤》使用Python的requests库调用API接口是开发中最常用的方式之一,它简化了HTTP请求的处理流程,以下是详细步骤和实战示例,涵... 目录一、准备工作:安装 requests 库二、基本调用流程(以 RESTful API 为例)1.

python运用requests模拟浏览器发送请求过程

《python运用requests模拟浏览器发送请求过程》模拟浏览器请求可选用requests处理静态内容,selenium应对动态页面,playwright支持高级自动化,设置代理和超时参数,根据需... 目录使用requests库模拟浏览器请求使用selenium自动化浏览器操作使用playwright

一文详解如何在Python中使用Requests库

《一文详解如何在Python中使用Requests库》:本文主要介绍如何在Python中使用Requests库的相关资料,Requests库是Python中常用的第三方库,用于简化HTTP请求的发... 目录前言1. 安装Requests库2. 发起GET请求3. 发送带有查询参数的GET请求4. 发起PO

Python结合requests和Cheerio处理网页内容的操作步骤

《Python结合requests和Cheerio处理网页内容的操作步骤》Python因其简洁明了的语法和强大的库支持,成为了编写爬虫程序的首选语言之一,requests库是Python中用于发送HT... 目录一、前言二、环境搭建三、requests库的基本使用四、Cheerio库的基本使用五、结合req

Python 中 requests 与 aiohttp 在实际项目中的选择策略详解

《Python中requests与aiohttp在实际项目中的选择策略详解》本文主要介绍了Python爬虫开发中常用的两个库requests和aiohttp的使用方法及其区别,通过实际项目案... 目录一、requests 库二、aiohttp 库三、requests 和 aiohttp 的比较四、requ

urllib与requests爬虫简介

urllib与requests爬虫简介 – 潘登同学的爬虫笔记 文章目录 urllib与requests爬虫简介 -- 潘登同学的爬虫笔记第一个爬虫程序 urllib的基本使用Request对象的使用urllib发送get请求实战-喜马拉雅网站 urllib发送post请求 动态页面获取数据请求 SSL证书验证伪装自己的爬虫-请求头 urllib的底层原理伪装自己的爬虫-设置代理爬虫coo

【python requests警告】python3.x requests库取消ssl验证,InsecureRequestWarning: Unverified HTTPS request is be

警告信息: InsecureRequestWarning: Unverified HTTPS request is being made. Adding certificate verification is strongly advised. See: https://urllib3.readthedocs.io/en/latest/advanced-usage.html#ssl-warni

【python requests错误】Caused by SSLError(SSLError(bad handshake: SysCallError(104, 'ECONNRESET')

错误描述: 在发送get请求时错误,执行下面一句时报错了: response = requests.get(image_url) 原因HTTPSConnectionPool(host='test-kkbuluo-resource.cdn.hzmltest.com', port=443): Max retries exceeded with url: /IMCORE/RESOURCE/LOG

Python实现requests-post(Multipart/form-data格式)boundary=----WebKitForm

这种模式相比于普通post,实在太烦了,这种基本都是用来上传文件(包括图片、excel、doc等) import requestsfrom requests_toolbelt.multipart.encoder import MultipartEncoderimport jsonurl = 'http://www.requests-post.com'headers = {'Accept':

Requests库对session的支持

场景:如何获取登录时响应消息中的sessionid,以及如何在后续请求中把sessionid添到cookie中 Requests库提供了一个Session类,通过requests库中的session对象,requests库会自动帮我们保存服务端返回的cookie数据(set-cookie里的内容),也会在HTTP发出请求时自动在消息头中放入cookie数据。 用py模拟客户端接收响应消息:

python+requests实现接口测试 - get与post请求使用( params

原 http://www.mamicode.com/info-detail-1755093.html 简介:Requests 是用Python语言编写,基于 urllib,采用 Apache2 Licensed 开源协议的 HTTP 库。它比 urllib 更加方便,可以节约我们大量的工作,完全满足 HTTP 测试需求。Requests 的哲学是以 PEP 20 的习语为中心开发

爬虫二:获取豆瓣电影Top250(Requests+XPath+CSV)

描述: 在上一篇获取豆瓣图书Top250的基础上,获取豆瓣电影Top250的数据并将结果写入CSV文件中。 代码: # -*- coding: UTF-8 -*-import requestsfrom lxml import etreeimport timeimport csv# 从网页上获取电影数据moviedata = []count = 0for i in range(1

爬虫一:获取豆瓣图书Top250(Requests+XPath)

目的: 获取豆瓣图书Top250的所有书目信息。 豆瓣网址:https://book.douban.com/top250 代码: import requestsfrom lxml import etreeimport timefor i in range(10):url = 'https://book.douban.com/top250?start=' + str(25*i)data

requests请求方式、参数

getpost其他请求参数 get 1、无参数实例 import requestsret = requests.get('https://github.com/timeline.json')print(ret.text) 输出如下: {"message":"Hello there, wayfaring stranger. If you’re reading

python3 requests https 请求 报 SSLContext 相关递归错误

一、错误信息: 2019-11-19 15:14:40 : Provider before requests .post2019-11-19 15:14:41 : error infoTraceback (most recent call last):File "/root/operation/spider/web/lh_spider_config/utils/run_provider/ser

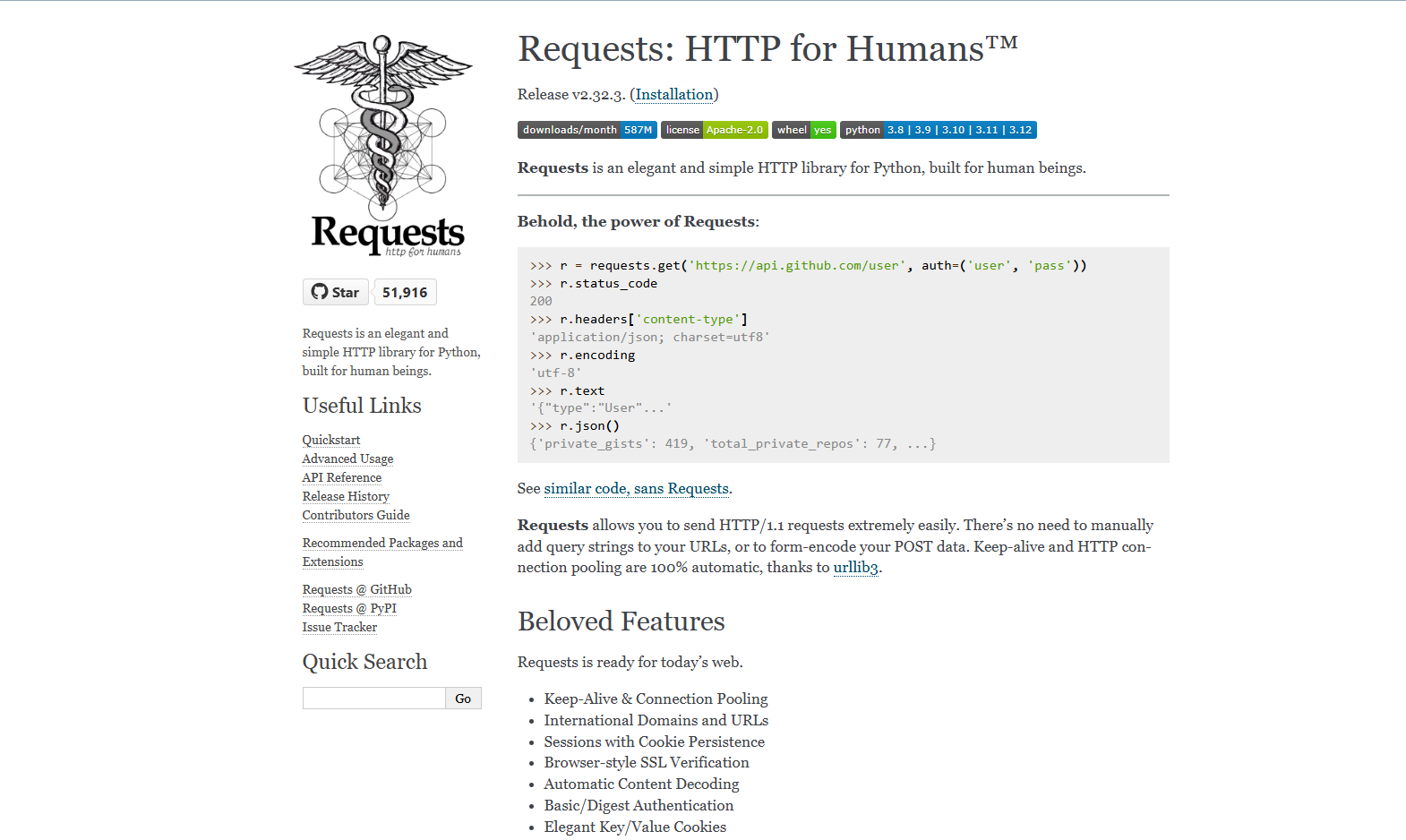

requests:一个强大的HTTP请求Python库

我是东哥,一个热衷于用Python简化日常工作的技术爱好者。今天,我要和大家分享一个网络请求的Python利器——requests库。你是否曾经在编写代码时,需要从网络上获取数据,却对复杂的HTTP协议感到头疼?requests库将帮你轻松解决这个问题。 一、初识requests库 requests库是Python中一个用于发送HTTP请求的第三方库。它基于urllib库进行了封装,提供了更加

第4章-07-将WebDriver获取的Cookie传递给Requests

🏆作者简介,黑夜开发者,CSDN领军人物,全栈领域优质创作者✌,CSDN博客专家,阿里云社区专家博主,2023年CSDN全站百大博主。 🏆数年电商行业从业经验,历任核心研发工程师,项目技术负责人。 🏆本文已收录于专栏:Web爬虫入门与实战精讲,后续完整更新内容如下。 文章目录 🚀一、功能实现🔎1.1 使用Selenium WebDriver获取Cookies🔎1.

第4章-08-用Python Requests库模拟浏览器访问接口

🏆作者简介,黑夜开发者,CSDN领军人物,全栈领域优质创作者✌,CSDN博客专家,阿里云社区专家博主,2023年CSDN全站百大博主。 🏆数年电商行业从业经验,历任核心研发工程师,项目技术负责人。 🏆本文已收录于专栏:Web爬虫入门与实战精讲,后续完整更新内容如下。 文章目录 🚀一、功能实现🔎1.1 安装Requests库🔎1.2 模拟浏览器发送POST请求🔎1

Python的requests库详细介绍

Python requests 库是一个用于发送 HTTP 请求的简单而强大的库,它可以让你轻松地在 Python 中处理 HTTP 请求。这个库是 Python中处理 HTTP 请求的标准工具,因其简洁的 API 和强大的功能而广受欢迎。 1. 安装 requests pip install requests 2. 基本用法 2.1 导入库 import requests 2.2

Apache ab 压力测试出现 Failed requests

如图: Failed requests 分別有 Connect, Length,Exception : 1:Connect 无法送出要求,目标主机连接失败,要求的过程中连接被中断

第3章-03-Python库Requests安装与讲解

Python库Requests的安装与讲解 🏆作者简介,黑夜开发者,CSDN领军人物,全栈领域优质创作者✌,CSDN博客专家,阿里云社区专家博主,2023年CSDN全站百大博主。 🏆数年电商行业从业经验,历任核心研发工程师,项目技术负责人。 🏆本文已收录于专栏:Web爬虫入门与实战精讲,后续完整更新内容如下。 文章目录 Python库Requests的安装与讲解一、R

python模块04-requests

1 requests模块发送请求 Requests是一个Python HTTP庫 相关参考资料: 文档:Requests: 让 HTTP 服务人类 — Requests 2.18.1 文档 requests · PyPI:requests · PyPI requests源码:GitH0ub - psf/requests: A simple, yet elegant, HTTP libra

python requests 被屏蔽(已设置header和代理IP,解决浏览器指纹问题)

情况说明: 已设置 User-Agent已使用代理IP之前请求没问题,突然无法请求了。我用浏览器打开网站可以正常访问。 我遇到的原因: 目标网站/接口,能够通过JA3或者其他浏览器指纹信息,识别到你不是通过浏览器进行访问的。 解决方法: 使用 curl_cffi 库即可 使用方法: 注意: curl_cffi 仅支持 python 3.8 以上使用。 安装 curl_cffi p

[python]如何在requests post时不做urlencode?

这两天要为公司一个项目的服务端写性能测试脚本,其中有一个请求订单号的接口,需要客户端用post请求向服务端发送加密过的token 和订单数据。代码如下: payload = {'token':token,'order_data':order_data} r = requests.post(url, data=payload} 但是,服务端返回错误,花了很长时间检查了token和ord

《Python requests 库详解》

requests是一个非常流行的用于在 Python 中进行 HTTP 请求的库。以下是对requests库的详细介绍: 一、安装 可以使用 pip 进行安装: pip install requests 二、主要功能特点 简洁易用的 API requests提供了非常简洁直观的函数来发送各种 HTTP 请求,如get()、post()、put()、delete()等,让开发者可以轻松