本文主要是介绍YOLOv8添加注意力机制方法【MHSA、ShuffleAttention、SiAM】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

YOLOv8添加注意力机制方法

文章目录

- 注意力机制示例1:MHSA

- 注意力机制示例2:ShuffleAttention

- 注意力机制示例3:SiAM

注意力机制示例1:MHSA

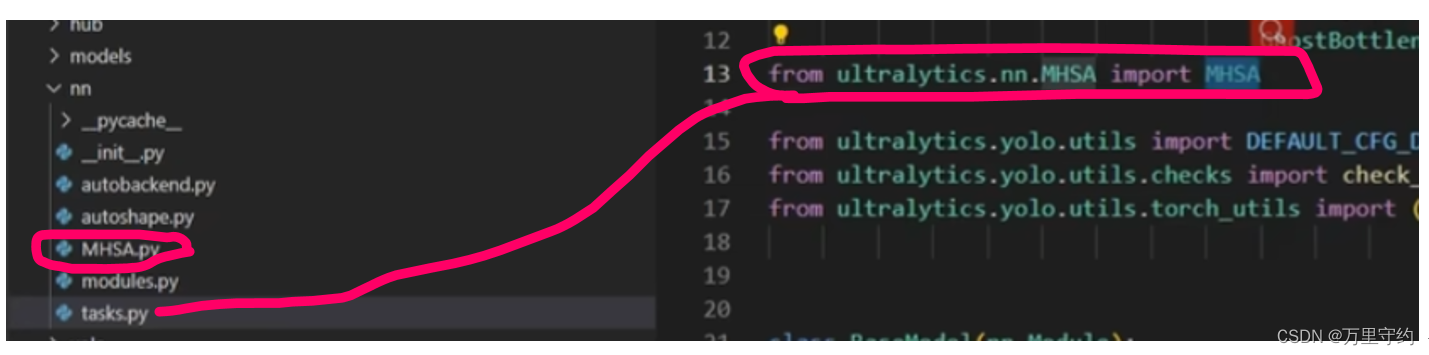

1、 注意力机制文件放在nn文件夹下

2、 task.py文件导入注意力机制文件

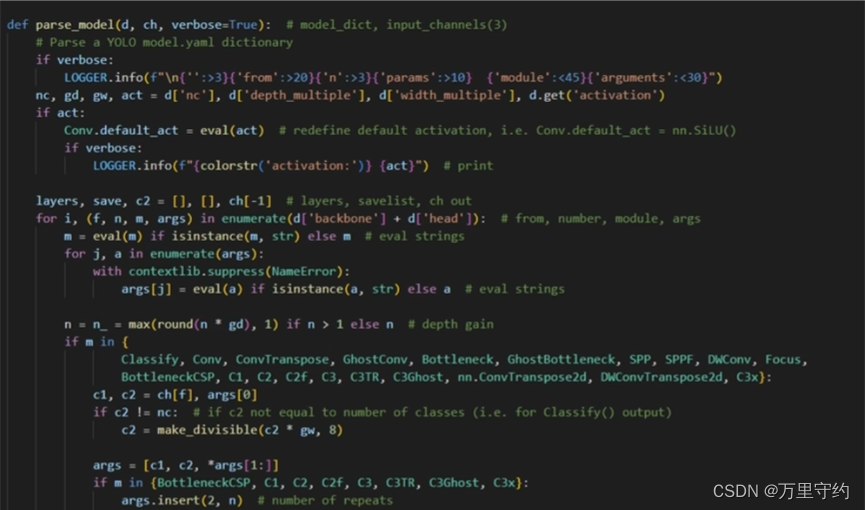

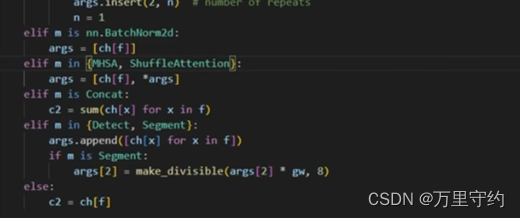

3、 task.py中parse_model函数添加elif语句:

注意是in

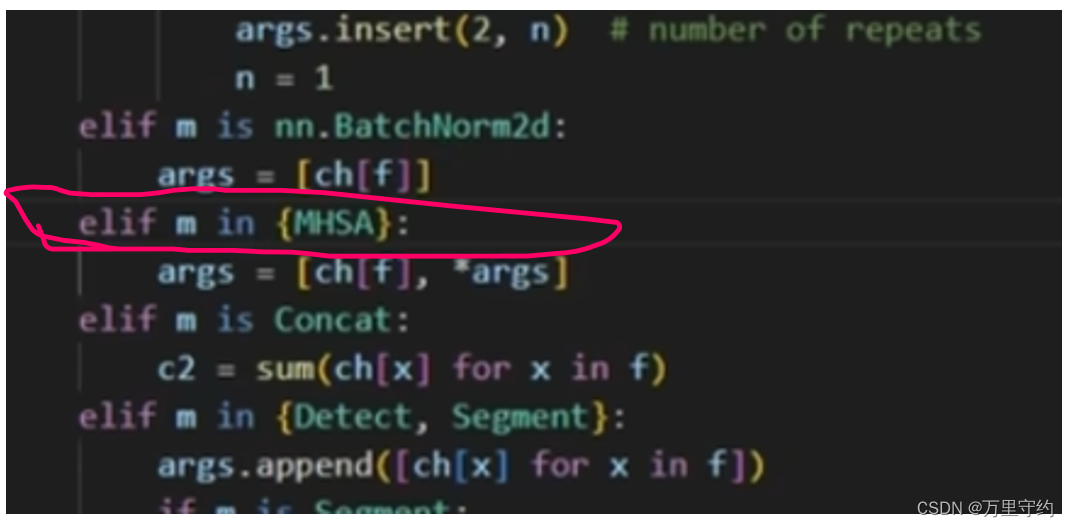

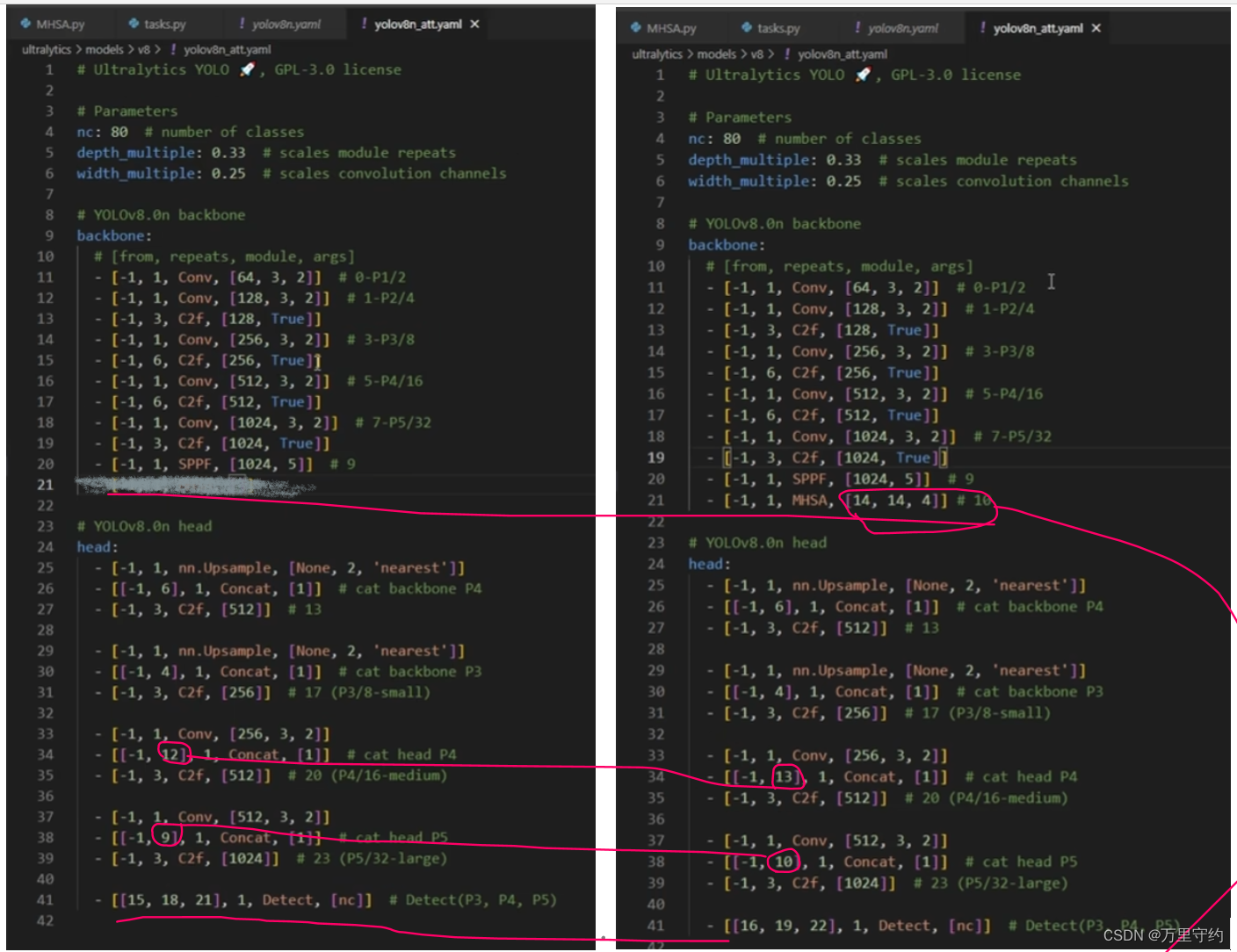

4、 改模型配置文件

原模型(左图)和添加注意力机制后的(右图)

这里的参数要看MHSA的参数要求

该注意力机制属于有参数的

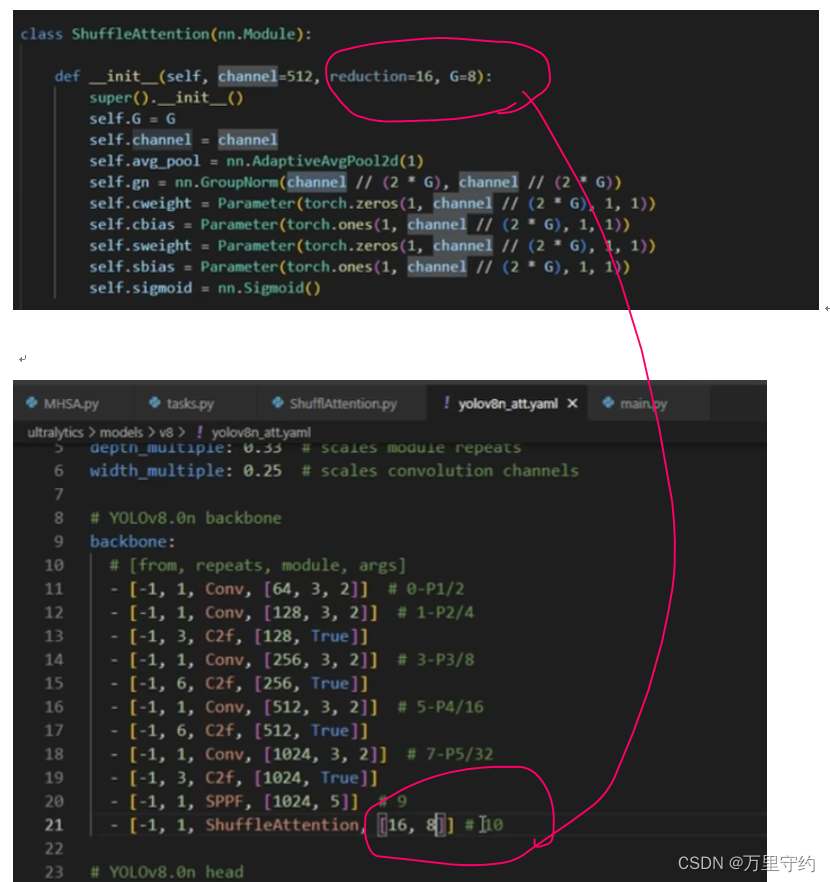

注意力机制示例2:ShuffleAttention

1、 nn文件夹下添加.py文件,task.py文件导入ShuffleAttention

2、 parse_model函数添加elif语句,由于该注意力机制也接收通道数为参数,所以方法和MHSA相同,如图所示:

3、看注意力机制源码的参数

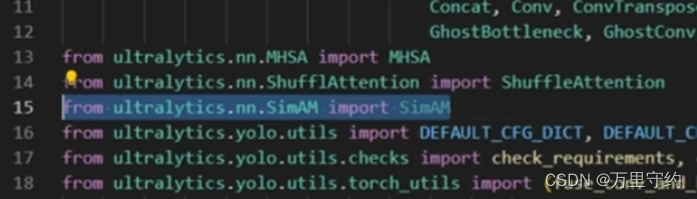

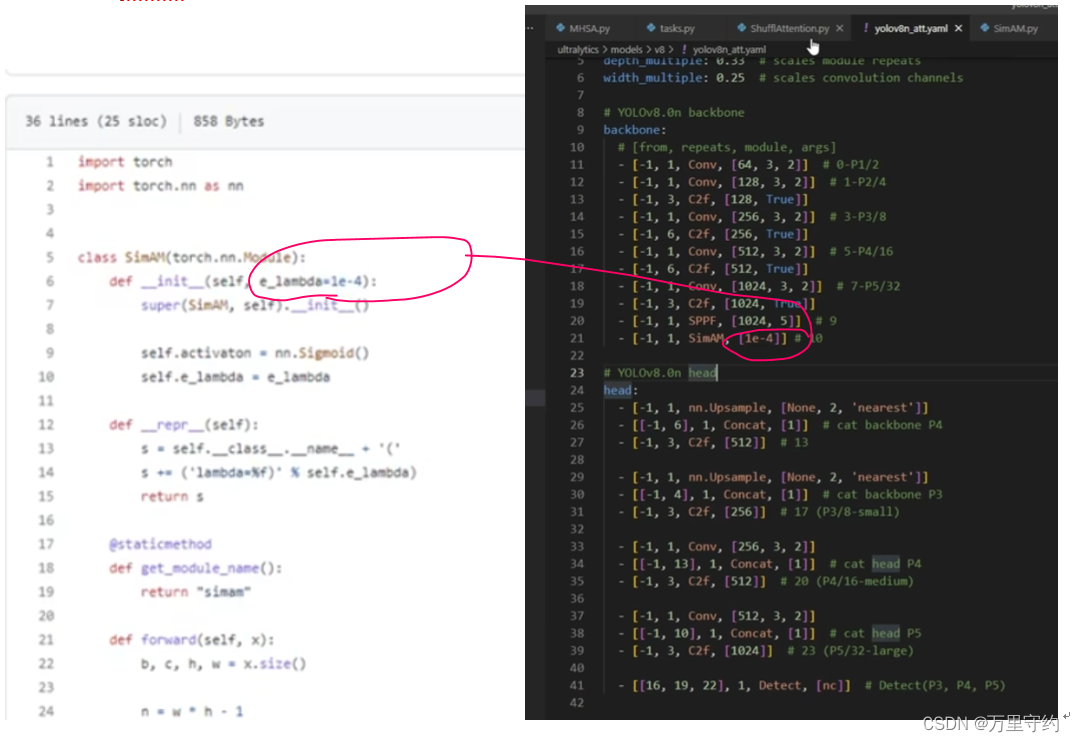

注意力机制示例3:SiAM

1、 该注意力机制不接受参数,故直接在task.py中导入即可

2、 修改yaml文件后即可运行

这篇关于YOLOv8添加注意力机制方法【MHSA、ShuffleAttention、SiAM】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!