shuffleattention专题

【YOLO改进】主干插入ShuffleAttention模块(基于MMYOLO)

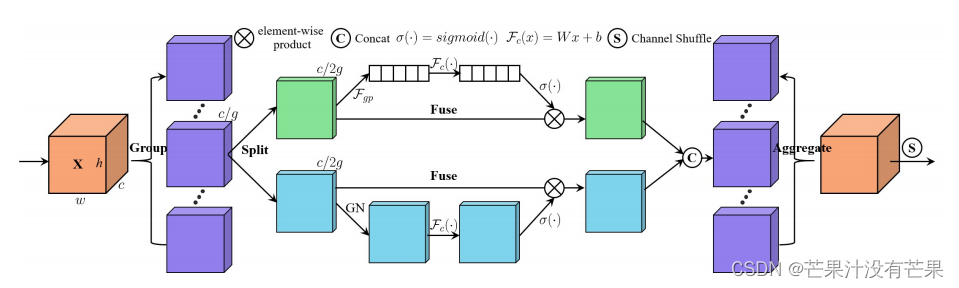

ShuffleAttention模块 论文链接:https://arxiv.org/abs/2102.00240 将ShuffleAttention模块添加到MMYOLO中 将开源代码ShuffleAttention.py文件复制到mmyolo/models/plugins目录下 导入MMYOLO用于注册模块的包: from mmyolo.registry import MODELS

YOLOv8 | 注意力机制 | ShuffleAttention注意力机制 提升检测精度

YOLOv8成功添加ShuffleAttention ⭐欢迎大家订阅我的专栏一起学习⭐ 🚀🚀🚀订阅专栏,更新及时查看不迷路🚀🚀🚀 YOLOv5涨点专栏:http://t.csdnimg.cn/1Aqzu YOLOv8涨点专栏:http://t.csdnimg.cn/jMjHb YOLOv7专栏:http://t.csdnimg.cn/yhXBl 💡魔改网络、

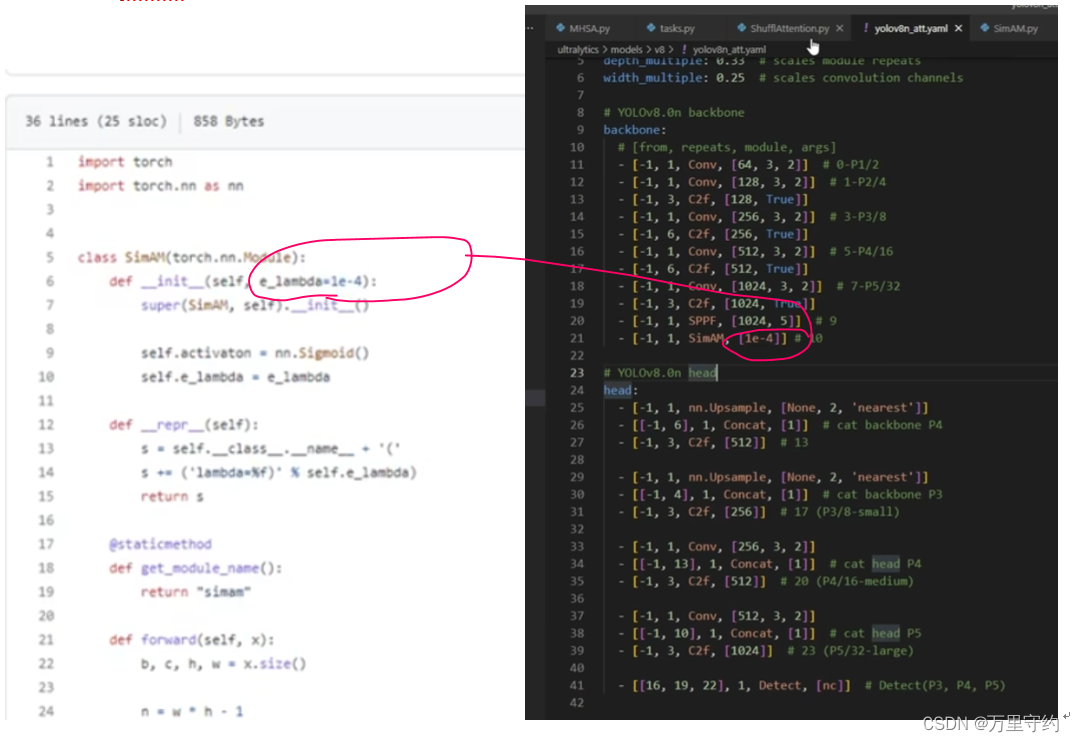

改进YOLOv8注意力系列六:结合SEAttention轻量通道注意力、ShuffleAttention重排特征注意力模块、SimAM无参数化注意力

改进YOLOv8注意力系列五:结合ParNetAttention注意力、高效的金字塔切分注意力模块PSA、跨领域基于多层感知器(MLP)S2Attention注意力 代码SEAttention轻量通道注意力ShuffleAttention重排特征注意力模块SimAM无参数化注意力 加入方法各种yaml加入结构 本文提供了改进 YOLOv8注意力系列包含不同的注意力机制以及多

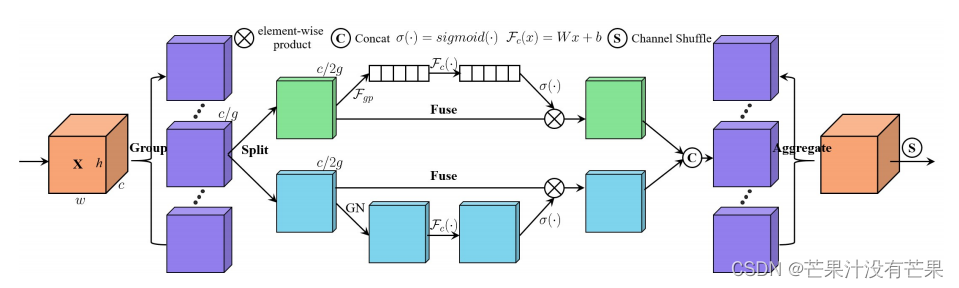

免费阅读篇 | 芒果YOLOv8改进113:注意力机制ShuffleAttention:深度卷积神经网络的随机注意力

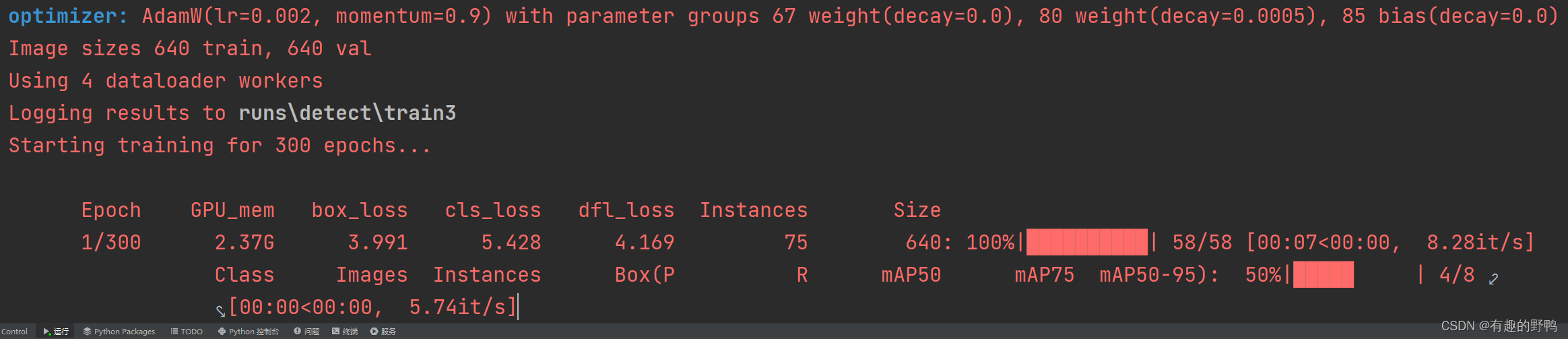

💡🚀🚀🚀本博客 改进源代码改进 适用于 YOLOv8 按步骤操作运行改进后的代码即可 该专栏完整目录链接: 芒果YOLOv8深度改进教程 该篇博客为免费阅读内容,YOLOv8+ShuffleAttention改进内容🚀🚀🚀 文章目录 1. ShuffleAttention 论文2. YOLOv8 核心代码改进部分2.1 核心新增代码2.2 修改部分 2.3 YOL

YOLOv8添加注意力机制方法【MHSA、ShuffleAttention、SiAM】

YOLOv8添加注意力机制方法 文章目录 注意力机制示例1:MHSA注意力机制示例2:ShuffleAttention注意力机制示例3:SiAM 注意力机制示例1:MHSA 1、 注意力机制文件放在nn文件夹下 2、 task.py文件导入注意力机制文件 3、 task.py中parse_model函数添加elif语句: 注意是in 4、 改模型配置文件 原模型(左图)和

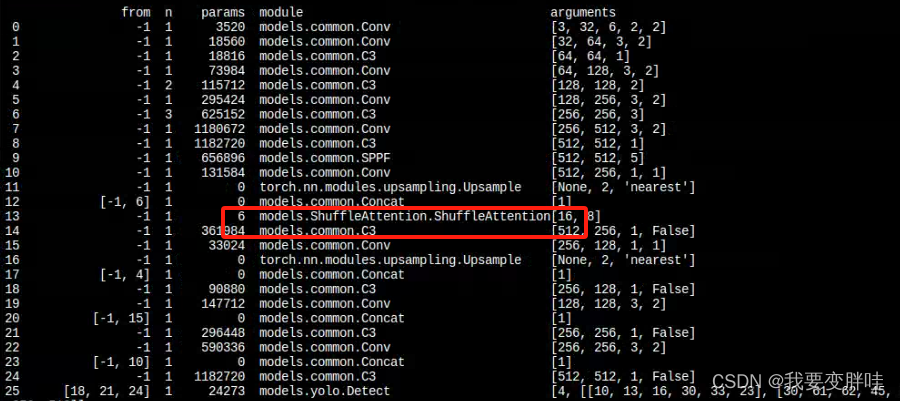

yolov8添加注意力机制模块-ShuffleAttention

修改 原本打算把ShuffleAttention模块先写进conv.py文件中,然后在引入tasks.py文件中。但是不知道咋回事,在tasks.py文件中引入报红。所以干脆直接把ShuffleAttention模块写进了tasks.py文件中。 from torch.nn import initfrom torch.nn.parameter import Parameterclass Sh

(超详细)4-YOLOV5改进-添加ShuffleAttention注意力机制

1、在yolov5/models下面新建一个SE.py文件,在里面放入下面的代码 代码如下: import numpy as npimport torchfrom torch import nnfrom torch.nn import initfrom torch.nn.parameter import Parameterclass ShuffleAttention(nn.Modu

YOLOv8 C2f模块融合shuffleAttention注意力机制

1. 引言 1.1YOLOv8直接添加注意力机制 yolov8添加注意力机制是一个非常常见的操作,常见的操作直接将注意力机制添加至YOLOv8的某一层之后,这种改进特别常见。 示例如下: 新版yolov8添加注意力机制(以NAMAttention注意力机制为例) YOLOv8添加注意力机制(ShuffleAttention为例) 知网上常见的添加注意力机制的论文均使用的上述方式。 下面展

YOLOv8 C2f模块融合shuffleAttention注意力机制

1. 引言 1.1YOLOv8直接添加注意力机制 yolov8添加注意力机制是一个非常常见的操作,常见的操作直接将注意力机制添加至YOLOv8的某一层之后,这种改进特别常见。 示例如下: 新版yolov8添加注意力机制(以NAMAttention注意力机制为例) YOLOv8添加注意力机制(ShuffleAttention为例) 知网上常见的添加注意力机制的论文均使用的上述方式。 下面展

改进YOLOv5、YOLOv8系列:12.添加ShuffleAttention注意力机制

最新创新点改进推荐 -💡统一使用 YOLO 代码框架,结合不同模块来构建不同的YOLO目标检测模型。 🔥 《芒果书》系列改进专栏内的改进文章,均包含多种模型改进方式,均适用于YOLOv3 、YOLOv4 、 YOLOR 、 YOLOX 、YOLOv5 、 YOLOv7 、 YOLOv8 改进(重点)!!! 🔥 专栏创新点教程 均有不少同学反应和我说已经在自己的数据集上有效涨点啦!! 包