siam专题

YOLOv8添加注意力机制方法【MHSA、ShuffleAttention、SiAM】

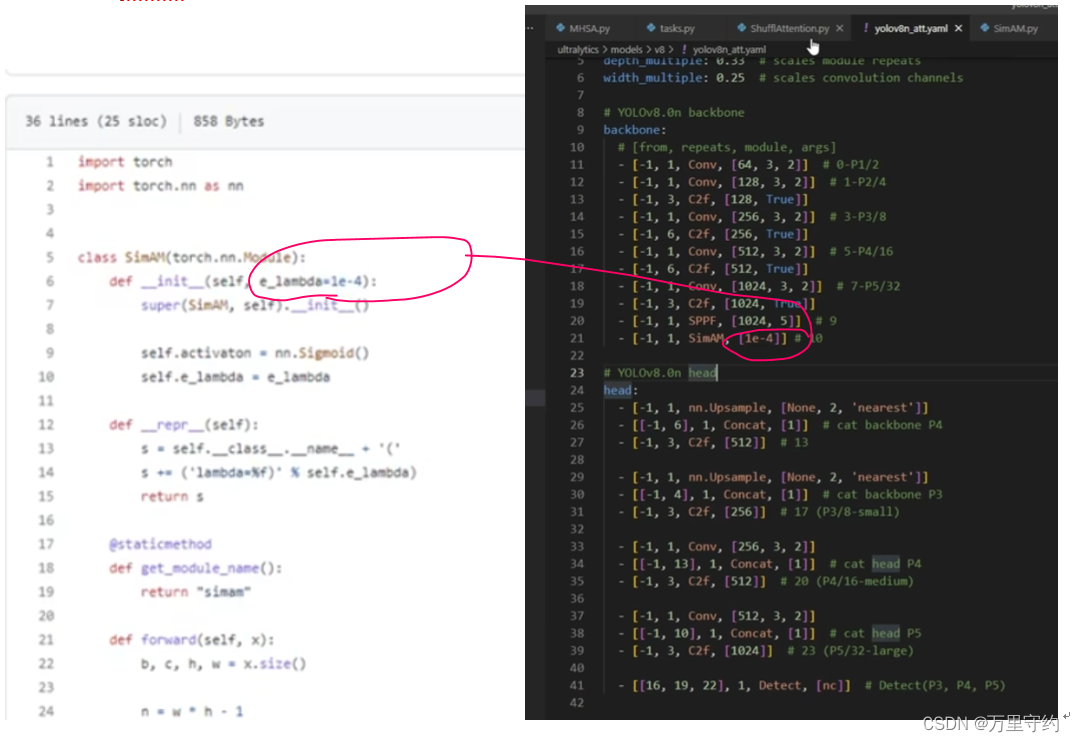

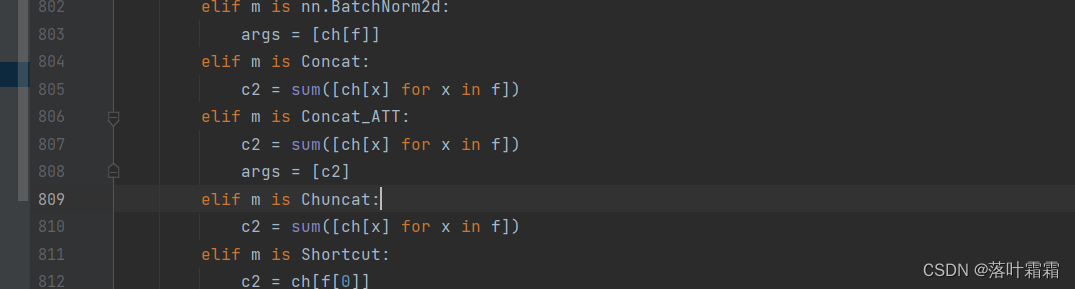

YOLOv8添加注意力机制方法 文章目录 注意力机制示例1:MHSA注意力机制示例2:ShuffleAttention注意力机制示例3:SiAM 注意力机制示例1:MHSA 1、 注意力机制文件放在nn文件夹下 2、 task.py文件导入注意力机制文件 3、 task.py中parse_model函数添加elif语句: 注意是in 4、 改模型配置文件 原模型(左图)和

【Siam-BM】论文阅读笔记

Towards a Better Match in Siamese Network Based Visual Object Tracker 论文地址 代码不开源 写在前面 这是SASiam的作者18年另一个工作,在VOT2018公测上也占的一席之地,只不过好像因为什么奇奇怪怪原因没有终测,但是它还是不失为一个real-time精度高的tracker,比SASiam精度也有了提升,主要是处理了

【yolov系列:yolov7改进添加SIAM注意力机制】

yolo系列文章目录 文章目录 yolo系列文章目录一、SimAM注意力机制是什么?二、YOLOv7使用SimAM注意力机制1.在yolov7的models下面新建SimAM.py文件2.在common里面导入在这里插入图片描述 总结 一、SimAM注意力机制是什么? 论文题目:SimAM: A Simple, Parameter-Free Attention Modu