本文主要是介绍【Python/crawl】如何使用Python爬虫将一系列网页上的同类图片下载到本地,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

【需求】

从网页https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html

开始,有十七页,每页都有大漂亮“小濑田麻由”的若干图片,想要将其下载到本地。

如果手工一张张右键另存为比较麻烦,想用程序自动下载下来。

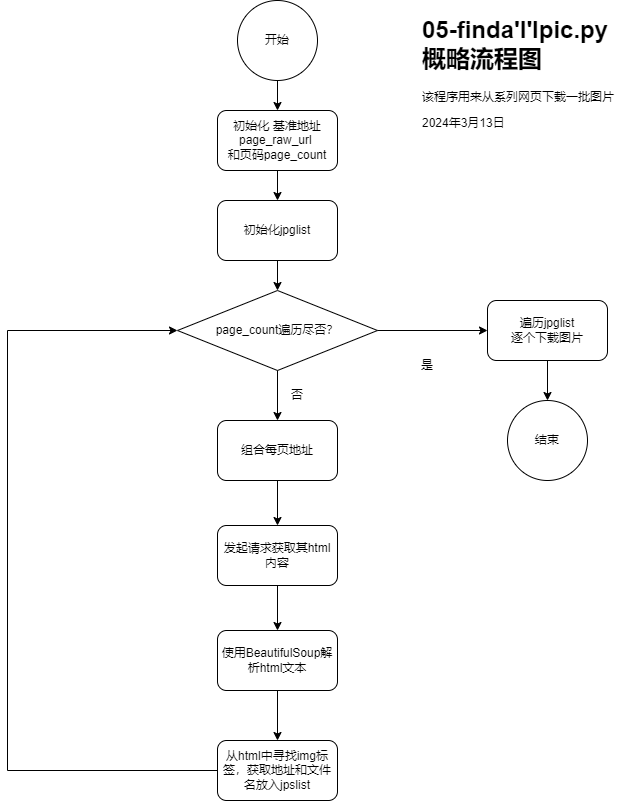

【思路】

17张网页地址都是连续的,可以用基准网址+页码的形式拼出每个网页。

得到具体每页的网址后,可发起网络请求得到其html内容,再用BeautifulSoup去解析,把包含图片的img标签拿下来,从标签的src属性获取图片的真实地址。

有了图片的真实地址后,就可以发起网络请求获得相应,然后把相应内容存成二进制文件。

流程图

【代码】

#encoding=utf-8# 内置网络访问包

import requests# 内置的urllib.request模块

import urllib.request# 解析html的BeautifulSoup包,安装方法是pip install BeautifulSoup4

from bs4 import BeautifulSoup# 引入正则表达式包

import re# 把请求伪装成浏览器Mozilla

user_agent='Mozilla/4.0 (compatible;MEIE 5.5;windows NT)'

headers={'User-Agent':user_agent}# 以下两个变量需要手工修改

# 去除了页码的基准地址,这个地址需要自己拷贝粘贴过来

page_raw_url="https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/"

# 共有多少页,注意17不是死值,是需要自己看究竟有多少页然后修改的

page_count=17# 准备一个列表,用以放入文件名和地址组成的字典

jpglist=[]# 循环组合每页具体地址

for i in range(page_count):# 以粗地址和序号,重新组合每页的地址url=page_raw_url+str(i+1)# 发起请求获取其html内容html=requests.get(url,headers=headers)# 使用BeautifulSoup解析html文本soup= BeautifulSoup(html.text,'html.parser');jpg_count=0;# 查找html文本中img标签,指定其class是aligncenter,这个规律需要自己看网页源码探究出来!for img in soup.find_all('img',class_="aligncenter"):# 获取img的实际地址addr=img.get("src")# 使用正则表达式劈分文本parts = re.split(r'[/]', addr)# 最后一项即文件名filename=parts[-1]# 因为此法获取的文件名有两种:png和jpg,png是不需要的,故过滤掉if filename.endswith(".jpg"):# 准备字典,字典中包含地址和文件名两项dic={}dic['address']=addrdic['filename']=filename# 把字典放入列表jpglist.append(dic)jpg_count=jpg_count+1# 打印每页发现多少图片print("找到"+str(jpg_count)+"张靓照于网址:"+url)# 用len函数取得jpglist列表的总个数,打印出来

print("共找到"+str(len(jpglist))+"张靓照.")# 遍历列表,其中每一项是个字典

sn=0

for dic in jpglist:#print(dic['filename']+"_"+dic['address'])with urllib.request.urlopen(dic['address']) as response:data=response.read()filename=dic['filename']# write binary filesn=sn+1with open(filename,'wb') as f:f.write(data)print(str(sn)+"."+filename+" 已下载到本地.")print("全部靓照下载完成!")

【运行情况】

C:\hy\py>python 05-findallpic.py 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/1 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/2 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/3 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/4 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/5 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/6 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/7 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/8 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/9 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/10 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/11 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/12 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/13 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/14 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/15 找到6张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/16 找到4张靓照于网址:https://www.zhainq.com/%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f%e6%9c%ba%e6%9e%84/%e6%97%a5%e6%9c%ac%e7%be%8e%e5%a5%b3%e5%86%99%e7%9c%9f/109012.html/17 共找到100张靓照. 1.p1682-0628-89533.jpg 已下载到本地. 2.p1682-0628-89534.jpg 已下载到本地. 3.p1682-0628-89535.jpg 已下载到本地. 4.p1682-0629-89536.jpg 已下载到本地. 5.p1682-0629-89537.jpg 已下载到本地. 6.p1682-0629-89538.jpg 已下载到本地. 7.p1682-0629-89539.jpg 已下载到本地. 8.p1682-0630-89540.jpg 已下载到本地. 9.p1682-0630-89541.jpg 已下载到本地. 10.p1682-0631-89542.jpg 已下载到本地. 11.p1682-0631-89543.jpg 已下载到本地. 12.p1682-0631-89544.jpg 已下载到本地. 13.p1682-0631-89545.jpg 已下载到本地. 14.p1682-0631-89546.jpg 已下载到本地. 15.p1682-0631-89547.jpg 已下载到本地. 16.p1682-0632-89548.jpg 已下载到本地. 17.p1682-0632-89549.jpg 已下载到本地. 18.p1682-0632-89550.jpg 已下载到本地. 19.p1682-0632-89551.jpg 已下载到本地. 20.p1682-0632-89552.jpg 已下载到本地. 21.p1682-0633-89553.jpg 已下载到本地. 22.p1682-0633-89554.jpg 已下载到本地. 23.p1682-0633-89555.jpg 已下载到本地. 24.p1682-0633-89556.jpg 已下载到本地. 25.p1682-0633-89557.jpg 已下载到本地. 26.p1682-0633-89558.jpg 已下载到本地. 27.p1682-0634-89559.jpg 已下载到本地. 28.p1682-0634-89560.jpg 已下载到本地. 29.p1682-0634-89561.jpg 已下载到本地. 30.p1682-0634-89562.jpg 已下载到本地. 31.p1682-0634-89563.jpg 已下载到本地. 32.p1682-0634-89564.jpg 已下载到本地. 33.p1682-0635-89565.jpg 已下载到本地. 34.p1682-0635-89566.jpg 已下载到本地. 35.p1682-0635-89567.jpg 已下载到本地. 36.p1682-0635-89568.jpg 已下载到本地. 37.p1682-0636-89569.jpg 已下载到本地. 38.p1682-0636-89570.jpg 已下载到本地. 39.p1682-0636-89571.jpg 已下载到本地. 40.p1682-0636-89572.jpg 已下载到本地. 41.p1682-0636-89573.jpg 已下载到本地. 42.p1682-0636-89574.jpg 已下载到本地. 43.p1682-0636-89575.jpg 已下载到本地. 44.p1682-0637-89576.jpg 已下载到本地. 45.p1682-0637-89577.jpg 已下载到本地. 46.p1682-0637-89578.jpg 已下载到本地. 47.p1682-0637-89579.jpg 已下载到本地. 48.p1682-0637-89580.jpg 已下载到本地. 49.p1682-0638-89581.jpg 已下载到本地. 50.p1682-0638-89582.jpg 已下载到本地. 51.p1682-0638-89583.jpg 已下载到本地. 52.p1682-0638-89584.jpg 已下载到本地. 53.p1682-0639-89585.jpg 已下载到本地. 54.p1682-0639-89586.jpg 已下载到本地. 55.p1682-0639-89587.jpg 已下载到本地. 56.p1682-0639-89588.jpg 已下载到本地. 57.p1682-0639-89589.jpg 已下载到本地. 58.p1682-0639-89590.jpg 已下载到本地. 59.p1682-0640-89591.jpg 已下载到本地. 60.p1682-0640-89596.jpg 已下载到本地. 61.p1682-0640-89604.jpg 已下载到本地. 62.p1682-0640-89609.jpg 已下载到本地. 63.p1682-0641-89621.jpg 已下载到本地. 64.p1682-0641-89623.jpg 已下载到本地. 65.p1682-0641-89627.jpg 已下载到本地. 66.p1682-0642-89634.jpg 已下载到本地. 67.p1682-0642-89641.jpg 已下载到本地. 68.p1682-0642-89649.jpg 已下载到本地. 69.p1682-0643-89652.jpg 已下载到本地. 70.p1682-0643-89654.jpg 已下载到本地. 71.p1682-0643-89657.jpg 已下载到本地. 72.p1682-0643-89664.jpg 已下载到本地. 73.p1682-0643-89666.jpg 已下载到本地. 74.p1682-0643-89669.jpg 已下载到本地. 75.p1682-0644-89671.jpg 已下载到本地. 76.p1682-0644-89675.jpg 已下载到本地. 77.p1682-0644-89677.jpg 已下载到本地. 78.p1682-0644-89679.jpg 已下载到本地. 79.p1682-0645-89680.jpg 已下载到本地. 80.p1682-0645-89682.jpg 已下载到本地. 81.p1682-0645-89683.jpg 已下载到本地. 82.p1682-0645-89684.jpg 已下载到本地. 83.p1682-0645-89685.jpg 已下载到本地. 84.p1682-0645-89687.jpg 已下载到本地. 85.p1682-0646-89689.jpg 已下载到本地. 86.p1682-0646-89691.jpg 已下载到本地. 87.p1682-0646-89692.jpg 已下载到本地. 88.p1682-0646-89694.jpg 已下载到本地. 89.p1682-0646-89696.jpg 已下载到本地. 90.p1682-0646-89698.jpg 已下载到本地. 91.p1682-0647-89701.jpg 已下载到本地. 92.p1682-0647-89703.jpg 已下载到本地. 93.p1682-0647-89705.jpg 已下载到本地. 94.p1682-0647-89706.jpg 已下载到本地. 95.p1682-0648-89707.jpg 已下载到本地. 96.p1682-0648-89709.jpg 已下载到本地. 97.p1682-0648-89710.jpg 已下载到本地. 98.p1682-0648-89711.jpg 已下载到本地. 99.p1682-0648-89712.jpg 已下载到本地. 100.p1682-0649-89713.jpg 已下载到本地. 全部靓照下载完成!

【运行结果】

检查发现,所有图片确实如愿被下载到了本地。程序如果修改基准网址和页码范围,也能用到同网站的其它人的照片上。

END

这篇关于【Python/crawl】如何使用Python爬虫将一系列网页上的同类图片下载到本地的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!