本文主要是介绍Pytorch学习 day07(神经网络基本骨架的搭建、2D卷积操作、2D卷积层),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

神经网络基本骨架的搭建

- Module:给所有的神经网络提供一个基本的骨架,所有神经网络都需要继承Module,并定义_ _ init _ _方法、 forward() 方法

- 在_ _ init _ _方法中定义,卷积层的具体变换,在forward() 方法中定义,神经网络的前向传播具体是什么样的

- 官方代码样例如下:

import torch.nn as nn

import torch.nn.functional as Fclass Model(nn.Module):def __init__(self):super().__init__()self.conv1 = nn.Conv2d(1, 20, 5)self.conv2 = nn.Conv2d(20, 20, 5)def forward(self, x):x = F.relu(self.conv1(x))return F.relu(self.conv2(x))

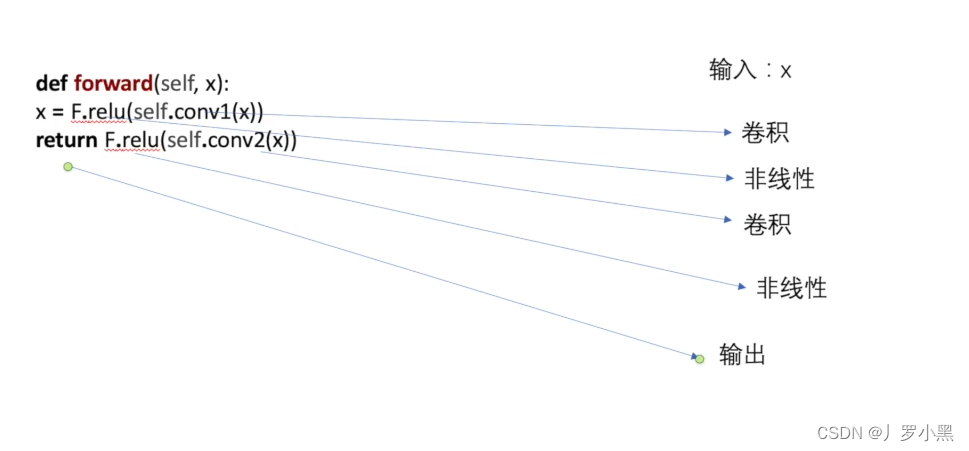

- 表明输入 x 经过一个卷积层A,一个非线性层a,一个卷积层B,一个非线性层b,最后输出,如下图:

- 简单模型代码如下:

from torch import nn

import torch# 定义一个简单的Module

class Tudui(nn.Module):def __init__(self): # 初始化函数super().__init__() # 调用父类的初始化函数def forward(self, input): # 前向传播函数output = input + 1 # 定义张量的加法运算return output # 返回输出张量tudui = Tudui() # 实例化一个Tudui对象

x = torch.tensor(1.0) # tensor()函数可以将任意数据转换为张量

print(tudui(x))

* 注意:可以在调试模式中,选择单步执行代码,一步一步执行更清晰

2D卷积操作(了解原理即可,实际直接使用卷积层)

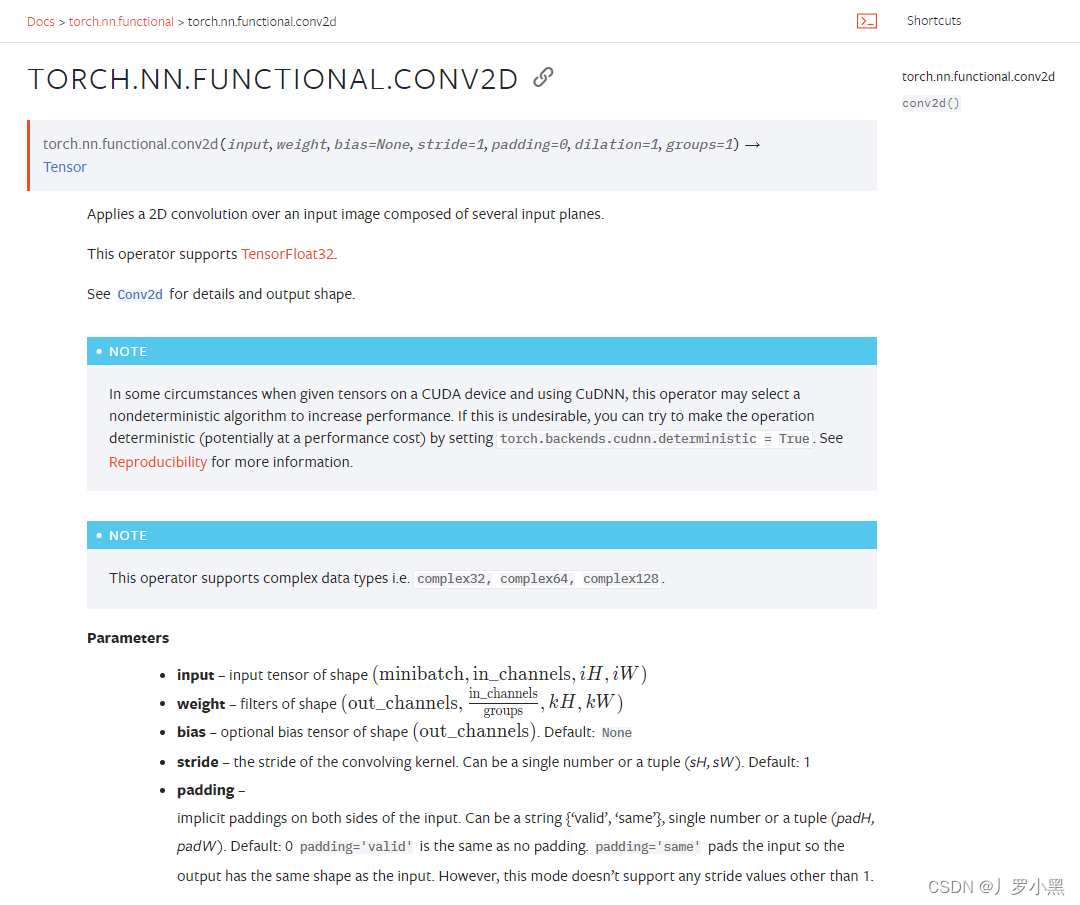

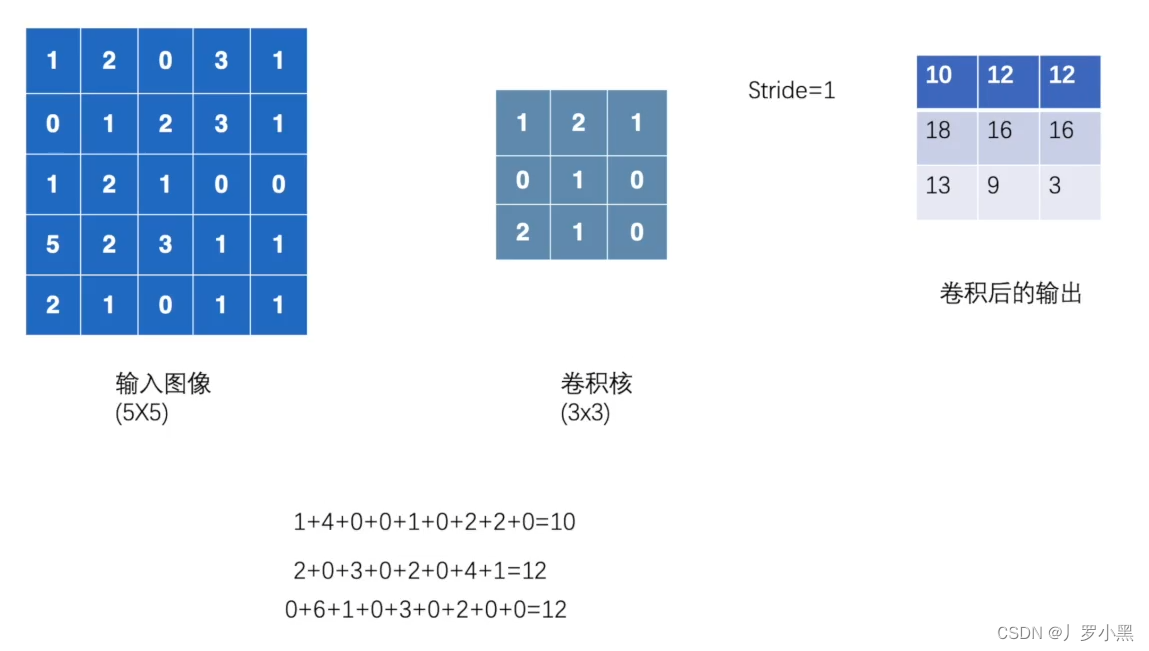

- 2D卷积操作:卷积核在输入图像上不断移动,并把对应位相乘再求和,最后得到输出结果,以下是参数设置:

- input:输入张量的维数要是四维,batch表示一次输入多少张图像,channel表示通道数,RGB图像的通道数为3,灰度图像(二维张量)的通道数为1,H为高度,W为宽度

- weight:卷积核,维数也要是四维,out_channel表示卷积核的数量,in_channel表示输入图像的通道数,一般groups为1,H为高度,W为宽度

- stride:卷积核每次移动的步长(为整数或者长度为2的元组),如果是整数,表示在水平和垂直方向上使用相同的步长。如果是元组,分别表示在水平和垂直方向上的步长。默认为1。

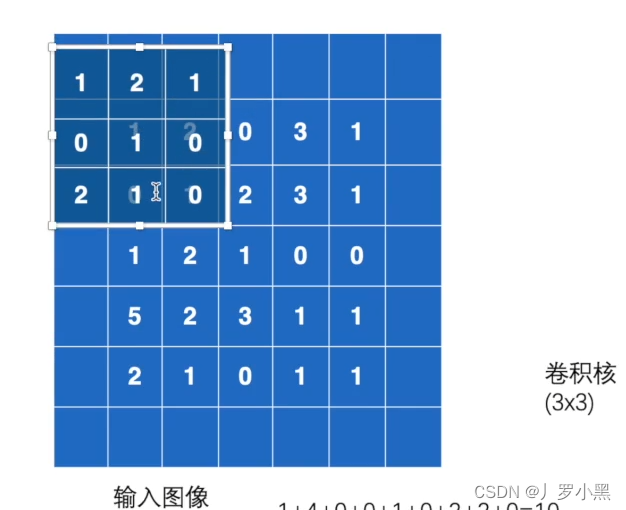

- padding:控制在输入张量的边界周围添加的零填充的数量(为整数或长度为2的元组),如果是整数,表示在水平和垂直方向上使用相同的填充数量。如果是元组,分别表示在水平和垂直方向上的填充数量。默认为0

- 例如,将一张灰度图经过2D卷积操作得到输出的代码,如下:

import torch# 因为想让输入数据是tensor类型的,所以使用torch.tensor

input = torch.tensor([[1,2,0,3,1],[0,1,2,3,1],[1,2,1,0,0],[5,2,3,1,1],[2,1,0,1,1]])# 因为想让卷积核是tensor类型的,所以使用torch.tensor

kernel = torch.tensor([[1,2,1],[0,1,0],[2,1,0]])

print(input.shape) # torch.Size([5, 5])

print(kernel.shape) # torch.Size([3, 3])# 由于卷积核的尺寸和输入的尺寸都不满足卷积运算的要求,所以需要对输入和卷积核进行维度的扩展

input = torch.reshape(input, [1,1,5,5]) # 输入是一张二维图片,所以batch_size=1(一张),通道数为1(二维张量)

kernel = torch.reshape(kernel, [1,1,3,3]) # 卷积核的个数为1,所以输出通道数为1,输入通道数由上可知为1print(input.shape) # torch.Size([1, 1, 5, 5])

print(kernel.shape) # torch.Size([1, 1, 3, 3])output = torch.nn.functional.conv2d(input, kernel, stride=1) # 经过2D卷积运算后的输出

print(output)

- 可视化图如下:

- padding设置为1的可视化图如下:

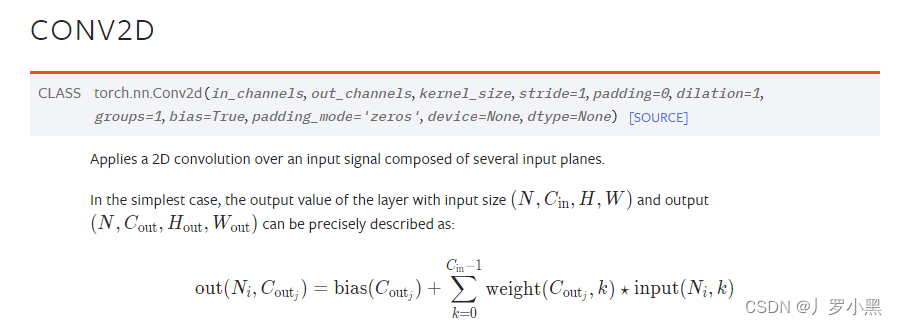

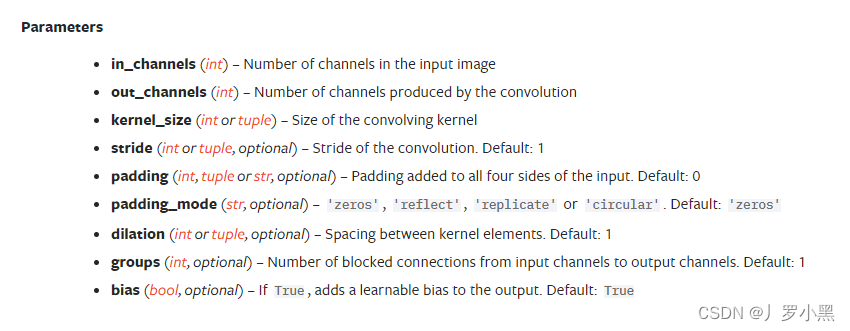

2D卷积层

- 2D卷积层,通常我们直接使用卷积层即可,上一节仅供了解,以下是参数设置:

- in_channels:输入通道数,RGB图像为3,灰度图像为1

- out_channels:输出通道数,即卷积核的个数

- kernel_size:卷积核的高宽(整数或元组),整数时表示高宽都为该整数,元组时表示分别在水平和垂直方向上的长度。我们只需要设置卷积核的高宽,而卷积核内部的具体参数不需要我们指定,它是在神经网络的训练中不断地对分布进行采样,同时进行不断调整

- stride:卷积核每次移动的步长(整数或元组),整数时表示在水平和垂直方向上使用相同的步长。元组时分别表示在水平和垂直方向上的步长。默认为1。

- padding:控制在输入张量的边界周围添加的零填充的数量(为整数或元组),如果是整数,表示在水平和垂直方向上使用相同的填充数量。如果是元组,分别表示在水平和垂直方向上的填充数量。默认为0

- padding_mode:控制以什么样的模式进行填充,默认为 zeros 零填充

- dilation:卷积核之间的距离,空洞卷积,默认为1

- groups:默认为1

- bias:给输出加一个偏置,默认为True

- 以下是2D卷积层的可视化图像,青色的为输出图像,蓝色为输入图像,深蓝色为卷积核:

|  |

|---|---|

| No padding,No strides | Aribitrary padding,No strides |

|  |

|---|---|

| Half padding,No strides | Full padding,No strides |

|  |  |

|---|---|---|

| No padding,strides | Padding,strides | Padding,strides(odd) |

这篇关于Pytorch学习 day07(神经网络基本骨架的搭建、2D卷积操作、2D卷积层)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!