本文主要是介绍A Survey of Text Watermarking in the Era of Large Language Models,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本文介绍首个大模型时代下的文本水印综述,由清华、港中文、港科广、UIC、北邮联合发布,全面阐述了大模型时代下文本水印技术的算法类别与设计、评估角度与指标、实际应用场景,同时深入探讨了相关研究当前面临的挑战以及未来发展的方向,探索文本水印领域的前沿趋势。

-

论文:A Survey of Text Watermarking in the Era of Large Language Models

-

论文链接:https://arxiv.org/abs/2312.07913

大模型时代:文本水印新纪元

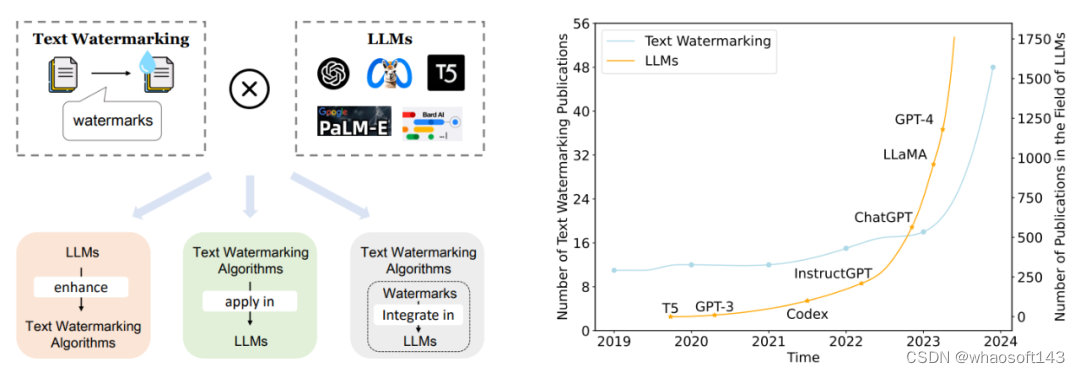

文本水印是一种信息隐藏技术,起源可以追溯到上个世纪 90 年代。它通过将机密信息(水印)嵌入文本中,实现了在共享水印规则的个体之间进行安全、隐式的消息传递。

随着大语言模型(LLMs)的崛起,文本水印技术焕发新生,涌现出多种可能:

-

将现有文本水印算法应用于 LLMs?

-

将 LLMs 运用于文本水印算法设计?

-

将水印直接植入 LLMs?

特别是随着 ChatGPT 的出现,文本水印技术更是被推向研究热潮。本综述将揭秘 LLMs 与文本水印技术的梦幻联动,深入探索文本水印新纪元!

1. 文本水印技术保障大模型使用安全

近年来,大语言模型在自然语言处理领域取得显著进展,但其快速生成文本的能力也带来了信息传播和知识产权方面的挑战。文本水印技术通过嵌入可识别的标记来实现内容追踪和来源归属,是解决大语言模型滥用问题的有效方法。

2. 大模型辅助文本水印算法设计

在文本水印算法设计中一个关键挑战是在不扭曲原始文本的含义或可读性的情况下嵌入水印。传统方法通常无法在修改文本时做到较好的语义保持。然而,大语言模型(LLMs)显著改变了这一格局。由于它们对语义和上下文的精准把握,LLMs 能够实现精细的水印嵌入方法,对文本的内在含义影响最小化。

3. 大模型 × 文本水印全新探索:水印植入大模型

随着越来越多的文本直接由大模型生成,研究直接针对大模型的水印技术已经成为一种趋势。被植入水印的大模型(Watermarked LLMs)可以直接生成水印文本,以从而实现更为直接、快捷的水印嵌入。

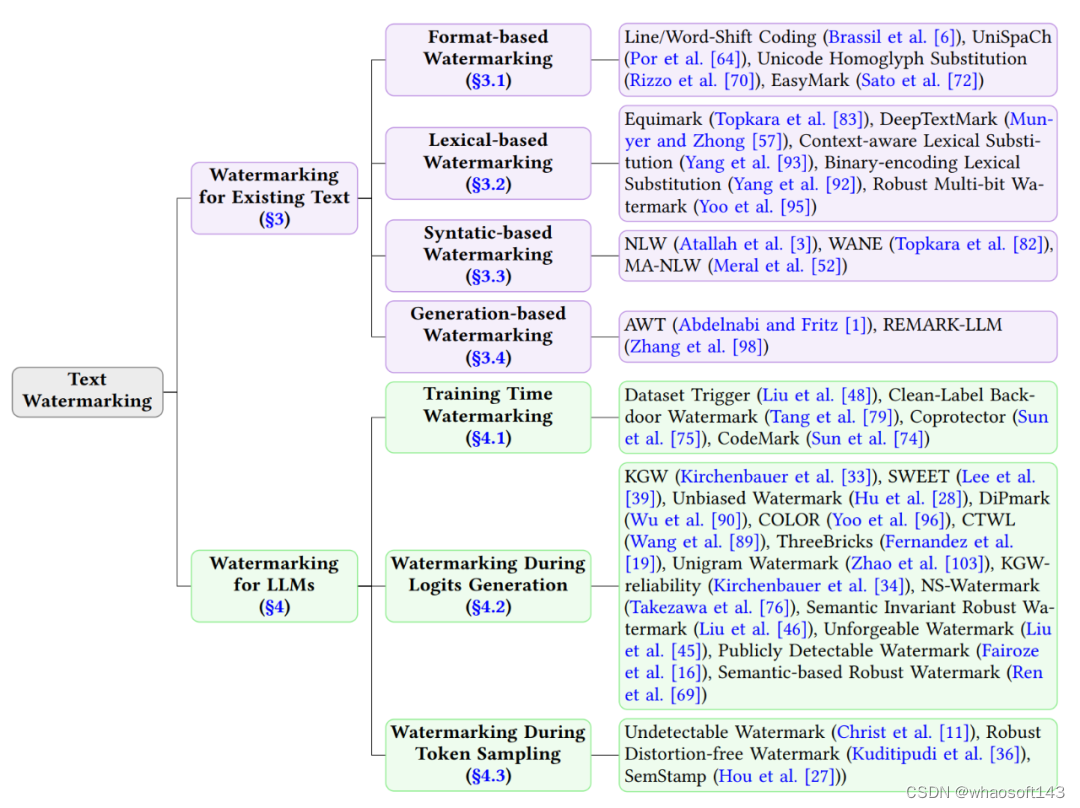

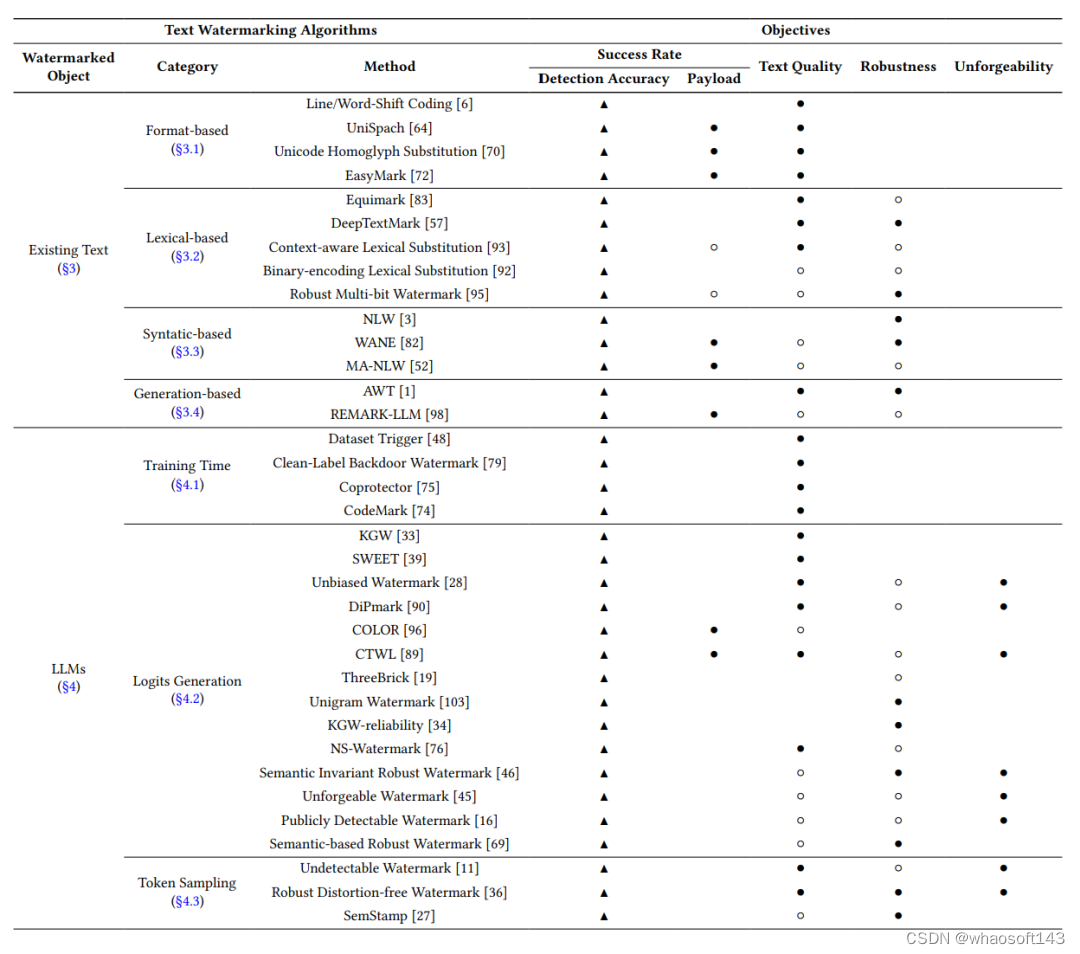

文本水印算法大汇总

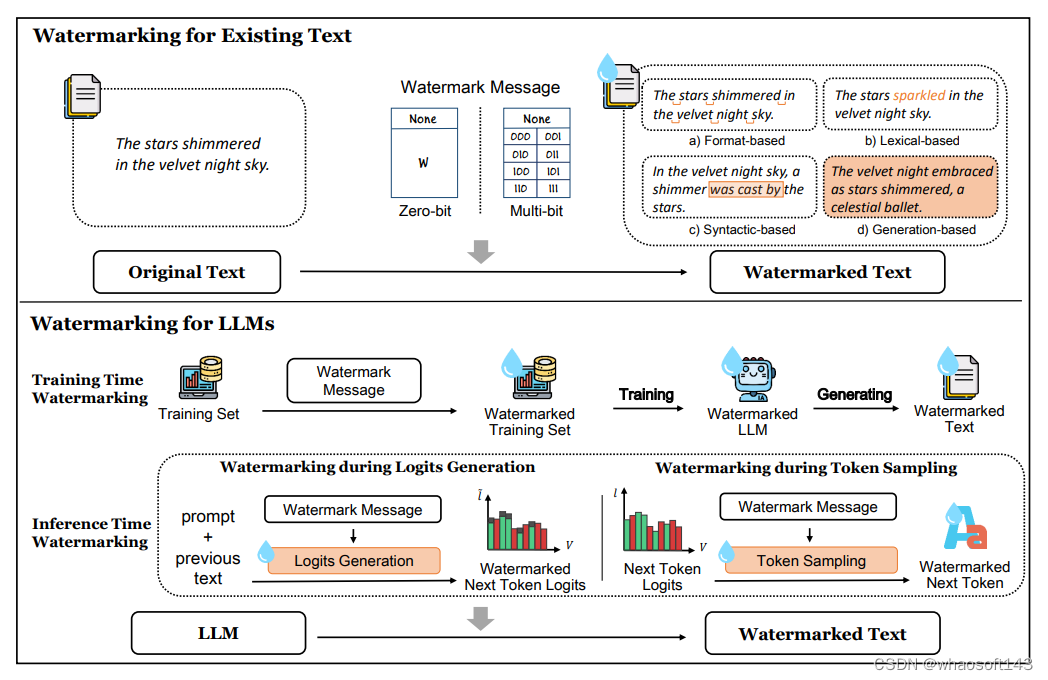

现有的文本水印算法可以根据植入水印的对象不同分为两大类:Watermarking for Existing Text,向现有文本中嵌入水印;Watermarking for LLMs, 向大模型中植入水印。其中,Watermarking for Existing Text 又可以根据水印规则的不同细粒度地划分为:

-

Format-based Watermarking

-

Lexical-based Watermarking

-

Syntactic-based Watermarking

-

Generation-based Watermarking

Watermarking for LLMs 可以根据水印加入的时间划分为:

-

Watermarking during LLM Training

-

Watermarking during Logits Generation

-

Watermarking during Token Sampling

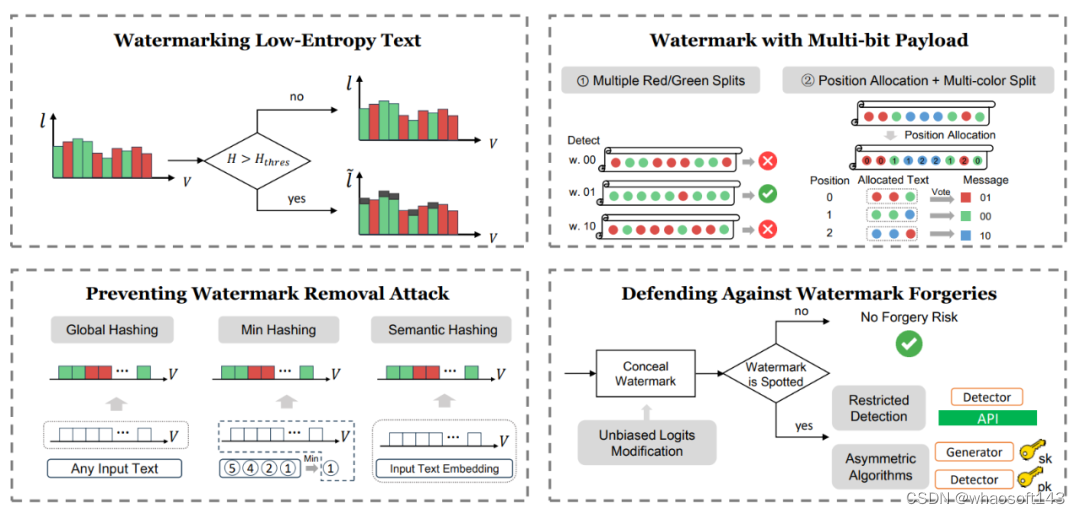

近期,随着 LLM 的兴起和广泛使用,Watermarking for LLMs 类别下的研究层出不穷。尤其在 Watermarking for Logits Generation 子类下,更是有许多侧重于各个角度的创新方法被提出,例如如何应对低熵文本、如何让文本携带多比特信息、如何高鲁棒地应对攻击者的篡改、如何抵御水印伪造等等。

如何评估一个文本水印算法?

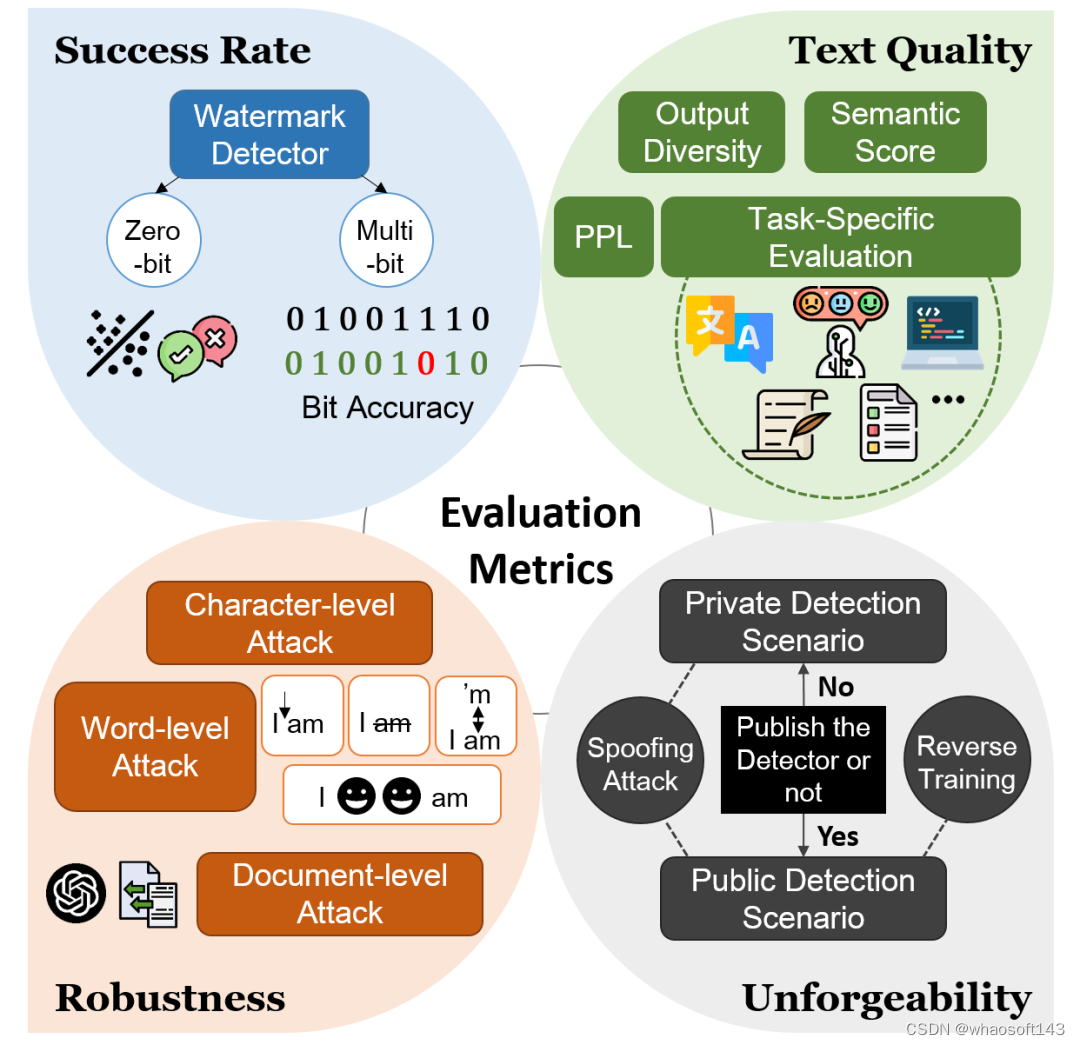

在该综述中,作者系统性地将文本水印算法的评估总结为四个角度:Success Rate(成功率)、Text Quality(文本质量)、Robustness(鲁棒性)、Unforgeability(不可伪造性)。

-

Success Rate:检测水印信息的准确性

-

Text Quality:水印算法对文本质量的影响

-

Robustness:应对 “水印移除攻击” 的鲁棒性

-

Unforgeability:抵制水印伪造的能力

作者还对每个评估角度下现有的评估指标做了全面的总结。

1. Success Rate(成功率):对于零比特水印算法(Zero-bit),检测过程等价于一个二分类问题,评估指标包括 F1、TPR、FPR、TNR、FNR 等;对于多比特水印算法(Multi-bit),则需要考虑文本水印算法能够携带的负载量(Payload),同时在检测时需要关注比特正确率(Bit Accuracy)。

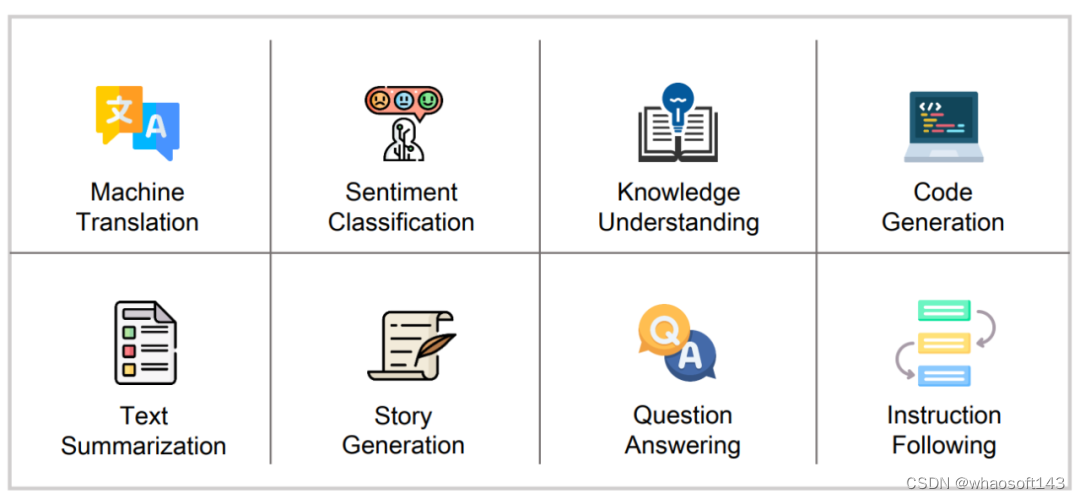

2. Text Quality(文本质量):评估水印算法对生成文本质量的影响有多种指标,例如 PPL(困惑度)、基于预训练模型编码的语义相似度检测、文本丰富性评估等。此外,还有许多研究在下游的 NLP 传统任务上对水印文本的质量进行评估。这些下游任务包括:机器翻译、情感分类、知识理解、代码生成、文本总结、故事续写、问答、指令遵循等。

3. Robustness(鲁棒性):用于测试水印算法鲁棒性的水印移除攻击可以分为字符级(character-level)、单词级(word-level)和文档级(document-level)三大类。字符级的攻击方式包括 Homoglyph Attack(同形字符替换攻击)等,单词级的攻击方式包含同义词替换、Emoji Attack 等,文档级攻击包括重写攻击、Copy-Paste Attack 等。

4. Unforgeability(不可伪造性):不可伪造性需要在两种不同的检测场景下分别考虑。在私密检测场景(Private Detection Scenario)下,也就是水印检测器不公开的情况下,攻击者只能从生成的文本中寻找蛛丝马迹,试图攻破水印规则。这里的攻击方式包括训练分类器,以及词频分析(Spoofing Attack)等。在公开检测场景(Public Detection Scenario)下,也就是水印检测器公开的情况下,攻击者不仅可以从生成的文本中寻找线索,还可以通过分析检测器的结构和算法来反推生成器的设计。这里的攻击方式在私密场景攻击方式的基础上,还包括逆向工程(Reverse Training)等等。

此外,作者还整理了现有的文本水印算法在这四个评估角度下做出的优化尝试,▲代表基础优化目标,● 代表首要优化目标,○ 代表次要优化目标。

文本水印技术的应用场景

大模型时代下,文本水印技术的应用场景得到了进一步的拓广。本综述关注了新纪元下文本水印技术的三大应用场景:版权保护、学术诚信和虚假新闻检测。

1. 版权保护:文本水印在保护文本 / 数据集版权以及保护大模型版权上发挥了至关重要的作用。

-

文本 / 数据集版权保护:在数字时代,随着数据的共享和利用不断增加,保护这些资产免受非法复制和滥用的影响变得至关重要。文本水印技术通过在文本和数据集中嵌入不可察觉的标记,有助于维护知识产权。

-

大模型版权保护:大模型版权保护的关键目标是防御抽取攻击,即从 LLMs 中提取大量数据用于训练新模型。通过在 LLMs 的输出中嵌入水印,使用带水印的数据集进行训练后得到的新模型也会带有水印特征。当前的研究工作已经为各种 LLM 类型开发了水印算法,包括嵌入式(输入是文本,输出是该文本的相应嵌入)、生成式(目前最常用的 LLM,其输入和输出都是文本)和分类式(输入是文本,输出是特定的类别)的 LLM。

2. 学术诚信:在当今的教育领域,学术诚信问题尤为重要。尤其是考虑到 LLMs 的轻松获取和使用,学生可能会利用这些先进的模型完成作业、论文,甚至参加考试,这给维护学术诚信带来了新的挑战。在需要学生独立和原创完成的任务或考试中,有必要制定方法来判定提交的内容是否由 LLMs 生成。文本水印技术通过在 LLMs 的输出中嵌入隐式的水印特征,可以高效地检测机生文本,为维护学术诚信做出贡献。

3. 虚假新闻检测:随着 LLMs 技术的兴起,它在创建令人信服但有潜在错误或误导性内容上信手拈来,这使 LLMs 成为制造虚假新闻的有效工具,从而欺骗公众并扭曲事实。在数字时代下,这些虚假信息在数字平台上的迅速繁衍加剧了错误观点的传播,侵蚀了公众对可靠信息源的信任。因此,识别由 LLMs 生成的新闻至关重要。文本水印技术通过在 LLMs 的输出中嵌入隐式的水印特征,可以高效地检测机生新闻,为维护新闻的真实和纯净做出贡献。

挑战与机遇并存:

大模型时代下的文本水印技术将何去何从?

在本综述中,作者以前瞻性的眼光分析了大模型时代下文本水印技术仍然面临的挑战,给出了未来可能的发展方向,对文本水印技术的前沿趋势做出了深度探索。 whaosoft aiot http://143ai.com

1. 探索平衡不同评估角度的文本水印算法

如上文提到的那样,评估一个文本水印算法可以有不同的视角。然而,这些视角通常存在固有的矛盾,使得一个文本水印算法难以同时在所有评估视角中表现优异。例如,在高负载情况下实现成功率、文本质量和鲁棒性之间的良好平衡是困难的。

-

平衡负载、鲁棒性和文本质量:关键主要在于设计更有效的策略来划分水印文本空间。这可能需要额外的设计来对抗潜在的水印去除攻击,将水印空间划分为不同的水印消息域,确保在不同水印消息域之间过渡需要足够数量的水印去除攻击操作。其次,从负载的角度来看,可以从纠错码的概念中汲取灵感,例如利用汉明码,以提高从部分修改的文本中恢复原始水印信息的概率。这些方法可以有效增强负载和鲁棒性,同时对文本质量产生一致的影响。

-

增强文本水印的不可伪造性:通常需要利用密码学、信息理论和机器学习等领域的专业知识。这涉及增加水印算法的复杂性,以提高其抵抗伪造的能力。尽管当前的方法取得了一些进展,但它们更为复杂的设计仍引入了额外的非鲁棒因素。此外,这些方法尚未在具有更大负载的场景中推广应用。

2. 探索适应更具挑战性实用场景的文本水印算法

水印算法在简单环境中表现良好,但在面对低熵和公开检测情境时需要进一步改进。低熵情境下,由于文本多样性和复杂性较低,嵌入水印而不影响严格格式要求具有挑战性。在公开检测情境中,水印的存在和检测机制公开可见,要求算法足够复杂和不可预测,同时保持生成方法的安全性和实用性。未来的方法可能涉及更精密的加密和机器学习技术。

3. 制定更全面的评估基准

目前文本水印基准研究主要关注文本质量,对其他关键指标如高成功率、鲁棒性和防伪性的基准较为有限。因此,未来的重要方向之一是建立更全面的基准系统。构建这样的基准需要考虑各种应用场景、攻击方法和不同水印算法的特征,同时确保建立一个公平、透明、用户友好的评估过程,使研究人员能够在统一标准下测试和比较算法。这一基准系统将推动学术研究和帮助行业更好地理解和应用文本水印技术。

4. 拓宽文本水印技术的应用场景

尽管文本水印技术在多个领域展示了其实用性,但要实现更广泛的应用还需要进一步努力。这不仅包括水印技术的进步,还涉及技术领域以外的因素,包括 LLM 提供者的参与、公众信任和透明度等。

-

LLM 提供者的参与:随着大型语言模型生成大量文本,有必要将文本水印功能整合到它们的服务中促进文本水印的使用。然而,目前这些提供商在文本水印技术上的参与不足,受到技术和非技术因素的制约。现有算法需要更全面地考虑对文本质量的影响,未来的研究应重点关注提供商直接受益的领域,如保护模型版权。

-

公众信任和透明度:公众信任和透明度是推动文本水印技术广泛应用的关键因素。只有当公众信任文本水印算法并相信其检测结果准确时,它们才能在实际应用中发挥作用。为增强公众信任,需要确保水印技术的透明度和可靠性。全面披露文本水印检测算法的细节是关键步骤,透明度不仅培养用户信任,还推动了学术和工业的发展。引入独立第三方平台进行检测和验证可以加强信任,政府和监管准则有助于确保技术的公正和透明度,提高公众信心。

结语

本综述深入探讨了在 LLMs 时代下文本水印技术的发展现状,全面总结了其算法设计与实现、评估角度与方法、在版权保护、学术诚信和假新闻检测等领域的应用,以及该领域的挑战和未来方向。作者热切欢迎学术界和行业专家就大模型时代下文本水印的研究议题进行广泛的交流和讨论。希望这不仅仅是一份综述论文,更是一个激发深入思考与广泛交流的契机。

这篇关于A Survey of Text Watermarking in the Era of Large Language Models的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[论文笔记]Making Large Language Models A Better Foundation For Dense Retrieval](https://img-blog.csdnimg.cn/img_convert/6dbbf911e7e57daa6ac5366f311e3e68.png)