本文主要是介绍Adaboost——三个臭皮匠赛过诸葛亮,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

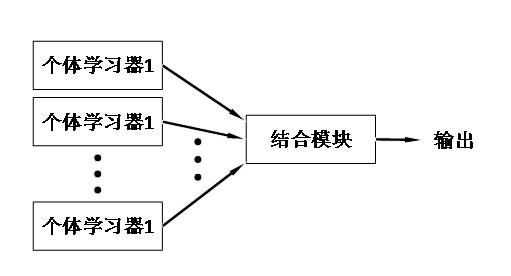

古人云“三个臭皮匠赛过诸葛亮”,以adaboost为代表的集成学习正是体现了古人的这个智慧,也就是说,对于弱学习器(性能比较差的学习器),通过某种算法把它们结合起来,使它们能够有缺互补,那么它们就能赛过诸葛亮(强学习器)。下面是集成学习的示意图。

图 1集成学习示意图

对于个体学习器,可以使用同类学习算法,也可以是不同类学习算法。理想的个体学习器是</

这篇关于Adaboost——三个臭皮匠赛过诸葛亮的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!