本文主要是介绍Multi-Sample based Contrastive Loss for Top-kRecommendation(IR 2021),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在 CL 中,将同一批次中的所有非正样本作为负样本,可以简单的快速获取大量负样本,CL_loss 意在最大化正对的相似性并最小化负对的相似性。而BPR 一般采用随机抽取的方式使用一个或几个负样本,BPR_loss意在最大化正样本和负样本之间的距离。它们都是通过对比过程学习的,所以BPR 损失也可以看成对比损失的一种。

为解决 CL 中正负样本不均衡的问题,作者提出了多采样正样本的 CL ,如上图。正负样本添加了权重来权衡它们之间的重要性,还可以同时使用多个正样本来参与 CL。

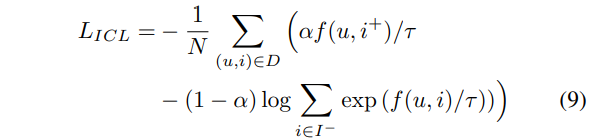

ICL (加入权重后的 CL_loss): a ∈(0,1)

MCL(基于多个正样本的CL):针对正样本使用不足的问题,文中提出了一种同时使用多个正样本的新数据增强方法。传统的做法是在模型计算完成后&

这篇关于Multi-Sample based Contrastive Loss for Top-kRecommendation(IR 2021)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[SWPUCTF 2021 新生赛]web方向(一到六题) 解题思路,实操解析,解题软件使用,解题方法教程](https://i-blog.csdnimg.cn/direct/bcfaab8e5a68426b8abfa71b5124a20d.png)