本文主要是介绍jieba+wordcloud分析豆瓣惊奇队长影评,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

复联三过后或许你还惊魂未定就被惊奇队长里的噬元兽吓到恐猫,whatever,本文将会介绍如何从豆瓣爬取惊奇队长的短评并加工处理生成词云。

爬取评论

首先还是爬取评论,老规矩用requests和BeautifulSoup就行。通过查看网页源码容易发现所有的短评都放在span标签中且class为short,这样就很方便了,用find_all就完事了。

# -*- coding:utf-8 -*-

import requests

import time

import random

from bs4 import BeautifulSoupurls = []

for i in range(0, 500, 20):urls.append('https://movie.douban.com/subject/26213252/comments?start=' + str(i) + '&limit=20&sort=new_score&status=P') # 评论的翻页def singlepage_comment(url):# 得到单页的评论headers = {'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko)''Chrome/65.0.3325.162 Safari/537.36'}html = requests.get(url, headers)html.encoding = 'utf-8'soup = BeautifulSoup(html.text, 'lxml')fk = []for comment in soup.find_all(name='span', class_='short'):fk.append(comment.text)return fk# singlepage_comment('https://movie.douban.com/subject/26213252/comments?start=40&limit=20&sort=new_score&status=P')def store_comment(fk):# f = open('comments.txt', mode='w', encoding='utf-8')for comment in fk:f.write(comment)f.write('\n\n')# f.close()f = open('comments.txt', mode='w', encoding='utf-8')

for url in urls:comments = singlepage_comment(url)#print(comments)store_comment(comments)time.sleep(random.randrange(1, 3)) # 反爬f.close()分词

分词这个部分使用jieba

具体的使用可以参考 https://github.com/fxsjy/jieba

安装使用的话 pip3 install jieba

ps. 若此处遇到安装错误的情况可能是pip版本太旧导致,运行python -m pip intsall --upgrade pip即可。

#-*- coding:utf-8 -*-

import jiebaf = open('comments.txt', mode='r', encoding='utf-8')comments = f.readlines()#sentence = "1.第一次看电影片头就有人鼓掌,Thank You Stan;2.漫威还是比DC会选角,神奇女侠完全是物化女性审美,惊奇队长是真女权,没有任何爱情戏,是女人就靠自己;3.铲屎官噩梦。"jieba.load_userdict('dict.txt')for comment in comments:seg_list = jieba.cut(comment)print("Full Mode: " + "/ ".join(seg_list))对于这样一个语境,使用默认的字典分词会得到一些奇怪的结果,例如

Full Mode: 1/ ./ 第一次/ 看/ 电影片/ 头/ 就/ 有人/ 鼓掌/ ,/ Thank/ / You/ / Stan/ ;/ 2/ ./ 漫威/ 还是/ 比/ DC/ 会选角/ ,/ 神奇/ 女侠/ 完全/ 是/ 物化/ 女性/ 审美/ ,/ 惊奇/ 队长/ 是/ 真/ 女权/ ,/ 没有/ 任何/ 爱情/ 戏/ ,/ 是/ 女人/ 就/ 靠/ 自己/ ;/ 3/ ./ 铲/ 屎/ 官/ 噩梦/ 。

可见jieba并不能识别出例如惊奇队长、漫威、铲屎官、噬元兽等角色名以及一些简写、网络语言等,因此需要手动添加用户词典,这里我添加了一些常见的名词。

ps.这个列表可以通过查看分词的结果逐步加以调整

惊奇队长

漫威

DC

神奇女侠

美国队长

铲屎官

噬元兽

复联4

咕咕

尼克费瑞

寇森

美队

斯坦李

银河护卫队

添加用户词典后,分词的准确性和有效性就大为增长。

生成词云

这一步相对就较为简单了。

同样先安装wordcloud库pip3 install wordcloud

还需要用到matplotlib 这是一个画图的库

#-*- coding:utf-8 -*-

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import jiebaf = open('comments.txt', mode='r', encoding='utf-8')

comments = f.readlines()

jieba.load_userdict('dict.txt')text = ''

for comment in comments:text += ' '.join(jieba.cut(comment))wordcloud = WordCloud(font_path="C:/Windows/Fonts/msyh.ttc",background_color="white",width=1000,height=880,stopwords={'漫威','惊奇队长','电影','就是','没有','一个','什么','还是','不是','可以','真的','角色','剧情','这个'}).generate(text)plt.imshow(wordcloud, interpolation="bilinear")

plt.axis("off")

plt.show()

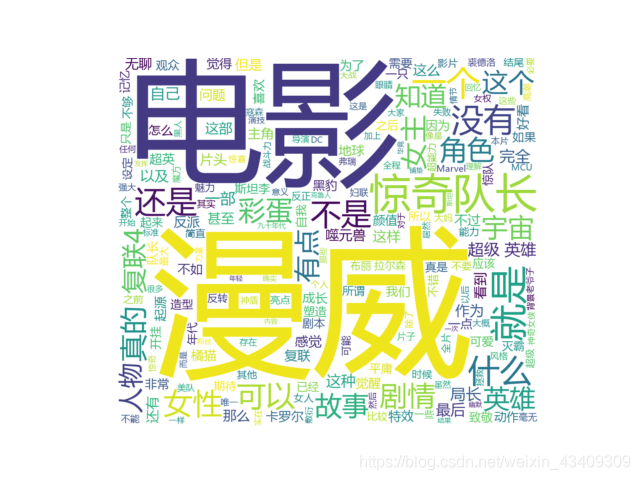

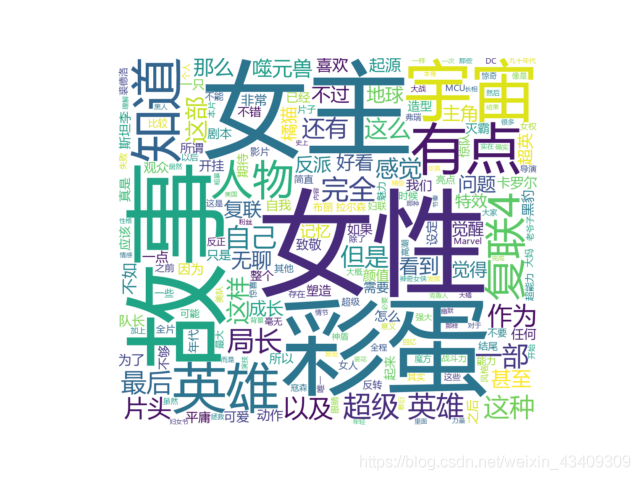

同样需要注意的是停用词。

在未启用停用词前会有大量的干扰,例如漫威、电影、惊奇队长等与分析无关的词。在不断调整停用词后,就能得到一个比较有参考意义的词云。

之后生成的词云就比较有参考意义。

这篇关于jieba+wordcloud分析豆瓣惊奇队长影评的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!