本文主要是介绍[MM18]BeautyGAN: Instance-level Facial Makeup Transfer with Deep Generative Adversarial Network,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

BeautyGAN: Instance-level Facial Makeup Transfer with Deep Generative Adversarial Network

- ACM MM 2018

- http://liusi-group.com/projects/BeautyGAN

- facial makeup transfer | generative adversarial network

一、摘要

妆容迁移的目的在于从给定的一个带妆图片中的化妆风格迁移到一张不带妆的照片中,并且保留其面部特征。属于局部风格迁移。

这种实例级别的风格迁移比常规的域迁移更具有挑战性:

- 没有成对的训练数据。

- 不同于全局风格迁移(例如绘画),其迁移的区域是局部的风格(眉毛、嘴唇)。现有的方法对提取迁移局部的精的特征不可行。

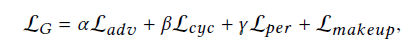

BeautyGAN:综合考虑global domain-level loss, 和local instance-level loss. 使用两个输入输出的GAN网络。总的损失函数包括四个部分:

- Domain-Level:其中判别器将生成的图像和真实图像的区别开。

- Instance-Level:计算分离的局部面部像素级直方图loss。

- Perceptual Loss和Cycle Consistency Loss生成高质量面部并且保留面部特征。

此外还开源了一个数据集,包括3834张高分辨率的面部照片。

二、研究背景

例如美图秀秀等传统的虚拟画妆工具需要用户手动的进行交互,并且只提供一小部分固定的妆容风格。

而自动的妆容迁移是一种帮助用户选择最合适的妆容风格的有效方法,通过给定一些妆容的参考,可以在不改变面部特征的情况下,实现自动对不带妆的照片进行上妆。

目前自动的妆容迁移技术主要分为两类:传统的图像处理方法和深度学习的方法。其中图像处理方法通常将图像分解成几层(例如,面部结构,颜色,皮肤),将参考面部图像变形为非化妆图像之后,将每一层迁移。深度学习的方法采用几个独立的网络单独处理不同的妆容。之前的方法将妆容的风格看作为不同“容器”的简单的组合,因此,在组合位置时,整体输出图像看起来不自然。

妆容迁移是无法直接使用端到端的结构产生高质量的图像的,因为妆容迁移存在以下问题:

- 化妆风格因人而异,需要在实例级别进行转换。(GAN主要用于域级别的迁移,例如CycleGAN强调域内不同,忽视了域间的区别)。

- 妆容风格不仅仅是全局的风格,还包括独立的局部风格。因此在保留不同化妆品不同的特征下,很难抽取全局的妆容风格。(传统的风格迁移更多的是从全局风格迁移,例如笔触、颜色风格。而妆容风格更加的精细,对于不同的化妆部位,都有不同的风格)。

- 缺少数据集,尤其是很难获得具有不同化妆风格的一对对齐的面部图像。所以需要进行非监督学习。

BeautyGAN:

网络首先使用几个判别器将非化妆脸部转移到化妆域,以区分从domain真实样本生成的图像。在域级别迁移的基础上,在不同面部区域的计算用像素直方图损失实现实例级别的迁移。为了保留脸部特征,还在整体损失函数中加入了感知损失和循环一致性损失。

三、论文贡献

- 通过双重输入/输出的生成对抗网络实现自动妆容迁移。

- 通过在局部区域使用像素级直方图损失来实现实例级别风格迁移。

- 开源了妆容数据集,包括3834张高分辨率照片。

四、网络结构

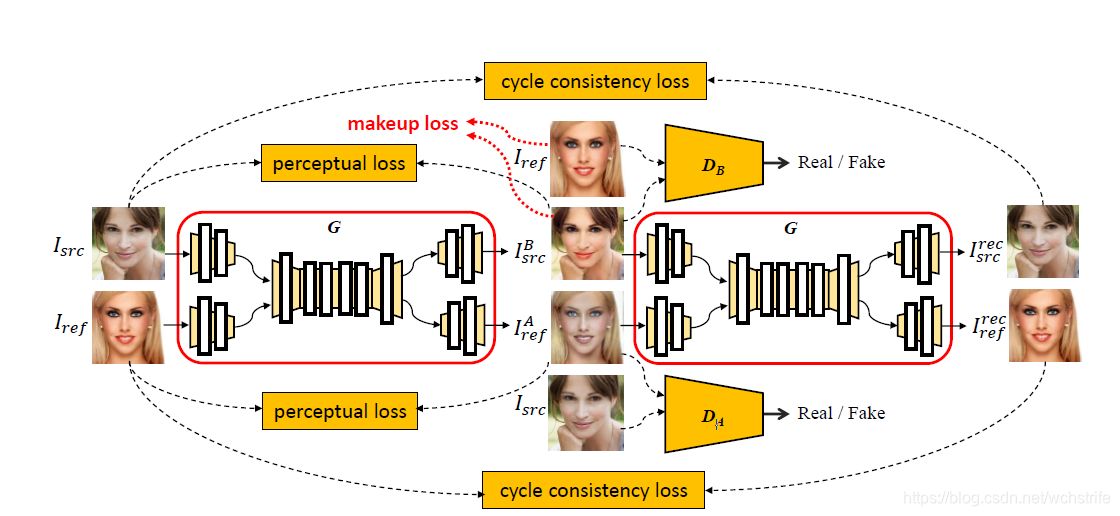

两张图片作为输入,A是不带妆的图片的集合,B是带妆的图片集合。

其中 I s r c I_{src} Isrc作为不带妆的源图片, I r e f I_{ref} Iref作为带妆的参考图片。

网络输出为 I s r c B I_{src}^{B} IsrcB作为带妆的源图片:在保留源图片的面部特征下,合成参考图片的妆容风格。

I r e f A I_{ref}^{A} IrefA作为不带妆的参考图片:参考图片去掉妆容的图片。

首先输入两张图片,然后通过不同的两组卷积提取特征,然后concatenate在一起,

输入residual block中,之后通过两组反卷积,将输出的feature map上采样,生成 I s r c B I_{src}^{B} IsrcB和 I r e f A I_{ref}^{A} IrefA

生成的图片再次经过同样的G得到最终的 I s r c r e c I^{rec}_{src} Isrcrec和 I r e f r e c I^{re c}_{ref} Irefrec。

注意:

-

生成器G使用了instance normalization

-

判别器 D A D_A DA, D B D_B DB中使用了 70*70 的 Patch GAN

总的Loss函数包括四个部分:

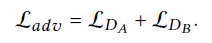

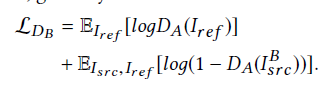

4.1 GAN Loss

GAN Loss主要是使得生成的图片更加逼真。

其包括两个判别器 D A D_A DA、 D B D_B DB的对抗损失

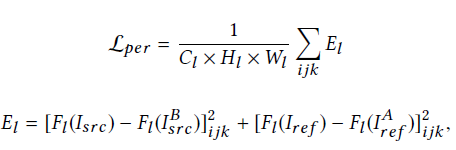

4.2 Perceptual Loss

Perceptual Loss 的目的在于更好的保留图片的面部特征。

首先使用16层的VGG网络在ImageNet上做预训练, F l ( x ) F_l(x) Fl(x)表示图片X在VGG中第i层的特征, C l , H l , W l C_l, H_l, W_l Cl,Hl,Wl分别是feature map的数量、高度、宽度。

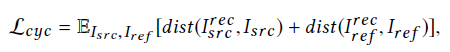

4.3 Cycle Consistency Loss

Cycle Consistency Loss 目的在于保持背景信息的一致。

通过直接对比生成图像和原图像的距离,L1或者L2距离都可以。

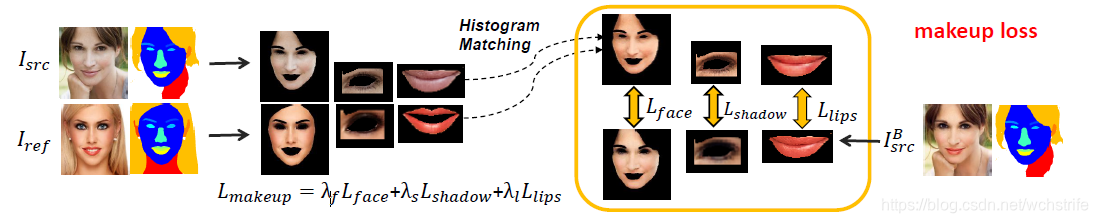

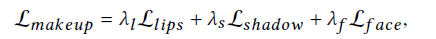

4.4 Makeup Loss

Makeup Loss目的在于迁移时只将化妆部位的颜色迁移过来,而不改变源图的形态。具体的方法是采用直方图匹配(Histogram Matching)。

首先先对 I s r c I_{src} Isrc, I r e f I_{ref} Iref, I s r c B I_{src}^{B} IsrcB面部进行分割,采用的方法是PSPNet,得到不同部位的Mask,在所有的Mask中只挑选出face eye lip部分进行二值化,得到 M l i p M_{lip} Mlip, M l e y e M_{leye} Mleye, M f a c e M_{face} Mface.。

然后用该模板与对应的图像相乘,得到源图片x和参考图片y的不同部位。

对这些部位进行颜色直方图匹配,得到相同颜色分布的H(x,y),其保留了x的特征,和y的颜色分布。

然后对生成的带妆图 I s r c B I^B_{src} IsrcB和直方图匹配的函数进行对比。

五、实验效果

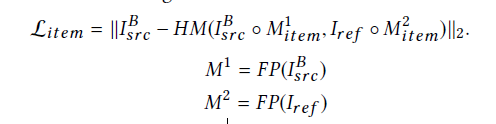

5.1 定性分析

- Guo[11]-Digital Face Makeup:传统方法,效果不真实、轮廓不准确,细节迁移的不对

- Gatys[8]:颗粒感,没有对妆容进行迁移

- Liu[23]-DTN:对于不同的妆部分独立的迁移:边缘有缺陷,面部和眼影迁移的不好

- Liao[21]:Deep Image Analogy:妆容迁移的细节较好,但是背景也被错误的迁移了过来。

- Cycle-GAN[35]:并没有进行迁移妆容

其实后面两种方法是对整体的画面风格进行迁移,所以效果有所缺陷。

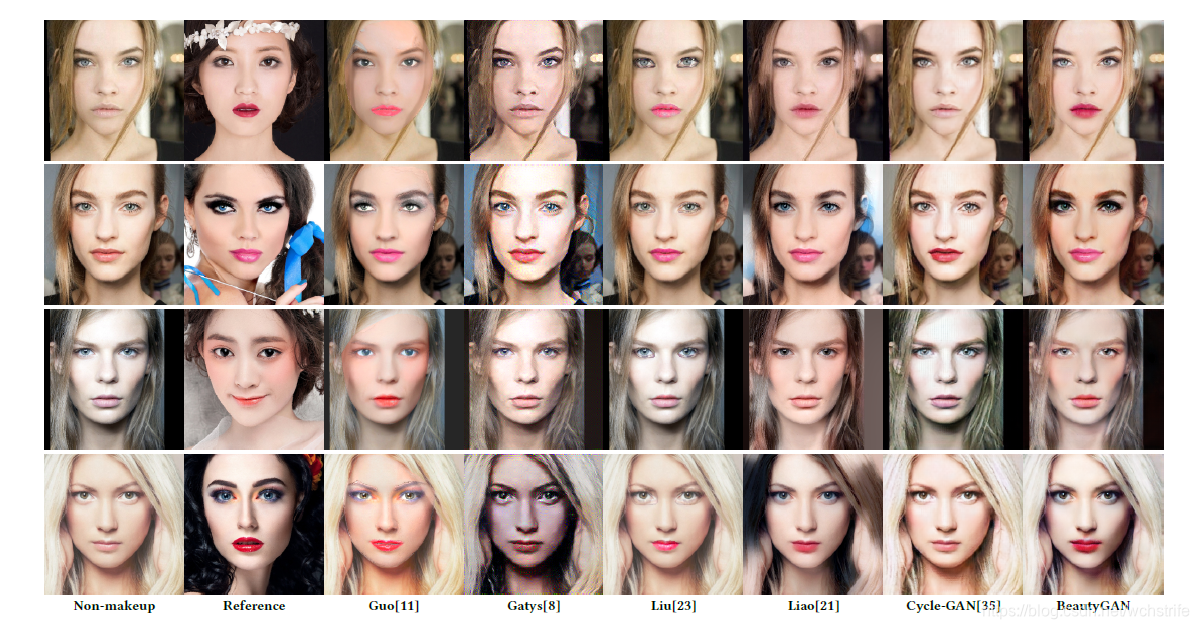

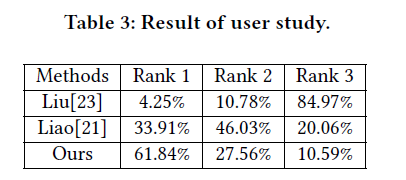

5.2 定量分析

利用人对不同方法生成的图片进行打分,可以看到BueatyGAN打分在RANK1区间的最高,所以效果最好。

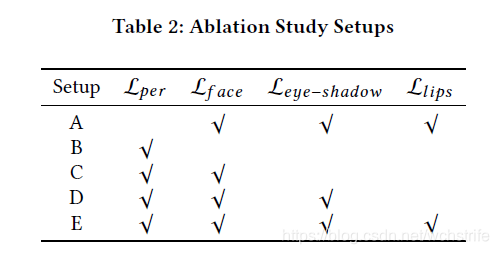

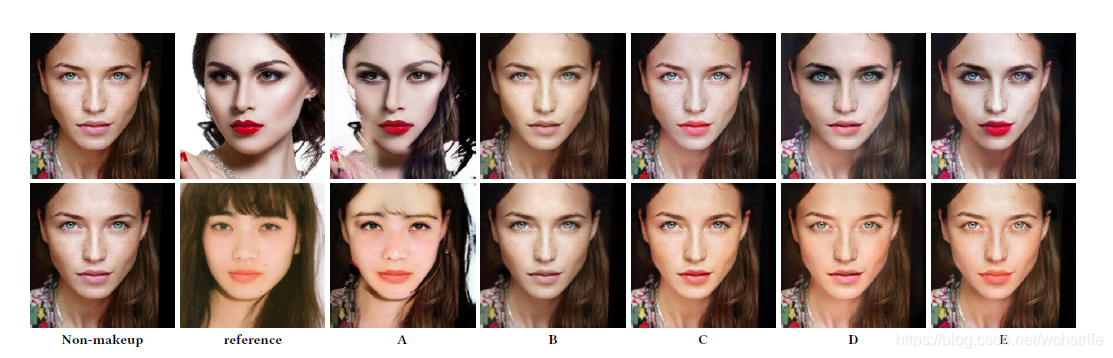

5.3 Ablation Study

对不同的Loss的作用进行对比。

可以看到去掉了perceptual loss之后,面部的特征发生了变化,所以perceptual loss的作用对于保留面部特征起到很大的作用。

C、D、E依次加上了不同化妆部位的Loss,可以看到三个不同部分的妆容依次添加了上去。

这篇关于[MM18]BeautyGAN: Instance-level Facial Makeup Transfer with Deep Generative Adversarial Network的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!