本文主要是介绍爬虫小实战——爬取mooc讨论区内容,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

- 1.前言

- 2.实战介绍

- 3.代码分析(下以爬综合讨论区为例)

- 3.1 帖子层面

- 3.2 回复层面

- 3.2.1 需求分析

- 3.2.2 基本原理

- 3.2.3 代码实现

- 4.参考文档

1.前言

之前一直都没接触过爬虫,最近刚好因为毕设数据集的需求,就趁此契机赶紧动手学习起来啦(ง •_•)ง

身为初次爬虫的小白,为了完成这一个小小的爬虫实战,中间也经历了不少曲折,断断续续花了三四天才完成。个人觉得这个小项目非常典型,涉及到了许多知识点,可以作为一个入门的好例子,就想写一篇总结与大家分享一下~

2.实战介绍

- 爬取课程:课程网页链接.

- 爬取范围:选定课程的讨论区部分的内容

- 所需数据:

- 帖子层面:帖子id、浏览量、回复量、投票量、帖子主题、帖子内容、发帖者id、发帖时间

- 回复层面:帖子id、回复内容、回复评论量、回复投票量、回复者id、回复时间

- 网页构造分析:

讨论区由3个板块构成,每个板块下含若干帖子,每个帖子又含若干回复

// 上述所需数据主要分布在以下两个页面:

3.代码分析(下以爬综合讨论区为例)

废话不多说,赶紧上代码(ง •_•)ง

3.1 帖子层面

这部分主要调用selenium、BeautifulSoup等包来爬取回复详情,这类爬取方法是 ” 模拟人为操作浏览器的行为“ 进而爬取html标签中的内容。

step1:模拟登陆 (该课程需要登陆才能爬取具体内容)

//注意:

1.请务必要下载与浏览器版本号对应的webdriver

2.最好能先在浏览器开发者选项内判断该页面有无iframe结构,若有则需先定位到iframe,再继续往下定位具体元素

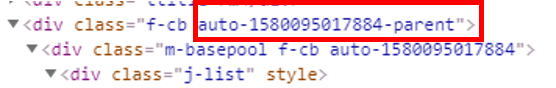

3.不能用动态id来定位元素(如下图所示,即为动态id)

4.反爬行为。在模拟登录的过程中,遇到了能定位到登录按钮元素,却不能在定位像素点部分执行点击操作的情况。后来发现是碰上了网页的反爬行为/(ㄒoㄒ)/ 网页运用了一个弹出的div遮盖住了所有元素。再通过观察,发现只需要滚动滚动条,就可以使其消失啦,那么我们也就只需要在代码中加上模拟人为滚动行为的部分就可以轻松应对这个反爬啦~~

from selenium import webdriver

import time

import pandas as pdbase_url="https://www.icourse163.org/member/login.htm#/webLoginIndex"

driver = webdriver.Chrome(executable_path="你的driver路径")

driver.get(base_url)#观察慕课网登录页面,默认登录方式是手机验证码,如果需要账号密码登录,则要点击一下“账号密码”按钮

#注意:登陆部分在iframe里,且为动态id,参考https://blog.csdn.net/weixin_44342166/article/details/99635635

#先找到这个按钮

time.sleep(1)

driver.execute_script('window.scrollTo(0, 200)') #遇见了反爬行为,通过滚动页面对抗iframe = driver.find_elements_by_tag_name("iframe")[0]

driver.switch_to.frame(iframe)

#先找到这个按钮

jump = driver.find_element_by_class_name('tab0')

#然后点击跳转到账号密码登录界面

jump.click() name_input = driver.find_element_by_xpath('//*[@id="phoneipt"]') #找到输入账号的框框

pass_input = driver.find_element_by_css_selector("[class='j-inputtext dlemail']")#找到输入密码的框框

login_button = driver.find_element_by_id('submitBtn')# 找到登录按钮username="你的账号"

password="你的密码" name_input.clear()

name_input.send_keys(username)

time.sleep(1)

pass_input.clear()

pass_input.send_keys(password)

time.sleep(1)

login_button.click()# 点击登录

time.sleep(1)

step2:进入讨论区,并获取板块对应的a标签

from bs4 import BeautifulSoup

from selenium.webdriver.chrome.options import Options

import requestsurl_head = 'https://www.icourse163.org/learn/CAU-23004?tid=1002299017#/learn/forumindex'

driver.get(url_head)

print("成功进入讨论区")def get_panel_list():content = driver.page_sourcesoup = BeautifulSoup(content,'html.parser')time.sleep(5)panel_list=soup.find('div',class_ = 'j-panels').find_all('a',class_='tit')return panel_list

panel_list=get_panel_list()

step3:爬取帖子层面所需数据

//注意:

1.同一个页面中,可能会出现许多同名的标签,也可能会出现标签隐藏在很多层级标签下面的情况,这时候我们最好能先定位到它的父级标签,再一层层往上试验(ง •_•)ง

2.在构造爬取函数的时候,一定要先想清楚数据在页面之间的分布情况

#获取该板块下指定页的贴子信息

import re

def get_comment_detail(comment_list):#初始化一个dataframe,用于暂存爬取结果df = pd.DataFrame(columns = ["pid", "watch_num", "reply_num", "vote_num","post_title", "post_content", "post_uid", "post_time"])for comment in comment_list:comment_href=comment.find('a', class_='j-link').get('href')pid=re.search('(\d+)',comment_href).group() #贴子id,strwatch_num=int(comment.find('p', class_='watch').text[3:]) #贴子的浏览数reply_num=int(comment.find('p', class_='reply').text[3:]) #贴子的回复数vote_num=int(comment.find('p', class_='vote').text[3:]) #贴子的投票数reply_link = url_head.split('#')[0] +</这篇关于爬虫小实战——爬取mooc讨论区内容的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!