本文主要是介绍Transformer模型中前置Norm与后置Norm的区别,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

主要介绍原始Transformer和Vision Transformer中的Norm层不同位置的区别。

文章目录

前言

不同位置的作用

总结

前言

在讨论Transformer模型和Vision Transformer (ViT)模型中归一化层位置的不同,我们首先需要理解归一化层(Normalization)在这些模型中的作用。归一化层主要用于调整输入数据的尺度,以减少梯度消失或梯度爆炸的问题,从而提高模型的稳定性和训练效率。

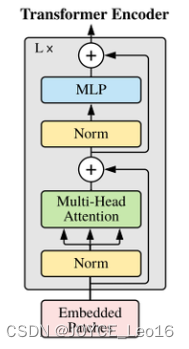

原始的transformer模型把norm归一化层放在了注意力机制的后面,但是vision transformer模型把norm归一化层放到了注意力机制的前面。

在Transformer模型中,归一化(Normalization)层的位置在注意力前后有所不同。这种差异主要源于对模型训练和稳定性的考虑。

不同位置的作用

在原始的transformer模型中,归一化层被放置在注意力机制之后。这种设计有助于提高模型的训练效率和稳定性。在自注意力机制中,输入序列通过与权重矩阵相乘来计算注意力分数,这可能导致梯度消失或梯度爆炸的问题。将归一化层放在注意力机制之后,可以有效缓解这些问题,因为归一化层可以调整输入的尺度。使得梯度更加稳定。此外,由于注意力机制本身是一种非线性的处理方式,把归一化层放在它之后,可以帮助保持输入数据分布的稳定性,这对于模型收敛和有效训练来说是至关重要的。

在Vision transformer(ViT)模型中,归一化层被放置在注意力机制之前。这种设计选择是为了更好地适应图像数据的特性。在ViT模型中,输入的图像数据首先经过卷积层进行初步的特征提取,然后这些特征通过归一化层和线性层进行进一步处理,以便于计算注意力分数。鉴于图像数据通常具有较大的尺度变化,将归一化层置于注意力机制之前可以更有效地调整输入特征的尺度。这样的设计使得模型能够更好地适应和处理图像数据,从而在视觉任务中表现出更优异的性能。

总结

-

在原始的Transformer模型中,归一化层放在注意力机制之后:这样的安排有助于模型更好地保留和学习输入数据之间的关系,同时也有利于保持模型训练的稳定性和高效性。

-

在Vision Transformer模型中,归一化层放在注意力机制之前:这种设计有助于针对图像数据调整输入特征的尺度,使模型在处理图像数据时更加高效和精确。

这篇关于Transformer模型中前置Norm与后置Norm的区别的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!