本文主要是介绍python机器学习之降维算法PCA对手写数字数据集的降维案例,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

PCA对手写数字数据集的降维案例

数据集获取地址:->这里下载

导入需要的模块和库

from sklearn.decomposition import PCA

from sklearn.ensemble import RandomForestClassifier as RFC

from sklearn.model_selection import cross_val_score

import matplotlib.pyplot as plt

import pandas as pd

import numpy as np

导入数据,探索数据

data = pd.read_csv("../数据/digit recognizor.csv")

x = data.iloc[:,1:]

y = data.iloc[:,0]

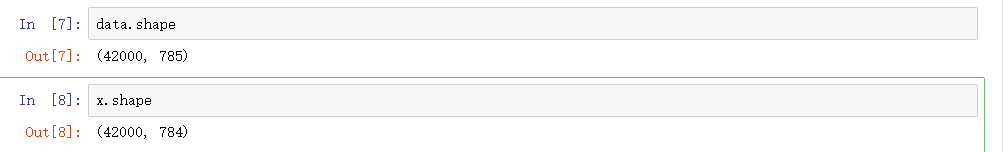

查看数据维度

data.shape

x.shape

画累计方差贡献率曲线,找最佳降维后维度的范围

pca_line = PCA().fit(x)#实例化

plt.figure(figsize=[20,5])#创建画布

plt.plot(np.cumsum(pca_line.explained_variance_ratio_))#折线图

plt.xlabel("number of components")#x轴标题

plt.ylabel("cumulative explainec variance")#y轴标题

plt.show()#显示图像

降维后维度的学习曲线,继续缩小最佳维度的范围

score = []

for i in range(1,101,10):x_dr = PCA(i).fit_transform(x)once = cross_val_score(RFC(n_estimators=10,random_state=0),x_dr,y,cv = 5).mean()score.append(once)plt.figure(figsize=[20,5])

plt.plot(range(1,101,10),score)

plt.show()

细化学习曲线,找出降维后的最佳维度

score = []

for i in range(10,25):x_dr = PCA(i).fit_transform(x)once = cross_val_score(RFC(n_estimators=10,random_state=0),x_dr,y,cv = 5).mean()score.append(once)plt.figure(figsize=[20,5])

plt.plot(range(10,25),score)

plt.show()

发现在23时有最大值,所以我们选择使用23作为PCA维度.

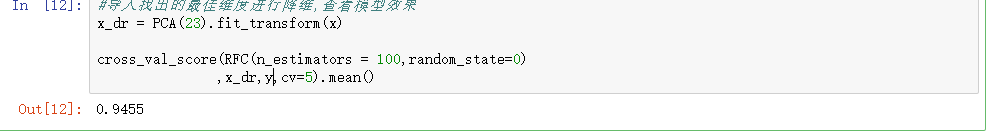

导入找出的最佳维度进行降维,查看模型效果

x_dr = PCA(23).fit_transform(x)cross_val_score(RFC(n_estimators = 100,random_state=0),x_dr,y,cv=5).mean()

型的效果还好,跑出了94.55%的水平,但是还没有我们使用嵌入法特征选择后的96%高.

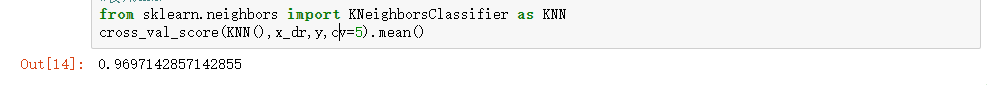

特征数量已经不足原来的3%,换模型怎么样,换成KNN

from sklearn.neighbors import KNeighborsClassifier as KNN

cross_val_score(KNN(),x_dr,y,cv=5).mean()

KNN 的K值学习曲线

score = []

for i in range(10):x_dr = PCA(23).fit_transform(x)once = cross_val_score(KNN(i+1),x_dr,y,cv = 5).mean()score.append(once)plt.figure(figsize=[20,5])

plt.plot(range(10),score)

plt.show()

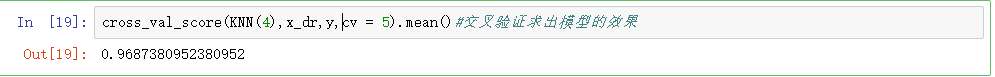

使用交叉验证求出模型的结果

cross_val_score(KNN(4),x_dr,y,cv = 5).mean()#交叉验证求出模型的效果

定下超参数后,模型的效果如何,模型运行时间如何

%%timeitcross_val_score(KNN(4),x_dr,y,cv = 5).mean()#交叉验证求出模型的效果

小结:

可以发现,原本785列的特征被我们减到23列以后,用KNN跑出了目前位置这个数据集上最好的结果.

PCA为我们提供了无限的可能,再也不用担心数据量过于庞大而被迫选择复杂的模型了

这篇关于python机器学习之降维算法PCA对手写数字数据集的降维案例的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!