本文主要是介绍sklearn.preprocessing.StandardScaler,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

http://scikit-learn.org/stable/modules/generated/sklearn.preprocessing.StandardScaler.html#sklearn.preprocessing.StandardScaler

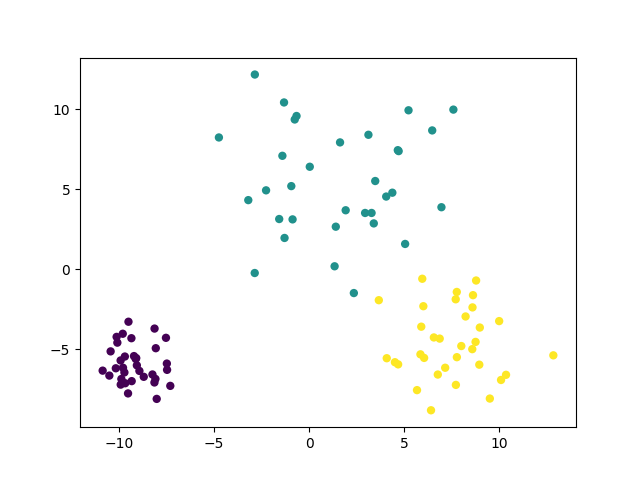

sklearn中的StandardScaler,是对每个特征(列向量)独立地进行居中和缩放。然后存储平均值和标准偏差以使用变换方法在以后的数据上使用 。

这篇关于sklearn.preprocessing.StandardScaler的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![sklearn光速入门实践[1]——实现一个简单的SVM分类器](https://i-blog.csdnimg.cn/blog_migrate/37b1cd9f70b70b7a88429c60af5e31b8.png)